1

{

c

i

≠

∅

}

p

^

σ

(

i

)

(

c

i

)

1

{

c

i

≠

∅

}

L

box

(

b

i

,

b

^

σ

(

i

)

)

\hat{\sigma}=\underset{\sigma \in \mathfrak{S}_{N}}{\arg \min } \sum_{i}^{N} \mathcal{L}_{\operatorname{match}}\left(y_{i}, \hat{y}_{\sigma(i)}\right) \ \mathcal{L}_{\operatorname{match}}\left(y_{i}, \hat{y}_{\sigma(i)}\right) = -\mathbb{1}_{\left{c_{i} \neq \varnothing\right}} \hat{p}_{\sigma(i)}\left(c_{i}\right)+\mathbb{1}_{\left{c_{i} \neq \varnothing\right}} \mathcal{L}_{\text {box }}\left(b_{i}, \hat{b}_{\sigma(i)}\right)

σ=σ∈SNargmini∑NLmatch(yi,yσ(i))Lmatch(yi,yσ(i))=−1{ci=∅}pσ(i)(ci)+1{ci=∅}Lbox (bi,b^σ(i))

我们来看看 ground truth

y

i

y_i

yi 和预测出来的第

δ

(

i

)

\delta(i)

δ(i) 个结果之间的匹配损失。首先是对于那些不是背景的,获得其对应的预测是目标类别的概率,然后用框损失减去预测类别概率。这也就是说不仅框要近,类别也要基本一致,是最好的。经过匈牙利算法之后,我们就得到了 ground truth 和预测目标框之间的一一对应关系。然后就可以计算损失函数了。

损失函数和匹配损失不同之处在于,损失函数需要是正值,所以使用了 log-probability。对于

c

i

=

ϕ

c_i = \phi

ci=ϕ 的类别损失,将分类损失除了 10,降低其作用,因为正负样本不均衡。这种思想和 Faster R-CNN 等一致。目标边界框回归损失则是 IOU 损失和 L1 损失的加权和,其中 IOU 损失对于 Scale 不敏感,L1 损失对于 Scale 敏感。事实上 DETR 用的是 GIoU 损失。

L

Hungarian

(

y

,

y

^

)

=

∑

i

=

1

N

[

−

log

p

^

σ

^

(

i

)

(

c

i

)

1

{

c

i

≠

∅

}

L

box

(

b

i

,

b

^

σ

^

(

i

)

)

]

L

box

(

b

i

,

b

^

σ

^

(

i

)

)

=

λ

iou

L

iou

(

b

i

,

b

^

σ

(

i

)

)

λ

L1

∥

b

i

−

b

^

σ

(

i

)

∥

1

\mathcal{L}_{\text {Hungarian }}(y, \hat{y})=\sum_{i=1}^{N}\left[-\log \hat{p}_{\hat{\sigma}(i)}\left(c_{i}\right)+\mathbb{1}_{\left{c_{i} \neq \varnothing\right}} \mathcal{L}_{\text {box }}\left(b_{i}, \hat{b}_{\hat{\sigma}}(i)\right)\right] \ \mathcal{L}_{\text {box }}\left(b_{i}, \hat{b}_{\hat{\sigma}}(i)\right) = \lambda_{\text {iou }} \mathcal{L}_{\text {iou }}\left(b_{i}, \hat{b}_{\sigma(i)}\right)+\lambda_{\text {L1 }}\left|b_{i}-\hat{b}_{\sigma(i)}\right|_{1}

LHungarian (y,y)=i=1∑N[−logpσ^(i)(ci)+1{ci=∅}Lbox (bi,bσ(i))]Lbox (bi,bσ(i))=λiou Liou (bi,b^σ(i))+λL1 ∥∥∥bi−b^σ(i)∥∥∥1

依然延续论文实验部分不做过多详解,主要学习核心思想的观点,故实验部分就不做过多赘述,大家可以详见论文的描述。

4. 代码

代码见 Facebook 官方实现最好不过了,代码链接点击 此处。强烈推荐搭建看看“搞笑”博主手把手代码运行教学。

5. 总结

之前还有幸接触外国博主的一种理解,说 Transformer 的 Self-Attention 对于目标检测友好的观点,个人觉得非常好。他说:Backbone 输出的特征图经过

1

×

1

1 \times 1

1×1 卷积后进行降维,得到的是

d

×

H

×

W

d \times H \times W

d×H×W,被 reshape 成

d

×

H

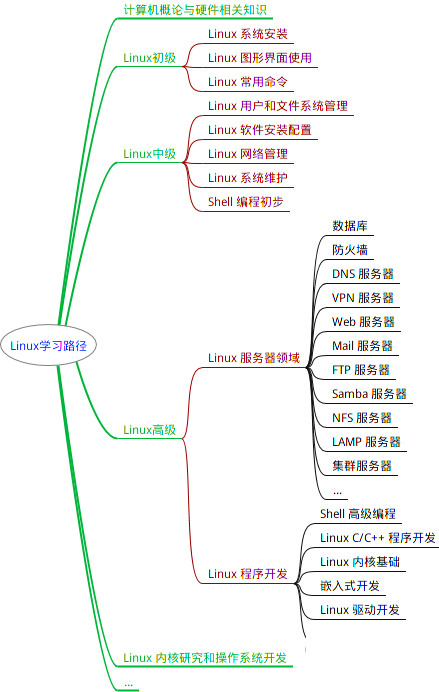

最全的Linux教程,Linux从入门到精通

======================

-

linux从入门到精通(第2版)

-

Linux系统移植

-

Linux驱动开发入门与实战

-

LINUX 系统移植 第2版

-

Linux开源网络全栈详解 从DPDK到OpenFlow

第一份《Linux从入门到精通》466页

====================

内容简介

====

本书是获得了很多读者好评的Linux经典畅销书**《Linux从入门到精通》的第2版**。本书第1版出版后曾经多次印刷,并被51CTO读书频道评为“最受读者喜爱的原创IT技术图书奖”。本书第﹖版以最新的Ubuntu 12.04为版本,循序渐进地向读者介绍了Linux 的基础应用、系统管理、网络应用、娱乐和办公、程序开发、服务器配置、系统安全等。本书附带1张光盘,内容为本书配套多媒体教学视频。另外,本书还为读者提供了大量的Linux学习资料和Ubuntu安装镜像文件,供读者免费下载。

本书适合广大Linux初中级用户、开源软件爱好者和大专院校的学生阅读,同时也非常适合准备从事Linux平台开发的各类人员。

需要《Linux入门到精通》、《linux系统移植》、《Linux驱动开发入门实战》、《Linux开源网络全栈》电子书籍及教程的工程师朋友们劳烦您转发+评论

3087

3087

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?