点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

与线下学习不同,在线学习主要分为两种研究模式:(1)在线元学习。该方法在一个连续的场景中学习模型参数的先验(也被称为学习如何学习),该场景默认每个学习任务是在连续时间点依次出现。尽管在线元学习提供了一个次线性的遗憾上限,但是它忽略了公平学习的重要性,而公平学习是人工智能是一个非常重要的标志。(2)第二种方法是在线公平性学习。尽管这种方法适应于许多涉及公平性的分类问题,但这种方法主要集中于在没有任何特定任务适应性的情况下实现零概率泛化,这也因此限制了模型适应新数据的能力。为了克服上面的问题,本文首次提出了一-种新的在线元学习算法FFML,该算法是在不公平预防背景下进行的。FFMIL的关键部分是学习在线公平分类模型的原始参数和对偶参数的良好先验,它们分别与模型的准确性和公平性有关,并且该原始和对偶参数对的优化问题是采用一个双层次的凸凹优化方法。该算法的理论分析同时为遗憾损失和累积公平性限制提供了次线性上限。此外,该算法的有效性得到了基于真实数据实验的证明。

本期AI TIME PhD直播间,我们邀请到美国Kitware公司高级研发工程师——赵辰,为我们带来报告分享《公平意识在在线元学习的研究》。

赵辰:

美国Kitware公司高级研发工程师,博士2021年毕业于美国德州大学达拉斯分校计算机专业。博士期间的研究方向主要是公平性学习在数据挖掘,机器学习,深度学习上的研究和应用等。在包括KDD, AAAI, ICDM, WWW等会议与期刊上发表过多篇论文,并多次受邀担任KDD, AAAI, WACV, ICDM, AISTATS, WSDM, SDM, NeurIPS, BigData, JBDR等人工智能领域顶级国际会议程序委员/审稿人。

个人主页:

https://charliezhaoyinpeng.github.io/homepage/

01

背 景

在机器学习中,当数据集中包含敏感(或保护)属性集(比如性别、种族、地域等)时,不同的场景下相同算法的预测结果可能是把不同的。公平性学习是在保护或隐藏某些敏感属性并同时保持原有的学习效用。

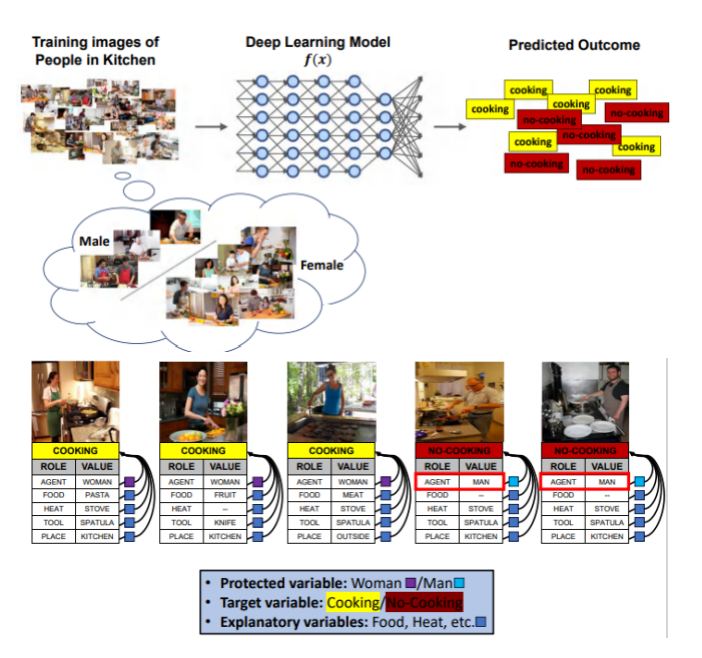

比如下面的例子,将包含厨房中人的图片放到网络中训练,预测这个人是否在做饭。训练集中女人的样本要多于男人的样本,而对于做饭场景,性别属于敏感属性,模型预测的结果基本和性别呈相关关系,男人被预测不做饭的概率较大,女人被预测做饭的概率较大。

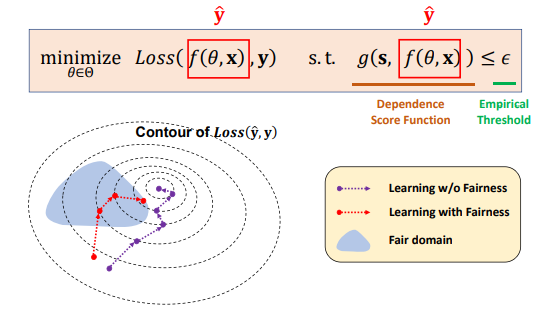

公平性学习的一般描述是一类约束优化问题,通过满足公平性限制的基础上,最小化预测系统损失,从而提高系统公平性。其中,公平性限制条件称为Dependence Score Function,用来限制预测结果对敏感属性的依赖关系,本文用g来表示。

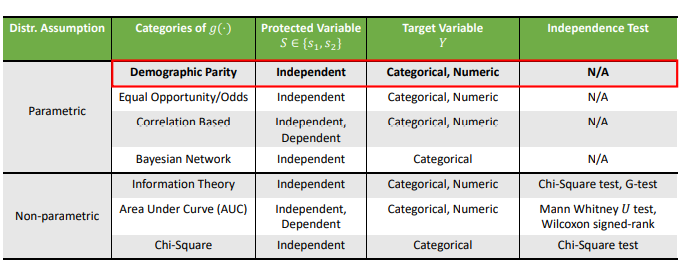

下面列举了常用的Dependence Score Function,本文主要关注Demographic Parity这个类目。

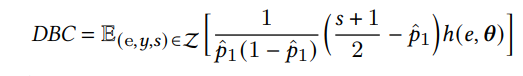

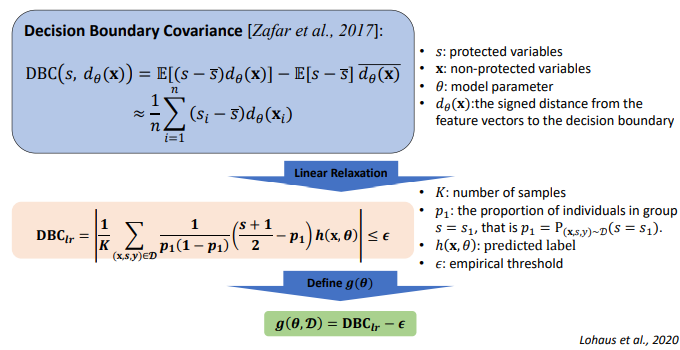

Decision Boundary Covariance(DBC)是一种定义在敏感属性和特征向量与决策边界距离的协方差。下式是DBC的线性近似形式,s是敏感属性,是敏感属性s=1(本文假设s取值可选0或1)时的样本比例,h是以 θ 为参数的实值函数。

当满足公平性约束时,任务域中的参数 θ 是可行的。上式中引入的DBC公平概念是demographic parity.的经验版本。在本文中,将DBC视为公平性约束,引出下面的g函数,采用了DBC进行linear relaxation的形式定义了g函数。

目前的公平性学习一般是基于单任务的场景,很少涉及多任务场景下的公平性学习问题。

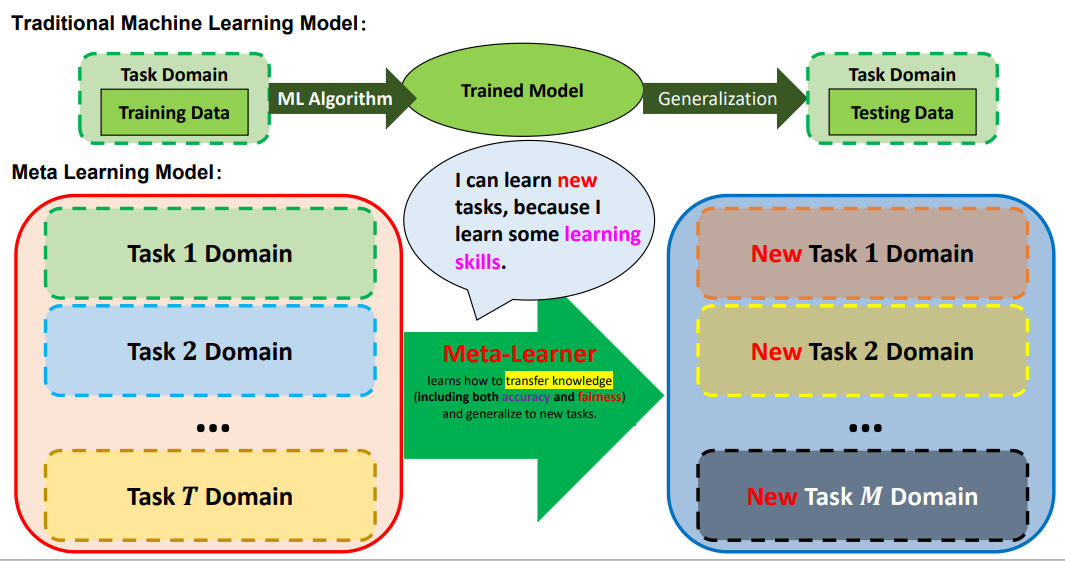

现有的公平性学习方法大都是基于大量数据检测和控制学习的偏差,但更快地学习也是很重要的,所以本文关注到元学习的概念,每个任务都用较少的数据去训练,如下图所示。

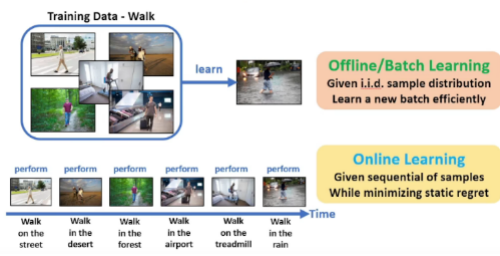

元学习假设每个任务的数据分布是相同的,但事实上我们获取的数据存在先后顺序,因此数据的分布可能存在一些差异。比如下面我们要训练一个判断是否在行走的分类器,元学习会把所有场景的行走都看作是一类,都是在行走,忽略是沙漠还是马路等场景,但是实际训练中,我们的数据可能是随着时间变化一个场景、又一个场景的到来,因此训练会受到一些影响。而在时间上很快适应上述任务并且使得模型损失次线性增长是在线学习的一个重要研究点。因此本文将公平性学习、元学习以及在线学习融合起来,进行公平意识在在线元学习的研究。

02

方 法

由于收集的数据是按不同的时间顺序按批次获得,因此数据分布是不稳定的。因此,本文将离线元学习的技术应用在在线学习上并增加了公平意识的概念。本文的关键点在于提出了FFML(Follow the Fair Meta Leader)方法,解决过去的学习经验如何快速适应到新的任务中的问题。

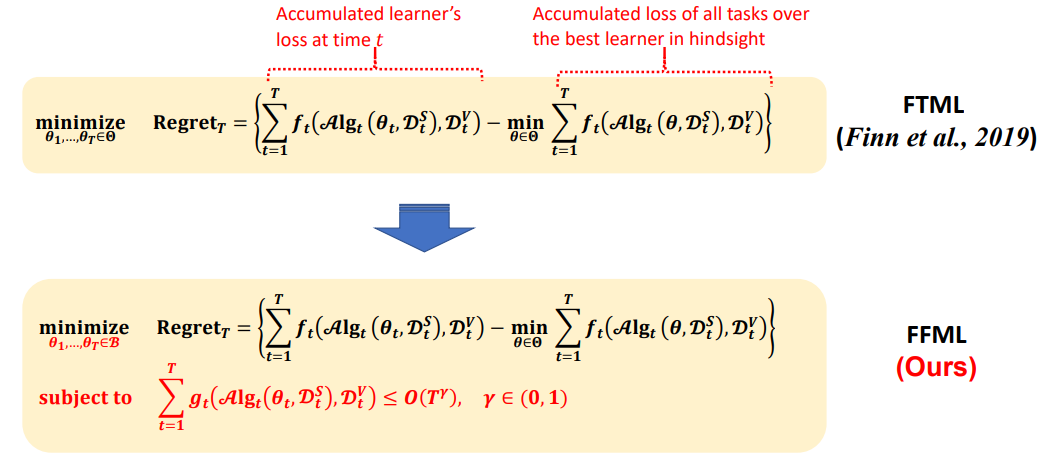

在在线学习中,优化目标是最小化loss Regret。FTML中的Regret定义为每个时间点的学习器损失之和与后置最优学习器损失的差。本文的FFML方法的Regret函数将模型参数域松弛到球体域,使得这个域可以包含所有公平性约束。允许学习器在学习中进行决策,这些决策可能不属于原来的模型参数域,但整体上,决策序列满足公平性约束,g函数的和在时间点上要满足次线性。

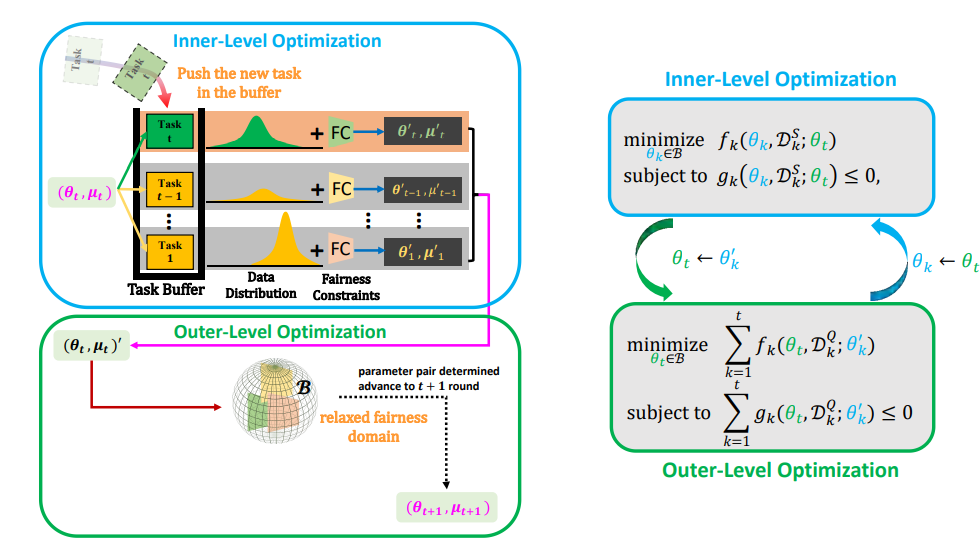

FFML方法的目的是在每个时间点上找到meta parameters,使得这个meta parameters可以很好地适应到下一个时间点上。如下图所示,在时间点t,新的任务会被添加到缓冲区中,参数通过内部和外部相互作用的双级优化,使用公平性约束进行迭代更新。

3 实验

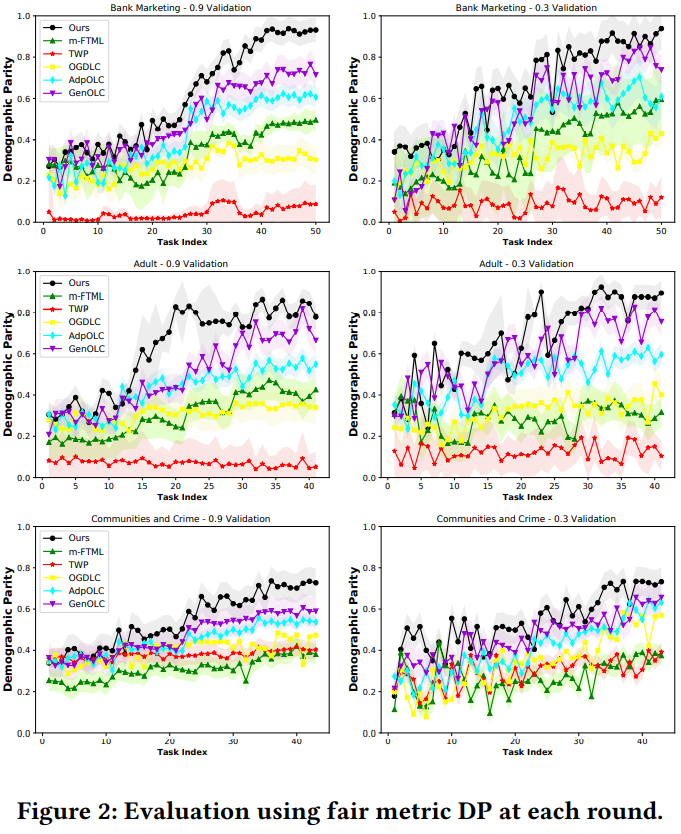

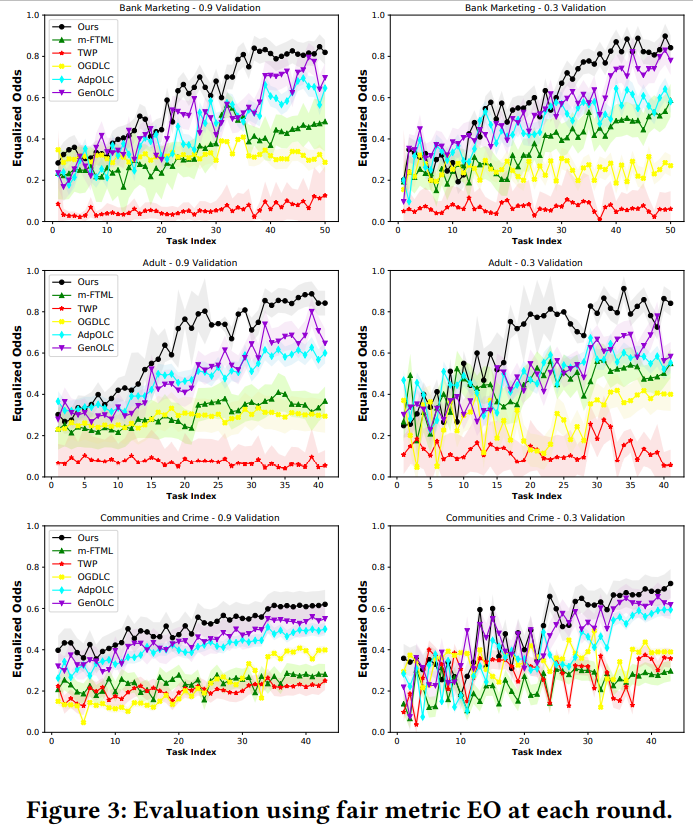

下图是基于本文提出地FFML方法进行的一些实验,在90%的验证样本上,基于两个公平评估指标的每轮公平性结果表明,我们的方法优于其他方法;当验证样本减少到30%时,尽管所有方法的性能都会发生波动,但我们的方法仍然优于其他方法。

整理:爱 国

审核:赵 辰

AI TIME欢迎AI领域学者投稿,期待大家剖析学科历史发展和前沿技术。针对热门话题,我们将邀请专家一起论道。同时,我们也长期招募优质的撰稿人,顶级的平台需要顶级的你!

请将简历等信息发至min.gao@aminer.cn!

微信联系:AITIME_HY

AI TIME是清华大学计算机系一群关注人工智能发展,并有思想情怀的青年学者们创办的圈子,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法、场景、应用的本质问题进行探索,加强思想碰撞,打造一个知识分享的聚集地。

更多资讯请扫码关注

我知道你在看哟

点击“阅读原文”查看精彩回放

1

1

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?