《3D ISP核心技术算法》系列文章是上海数迹智能科技有限公司结合自身多年来在3D ISP技术方向上的积累,推出的系列型科普文章。系列文章将对影响3D成像质量的主要问题逐一进行讲解,深入浅出的介绍问题出现的原理机制和解决方法,旨在促进3D视觉从成像到感知的应用工程实践,真正实现慧视界、智未来。

本篇文章作为该系列的第一篇文章,将对iToF在复杂场景下的最主要环境误差源之一的多径误差进行介绍。

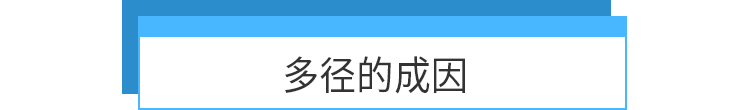

多径是无线通信领域中一个常见术语,具体含义是指无线电信号从发射天线经过多个路径抵达接收天线的传播现象。各分量相互叠加,会导致信号的衰落和相移,对系统造成不良影响[25]。ToF向场景中主动发射(近)红外光,传感器接收场景中对应目标的反射光信号,利用(近)红外光的飞行时间计算深度。由于光在场景中会发生多次反射与折射,每个像素接收的信号包含多个路径的反射光,面临相似的多径问题,导致深度测量的误差。

目前的ToF设备根据测量原理的不同,分为dToF和iToF两类。虽然多径现象是发生在场景中,但是由于测量原理的不同,多径对两类ToF的影响不一样,呈现出来的误差形式也不一样。dToF每个像素对曝光时间内所有接收信号的飞行时间做直方图统计,多径虽然会改变直方图的分布,从理想的单峰分布变成多峰分布。但是直达径信号对应的柱仍然会是峰值,dToF的多径消除方法只需要排除多个干扰项。对于iToF而言,每个像素把所有的接收信号当做一个合成信号处理,经过一系列非线性计算得到一个深度值,无法从该深度值中直接恢复出正确深度值。所以,iToF的多径消除更加困难。此外,由于dToF的研究起步晚,市面上的产品较少,dToF的数据获取比iToF更难。因此,目前关于多径的研究大多数都是基于连续正弦波调制的iToF(CW-ToF)。

本文围绕iToF展开,介绍多径的影响、成因以及消除方法。在多径的消除方法部分,我们主要调研了2011-2018年关于多径的论文。由于篇幅限制,在文中展开介绍了其中具有代表性的4篇。感兴趣的读者可以根据本文最后的参考文献自行查阅,有问题可以联系我们,一起交流,共同探讨。

首先,让我们先来了解一下理想的iToF成像原理。

iToF相机向目标场景发射调制光,并由传感器接收目标场景反射回来的调制光,通过计算发射光和反射光的相位差来计算每一个像素点到相机的距离。理想的iToF成像满足如下假设,发射信号在场景中只经过一次反射,传感器的接收信号只包含一次反射光和环境光,如式(1)所示。

其中,是接收信号的幅值,

是环境光分量,

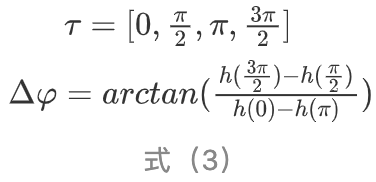

就是发射信号和接收信号的相位差。由于相位差无法通过一次测量直接获得,常见的相位差求解方法是Four-Sampling-Bucket算法[1]。该算法首先计算参考信号和接收信号的自相关

,参考信号是发射信号经过相位移动τ后得到的信号。

然后对 采样,取3-4个值就可以计算出相位差。通常是四次采样,

得到相位差之后,结合式(4),就可以计算深度:

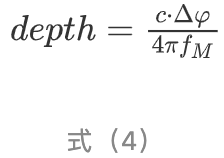

前文提到,理想的iToF成像假设发射信号在场景中只经过一次反射。然而,实际的成像过程中,光线会在场景中发生多次反射和折射,这也就意味着实际接收信号可能包含若干(甚至无数)个子信号,

其中, 项对应的是直达径(direct path),剩下的

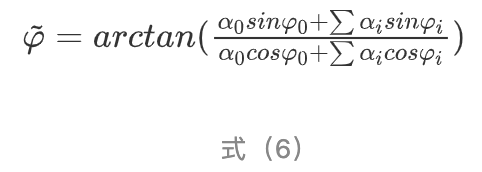

项则是对应的间接路径(indirect path),也就是多径干扰成分。通过四次采样计算得到的相位差也不再是式(3)所描述的,而是如式(6)所示:

最简单的多径模型是Two-path模型,反射信号中只有一个直达径和一个多径分量,如式(7)所示:

多径现象在ToF测量中始终存在。但是,在大多数场景中,间接路径的强度通常比较低,对于最终的测量值影响不大。因为间接路径会经过多次反射,每次反射信号会衰弱。同时,间接路径的光信号飞行距离往往比较长,信号衰减也较为明显。所以,间接路径的信号幅值会远低于直达径的信号,也就意味着多数的测量值是有效的。但是,在一些特殊场景中,间接路径的信号幅值会异常高。此时,测量值的误差会比较大。总的来说,这些特殊场景可以分为三类[2]。

第一类是高反射率的表面,比如镜面。对于这一类物体而言,由于菲涅尔效应,当光线以特定角度入射时,反射会特别强烈,反射信号的衰减不明显。同时,若是该平面附近存在其他物体,物体表面会收到来自平面的高幅值反射信号,如图1(a)所示。该间接路径信号与直达径信号的幅值差异较小,但是由于深度存在差异,所以最终的测量值和直达径之间的误差比较明显,如图1(b)所示。

(a)

(b)

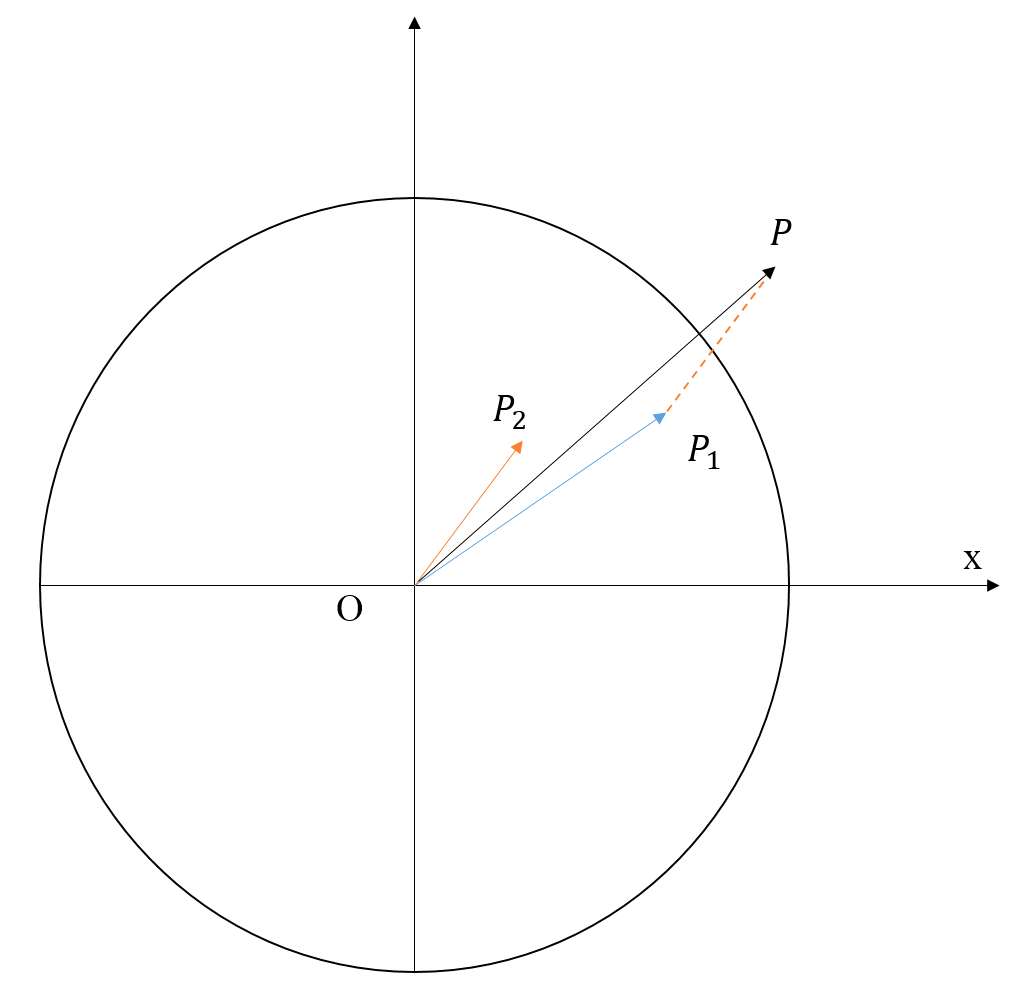

图1. 镜面场景简单多径示意图。(a)镜面场景下光线传播路径图;(b)镜面场景下各分量信号与最终测量值之间的关系, 对应直达径信号,对应图(a)中蓝色路径,

对应间接路径信号,对应图(a)中红色路径,

对应最终测量值信号,本例中没有考虑环境光分量以及其他多径信号。

图1(b)中,采用的是极坐标系的形式表示信号分量, 的长度表示信号的幅值,

与x轴的夹角表示信号的相位差,也就是深度值。

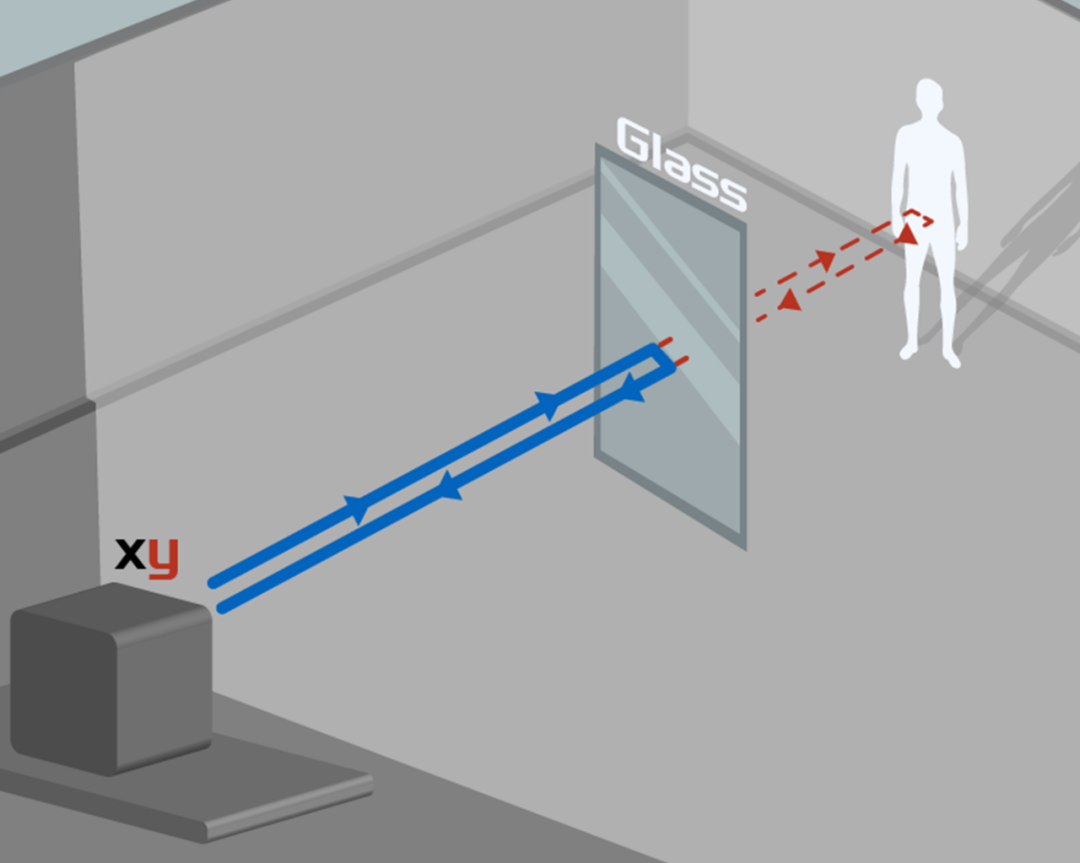

第二类是透明/半透明的物体。透明物体的表面会反射一部分光,同时,光线还会通过透明物体而不会大幅衰减。透射信号经其他物体反射回来,与透明物体表面的反射信号会叠加,导致多径误差。透明物体的接收信号其实是对应了两个物体的反射信号,但是在像素处理单元中,会被当成一个物体的多路径反射信号处理。

图2. 透明物体场景简单多径示意图

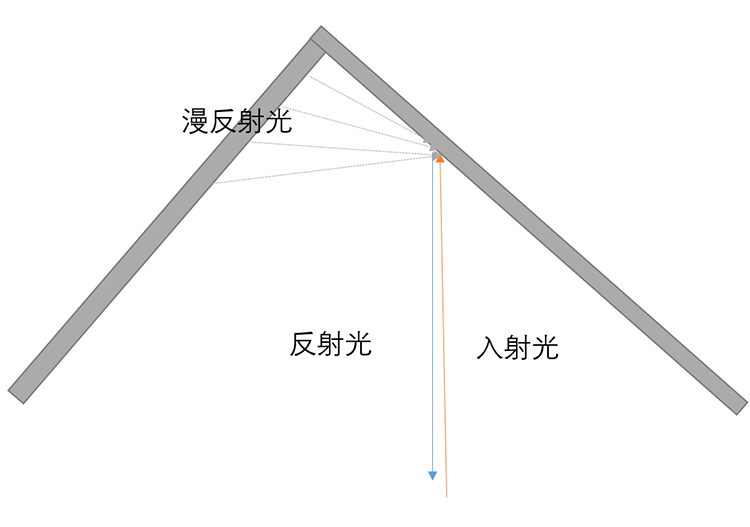

第三类是最复杂的墙角场景。对于墙角场景而言,由于漫反射的存在,光会往各个方向反射。也就意味着,墙面上的每一个点都会接收到来自墙上其他点的反射光。虽然每一个反射光的幅值都比较低,但是由于反射分量足够多,ToF的测量值与直达径之间差异明显。

图3. 墙角场景简单多径示意图

此外,一些研究[2,20]会将散射问题也归类为多径。散射是由于光在透镜和传感器之间发生了多次反射,如图4(b)所示。假设三个物体Target1,2,3与相机的距离由近到远,且反射率、材质等因素一致时,三个物体对应的信号幅值依次降低,与距离的平方呈反比。由于散射现象,每个像素的接收光在透镜和传感器内反射,从而对其他像素施加一个散射光信号。该散射光信号可以简单看成是每个像素本身的原始观测信号乘一个衰减系数。所以,每个像素的最终观测值其实是自身的原始观测信号和来自其他像素的散射光信号的幅值加权。尽管该现象对观测到的信号幅度的影响可以忽略不计,但是相位测量结果以及对应的距离值可能会受到很大影响。如图4(a)所示。Target2和3的相位值都发生了较大的改变,其中,Target3由于和Target1的距离差较大,对应的幅值差也比较大,所以受散射的影响明显大于Target2。这种现象主要发生在具有高幅值和深度对比度的场景中,比如远近效应:远近景物体同时存在时,远景物体的深度值会发生较大偏移。

但是,该现象和前面所述的三种多径现象不一样的是,前面三种多径现象都是发生在场景中,散射现象是发生在设备中。在前面三种多径模型中,各像素的测量值之间是独立的。散射现象则是体现在像素之间的影响,尤其是当两个像素对应的物体间距比较大时 。散射现象的多径模型和其他三种多径模型不太一致。

图(a) 图(b)

图4. 散射现象示意图[24]Target1,2,3和相机之间的距离依次增大,对于材质相同的物体,幅值会对应依次减小,对应图(a)中不同颜色向量的长度。

自从ToF的成像技术提出到现在,关于ToF中多径消除方法的研究一直在推进。早期的多径消除方法主要采用谱估计思想,利用多频率测量值求解各分量对应的深度和幅值。随着机器学习体系的完善,神经网络在各视觉任务中的成功应用,逐渐有学者利用机器学习的方法解决ToF中的多径。本文调研了目前iToF多径消除相关的论文,根据调制频率的数量,总体上将多径消除的方法分为两大类,一类是基于多频率的测量数据实现多径消除,另一类则是利用单频率的测量值实现多径消除。

首先介绍基于多频率的方法,因为这一类方法是现有研究中的主流方法。对于多径场景而言,接收信号包含直达径与众多间接路径,每一个信号分量都有两个待确定的参数,对应信号的幅值和该路径的光飞行距离,也就是公式(5)中的 。假设接收信号中的信号分量有 个,那么,包含环境光分量对应的参数在内,所有待确定的参数一共有 个。根据线性代数的知识,要想完全求解这些未知参数,需要有 个线性无关的测量值。在多径场景中,改变调制频率,获得的测量值之间是线性无关的。因此,多频率方法是求解多径分量的直观思路。

基于多频率的方法分析多径模型,通过处理傅里叶域中每个像素的原始测量值的时间变化来解决该问题[16]。常见的处理方法包括Prony[3]、Matrix Pencil [13]、正交匹配追踪[21]等。大多数研究都会把多径信号会被看成一个稀疏信号。部分研究[15,20]将多频率测量值和compressive sensing(CS)算法结合,重构稀疏信号,从而恢复出直接分量。部分研究[4]则是根据多频率测量值构建一个凸优化问题求解稀疏信号。在早期的研究中,为了简化多径问题,许多研究[3,10,12,13,22]将多径模型简化成Two-path模型。这样,所需要的频率数会大幅减少。

文章[3]提出了一个名为SPUMIC的框架,全名为Simultaneous Phase Unwrappingand Multipath Interference Cancellation, 该框架同时解决相位展开和多径修正的问题。本文简化了多径模型,只考虑了一个间接路径的情况。因此,传感器的接收信号可以简化成两个分量,如式(8)所示:

式中的 分别代表直达径和多径的幅值,

分别代表直达径的深度值和多径的深度值,

代表我们所需要的校准深度值。没有多径干扰时,意味着

。而要求解这样一个包含4个未知数的方程,方程组中至少要包含4个方程,也就是说至少需要4个采样频率。[3]中采用了5个采样频率,利用5组测量值建立Hankel矩阵,通过分析Hankel矩阵的秩检测每个测量值是否有多径信号的干扰。如果存在多径干扰,则使用Prony算法分离两个多径分量,从而把原问题抽象成一个谱估计的问题。

利用谱估计的思想求解多径问题,能够以较低的计算量计算直达径信号,但是这一类方法对噪声较为敏感,在信噪比较低的场景中效果不理想。多频率方法中另一个思想是根据多频测量值构建一个凸优化问题,从而求解多径模型的最优解,以文章[4]为例。

文章[4]中用离散形式表示多径模型,如式(11)所示:

多径问题的求解就变成如下问题,根据m次测量值v求解向量x。x被称为“Backscattering”。Backscattering有如下两条特性:

1.非负性。 的每一个分量其实对应的是每个径的幅值信号,如果等于0,则表示该距离没有对应的多径信号。如果大于0,则表示该距离存在对应的多径信号。

2.可压缩性。如果是一个Two-path模型,则 中只有两个值是大于0的,意味着

是稀疏的。

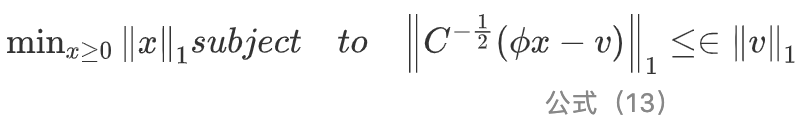

利用以上两个特性,构建一个凸优化问题,如式(13)所示:

直达径信号对应的距离必定是所有分量中最短的,也就是第一个非零x对应的距离。

这一类利用稀疏性构建凸优化问题并求解的方法,一方面是忽略了深度本身的精度,仅达到了cm级。另一方面,由于稀疏性其实只是散射复杂性的弱近似,因此算法大多是在仿真场景验证。

基于单频率的方法可以细分为两类,一类是基于学习的方法,比如随机森林、卷积神经网络[5,9,14,17,19]。文章[17]针对不同材质的角落场景,建立数据集并构建一个学习模型,使用随机森林预测ToF数据的多径误差。文章[14]利用了两个神经网络,其中一个网络学习从ToF测量值到真实值的映射,另一个检测物体边界。对于每个像素,用4个边缘检测器检测四个方向,然后利用非极大抑制和迟滞阈值计算用于测地距离的二进制边缘图。最终利用邻域像素和测地距离恢复深度。一类是利用特定编码的照明模式,通过修改硬件或者使用外接投影的方式[6,7,8,11,23]。文章[8]将前向幅度调制的光传播公式化为与自定义代码的卷积,通过引入简单的电子时间延迟序列来记录样本,并执行稀疏反卷积恢复对应于多径返回的Diracs序列。文章[6,7]利用light transport校准多径误差,通过分析光的传播特性分离接收信号中的全局分量和直接分量。此外,其他作者提出了结合ToF和结构光技术的方法分离全局分量和直接分量[18]。

基于学习的方法比较好理解,以文章[5]为例。该文章的作者对多径特征的观察表明,它的大部分信息都存在于图像空间中,这就可以将深度成像过程表示为一个空间变化的卷积,并使用卷积神经网络来修正多径误差。由于输入和输出数据的结构类似,所以作者以自动编码器为基础设计网络,并将网络分为两个阶段进行训练。首先,第一个阶段使用编码器学习一个合适的basis,可以用来表示受多径干扰的深度图像。其次,第二个阶段训练一个解码器去修正仿真图像的深度。具体的网络结构如图5所示。

图5 回归网络结构的两阶段训练过程[5]

第一个训练阶段是无监督的,作用是学习一个卷积自编码器,去学习深度的低维表示。该阶段的输入和输出都是带有多径影响的深度图像。第二个训练阶段是有监督的,其输入既包含有多径的错误深度图,也有无多径的正确深度图。最终的网络则是由原始的编码器和更新后的解码器构成。

值得一提的是,该文的作者仅仅利用深度图像作为网络的输入,是因为他们认为虽然幅值图或者相移图可以为网络提供附加信息,但是他们往往是未经校准的,并且高度依赖于器件特性的。这一点和其他基于神经网络方法的文章不一样。此外,本文的另外一点贡献就是创建了一个仿真ToF数据集。该数据集包含多个实际场景,每个场景都提供了带有多径干扰的图像和ground-truth。

但是,这一类方法的缺点和大多数基于深度学习的任务一样,算法的准确性非常依赖数据集。实际场景的多径数据虽然获取容易,但是对应的真值通常难以获取,这也导致了目前的ToF多径数据集不多。虽然许多研究设计了ToF仿真器,利用仿真器生成大量带真值的多径数据集,但是仿真器本身也有缺陷存在,无法完美模拟传感器的特性,一些因为硬件特性导致的误差和噪声很难模拟。

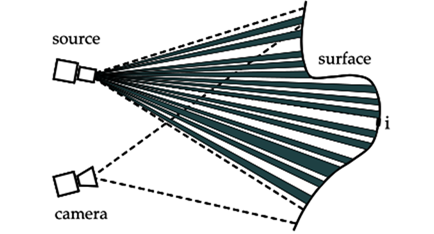

基于单频率的另一类方法是修改光照模式,利用光学特性分解直达径和多径信号,以文章[6]为例。

文章[6]的具体方法是沿用[7]的思路。通过向场景中发射具有不同相移的正弦照明图案,利用三次测量实现直达径分量和其他全局分量的分离。该方法要求照明频率必须足够高。每次测量时,场景中仅有一部分像素是激活的,如图6所示。激活状态的像素就是图6中的亮斑块,包含直接分量和全局分量,未亮斑块仅包含全局分量。

图 6 高频二进制照明模式。亮斑块包含直接分量和全局分量,未亮斑块仅包含全局分量。[7]

从理论上讲,用这种照明模式拍摄的两个场景图像及其互补就足够估计场景中所有像素的直接分量和全局分量。考虑一个场景的两次互补拍摄,同一个像素在第一次是激活状态,在第二次拍摄中是未激活状态,则两次测量结果可以表示为:

其中, 表示每次激活像素占所有像素的比例,

对应直接分量,

对应全局分量。在

已知的情况下,只需要两次测量就可以计算出

和

。考虑到投影仪中非激活像素也会产生少量的光,三次测量也足够分离直接分量和全局分量。文章[7]中用一个外接的DLP投影仪发射高频二进制照明模式的光,而不是修改ToF模组自身的照明模块。

图7 实验设置[6]

这一类方法其实也是基于Two-path简化模型求解多径问题,而且需要修改模组的硬件或者额外添加硬件。一方面,该方法需要针对特定的ToF模组,在普通光照模式的ToF模组中不适用,限制了算法的使用范围。另一方面,如果使用外接投影的方法,成本较高,比如文章[7]中所用的DLP投影仪的价格甚至比ToF模组本身还要高,这一类方法可以用于研究,但是不适合实际应用。此外,这种方法分析复杂的light transport的能力有限。

目前的多径消除方法比较多样化,可以从信号处理的层面分析,可以从光学特性的角度分析,还可以利用深度学习方法。但是由于缺少标准的公开数据集,且各方法所需要的输入数据差异较大,所以大多数研究都是基于自己的数据上分析。目前基于深度学习的多径数据集包括FLAT[9]和[5]。其中,FLAT数据集包含2000个ToF测量值的仿真数据集,[5]中的数据集包含1050张带有多径的仿真图像,共计25个场景。此外,还包含6000张未标注的真实场景数据。

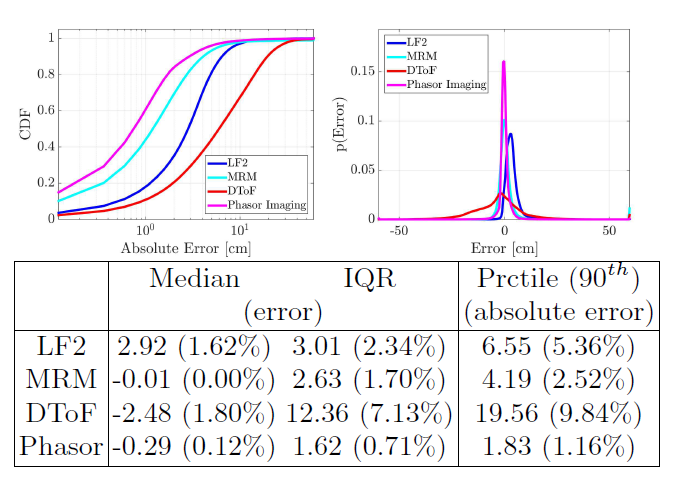

方法[5]可以实现50%的像素误差在5cm以下,而原始误差75%都在9cm以上。方法[9]在自己的数据集上对比了LF2(libfreenect2),DeepToF[5]、Phasor Imaging[11]和MRM[9]四种方法。结果表明DeepToF精度较差,而[9]和[11]的结果接近。

图8 实验对比[9] 注:CDF:累计分布函数;IQR:Inter Quartile Range

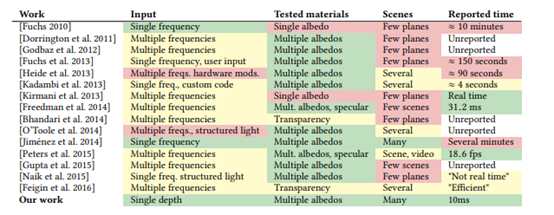

衡量算法的另一个标准就是实时性,因为多径消除算法是要应用到ToF相机中,所以,对算法的运行时间也有要求。[5]中统计了一些多径消除算法的运行时间和输入、测试材料以及场景数量。其中,[5]中的方法是在一块GTX 1080上运行的。

图9 现有多径抑制算法的对比[5]

总的来说,目前关于多径消除的方法各有优劣。基于多频率的方法从iToF的成像原理分析,不需要额外添加硬件或者修改照明模块。但是,这一类方法需要的频率数比较多,要想完全求解所有分量的信息,需要 (2K+1) 个频率,现有的iToF相机很难支持这么多频率。尤其是基于谱估计的方法,采用的频率需要是一个基频的整数倍,对频率要求过高。而且,这种要求会导致部分频率较高,从而导致相位模糊问题,求解时需要同时考虑多径和相位去模糊问题。

基于单频率的方法中,修改光照模式的方法实现复杂,但是求解简单。在光路传播复杂的场景中,效果比较差。基于学习的方法相对准确率较高,也不需要对硬件做任何修改,但是其准确性依赖数据集,而数据集的获取难度太高。此外,对于不同的ToF相机,可能需要单独训练一个网络模型,普适性较差。

本文从多径如何影响深度测量、多径的成因和多径消除的方法三个方面,全面介绍了ToF多径现象,分析了现有的多径消除方法的优劣,让读者对ToF中的多径现象有一个全面的了解。

多径现象是ToF技术普及面临的一大挑战,多径消除也是3D ToF ISP中的一个重要技术点。ToF技术要想实现在任意场景下获取可靠和准确的深度数据,消除多径现象是一个关键。目前的多径消除方法还有很大的改进空间,期待感兴趣的同学们和我们一起交流,共同致力于推动ToF的发展。

[1] Dorrington A A,Godbaz J P ,Cree M J , et al. Separating true range me-asurements from multipath and scatering interfernce in commer-cial range cameras[j]. Proceedings of Spie the International Society for OpticalEngneering,20-11,7864.

[2] Jonathan Klein. Correction of Multipath-Effects in Time-of-Flight Range Data[D]. Uni-ersity of Siegen, 2014.

[3] Kirmani A , Benedetti A , Chou P A . SPU-MIC: Simultaneous phaseunwrapping and mul-tipath interference cancellation in time-of-fli-ght camerasusing spectral methods[C]// 2013 IEEE International Conference on Multimed-iaand Expo (ICME). IEEE, 2013.

[4] Freedman D , Krupka E , Smolin Y , et al. SRA: Fast Removal ofGeneral Multipath for ToF Sensors[J]. Lecture Notes in Computer Scien-ce, 2014,8689:234-249.

[5] Marco J , Hernandez Q , Muñoz, Adolfo, etal. DeepToF:Off-the-Shelf Real-Time Correc-tion of Multipath Interference in Time-of-Flight Imaging[J]. Acm Transactions on Graphics, 20-18, 36(6):1-12.

[6] Rhemann C , Izadi S , Kang R S B , et al. A light transportmodel for mitigating multipath interference in Time-of-flight sensors[J]. 2015.

[7] S. K. Nayar, G. Krishnan, M. D. Grossberg, and R. Raskar. Fastseparation of direct and gl-obal components of a scene using high frequ-ency illumination. In ACM TOG, volume 25, pa-ges 935–944. ACM, 2006

[8] Kadambi A, Whyte R, Bhandari A, etal. Coded time of flightcameras: sparse decon-volution to address multipath interference and recovertime profiles[C]. International Confer-ence on Computer Graphics and Interactive Techniques, 2013, 32(6).

[9] Guo Q,Guo Q, Frosio I, et al. Tackling 3D ToF Artifacts ThroughLearning and the FLAT Dataset[C]. European Conference on Computer Vision, 2018:381-396.

[10] Godbaz J P, Cree M J, Dorrington A A, et al. Closed-forminverses for the mixed pixel/ m-ultipath interference problem in AMCW lidar-[J].Proceedings of SPIE, 2012.

[11]Gupta M, Nayar S K, Hullin M B, et al. Phasor Imaging: AGeneralization of Correla-tion-Based Time-of-Flight Imaging[J]. ACM Transaction-son Graphics, 2015, 34(5).

[12] Fuchs S. Multipath Interference Comp-ensation in Time-of-FlightCamera Images[C]. International Conference on Pattern Recog-nition, 2010:3583-3586.

[13] Bhandari A, Feigin M, Izadi S, et al. Re-solving multipathinterference in Kinect: An in-verse problem approach[C]. IEEE Sensors, 20-14:614-617.

[14] Son K, Liu M, Taguchi Y, et al. Learning to Remove Multipath Distortionsin Time-of-Fl-ight Range Images for a Robotic Arm Setup-[J]. ar-Xiv: ComputerVision and Pattern Recogni-tion, 2016.

[15] Xuan V N, Hartmann K, Weihs W, et al. Multi-targetsuper-resolution using compres-sive sensing arguments for multipath interfer-encerecovery[C]. International Workshop on Compressed Sensing Theory and itsApplica-tions to Radar, Sonar and Remote Sensing, 2016: 148-152.

[16] Liu J, Liu Y, Hullin M B, et al. Fourier Analysis on TransientImaging with a Multifre-quency Time-of-Flight Camera[C]. computer vision andpattern recognition, 2014: 3230-3237.

[17] Mutny M, Nair R, Gottfried J, et al. Lear-ning the Correctionfor Multi-Path Deviations in Time-of-Flight Cameras[J]. arXiv: Computer Visionand Pattern Recognition, 2015.

[18] Agresti G, Zanuttigh P. Combination of Spatially-Modulated ToFand Structured Light for MPI-Free Depth Estimation[C]. European Conference onComputer Vision, 2018: 355-371.

[19] Agresti G, Zanuttigh P. Deep Learning for Multi-path ErrorRemoval in ToF Sensors[C]. European Conference on Computer Vision, 20-18:410-426.

[20] Jiang B, Jin X, Peng Y, et al. Design of mu-ltipath errorcorrection algorithm of coarse and fine sparse decomposition based oncom-press-ed sensing in time-of-flight cameras[J]. The Imaging Science Journal,2019, 67(8): 464-474.

[21] Bhandari A , Kadambi A , Whyte R , et al. Resolving multipathinterference in time-of-flight imaging via modulation frequency dive-rsity andsparse regularization[J]. Optics Lette-rs, 2014, 39(6):1705-8.

[22] Dorrington A A , Godbaz J P , Cree M J , et al. Separating truerange measurements from multi-path and scattering interference in com-mercial range cameras[J]. Proceedings of Spie the International Society for OpticalEnginee-ring, 2011, 7864.

[23] Whyte R, Streeter L, Cree M J, et al. Re-solving multiplepropagation paths in time of flight range cameras using direct and globa-lseparation methods[J]. Optical Engineering, 2015, 54(11): 113109-113109.

[24] Karel W, Ghuffar S, Pfeifer N, et al. Mod-elling andCompensating Internal Light Scatter-ing in Time of Flight Range Cameras[J]. Photogrammetric Record, 2012, 27(138): 155-174.

[25] https://baike.baidu.com/item/%E5%A4%9A%E5%BE%84/3975124?fr=aladdin

514

514

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?