DeepSeek 赋能具身智能中的长时序任务规划

DeepSeek 模型的核心能力

DeepSeek - V3/R1模型在长时序任务规划中扮演了“高层级大脑”的角色,主要体现在以下几个方面:

1. 理解人类的“模糊指令”

想象一下,你对一个机器人说:“帮我准备晚餐。”这听起来简单,但背后却藏着无数细节。DeepSeek 的模型能解析这种自然语言指令,弄清楚“晚餐”可能意味着什么——是煮个泡面,还是准备一桌丰盛的大餐?它会根据上下文和用户习惯,把任务拆解成具体的步骤。

2. 任务分解大师

复杂任务就像一个大拼图,DeepSeek 的模型擅长把这个拼图拆成小块。比如“做一盘意大利面”会被分解为:烧水、加盐、煮面、准备酱料、混合成品。每一个步骤都清晰可执行,让机器人不至于“手忙脚乱”。

3. 灵活规划与决策

现实世界充满意外,比如厨房里没有足够的面条怎么办?DeepSeek 的模型能根据环境变化调整计划,提出替代方案(比如用米饭代替),甚至还能根据实时反馈(比如水开了)优化下一步动作。

4. 代码生成,解放程序员

最酷的是,DeepSeek 的模型还能直接生成控制机器人的代码。无论是让机械臂抓取食材,还是设定烹饪时间,这些代码都能自动生成,省去了大量手动编程的麻烦。

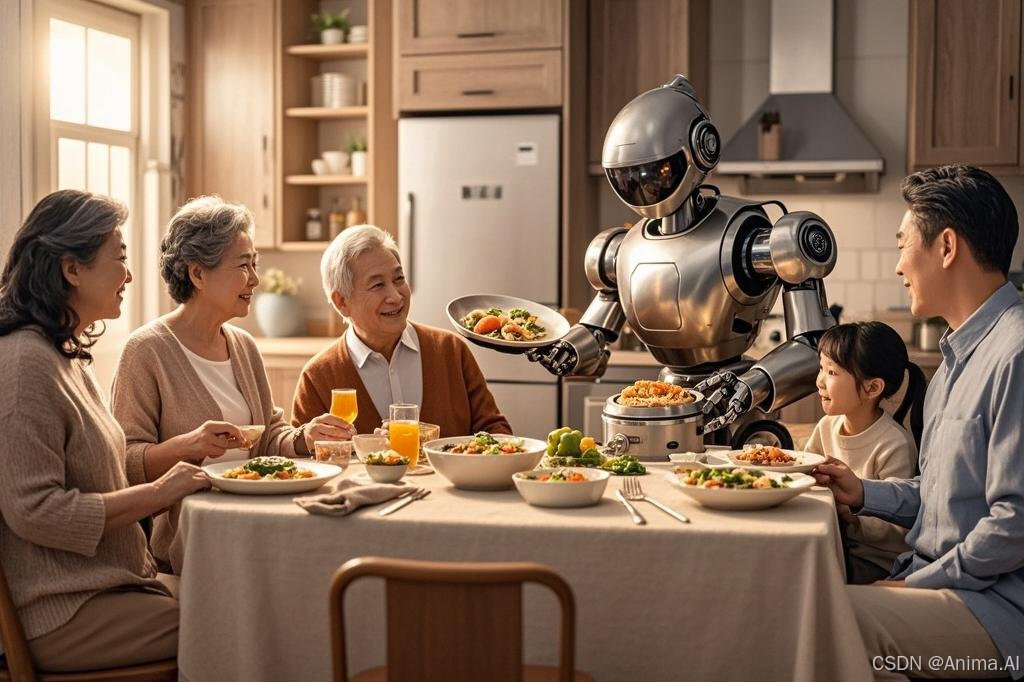

一个有趣的例子:烹饪机器人

为了让这一切更生动,我们来看一个场景:一个搭载 DeepSeek 模型的烹饪机器人要为你做一盘意大利面。

任务背景

- 指令:用户说:“请做一份意大利面。”

- 挑战:机器人需要理解食谱、准备食材、烹饪,还要应对意外(比如橱柜里只有半包面条)。

DeepSeek 如何“上场”

-

理解指令

用户的“请做一份意大利面”被模型解析为一个具体的目标:制作一盘可食用的意大利面。 -

分解任务

模型把任务拆成以下步骤:- 烧开一锅水

- 加一小勺盐

- 煮面条 10 分钟

- 准备番茄酱

- 把面和酱混合

-

规划与调整

机器人检查厨房,发现只有半包面条。DeepSeek 模型迅速调整计划,减少水的用量,并确保酱料比例匹配。 -

生成代码

假设具体动作的API已经提前封装好了,以下是一个由DeepSeek生成的简化的 Python 代码片段,展示机器人如何执行“煮面”这一步:

# 烧水

robot.move_to("stove") # 移动到炉灶

robot.fill_pot_with_water(2) # 加 2 升水

robot.turn_on_stove() # 开火

robot.wait_for_water_to_boil() # 等待水沸腾

# 加盐

robot.add_salt(5) # 加 5 克盐

# 煮面条

robot.add_pasta(200) # 加 200 克面条

robot.set_timer(10) # 设置 10 分钟计时器

robot.wait_for_timer() # 等待完成

# 后续步骤

robot.drain_pasta() # 沥干面条

DeepSeek 模型的独特优势

成本低,效率高

DeepSeek 的模型训练成本仅为 GPT-4 的几分之一,却能达到相似的性能。这意味着更多公司和研究者可以用得起这种技术,推动具身智能的普及。

开源的力量

采用 MIT 许可,DeepSeek 的模型向全世界敞开大门。开发者可以自由下载、修改、优化,社区的集体智慧让技术进步更快。

多模态的潜力

除了语言,DeepSeek 的模型还能处理图像等数据。比如,机器人可以通过摄像头识别食材,再结合语言指令决定下一步动作。这种多模态能力让它在现实世界中更“聪明”。

但是要真正吃到一个大脑里装着DeepSeek的机器人做的一桌子饭,我们还有些路要走。

当前的技术瓶颈

在具身智能的应用场景中,例如一个在厨房中执行长时序任务(如烹饪)的机器人,DeepSeek 的语言模型(LLMs)虽然展现了潜力,但仍面临以下关键技术瓶颈:

-

模型的可解释性和透明度不足

烹饪机器人需要根据环境变化(如水沸腾或食材状态)做出决策,但 DeepSeek 模型的决策过程对人类来说是一个“黑盒子”。例如,如果机器人错误地调高了火候,用户无法快速理解其原因,也难以调试或改进系统。这种缺乏透明性的问题在需要安全性和可信度的场景中尤为突出。 -

实时性和计算效率的限制

长时序任务要求机器人快速响应动态环境,例如在水沸腾时立即调整火力。然而,LLMs 的高计算需求使得其处理速度可能无法满足实时性要求,尤其是在资源有限的嵌入式机器人平台上。这可能导致任务失败或效率低下。 -

数据隐私和伦理挑战

开源模型如 DeepSeek 促进了技术创新,但在实际应用中(如家庭厨房),机器人可能接触到用户的私人数据(如饮食习惯)。如果缺乏保护机制,这些数据可能被滥用,或模型本身可能被恶意修改,带来安全隐患。 -

多模态整合的不足

烹饪任务需要机器人综合处理视觉(食材状态)、听觉(水沸腾的声音)和语言指令等多种信息。虽然 DeepSeek 在语言处理上表现出色,但在整合多模态数据时仍显不足。例如,机器人可能无法准确判断食材是否煮熟,导致任务结果不佳。 -

鲁棒性和泛化能力的局限

一个在特定厨房训练的烹饪机器人,面对不同的厨房布局、器具或食材种类时可能表现不佳。例如,如果训练数据中只有电炉,而实际环境使用燃气灶,机器人可能无法适应。这种泛化能力的不足限制了其在多样化场景中的应用。

未来的发展路线

为了克服上述瓶颈并推动具身智能在应用场景中的发展,未来的技术路线将聚焦以下方向:

-

提升模型的可解释性

未来的研究将致力于让模型的决策过程更透明。例如,通过可视化注意力机制,用户可以了解机器人为何在某一时刻选择了特定动作(如搅拌食材)。此外,生成解释性文本(如“水已沸腾,因此我降低了火力”)也能帮助用户信任和监督机器人。 -

优化实时性和计算效率

通过模型压缩、量化技术以及专用硬件加速器(如边缘计算芯片),未来的 LLMs 将能够在资源受限的机器人平台上更快运行。例如,一个烹饪机器人可以在几毫秒内完成环境分析并调整操作,确保任务无缝进行。 -

强化隐私和伦理保护

未来的发展将引入更强的隐私保护技术,如联邦学习(数据无需离开本地即可训练模型)或差分隐私(保护用户数据不被逆向推导)。同时,制定明确的伦理准则,确保机器人在家庭场景中的使用安全且符合道德标准。 -

推进多模态整合

通过跨模态注意力机制,未来的模型将更好地融合视觉、听觉和语言数据。例如,烹饪机器人可以根据食材的颜色变化(视觉)和锅内声音(听觉)判断烹饪进度,从而更准确地执行任务。 -

增强鲁棒性和泛化能力

借助迁移学习和元学习技术,未来的机器人将能够快速适应新环境。例如,一个烹饪机器人在不同厨房中只需少量数据或实时学习,就能掌握新的布局和工具,提高其实用性。

总结

在烹饪机器人等具身智能应用场景中,DeepSeek 的 LLMs 展示了长时序任务规划的潜力,但可解释性、实时性、隐私、多模态整合和泛化能力仍是当前的技术瓶颈。未来,通过提升透明度、优化效率、加强隐私保护、改进多模态能力和增强适应性,这些挑战有望被逐步解决。我们期待未来的机器人不仅能高效完成复杂任务,还能以更安全、智能的方式融入日常生活。

117

117

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?