点击下方卡片,关注“具身智能之心”公众号

在机器人技术不断演进的当下,复杂自主系统的开发是行业追求的目标之一。双臂协调能力使得机器人能够像人类一样,利用双臂完成更为复杂和精细的操作。例如在装配任务中,双臂机器人可以同时握住不同的零件,并将它们精确地组装在一起,这是单臂机器人难以实现的。先进工具使用能力则进一步拓展了机器人的功能。机器人可以根据任务需求,选择并使用合适的工具,如使用螺丝刀拧紧螺丝、使用钳子夹取物品等。这种能力与双臂协调相结合,能够让机器人在面对各种复杂任务时,具备更强的适应性和操作能力,从而更好地实现自主系统的复杂功能。然而,这些领域的进步受到缺乏专门的、高质量的训练数据的严重阻碍。这些活动往往需要定制的解决方案,难以标准化,并且在传统数据集中通常没有很好的体现。

图注:Astribot S1机器人双臂协同操作展示。视频来源:https://www.bilibili.com/video/BV1yJ4m1H7V2/?vd_source=60762b2741beebb14f0eaac7c46cc65f

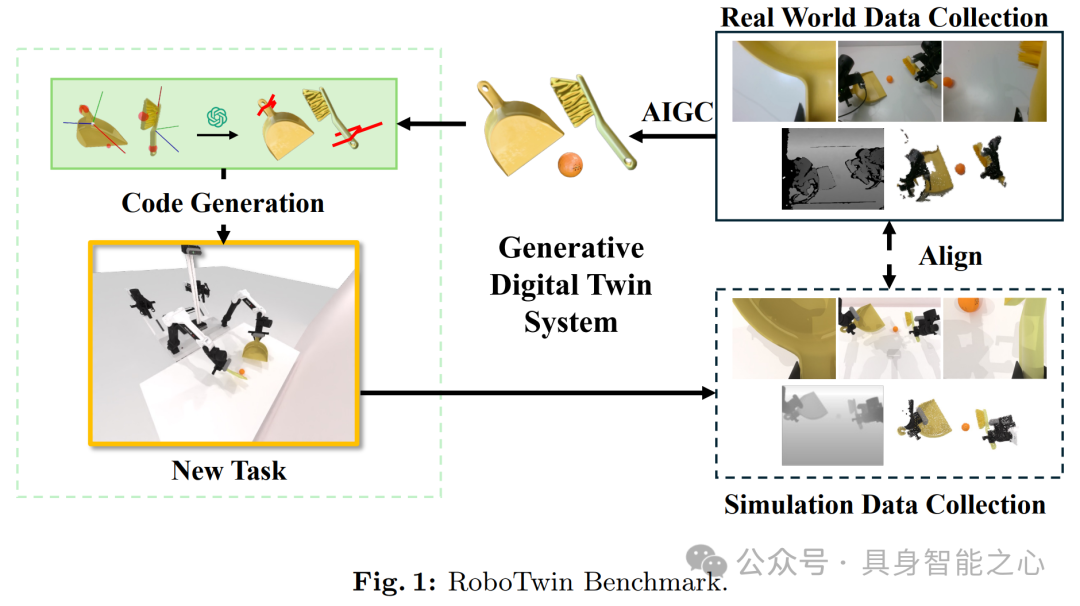

2024 ECCV 中,具身智能的协同智能WORKSHOP (WORKSHOP ON COOPERATIVE INTELLGENCE FOR EMBODIED AI) 最佳论文旨在解决这一关键差距,引入了 “RoboTwin”。它是一个综合基准,包括现实世界的遥控操作数据和由数字孪生生成的相应合成数据,专门用于涉及双臂机器人工具使用和人机交互的场景。

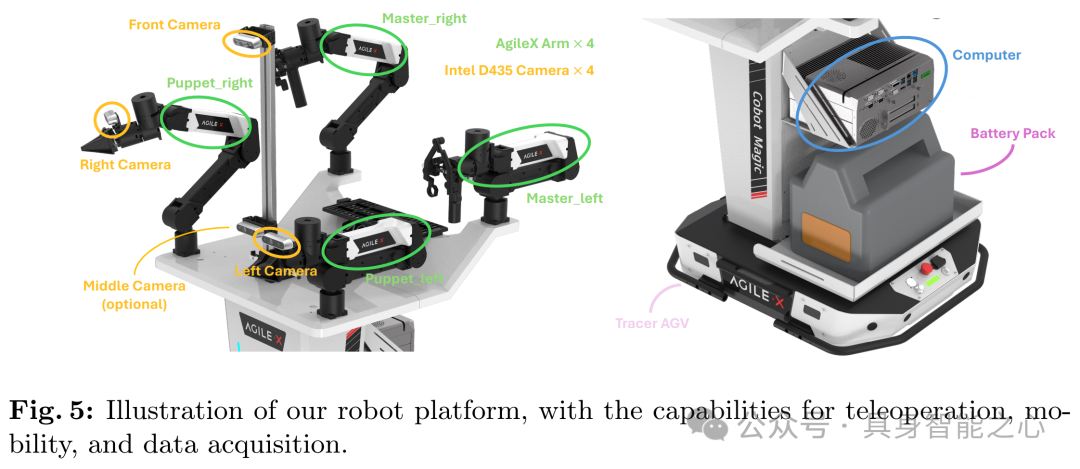

首先使用 AgileX Robotics 开发的开源 COBOT Magic 平台收集数据,该平台配备了四个 AgileX Arms 和四个 Intel Realsense D - 435 RGBD 摄像头,安装在坚固的 Tracer 底盘上,数据涵盖工具使用和人机交互等各种典型任务。

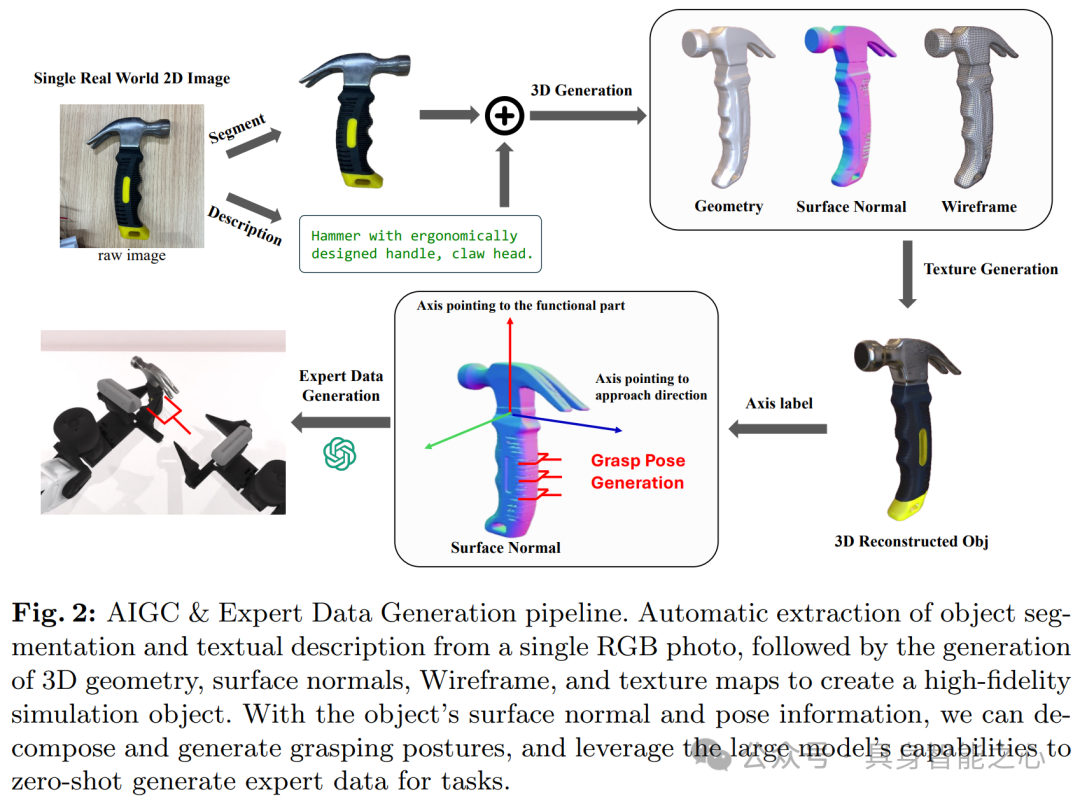

从现实世界数据收集到虚拟复制的过程中,创建数字孪生面临挑战。传统方法依赖昂贵的高保真传感器,本文开发了一种使用人工智能生成内容(AIGC),从单个 2D RGB 图像构建 3D 模型的经济有效的新方法。该方法能降低成本,提供逼真的视觉效果并支持物理模拟,包括将 2D 图像转换为具有复杂几何形状等的 3D 模型,还通过定义功能坐标轴来增强模型以实现抓取姿态的自动计算。

为增强数据集的实用性和相关性,建立了一个利用大型语言模型(LLMs)自动生成专家级训练数据。该方法丰富了数据集,还整合了 LLMs 的多功能性,如利用 GPT4 - V 自动生成任务特定的姿态序列以提高任务执行精度,使用 GPT4 生成的脚本来激活轨迹规划工具以简化编程和加快机器人系统部署。

论文链接:https://arxiv.org/pdf/2409.02920

项目主页:https://robotwin-benchmark.github.io/early-version/#:~:text=This%20paper%20introduces%20RoboTwin,%20a%20novel%20benchmark%20dataset%20combining%20real-world

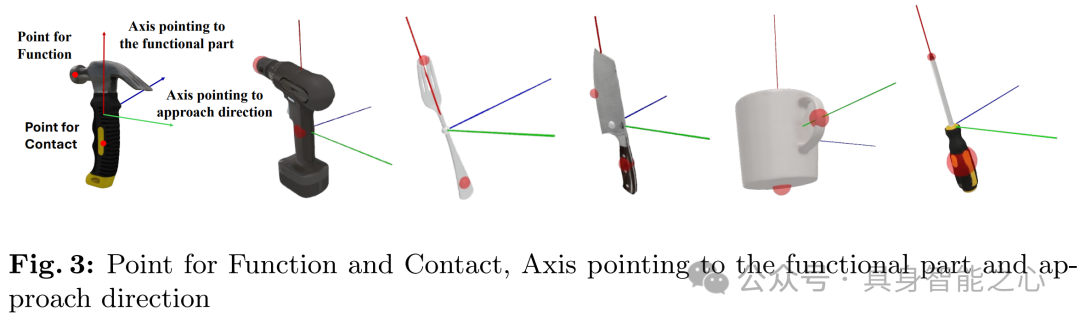

那么,文章是如何创建数字孪生(将物理实体或系统的各种特性和行为以数字化的形式进行精确模拟和映射)的呢?文章基于 Deemos’s Rodin 平台,从单个 2D RGB 图像构建 3D 模型,过程如下:首先将单张 2D 图像转换为包含详细几何形状、表面法线、线框和纹理的 3D 模型。这些特征增强了视觉真实感,并确保与物理模拟的引擎兼容。然后为模型内物体的功能部件指定特定坐标轴。例如对于锤子,一个轴与锤头(功能部分)对齐,另一个轴指示接近方向。抓取姿态沿着指定的接近方向轴垂直于功能部分的表面法线计算,这有助于机器人在操作和使用工具时能以最少的人工干预正确且高效地进行。

为了生成专家数据,首先借助 GPT4 - V 的推理能力编写代码,用于计算关键姿态和物体功能坐标轴之间的关系。GPT4 - V 会分析任务要求并生成符合要求的一系列姿态,确保任务的精确执行。然后通过 GPT4 生成的代码来调用轨迹规划工具,这些代码是基于计算出的姿态生成的。这种自动化操作大幅减少了手动编程所需的时间和人力,有助于机器人系统在不同应用中的快速部署,同时也为机器人学习提供了一种可扩展的高质量数据生成方法。

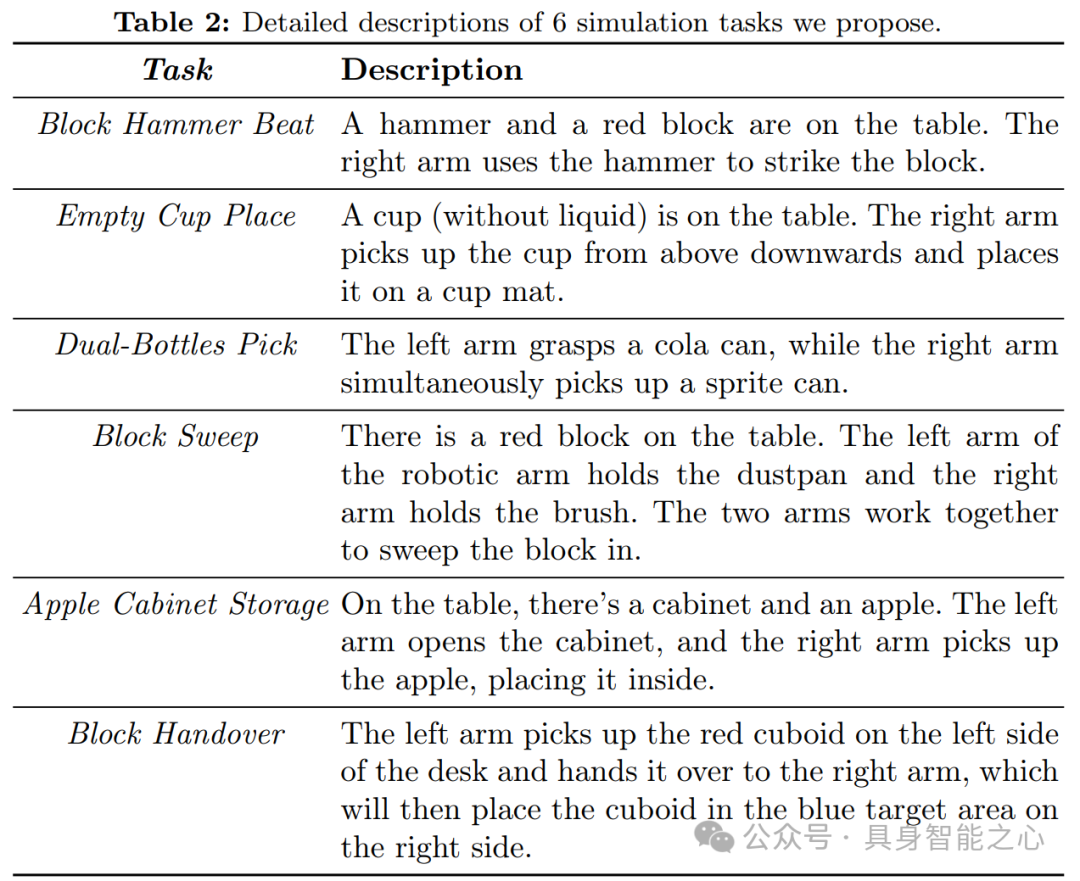

为了进一步推动该领域的研究和发展,如图 4 所示,文章引入了一个综合基准,专门用于评估各种场景下的双臂机器人。这个基准包含了一系列多样的任务,每个任务都呈现出独特的挑战,这些挑战对于评估模拟环境中机器人手臂的灵巧性、协调性和操作效率至关重要,任务范围从简单的物体操作到需要双臂同步运动的复杂协调动作。个基准旨在弥合理论机器人控制模型与其实际应用之间的差距,确保机器人系统能够在动态的现实世界环境中可靠地运行。

为了获取真实世界的数据,文章采用了AgileX Robotics公司的开源Cobot Magic 7平台,该平台配备了4个AgileX arm和4个英特尔Realsense D-435 RGBD摄像头,并建立在Tracer底盘上。这些摄像头一个在支架的高处,以扩大视野,两个在机器人手臂的手腕上,一个在支架的低处,这是可选的。前、左、右摄像头以30Hz的频率同时捕获数据,如图5所示。

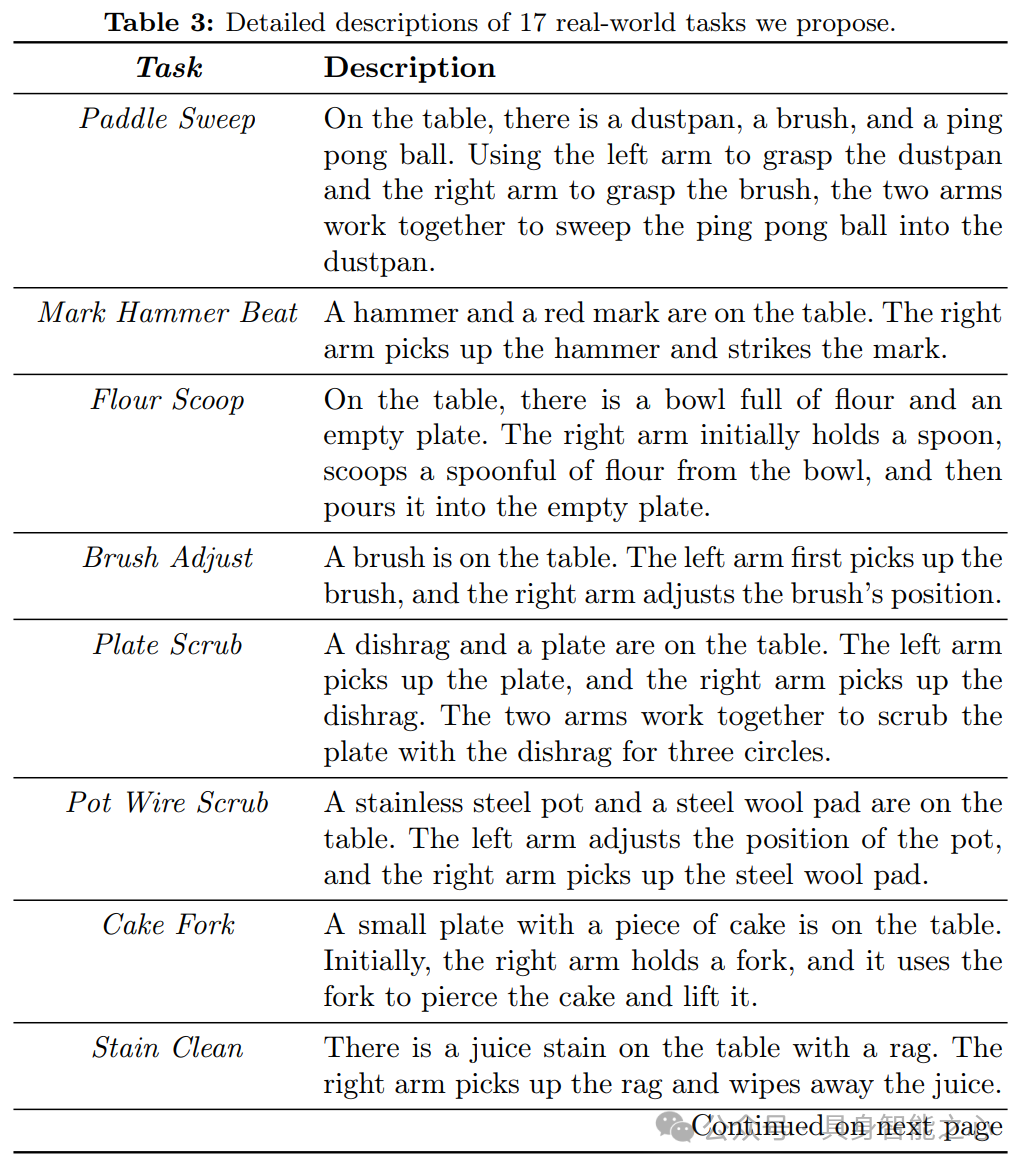

文章的数据集任务设计有两个主要亮点:关注人机交互和工具使用。文章设计了17个任务,其中9个任务强调工具使用,5个任务涉及人际互动,6个任务是双臂,每个任务收集了30个轨迹。

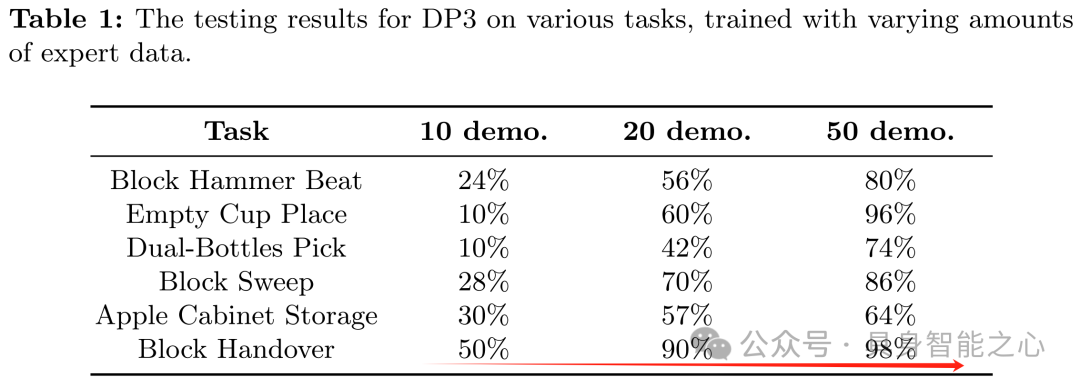

文章的实验旨在验证:a) COBOT Magic平台设置的合理性,b)自动生成的专家数据的有效性。文章使用3D Diffusion Policy (DP3)在基准内测试了6个任务,每个任务分别使用从10组、20组和50组专家数据中训练的策略进行测试,以获得成功率。实验结果如表1所示,所有任务的成功率皆随着演示次数的提升而大幅增加。“Block Handover”任务取得了最显著的改进,在50次演示中达到98%的成功率,远高于10次的50%。这些结果表明,专家演示的数量与任务成功之间存在很强的相关性,突出了自动生成的专家数据在提高COBOT Magic平台上的任务性能方面的有效性。这些数据进一步强调了为复杂任务制定稳健策略时,充分的训练示例的重要性。

总结

这篇文章引入了 RoboTwin,它是一个整合了现实世界和合成数据的基准,用于评估双臂机器人,解决了机器人领域专业训练数据严重短缺的问题。

数据集是使用 AgileX Robotics 平台开发的,并通过由 Deemos’s Rodin 平台提供支持的生成式数字孪生进行了增强。文章建立了一个便捷的从现实到模拟的管道,只需一张现实世界的 RGB 图像就能生成目标物体和相应场景的 3D 模型。该数据集有效加速了机器人系统的训练,能够使机器人在不同任务中的性能得到提升。

研究结果展示了这种混合数据方法在提高机器人灵巧性和效率方面的潜力,它是一个可扩展的工具,可能会给机器人研究和应用带来革命性的变化。

“具身智能之心”公众号持续推送具身智能领域热点:

往期 · 推荐

(1)具身多模态基础模型

NVIDIA最新!NVLM:开放级别的多模态大语言模型(视觉语言任务SOTA)

全面梳理视觉语言模型对齐方法:对比学习、自回归、注意力机制、强化学习等

CLIP怎么“魔改”?盘点CLIP系列模型泛化能力提升方面的研究

揭秘CNN与Transformer决策机制:设计原则是关键?

VILA:视觉推理能力如何up up?多模态预训练设计有妙招

(2)3D场景理解、分割与交互

大模型继续发力!SAM2Point联合SAM2,首次实现任意3D场景,任意Prompt的分割

更丝滑更逼真!模型自主发现与模式自动识别新升级助力三维场景构建与形状合成

进一步向开放识别迈进!3D场景理解与视觉语言模型的融合创新可以这样玩

(3)具身机器人与环境交互

Robust Robot Walker:跨越微小陷阱,行动更加稳健!

波士顿动力最新SOTA!ThinkGrasp:通过GPT-4o完成杂乱环境中的抓取工作

基础模型如何更好应用在具身智能中?美的集团最新研究成果揭秘!

(4)具身仿真×自动驾驶

东京大学最新!CoVLA:用于自动驾驶的综合视觉-语言-动作数据集

ECCV 2024 Oral | DVLO:具有双向结构对齐功能的融合网络,助力视觉/激光雷达里程计新突破

(5)权威赛事结果速递

模型与场景的交互性再升级!感知、行为预测以及运动规划在Waymo2024挑战赛中有哪些亮点

效率和精度齐飞!CVPR2024 AIS workshop亮点大盘点

(6)具身智能工具深度测评

巨好用的工具安利!胜过WPS?MinerU 帮你扫清PDF提取

UCLA出品!用于城市空间的具身人工智能模拟平台:MetaUrban

(7)具身智能时事速递

端到端、多模态、LLM如何与具身智能融合?看完这50家公司就明白了

见证历史?高通准备收购英特尔!

万张A100“堆”出来的勇气:一个更极致的中国技术理想主义故事

即将截止!ECCV'24自动驾驶难例场景多模态理解与视频生成挑战赛

6067

6067

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?