BERT(Bidirectional Encoder Representations from Transformers)作为一种强大的预训练语言模型,已经在自然语言处理领域取得了显著的成果。

一、什么是BERT模型

BERT是由Google提出的一种预训练语言表示模型,它通过双向Transformer结构来捕捉文本中的上下文信息。BERT模型在多种NLP任务中表现出色,如文本分类、问答系统等。

二、BERT基础教程:Transformer大模型实战

这里给大家推荐一本《BERT基础教程:Transformer大模型实战》书籍。

-

这本书聚焦谷歌公司开发的BERT自然语言处理模型,由浅入深地介绍了BERT的工作原理、BERT的各种变体及其应用。

-

这本书呈现了大量示意图、代码和实例,详细解析了如何训练BERT模型、如何使用BERT模型执行自然语言推理任务、文本摘要任务、问答任务、命名实体识别任务等各种下游任务,以及如何将BERT模型应用于多种语言。

-

通读本书后,读者不仅能够系统了解有关BERT的各种概念、术语和原理,还能够使用BERT模型及其变体执行各种自然语言处理任务。

有需要这本

《BERT基础教程:Transformer大模型实战》书籍PDF文档,可以微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

三、书籍目录内容

第一部分 开始使用BERT

第 1 章 Transformer 概览

1.1 Transformer 简介

1.2 理解编码器

1.3 理解解码器

1.4 整合编码器和解码器

1.5 训练Transformer

第 2章 了解BERT 模型

2.1 BERT 的基本理念

2.2 BERT 的工作原理

2.3 BERT 的配置

2.4 BERT 模型预训练

2.5 子词词元化算法

第3章 BERT实战

3.1 预训练的BERT模型

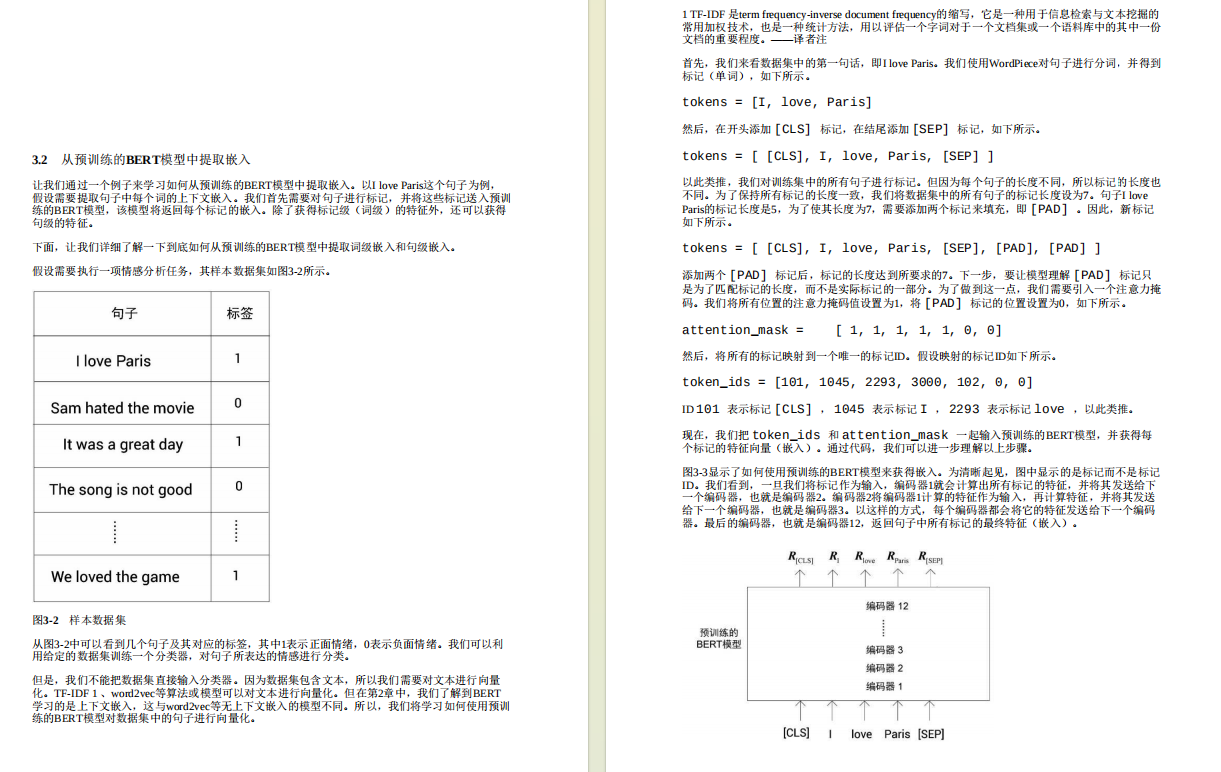

3.2 从预训练的BERT模型中提取嵌入

3.3 从BERT 的所有编码器层中提取嵌入

3.4 针对下游任务进行微调

第二部分 探索BERT 变体

第4章 BERT 变体(上):ALBERT、RoBERTa、ELECTRA和SpanBERT

4.1 BERT 的精简版ALBERT

4.2 从ALBERT 中提取嵌入

4.3 了解RoBERTa

4.4 了解ELECTRA

4.5 用SpanBERT 预测文本段

第5章 BERT 变体(下):基于知识蒸馏

5.1 知识蒸馏简介

5.2 DistilBERT 模型——BERT模型的知识蒸馏版本

5.3 TinyBERT 模型简介

5.4 将知识从BERT 模型迁移到神经网络中

第三部分 BERT 模型的应用

第6章 用于文本摘要任务的BERTSUM 模型

6.1 文本摘要任务

6.2 为文本摘要任务微调BERT模型

6.3 理解ROUGE 评估指标

6.4 BERTSUM 模型的性能

6.5 训练BERTSUM 模型

第7章 将BERT 模型应用于其他语言

7.1 理解多语言BERT 模型

7.2 M-BERT 模型的多语言表现

7.3 跨语言模型

7.4 理解XLM-R模型

7.5 特定语言的BERT模型

第8章 Sentence-BERT模型和特定领域的BERT 模型

8.1 用Sentence-BERT模型生成句子特征

8.2 sentence-transformers库

8.3 通过知识蒸馏迁移多语言嵌入

8.4 特定领域的BERT模型:ClinicalBERT模型和BioBERT模型

第9 章 VideoBERT模型和BART模型

9.1 VideoBERT模型学习语言及视频特征

9.2 了解BART模型

9.3 探讨BERT库

有需要这本

《BERT基础教程:Transformer大模型实战》书籍PDF文档,可以微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

457

457

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?