Cerebras可能大家并不是特别熟悉,它们一直在研发特大号的芯片,就比如它们发布的晶圆级引擎跟一个iPad还大。此次发布的 WSE-3 是专为训练业界最大的 AI 模型而打造的,基于 5 纳米、4 万亿晶体管的 WSE-3 将为 Cerebras CS-3 人工智能超级计算机提供动力,通过 90 万个人工智能优化的计算核心,提供每秒 125 petaflops 峰值 AI 性能(1 petaflops 是指每秒 1,000,000,000,000,000(1 万亿)次浮点运算)。

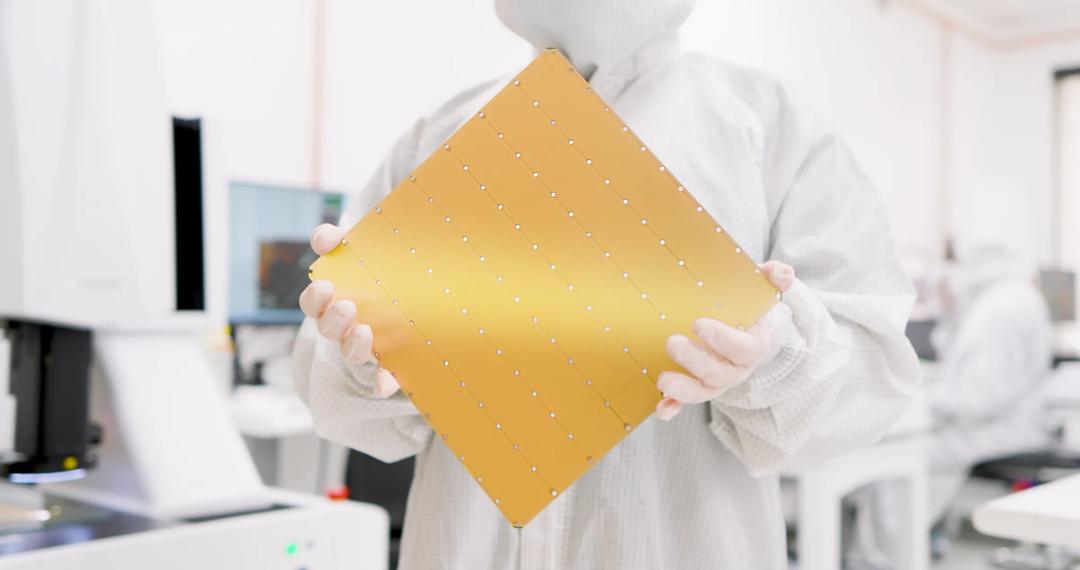

WSE-3 呈正方形,边长为 21.5 厘米(面积为 46225mm^2),几乎是使用了整个 300 毫米硅片来制造一个芯片。这么看来,凭借 WSE-3,Cerebras 可以继续生产世界上最大的单芯片了。

根据官方的介绍,Cerebras WSE-3拥有:

-

WSE-3 将 900,000 个 AI 内核打包到单个处理器上。WSE 上的每个内核都可以独立编程和优化,以用于基于张量的稀疏线性代数运算,这些运算支持深度学习的神经网络训练和推理,使其能够提供最高的性能、效率和灵活性。

-

与工作高速缓存很小的传统设备不同,WSE-3 采用 44GB 的超高速片上 SRAM,并将其均匀分布在芯片的整个表面上。这为每个内核提供了对极高带宽 (21 PB/s) 的快速内存的单时钟周期访问。这比领先的 GPU 高出 880 倍,带宽高出 7,000 倍。

-

WSE-3 晶圆上互连消除了通过电线和电缆连接数百个小型设备的通信速度减慢和效率低下的问题。它提供令人难以置信的 214 Pb/s 处理器互连带宽。这是图形处理器之间提供的带宽的 3,715 倍以上。

单芯片上的集群级性能

为何这么说呢?将WSE-3与世界上最大的GPU就知道了

对集群进行编程以扩展深度学习是痛苦的。它通常需要数十到数百个工程小时,并且仍然是许多人实现大规模 AI 对其工作价值的实际障碍。

在传统的 GPU 集群上,ML 研究人员(通常使用其 ML 框架的特殊版本)必须弄清楚如何分配他们的模型,同时仍然实现其收敛和性能目标的一部分。他们必须浏览各个处理器的内存容量、带宽、互连拓扑和同步的复杂层次结构;同时在此过程中执行无数的超参数和优化实验。更糟糕的是,最终的实现很容易更改,而这次只会延迟整体的解决时间。

有了 WSE,就没有瓶颈了。我们为您提供集群规模的 AI 计算资源,并且使用库存 PyTorch 的单台台式机的编程简便性。将时间花在 AI 发现上,而不是集群工程上。

高带宽,低延迟

WSE-3晶圆上的互连消除了通过电线和电缆连接数百个小设备时的通信延迟和效率低下问题。它在核心之间提供了惊人的214 Pb/s的互连带宽。这比领先的GPU之间提供的带宽高出3,715倍以上。其结果是在功耗仅为传统GPU集群一小部分的情况下,为您的深度学习工作提供更快、更高效的执行。

2290

2290

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?