论文笔记 之 Dynamic Video Segmentation Network)

1,本文解决的问题

本文是对DFF[30]的改进。改进了DFF的关键帧选取策略。关于DFF的论文笔记,请见论文笔记 之 Deep Feature Flow for Video Recognition

2,本文采用的策略

2.1,策略依据

作者观察到,视频中邻近帧往往有很大一部分相同的区域,如图Figure1所示:

作者观察到,如果场景中移动目标很少,那么邻近帧的差别就很小,反之差别很大,如图Figure2。对于前者Figure2(a),可以重用在邻近帧提取的特征,然后用尽可能少的计算(Shallower CNN)更新这些特征,对于后者Figure2(b),则要准确计算(Deeper CNN)。

基于以上观察,作者提出了自适应关键帧选取策略。

2.2,自适应关键帧选取策略adaptive key frame scheduling policy:

作者设计了一个**决策网络decision net-work (DN)**来判定keyframe,DN是本文的关键

准确来说,是key region 而不是key frame。作者首先将一张图划分成若干个区域输入到DN,输出expected confidence score。

基于expected confidence score将某个区域送到segmentation network还是 flow network。如果某区域的expected confidence score超过设定的阈值,则将该区域送到 flow network。反之送入segmentation network计算mask,并将其作为新的关键区域。

阈值设定越高,fps越低,精度越高。我们可以选取不同的阈值,从而调整fps。

在本策略中有三个“超参数”:

1,图像的划分方式

2,区域边界的重叠大小

3,DN的结构。这是作者的说法,其实是将哪一层的特征输入到DN。因为输入DN的其实不是原图,而是Flow network的中间层输出。

2.3,决策网络decision net-work:

DN的输入是flow network的中间层特征。

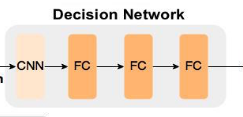

DN的结构如下:

由一个卷积层和3个全连接层构成

那为什么要基于区域而不是基于整张图片处理呢?

1,如前所述,作者观察到两张连续图片往往有一部分相似,有一部分区域不同,如图Figure1所示,因此基于区域更加准确。这一点也在实验中得到了验证,如图Figure5:

注:confidence score不是DN的预测值,是DN的真值。即该区域通过flow network的结果和通过segmentation预测的结果的IOU。

3,实验:

3.1,整体有效性实验:

采用了三个模型作为实验的baseline:DeepLab-Fast, PSPNet, and DeepLab-v2

DeepLab-Fast是DeepLab-v2 [6]的一个修改版本,PSPNet和DeepLab-v2分别是reproduce了PSPNet [8] 和DeepLab-v2 [6]得到的。所谓reproduce是:移除了 CRF, multi-scale inferencing, and slidingwindow segmentation。目的是加快速度。

采用[35]的FlowNet2-S和FlowNet2-s作为本文模型的flow network。

将图像划分为若干区域时,区域边界互相重叠64个像素。

结果表Table1所示:

其中:t表示阈值

精度-速度-阈值关系见图Figure8:

精度-速度-阈值关系见图Figure8:

注:每条曲线上的点表示不同的阈值取值。

3.2, 自适应关键帧选取策略有效性实验:

实验结果见图Figure9:

其中:

其中:

Frame difference是直接在原图上计算灰度差别,见公式(2)。

Flow magnitude是计算平均光流尺度,见公式(3)

结果验证了自适应关键帧选取策略的有效性,同时也证明直接在原图上比较区别是不靠谱的,其实我觉得这是显然的。

3.3,DN的多种结构实验:

我们采用了图Figure7的多种结构:

即将分别给DN不同的输入,结果见表Table2:

即将分别给DN不同的输入,结果见表Table2:

3.4,不同的区域划分实验:

结果见表Table3:

Spatial W arping/Segmentation表示送入Flow Net和送入Segmentation Net的区域数量之比。显然数值越大越好。结果表明2x2划分最好。

3.4,区域边界重叠部分大小实验:

见图Figure10:

在精度达到70左右时,曲线饱和,再增大重叠区域不能很好的提高精度,反而时计算量快速增加。

4,参考文献:

[6] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, andA. L. Yuille, “Deeplab: Semantic image segmentation withdeep convolutional nets, atrous convolution, and fully con-nected CRFs,”IEEE Trans. Pattern Analysis and MachineIntelligence (TPAMI), Apr. 2017. 1, 2, 3, 6

[8] H. Zhao, J. Shi, X. Qi, X. Wang, and J. Jia, “Pyramid sceneparsing network,” inProc. IEEE Conf. Computer Vision andPattern Recognition (CVPR), pp. 6230-6239, Jul. 2017. 1, 2,3,

[30] X. Zhu, Y. Xiong, J. Dai, L. Yuan, and Y. Wei, “Deep featureflow for video recognition,” inProc. IEEE Conf. ComputerVision and Pattern Recognition (CVPR), pp. 4141-4150, Jul.2017. 1, 2, 3, 4, 6, 7

[35] E. Ilget al., “FlowNet 2.0: Evolution of optical flow esti-mation with deep networks,” inProc. IEEE Conf. ComputerVision and Pattern Recognition (CVPR), pp. 1647-1655, Jul.2017. 2, 3, 6

813

813

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?