系列文章目录

玩转大语言模型——使用langchain和Ollama本地部署大语言模型

玩转大语言模型——三分钟教你用langchain+提示词工程获得猫娘女友

玩转大语言模型——ollama导入huggingface下载的模型

玩转大语言模型——langchain调用ollama视觉多模态语言模型

玩转大语言模型——使用transformers中的pipeline调用huggingface中模型

玩转大语言模型——transformers微调huggingface格式的中文Bert模型

玩转大语言模型——使用GraphRAG+Ollama构建知识图谱

玩转大语言模型——完美解决GraphRAG构建的知识图谱全为英文的问题

玩转大语言模型——配置图数据库Neo4j(含apoc插件)并导入GraphRAG生成的知识图谱

玩转大语言模型——本地部署带聊天界面deepseek R1的小白教程

玩转大语言模型——本地部署deepseek R1和本地数据库的小白教程(Ollama+AnythingLLM)

玩转大语言模型——使用LM Studio在本地部署deepseek R1的零基础)教程

玩转大语言模型——Ubuntu系统环境下使用llama.cpp进行CPU与GPU混合推理deepseek

玩转大语言模型——使用Kiln AI可视化环境进行大语言模型微调数据合成

文章目录

前言

在前期的几个文章中我们已经介绍了很多带UI的本地化部署方式了,而今天我们要介绍的LM Studio,不仅可以实现本机的使用,还可以为其他软件或处于同一局域网下的其他计算机提供接口的调用,和其他本地部署软件配合起来使用更佳。本章将介绍在Windows环境下和Linux环境下下载并部署LM-Studio

Windows环境下载安装

官网:https://lmstudio.ai/

在官网上找到合适的版本直接下载

下载后根据指引安装,进入到页面后点击Get your first KLM

然后点右上角skip,进入到以下界面

Linux环境下载安装

下载

选择这个适用于Linux的软件版本,下载下来是这个这样的文件,一般是在/home/用户名/Downloads路径下

为文件赋予权限

sudo chmod u+x LM-Studio-0.3.10-6-x64.AppImage

增加权限后双击这个文件就可以运行了,不过在软件栏里并不能找到这个应用

将LM Studio添加到应用栏

抽取desktop文件和图标文件

./LM-Studio-0.3.10-6-x64.AppImage --appimage-extract

执行问命令后会在当前目录出现一个squashfs-root的文件夹

进入文件夹看到的这两个文件就是抽取出来的我们需要的文件

编辑lm-studio.desktop文件,把Exec和Icon替换成读者自己的路径即可

[Desktop Entry]

Name=LM Studio

Exec=/home/aixing/Downloads/LM-Studio-0.3.10-6-x64.AppImage --no-sandbox %U

Terminal=false

Type=Application

Icon=/home/aixing/Downloads/squashfs-root/lm-studio.png

StartupWMClass=LM Studio

X-AppImage-Version=0.3.10

Comment=Use the chat UI or local server to experiment and develop with local LLMs.

Keywords=developer;llm;

category=Development;Utility;

MimeType=x-scheme-handler/lmstudio;

Categories=Development;

需要特别注意的是,路径要求是绝对路径,查看路径的命令为pwd

添加并更新应用栏

将配置好的.desktop文件移动到应用目录下

cp lm-studio.desktop $HOME/.local/share/applications/

更新应用栏

update-desktop-database $HOME/.local/share/applications/

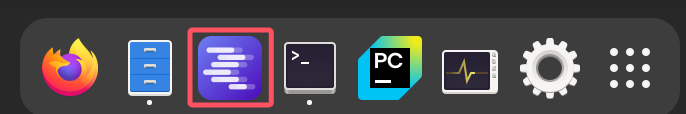

更新过后就可以看到应用栏上添加了LM-Studo了

修改配置

设置语言为中文

点击右下角这个标志

然后选择语言为简体中文

修改模型存储位置

点击左下角的Power User或者Developer

选择左侧文件夹的图标,然后更改模型路径。修改路径这一步的原因是,大语言模型占的存储空间一般都比较大,为避免过多占用C盘空间,一般换到其他盘符下,但如果C盘空间足够,可以跳过此步骤。

下载模型

特别注意的是,LM Studio中用到的模型格式均为gguf格式。

模型可以从modelscope或者hf-mirror下载,笔者在本篇中是使用modelscope中下载的deepseek R1-7B模型。

下载链接:https://modelscope.cn/models/unsloth/DeepSeek-R1-Distill-Qwen-7B-GGUF/files

来到下载页面,发现有多个gguf模型,有满血7B模型和量化到各种程度的模型,建议参照模型大小是稍小于本地显存即可

查看本地显存的方式为:打开任务管理器,点击性能,查看NVIDAI的GPU内存

这里需要注意的是,LM Studio需要的模型需要放到二级目录下,我们需要在刚刚设置的模型目录下新建两级目录。为了方便辨别,笔者推荐将下载好的模型放在模型目录/模型名/模型版本路径下,比如笔者将

下载的gguf模型放到目录:模型目录/deepseek/DeepSeek-R1-Distill-Qwen-7B下。

模型加载与运行

点击上侧的按钮选择本地模型运行

选择好模型后进入对话界面

使用结束时记得点击Eject卸载模型,不然会一直占用显存

模型应用

上传附件

点击这个回形针,可以上传本地文档,

点击后进入以下界面,这一操作后,LM Studio会自动对文档做信息增强检索(RAG)。

笔者上传的是一个由AI生成的学校制度大纲,以这个为例问他主要介绍了什么

点击发送后会根据文档内容回答

提供API接口服务

点击左侧绿色按钮,然后加载模型

然后把Settings中的所有设置全打开,再点击左侧的按钮启动

如果在启动时右侧有以下报错,可以考虑修改一下端口号

笔者修改成了2345端口

右侧提示信息如下图所示说明能够正常应用

LM Studio所支持的接口调用与OpenAI的接口一致

为了快速验证是否可以正常使用,笔者直接打开之前文章中配置过的Anything LLM,点击设置并选择LLM提供者

选择LM Studio

如果在前面调整过端口,需要再点进去一次,更改端口,更改的端口要与之前修改的一致,笔者更改的是2345,所以这里也应该是2345

同时,如果在设置时没有自动弹出来模型,也需要自己设置一下

随后点击Save Settings保存后就可以使用Anything LLM调用接口了

3157

3157

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?