mmseg配置解析 Polynomial Decay 多项式衰减

B站:肆十二-的个人空间-肆十二-个人主页-哔哩哔哩视频 (bilibili.com)

博客:肆十二-CSDN博客

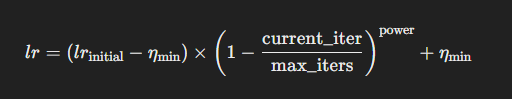

Polynomial Decay(多项式衰减)是一种常用于深度学习中学习率调度的方法。在训练过程中,学习率从初始值逐步减少到一个最小值(eta_min),以帮助模型更好地收敛到最优解。Polynomial Decay 的衰减过程遵循一个多项式函数,其公式如下:

Polynomial Decay 公式

如果我们设定初始学习率为 lr_initial,最小学习率为 eta_min,训练的总步数为 max_iters,当前的步数为 current_iter,衰减的指数为 power,那么 Polynomial Decay 的学习率 lr 可以表示为:

参数解释

lr_initial:初始学习率,训练开始时的学习率。eta_min:最小学习率,训练结束时的学习率。current_iter:当前的迭代次数。max_iters:总迭代次数,训练的总步数。power:多项式的幂次,控制衰减曲线的形状。power越大,学习率衰减越慢;power越小,学习率衰减越快。

举例说明

假设我们有以下参数:

- 初始学习率

lr_initial = 0.1 - 最小学习率

eta_min = 0.001 - 总迭代次数

max_iters = 1000 - 当前迭代次数

current_iter = 500 - 衰减指数

power = 2(表示二次衰减)

根据上述公式,学习率 lr 可以计算为:

l r = ( 0.1 − 0.001 ) × ( 1 − 5001000 ) 2 + 0.001 l r = ( 0.1 − 0.001 ) × ( 1 − 500 1000 ) 2 + 0.001 l r = ( 0.1 − 0.001 ) × ( 1 − 1000500 ) 2 + 0.001 lr=(0.1−0.001)×(1−5001000)2+0.001lr = (0.1 - 0.001) \times \left(1 - \frac{500}{1000}\right)^{2} + 0.001lr=(0.1−0.001)×(1−1000500)2+0.001 lr=(0.1−0.001)×(1−5001000

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?