最近在模型部署的时候直接使用yolov5的6.0版本的模型导出onnx文件,但是在使用的时候却报出输出节点名称对应不上的问题:

查看export.py文件,最终定义位置在160行左右。源码如下:

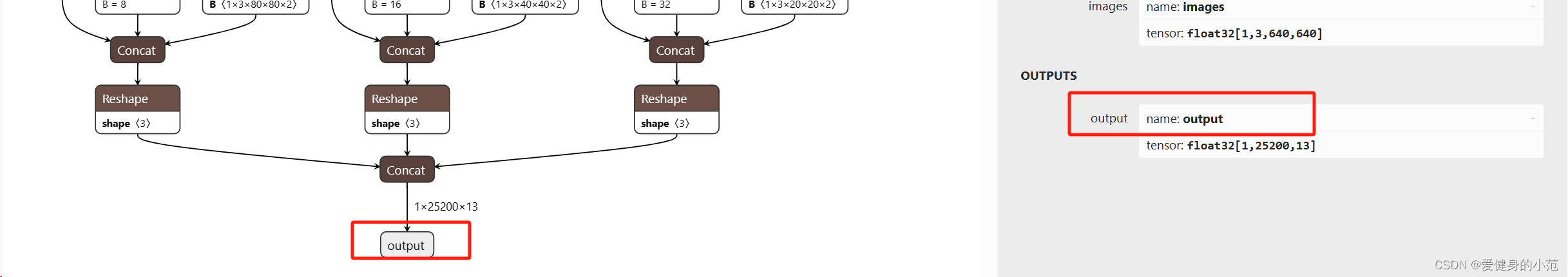

output_names = ['output0', 'output1'] if isinstance(model, SegmentationModel) else ['output0']源码的意思是根据是否是分割模型来定义输出节点的名称,将其中的output0修改为output之后所生成的onnx模型的输出节点就变成了output了,搞定,查看一下网络结构中的节点名称也没有问题。

标注:这个问题在expot.py导出engine模型的时候也会出现,需要注意,输出节点的名称不对的话就不能正确的读取信息,详情可以参考我的这一篇博文:

yolov5s进行tensorRT的VS部署时出现输出信息不正确的情况_yolo转tensorrt后精度不一致-CSDN博客

2008

2008

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?