论文阅读笔记(三)——YOLACT Real-time Instance Segmentation

简介

Abstract

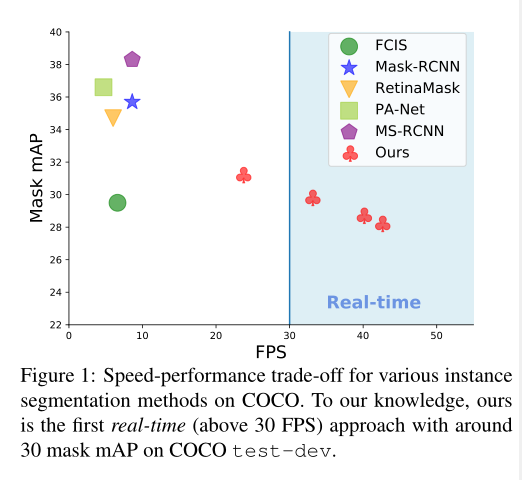

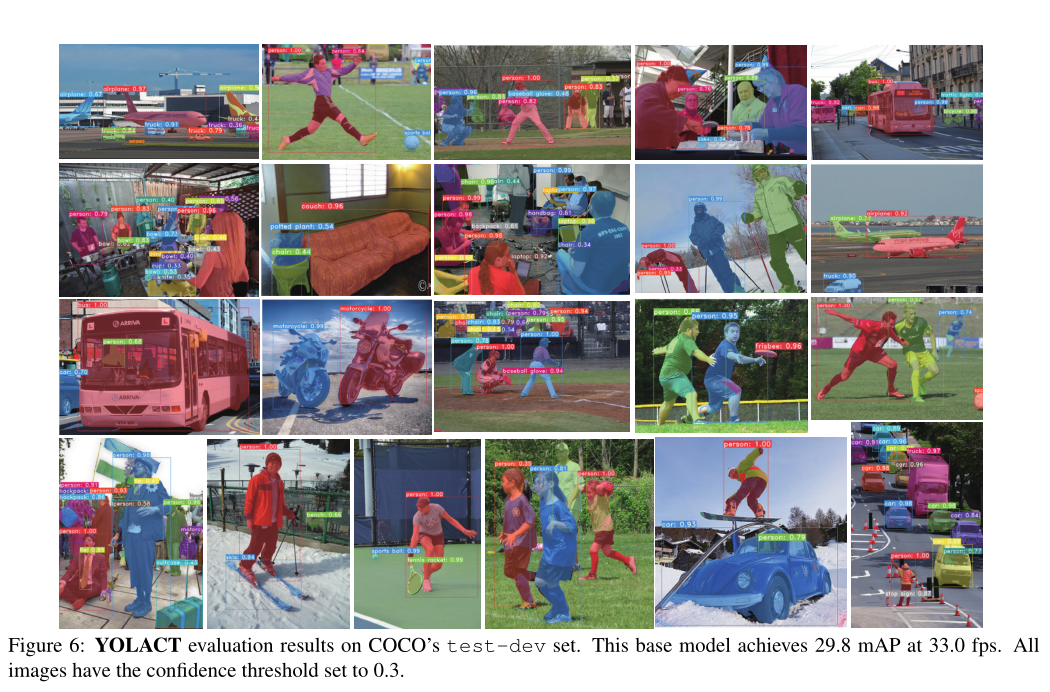

我们提出了一个简单的,全卷积的实时实例分割模型,在MS COCO上实现29.8 mAP,在单个Titan Xp上评估33.5 fps,这比任何以前的竞争方法都要快得多。而且,我们只在一个GPU上训练就得到了这个结果。为此,我们将实例分割分为两个并行子任务:(1)生成一组原型掩码和(2)预测每个实例的掩码系数。然后我们通过线性组合原型和掩码系数来产生实例掩码。我们发现,因为这个过程不依赖于重新池化,这种方法可以产生非常高质量的掩码,并免费展示时间稳定性。此外,我们分析了我们的原型的突发行为,并表明它们学会了以翻译变体的方式自己本地化实例,尽管这是全卷积的。最后,我们还提出了Fast NMS,这是一种比标准NMS快12毫秒的替代方案,它的性能损失很小。

论文创新点

- 提出一个快速的one-stage的实例分割模型

- (1)在整个图像上生成一个非局部原型掩模(non-local prototype masks)的字典(2)每个实例预测一组线性组合系数。然后,从这两个组件生成一个完整的图像实例分割很简单:对于每个实例,使用相应的预测系数线性组合原型,然后用预测的包围框进行裁剪。

- 快速因为它的并行结构和极其轻量级的组装过程,YOLACT只增加了一级骨干检测器的边际计算开销,使它很容易达到30帧/秒,即使使用ResNet-101,事实上,整个掩码分支的评估只需要约5毫秒。

- 蒙版是高质量的:因为蒙版充分利用了图像空间,而不会因为重新池化而失去任何质量,我们的大型物体的蒙版的质量明显高于其他方法。最后,它是通用的:生成原型和蒙版系数的思想可以添加到几乎任何现代物体检测器中。

- 第一个实时(> 30帧/秒)的实例分割算法,在具有挑战性的MS COCO数据集上获得了具有竞争力的结果。

- 分析了YOLACT的原型的紧急行为(emergent behavior),并提供实验来研究在不同的骨干架构、原型数量和图像分辨率下获得的速度与性能的权衡。

- 还提供了一种新颖的Fast NMS方法,比传统NMS快12毫秒,性能损失可以忽略不计。

论文链接

原文链接

代码链接

模型

第一个分支使用FCN生成一组图像大小的“原型掩码”,它们不依赖于任何一个实例。

第二种方法在对象检测分支中增加一个额外的头,用于预测每个锚点的“掩码系数”向量,这些锚点编码了原型空间中实例的表示。最后,对于在NMS下存活的每个实例,我们通过线性组合这两个分支的工作来为该实例构造一个掩码。

Rationale:以这种方式执行实例分割主要是因为遮罩在空间上是连贯的;也就是说,彼此接近的像素很可能是同一个实例的一部分,卷积(conv)层自然地利用了这种一致性,而完全连接(fc)层则没有.

文章将问题分解为两个并行的部分,利用擅长产生语义向量的FC层和擅长产生空间相干掩码的conv层,分别产生“掩码系数”和“原型掩码”。然后,因为原型和掩模系数可以独立计算,与主干检测器相比,计算开销主要来自组装步骤,可以通过单个矩阵乘法实现。这样,我们可以在保持单阶段快速的同时,在特征空间中保持空间一致性。

Prototype Generation

原型生成分支(protonet)为整个图像预测一组k个原型掩模。我们将质子网实现为FCN,它的最后一层有k个通道(每个原型一个通道),并将其附加到主干特征层。虽然这个公式类似于标准的语义分割,但它的不同之处在于我们在原型上没有表现出明显的损失。相反,对这些原型的所有监督都来自于组装后mask的最终损失。

我们注意到两个重要的设计选择:从更深的主干特征中提取质子网可以产生更健壮的掩模,更高分辨率的原型可以在更小的物体上产生更高质量的掩模和更好的性能。因此使用FPN。然后,我们将其上采样到输入图像的四分之一,以提高对小物体的性能。

最后,发现 protonet的输出无限的是很重要的,因为这允许网络产生压倒性的激活(例如,明显的背景)。因此,我们可以选择跟随具有ReLU作为激活函数

Mask Coefficients

典型的基于锚定的对象检测器在其预测头中有两个分支:一个分支预测c类置信度,另一个分支预测4个包围盒回归量。对于掩模系数预测,我们只需并行添加第三个分支来预测k个掩模系数,每个原型对应一个。因此,我们不再为每个锚产生4 + c的系数,而是产生4 + c + k。

然后对于非线性,我们发现能够从最终的遮罩中减去原型是很重要的。因此,我们对k个掩模系数应用tanh激活函数,这产生了比无非线性更稳定的输出。这种设计选择的相关性在图中很明显,因为没有减法,这两个掩码都是可构建的。

Mask Assembly

使用sigmoid非线性激活函数来产生最终遮罩。

P为原型掩码中的hwk矩阵,C为n个存货NMS和评分阈值的掩码系数的n*k矩阵。

损失函数:使用三种损失函数:分类损失Lcls,框回归损失Lbox,掩码损失Lmask。权重分别为1,1.5和6.125。Lcls和Lbox的定义方式与[Ssd: Single shot multibox detector]相同。然后,为了计算掩码损耗,我们只需取组合掩码M和地面真实掩码Mgt之间的像素级二进制交叉熵:Lmask = BCE(M, Mgt)。

Cropping Masks:在评估过程中,我们用预测的边框裁剪最后的蒙版。在训练过程中,我们用地面真值边界框进行裁剪,用Lmask除以地面真值边界框面积来保存原型中的小物体。

Emergent Behavior

在文章中,添加的唯一的平移方差是用预测的边界框裁剪最终的蒙版。然而,我们发现我们的方法在不裁剪中等和大型对象的情况下也能工作,所以这不是裁剪的结果。相反,YOLACT学习如何通过原型中的不同激活自己本地化实例。

要了解这是如何实现的,首先要注意图5中纯红色图像(图a)的原型激活在没有填充的FCN中实际上是不可能的。因为卷积的输出是单个像素,如果它在图像中的每一个地方的输入都是相同的,那么卷积输出的每一个地方的结果都是相同的。另一方面,在像ResNet这样的现代FCNs中,一致的填充边缘使网络能够分辨出一个像素距离图像边缘的距离。从概念上讲,实现这一点的一种方法是有多个层按顺序将填充的0从边缘向中心扩散(例如,使用像[1,0]这样的内核)。例如,这意味着ResNet本身就是翻译变量,我们的方法大量使用了这个属性(图像b和c显示了明显的翻译变量)

我们观察到许多原型在映像的某些“分区”上激活。也就是说,它们只会在隐式学习边界的一边激活物体。在图5中,原型1-3就是这样的例子。通过组合这些分区映射,网络可以区分同一语义类的不同(甚至重叠)实例;例如在图d中,用原型2减去原型3就可以将绿伞和红伞分开。

Backbone Detector

使用ResNet-101[19]和FPN[26]作为我们的默认特征骨干,基本图像大小为550 × 550。我们不保持长宽比,以获得一致的评估时间每幅图像。

其他改进

- Fast NMS

- Semantic Segmentation Loss

实验

数据集

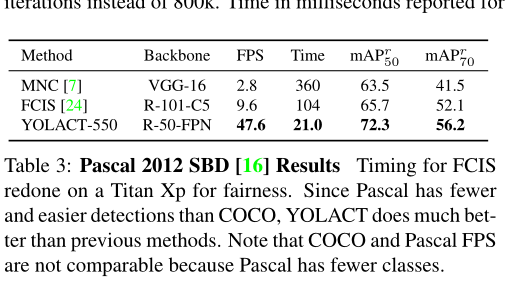

在MS COCO[28]和Pascal 2012 SBD[16]上使用标准度量的实例分割结果

对于MS COCO,我们在train2017上进行培训,在val2017上进行评估和测试开发。

具体实验

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?