本篇记录建议搭配 ONNX模型结构解析-CSDN博客 共同查阅

1.在onnx -> trt的转化过程中,会提示警告:

WARNING: onnx2trt_utils.cpp:374: Your ONNX model has been generated with INT64 weights, while TensorRT does not natively support INT64. Attempting to cast down to INT32.

![]()

解决方法:该问题无法解决,且几乎不会影响推理结果。

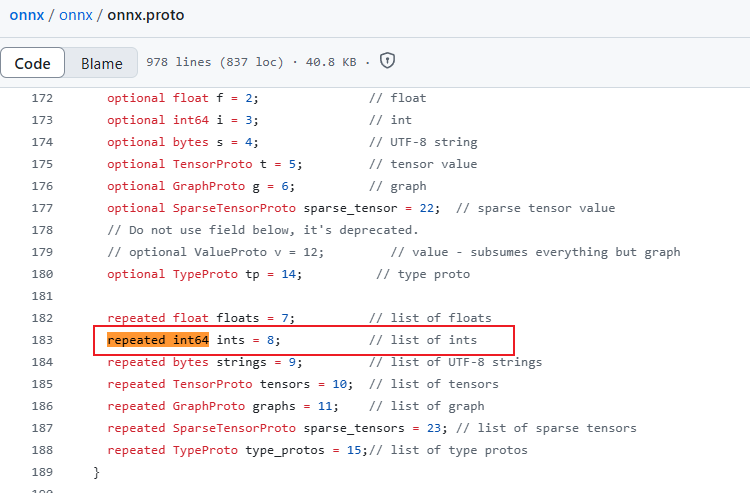

在ONNX内部结构中,可以出现int64类型的数据可能在两个地方,一个是model.graph.initializer中,内部存储一些张量权重等数据,此处若出现int64数据,是可以手动修改为int32类型的;另外一个地方是model.graph.node中的attribute数据,该类数据的类型如果是整形或者整形数组,则对应的类型为INT和INTS,默认是int64类型,因此此处无法手动修改。

而在TensorRT中,暂不支持INT64类型的数据。

2.若.onnx模型的输入或输出是int64类型,对于低版本的TensorRT,解析时可能自动转为int32类型,而高版本例如10.x,仍会保留int64的输出,因此,建议统一在生成PyTorch模型时,就把类型提前转为int32,避免后续不同版本的解析歧义。

3.更新中…

763

763

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?