Mask and Reason: Pre-Training Knowledge Graph Transformers for Complex Logical Queries

KGE缺点:由于其固有的浅层和静态架构的限制,他们很难处理日益增长的复杂逻辑查询,这些逻辑查询包括逻辑运算符,计算边缘,多个源实体和未知的中间实体。

EPFO逻辑查询

与KGE相比,它是多跳的,其面对如下两个挑战:

1,随着跳数的增加,其查询的复杂度也是呈指数级增加的。

2,现有的EPFO推理器以一个监督方式被限制在少数类型查询和有限数量的样本上直接训练,因此推理器被禁止掌握超出现有类型所能表达的各种形式和更大范围的知识,从而损害了普遍性。

kgTransformer——是一个基于Transformer的GNN——解决知识图谱上的EPFO查询。

将transformer用于知识图谱中有两个问题:

1,如何在图结构中对节点邻接进行编码。

解决方法:通常将图视为具有位置编码的标记序列,忽略领接矩阵。

2,如何建模实体和关系。

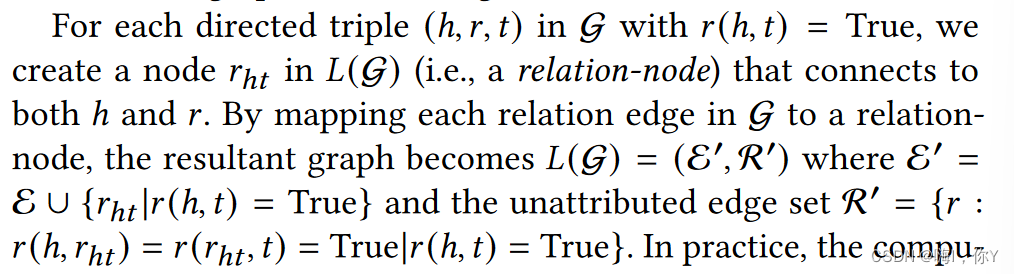

解决方法:Triple Transformer,将关系转换为关系节点,最终将知识图谱转换为没有边属性的有方向图。

该方法的具体操作如下:

本文介绍了一种名为kgTransformer的基于Transformer的GNN,旨在解决知识图谱上的复杂逻辑查询,克服KGE模型的局限。kgTransformer通过将关系转化为关系节点,并采用多专家(MOE)策略和掩码预训练方法提高性能。文章详细阐述了kgTransformer的结构和预训练、微调策略,旨在提升模型处理多跳查询和复杂逻辑的能力。

本文介绍了一种名为kgTransformer的基于Transformer的GNN,旨在解决知识图谱上的复杂逻辑查询,克服KGE模型的局限。kgTransformer通过将关系转化为关系节点,并采用多专家(MOE)策略和掩码预训练方法提高性能。文章详细阐述了kgTransformer的结构和预训练、微调策略,旨在提升模型处理多跳查询和复杂逻辑的能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3257

3257

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?