前沿科技速递🚀

Meta公司宣布开放的Llama 3.1系列模型,以其惊人的128K上下文长度、对八种语言的支持以及业界领先的405B开放式最前沿AI模型,瞬间吸引了全球科技界的目光。该系列模型不仅在通用知识、可控性、数学、工具使用和多语言翻译等方面表现出色,还通过开源的方式,为全球开发者提供了一个强大的平台,助力他们解锁新的工作流和应用场景。

来源:传神社区

Llama 3.1 405B:业界巅峰之作

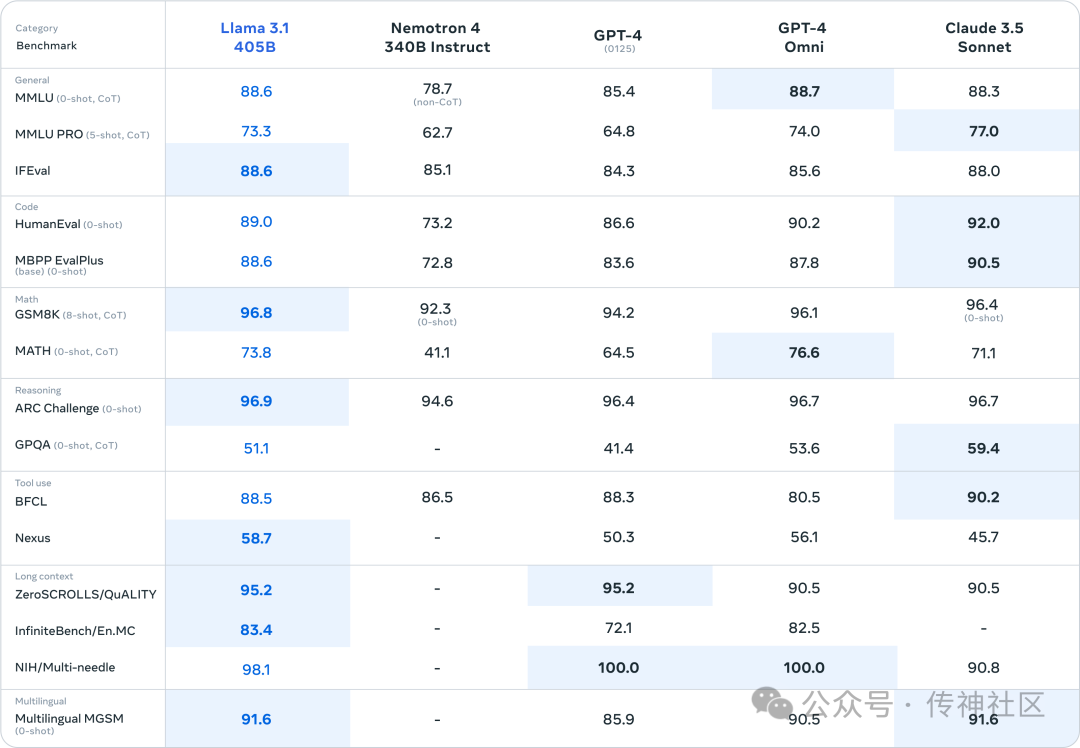

Llama 3.1 405B作为系列中的旗舰产品,以其4050亿参数的规模,成为目前参数量最大的开源模型之一。该模型在通用知识、可控性、数学、工具使用和多语言翻译等方面均展现出顶尖水平,足以与市场上最好的闭源模型如GPT-4和Claude 3.5 Sonnet相媲美。通过扩展上下文长度、增强推理能力和改进工具使用,Llama 3.1 405B能够支持高级应用如长文本摘要、多语言对话代理和编程助手,为开发者提供了无限可能。

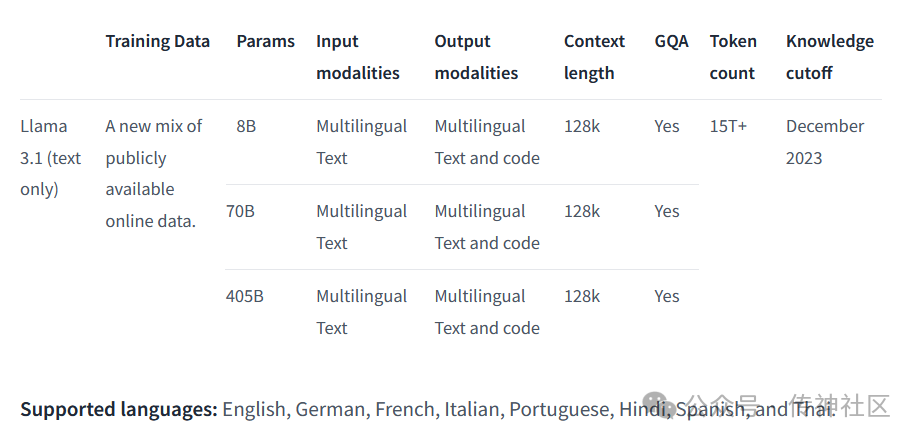

多尺寸选择和多语言支持:满足不同需求

除了405B型号外,Llama 3.1系列还提供了70B和8B两种尺寸的模型,以满足不同场景下的需求。70B型号作为高性能且性价比很高的中端模型,能在性能和成本之间取得良好平衡;而8B型号则以其轻量级和超高速的特点,几乎可以在任何设备上运行,特别适合资源受限的环境。

Llama 3.1系列模型支持英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语等多种语言,为全球用户提供了无缝的语言交流体验。这一特性使得模型在跨国企业、多语言社区以及全球化应用中具有极高的应用价值。

开源与生态系统

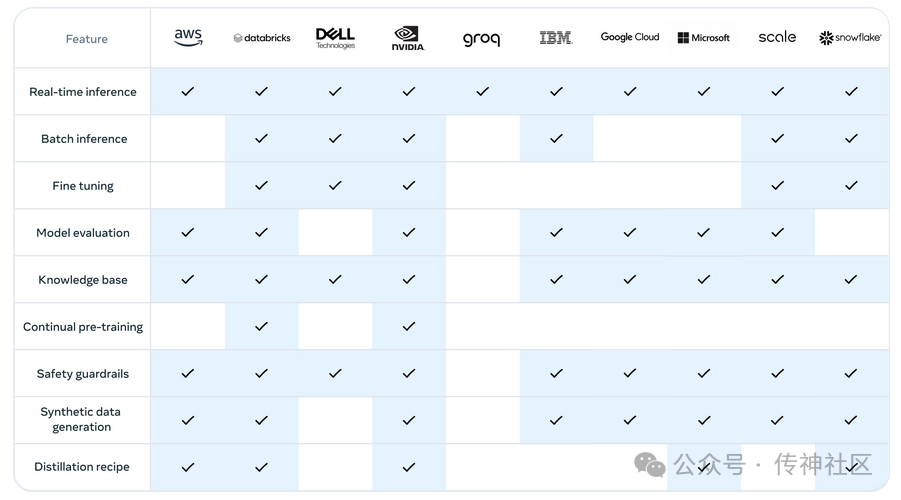

Meta公司坚持开源策略,将Llama 3.1系列模型向全球开发者开放。这一举措不仅促进了AI技术的普及和应用,还极大地推动了AI生态系统的繁荣发展。Meta还提供了与模型协同工作的多个组件和参考系统,以及全新的安全工具如Llama Guard 3和Prompt Guard,以支持开发者更加负责任地开发AI应用。除了最基本的根据提示词响应,Meta官方表示,任何普通开发者可以用它做些高级的事情,比如:

-

实时和批量推理

-

监督微调

-

针对特定应用评估模型

-

持续预训练

-

检索增强生成 (RAG)

-

函数调用

-

合成数据生成

而这背后也是由它的强大生态伙伴支持。在Llama 3.1发布之际,Meta已经与亚马逊AWS、NVIDIA英伟达、Databricks、Groq、戴尔、微软Azure、谷歌云和Snowflake等25多家合作伙伴建立了合作关系。这些合作伙伴将提供相关的服务和工具,以支持开发者在更广泛的生态系统中开发和部署Llama 3.1模型。

llama3.1快速体验下载

传神社区:

llama-3.1-8B版本:

-

https://opencsg.com/models/AIWizards/Meta-Llama-3.1-8B-Instruct

-

llama-3.1-70B和llama-3.1-405B版本持续更新中~

可以先通过磁力链接下载405B版本:Magnet: magnet:?xt=urn:btih:c0e342ae5677582f92c52d8019cc32e1f86f1d83&dn=miqu-2&tr=udp%3A%2F%http://2Ftracker.openbittorrent.com%3A80

huggingface:

-

https://huggingface.co/meta-llama

欢迎加入传神社区

•贡献代码,与我们一同共建更好的OpenCSG

•Github主页

欢迎🌟:https://github.com/OpenCSGs

•Huggingface主页

欢迎下载:https://huggingface.co/opencsg

•加入我们的用户交流群,分享经验

扫描上方二维码添加传神小助手

“ 关于OpenCSG

开放传神(OpenCSG)成立于2023年,是一家致力于大模型生态社区建设,汇集人工智能行业上下游企业链共同为大模型在垂直行业的应用提供解决方案和工具平台的公司。

关注OpenCSG

加入传神社区

1163

1163

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?