LightGlue:Local Feature Matching at Light Speed

作者:Philipp Lindenberger; Paul-Edouard Sarlin(superglue一作); Marc Pollefeys

论文链接:LightGlue: Local Feature Matching at Light Speed | IEEE Conference Publication | IEEE Xplore

代码:cvg/LightGlue: LightGlue: Local Feature Matching at Light Speed (ICCV 2023) (github.com)

1.Introduction

背景:寻找两张图片的对应关系是许多视觉任务的基石,例如相机跟踪和 3D 映射;

现有方法存问题:

1.在由于不同的视角和光照而表现出对称性、弱纹理或外观变化的条件下,可靠地描述每个点是具有挑战性的。

2.为了拒绝由于遮挡和缺失点而产生的异常值,这种表示也应该是有区别的。

3.这产生了两个相互冲突的目标,即稳健性和独特性,并且很难满足。

4.superglue解决了一些问题,但它是基于transformer的,很难训练。

本文贡献:

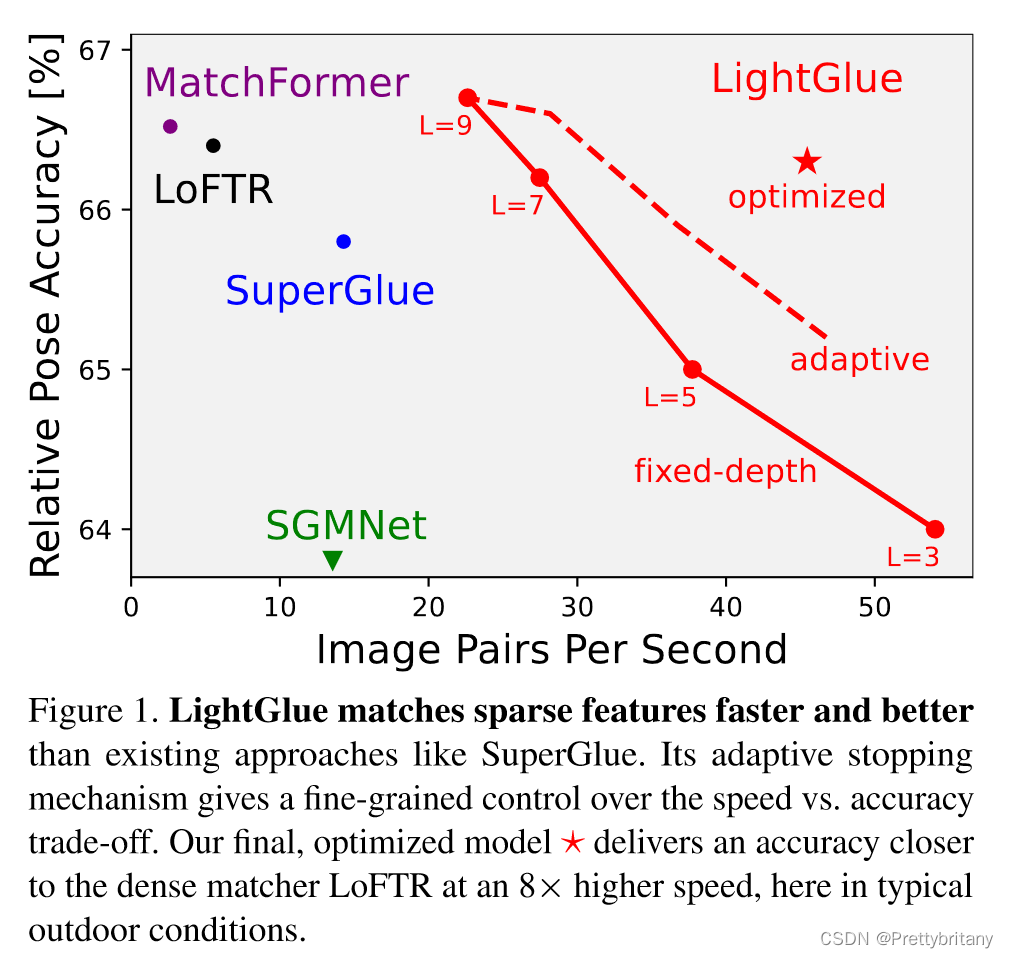

提出lightglue,比起superglue,需要更少的内存、更少的计算资源、更加准确、更容易训练。

实验表明,LightGlue 是 SuperGlue 的即插即用替代品:它可以在运行时间的一小部分内预测两组局部特征的强匹配。

这为在 SLAM 等延迟敏感的应用程序中部署深度匹配器或从众包数据重建更大的场景开辟了令人兴奋的前景。

特点:

1)在每个计算块之后预测一组对应关系,2)使模型能够反思它们并预测是否需要进一步的计算。

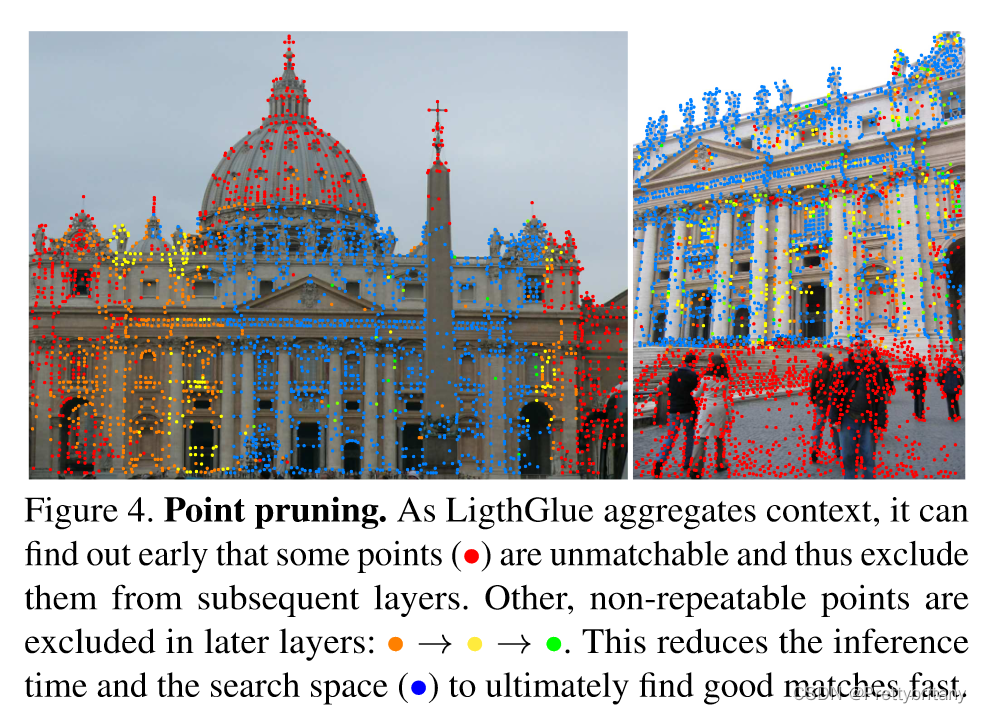

在早期阶段丢掉不可匹配的点,将注意力放在可匹配的区域。

3.Fast feature matching

Problem formulation

Overview

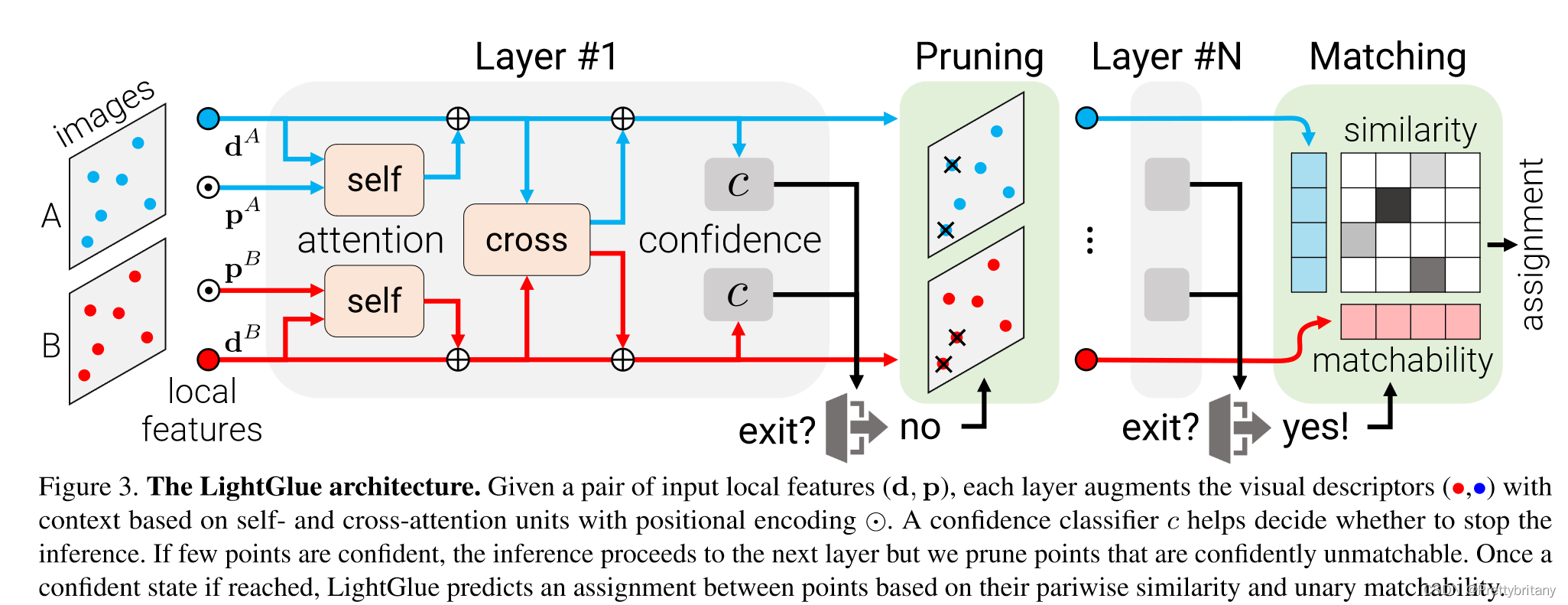

3.1.Transformer backbone

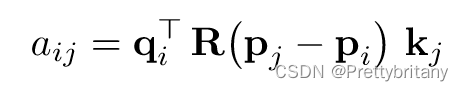

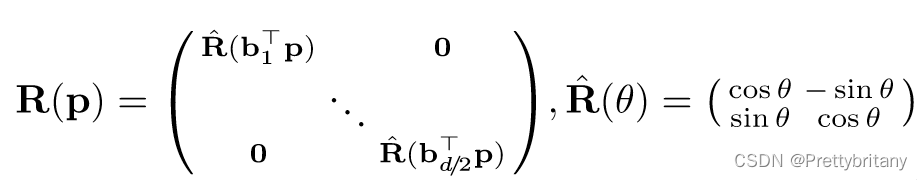

self-attention

每个点关注同一图像的所有点,自注意力中加入相对位置编码。

cross-attention

图像I中的每个点关注其他图像S中的所有点。由于相对位置在不同图像中没有意义,所以没有加入位置编码。

3.2.Correspondence prediction

我们设计了一个轻量级的头,可以根据任意层的更新状态来预测分配。

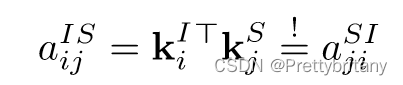

Assignment scores

计算图像间的得分矩阵:

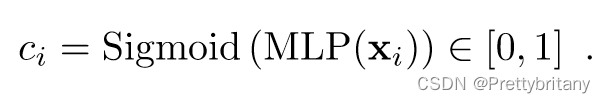

计算每个点的匹配性得分:

![]()

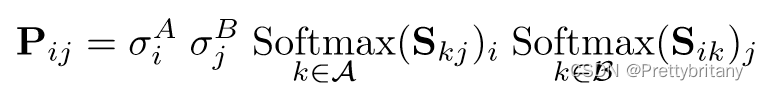

Correspondences

软分配矩阵:

当一对点 (i, j) 被预测为可匹配并且它们的相似度高于两个图像中的任何其他点时,这两个点就会产生对应关系。我们选择 Pij 大于阈值 τ 且大于行和列上任何其他元素的对。

3.3.Adaptive depth and width

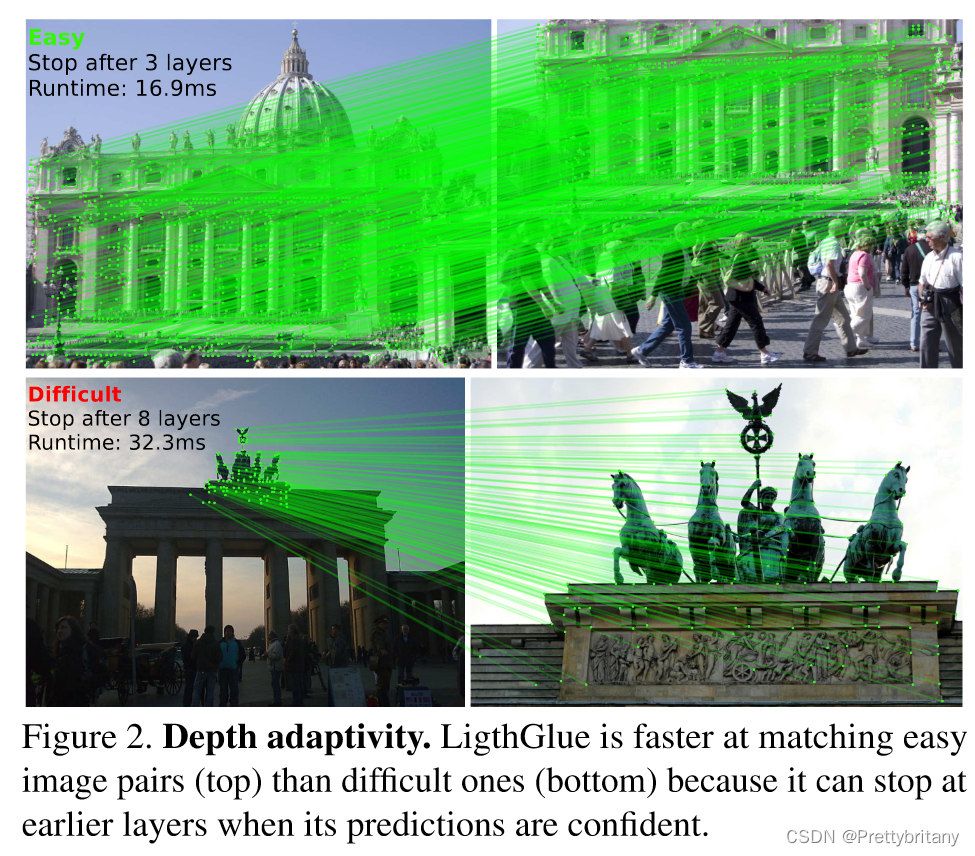

我们添加了两种机制来避免不必要的计算并节省推理时间:i)我们根据输入图像对的难度减少层数; ii) 我们剪掉那些早早被置信度拒绝的点。

Confidence classifier

LightGlue 的主干通过上下文增强输入视觉描述符。如果图像对很简单,即具有较高的视觉重叠度和很少的外观变化,那么这些通常是可靠的。在这种情况下,早期层的预测是可信的,并且与后期层的预测相同。然后我们可以输出这些预测并停止推理。在每层的末尾,LightGlue 推断每个点的预测分配的置信度:

较高的值表明 i 的表征是可靠且最终的——它可以自信地匹配或不匹配。这是受到许多成功地将这种策略应用于语言和视觉任务的作品的启发 [62,20,71,80,40]。在最坏的情况下,紧凑的 MLP 仅增加 2% 的推理时间,但通常可以节省更多。

Exit criterion

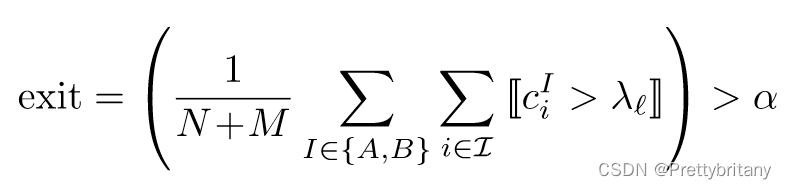

对于给定的层 l,如果 ci > λl,则认为点是可信的。如果满足置信度阈值的点达到了足够比例α,我们停止推断:

正如[62]中所示,我们观察到分类器本身对早期层的信心较低。因此,我们根据每个分类器的验证准确性在整个层中衰减 λl。阈值α直接控制准确性和推理时间之间的权衡。

Point pruning

当不满足退出标准时,被预测为置信且不可匹配的点不太可能帮助后续层中其他点的匹配。例如,这些点位于图像中明显不可见的区域中。因此,我们在每一层丢弃它们,只将剩余的点提供给下一层。考虑到注意力的二次复杂度,这显着减少了计算量,并且不影响准确性。

3.4.Supervision

分两个阶段训练LightGlue:首先训练它来预测对应关系,然后才训练置信度分类器。因此,后者不会影响最终层的准确性或训练的收敛性。

监督具有从两个视图变换估计的用真值标注的分配矩阵P。给定单应性或像素深度和相对姿态,将点从图像A wrap到B,反之亦然。

真值匹配M是在两个图像中具有低重投影误差和一致深度的点对。当一些点A和B的重投影或深度误差与所有其他点足够大时,它们被标记为不可匹配。然后最小化在每一层预测的分配的对数似然性ℓ, 推动LightGlue尽早预测正确的对应关系:

然后训练MLP来预测每一层的预测是否与最后一层相同,最小化层的分类器的二进制交叉熵.

3.5.Comparison with SuperGlue

LightGlue 受到 SuperGlue 的启发,但在准确性、效率和易于训练的关键方面有所不同。

位置编码:SuperGlue用MLP对绝对点位置进行编码,并在网络靠前的层将其与描述子融合,作者观察到这样做的话模型在层间传递时会忘记位置信息。而LightGlue依赖于一种相对编码,这种编码在图像之间更具可比性,并添加到每个自注意力单元中,这样可以更容易地利用位置,并提高更深层次的精度。

预测头:SuperGlue通过使用Sinkhorn算法解决可微最优传输问题来预测匹配,包括行和列归一化的多次迭代,这在计算和内存方面都很昂贵,SuperGlue还添加了一个dustbin来拒绝无法匹配的点,作者发现dustbin纠缠了所有点的相似性得分,从而产生了次优的训练,而LightGlue将相似性和可匹配性解耦,这两个问题的预测效率要高得多,产生了更清洁的梯度。

训练监督:由于Sinkhorn的价格昂贵,SuperGlue无法在每层之后进行预测,只能在最后一层进行监督,LightGlue较轻的head使其能够预测每一层的分配并对其进行监督,这加快了收敛速度,并使其能够在任何层退出推理,这是LightGlue提高效率的关键。

总结

介绍了一种用于特征匹配的深度神经网络LightGlue。在SuperGlue成功的基础上,将注意力机制的力量与关于匹配问题的见解以及Transformer最近的创新相结合,赋予这个模型反思其自身预测可信度的能力,使计算量适应每个图像对的难度。LightGlue比之前表现最好的SuperGlue更快、更准确、更容易训练!

4497

4497

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?