论文题目: Dropout: A Simple Way to Prevent Neural Networks from

Overfitting

(1)过拟合问题:

具有大量参数的深度神经网络是非常强大的机器学习系统。然而,在这样的网络中,过度拟合是一个严重的问题。

包含多个非线性隐含层的深层神经网络,具有非常强大的表现力型,能够学习输入和输出之间非常复杂的关系。然而,在训练数据有限的情况下,许多学到的复杂关系包括了数据中的噪音信息,即神经网络将噪音的信息也学习出来了。

目前有许多减少过拟合的方法,比如:利用验证集的表现来尽快停止对模型的训练,当在验证集上的正确率下降时,提前终止模型的训练;引入权重的惩罚项(L1范式和L2范式);软权重共享。

(2)模型组合:

在无限的计算力的条件下,提高预测正确率的最简单最好的方法就是使用训练集训练大量的不同的模型,然后在测试时,取他们的平均值来作为最后的结果(即模型组合)。然而这是非常耗时和消耗计算资源的。

我们希望用更少的计算来接近贝叶斯黄金标准的性能。dropout是解决这两个问题的一种技术。 它不仅防止了过度拟合,并提供了一种有效地以指数级方式组合许多不同的神经网络体系结构的方法。

Dropout:

dropout是指: 在训练模型时,神经网络随机(以一定概率)的丢弃一些神经元。

丢弃一个神经元,意味着在神经网络中“临时”的将其和与其相连的全部输入和输出链接删除。最简单的情况就是:每一个神经元以一个固定的独立的概率P保留(1-P的概率被丢弃)。如下图所示:

在测试阶段dropout到底是如何进行的?

将模型训练好后,在进行测试时,我们不再使用dropout丢弃神经元,而是将每个权重值乘上保留概率P, ,表示他们对最后的预测结果的平均贡献,以达到与在训练时使用dropout相同的效果。

,表示他们对最后的预测结果的平均贡献,以达到与在训练时使用dropout相同的效果。

将dropout应用到神经网络中,相当于从神经网络中采样一个“细”网络。这个细网络由那些在使用dropout后保留下来的神经元组成。由于每个神经元有一定的概率被丢弃或保留,所以一个拥有n个神经元节点的网络,通过dropout后可能产生 2^n 个细网络。并且,这些细网络都共享权重,因此参数的总数仍然是 O(n^2) 或更少。

在训练过程中,每一个样例都在一个新的采样得到的“细网络”中进行训练和表示,所以训练一个使用dropout的神经网络,相当于在训练一个共享权重的2^n个细网络的网络集合,并且每一个细网络被训练的次数都很少。

在使用dropout时,神经网络中的每个隐藏单元必须学会与随机选择的其他单元样本一起工作。这将使每个隐藏单元更加健壮,并推动它自己创建有用的特性,而不需要依赖其他隐藏单元来纠正错误。

减少神经元之间的依赖。

比如在一次期末考试中,4个人为一个小组。

(1)若最后考核的方式是:取4个人的平均值为最后每个人的分数,平均值>60则通过。那么在这种情况下就有了很强的依赖关系,对于某一小组成员,他可以不进行复习,考试可以随便考,只需要其余3个人考的很好就可以了。他相当于是无用的。

(2)若最后考核的方式是:老师随机从他们中选取一个人去考试,这个人的考试分数就是他们所有人的分数。那么为了考核通过,他们中每一人都需要去好好复习,不能去依赖别人。

这样就是的他们每一个人的作用最大化,没有无用的人浪费资源。

dropout可以解释为一种通过在神经网络的隐藏单元中加入噪声来实现神经网络正则化的方法。丢弃20%的输入单元和50%的隐藏单元通常是最理想的。

Dropout网络模型:

假设一个神经网络拥有L个隐藏层,标号 ,

, 表示第l层的输入向量,

表示第l层的输入向量, 表示第l层的输出向量,那么

表示第l层的输出向量,那么 表示输入X,

表示输入X, 表示第l层的权重矩阵和偏差值,

表示第l层的权重矩阵和偏差值,

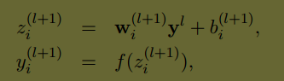

那么对于普通的神经网络模型的前反馈操作满足(i表示该层的第i个神经单元):

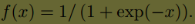

其中f表示任意的激活函数,例如

使用dropout的网络模型的前反馈操作为:

在每一层中, 是一个满足伯努利分布的向量,其中每个变量为1的概率为P,

是一个满足伯努利分布的向量,其中每个变量为1的概率为P, 产生细网络中的输出

产生细网络中的输出 ,这个输出将作为下一层的输入。使用dropout相当于对原网络进行了将采样得到一个细的子网络,在反向传播算法进行学习时,依然是在这个子网络中进行反向传播。

,这个输出将作为下一层的输入。使用dropout相当于对原网络进行了将采样得到一个细的子网络,在反向传播算法进行学习时,依然是在这个子网络中进行反向传播。

在dropout网络中使用随机梯度下降法进行训练时,除了使用dropout,使用学习率下降、高动量和max-norm正则化方法依然可以进一步提高模型的正确率。

Max-norm: 将每个隐藏单元的传入权向量的范数值限制为一个以固定常数c为上界的值,即满足 。当权向量w的范数值大于c时,将w投影到一个以c为半径的球面上。

。当权向量w的范数值大于c时,将w投影到一个以c为半径的球面上。

Dropout是一个通用的正则化技术。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?