笔记整理:金龙,浙江大学硕士,研究方向为知识图谱表示学习

论文链接:https://arxiv.org/abs/2311.09149

发表会议:ACL2024

1. 动机

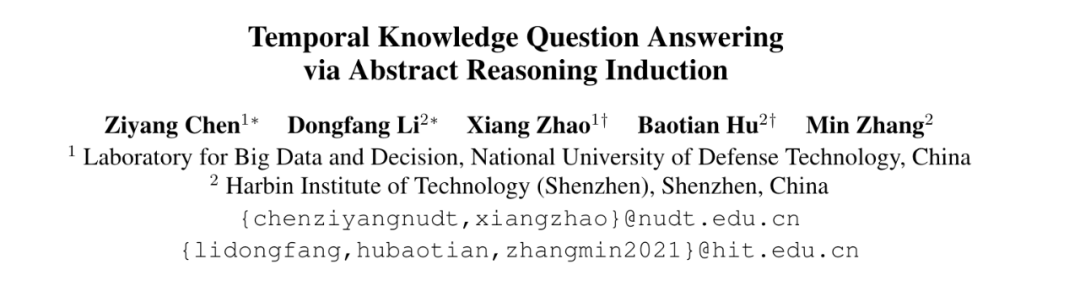

尽管大语言模型在解决通用任务下表现出强大的能力,但在时间知识图谱问答下的效果表现欠佳,原因可以归结为以下两点:(1)缺乏时间相关的知识。2)缺乏复杂的时间推理能力。现有的方法如RAG虽然可以引入时间相关知识,但检索精度和输入长度限制可能会导致不相关的噪音和不完整的推理;通过定制例子可以指导大模型生成更准确的推理,但不能满足不同的实际任务,并且需要大量的时间和人力来获取高质量的例子。因此作者提出摘要推理归纳(ARI)框架增强实用性。

2. 方法

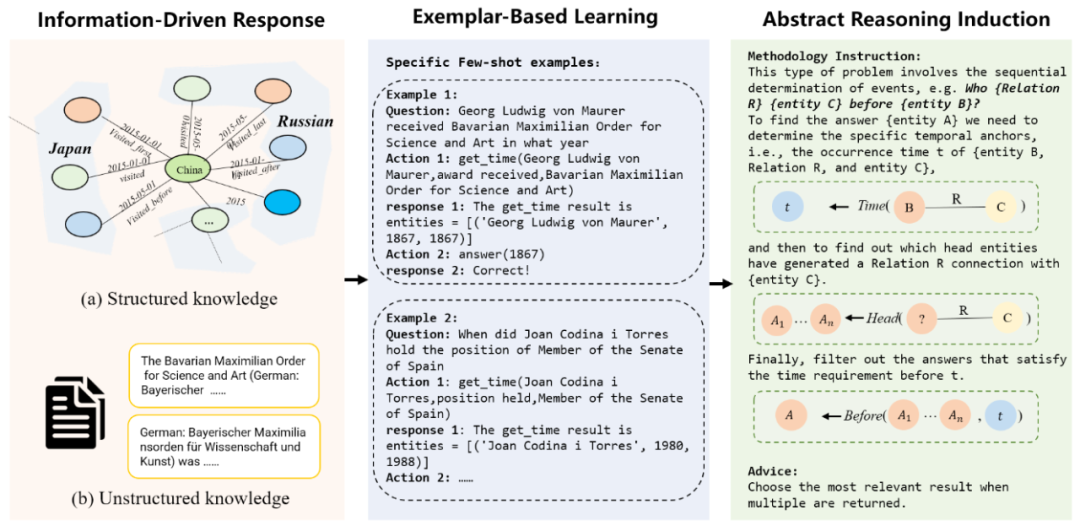

将时间知识推理分为两部分:基于知识的模块和知识不可知的模块。

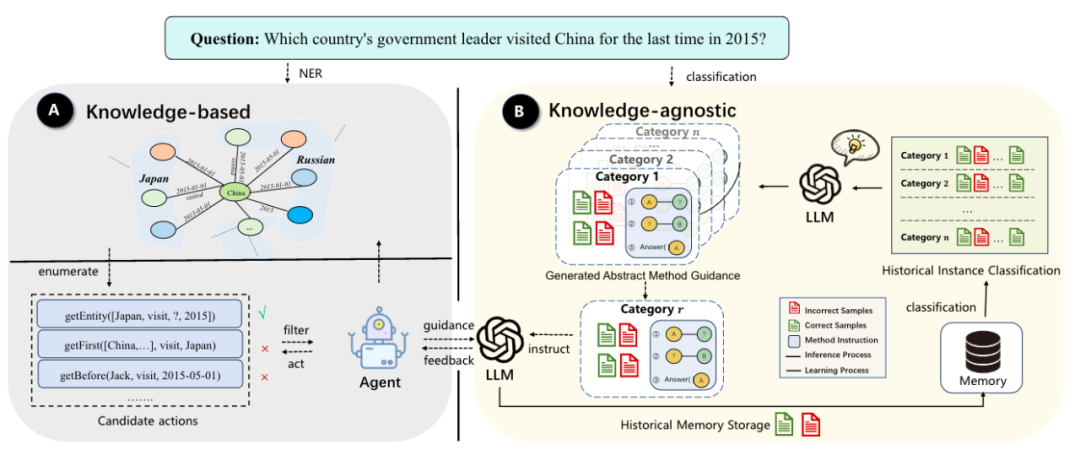

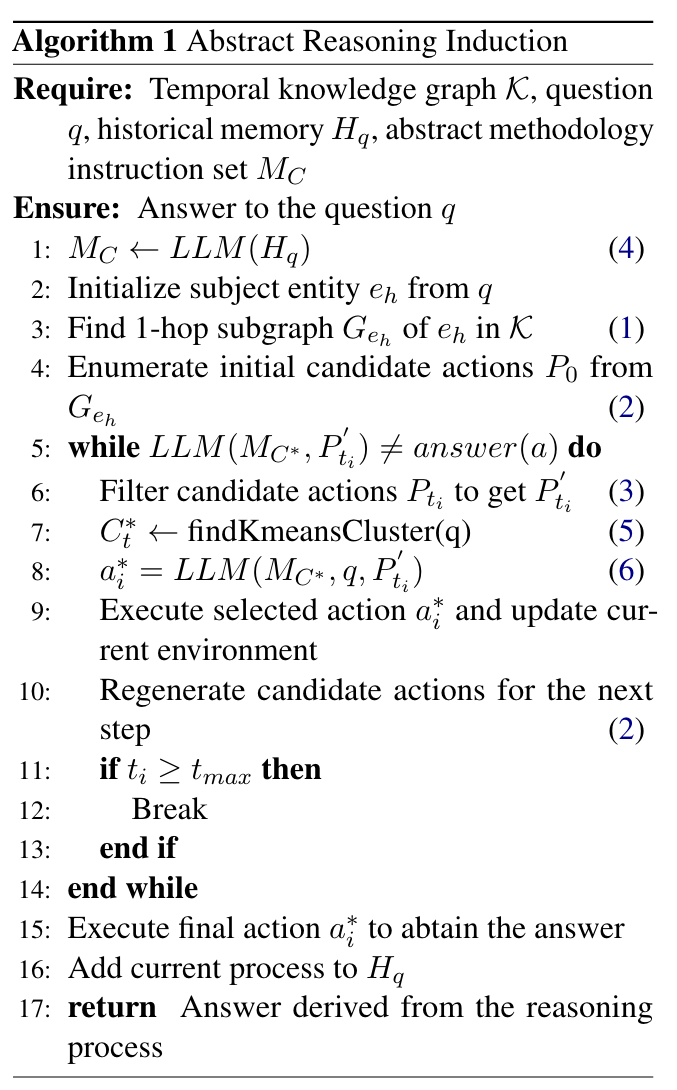

基于知识的模块根据给定的问题提取相关的TKG子图,通过遍历生成所有可行的细粒度动作。该模块首先通过目标实体挖掘出时间知识图谱的一跳子图,并按照以下动作模版构造下一步的动作,并过滤执行结果为空的动作,将过滤后的动作提供agent选择,并执行agent选择的动作。

知识无关的模块使大模型能够从历史推理示例中提取和应用摘要方法,从而能够适应不同的问题。在解决新的推理挑战时,通过选择与新问题最接近的历史推理簇来提示该过程。然后,提取其生成的摘要方法来指导大模型对当前问题的推理。并在每次迭代中维护历史推理簇。

ARI的代码流程如下:

3. 实验

实验设定:

使用 gpt-3.5-turbo-0613 作为基座。使用LLM构建200个历史推理样本的语料库,推理路径的最大长度设置为5,历史路径类别的数量固定为10。由于测试集规模庞大,其中包括对于超过 50,000 个问答对,作者采用分层抽样方法进行评估,从每次迭代的测试集中提取 200 个问题的子集。

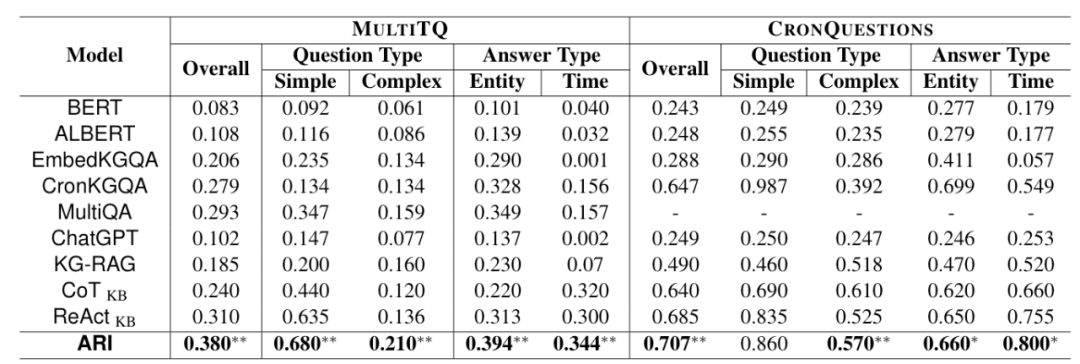

实验结果:

ARI 显著优于当前最先进的 TKGQA 模型,在 MULTITQ 数据集上实现了 29.7% 的相对改进,在 CRONQUESTIONS 数据集上的性能提高了 9.27%。这些实质性的提升可以归因于知识适应性和摘要方法论指导机制,使大模型能够做出先进的决策。通过利用摘要方法,大模型可以选择最佳的时间推理步骤,而无需涉及底层知识的具体细节。

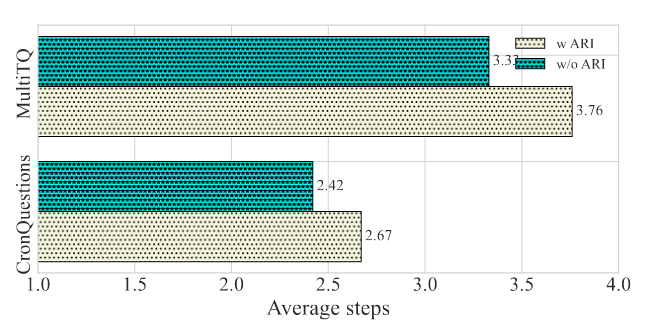

为了验证摘要教学的有效性,作者对推理效率进行了评估。在测试集上,在模型的所有其他组件保持不变的情况下,作者删除摘要指令并记录推理所采取的平均步骤数。与 ARI 相比,在摘要方法论的指导下,LLM 不仅推理精度有所提高,而且在 MULTITQ 上平均推理步骤数减少了 11.4%,在 CRONQUESTIONS 上减少了 9.3%。这强调了摘要方法提供的指导可以显著提高大模型在时间推理任务中的效率。

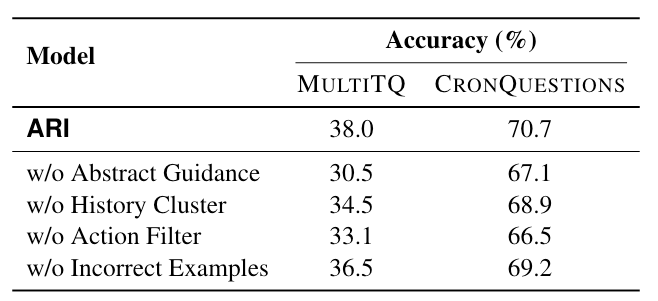

消融实验:

为了评估模型各个组成部分的功效,作者进行了消融研究。最初,作者删除了摘要指导部分,要求大模型依靠自己对问题的理解,而不需要历史信息的帮助。这导致两个数据集的性能下降,MULTITQ 下降了 19.7%,CRONQUESTIONS 下降了 3.7%。这表明精炼的摘要指导在支持模型的推理能力方面发挥着重要作用。

4. 总结

这项研究以建构主义原则为基础,批判性地审视了大模型在解决复杂的时间推理挑战方面的缺点,并提出了一种创新方法来增强其推理能力。通过知识适应性框架和摘要方法论指导的整合,作者表明大模型可以在复杂的时间场景中获得更精确和高效的推理,有效克服其在处理和解释时间敏感知识方面的限制。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。

2139

2139

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?