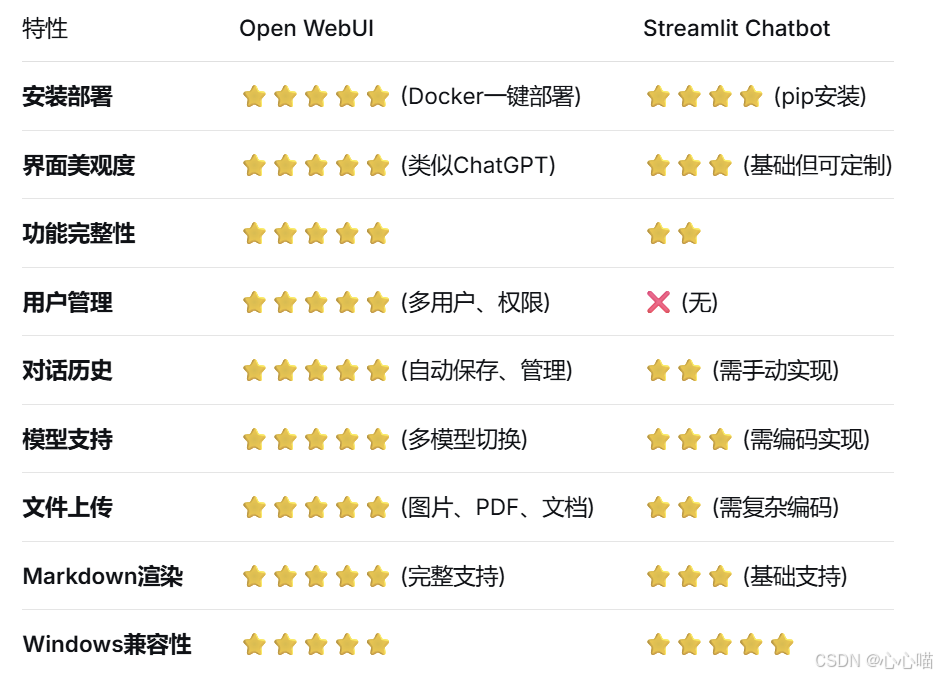

在Windows环境下构建DeepSeek R1的网页聊天界面,Open WebUI明显是更好的选择。以下是详细对比分析:

-

安装Docker Desktop

powershell

# 验证Docker安装 docker --version docker-compose --version

-

确保Ollama服务运行

powershell

# 检查Ollama状态 ollama list ollama serve

Open WebUI部署方案

方案一:基础Docker部署

powershell

# 在PowerShell中以管理员身份运行 docker run -d ` --name open-webui ` -p 3000:8080 ` -e OLLAMA_API_BASE_URL=http://host.docker.internal:11434 ` -e OLLAMA_WATCH_TIMEOUT=120 ` -v open-webui-data:/app/backend/data ` --rest

订阅专栏 解锁全文

订阅专栏 解锁全文

2383

2383

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?