文章目录

0 前言

总目录 大模型安全相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

论文阅读:ICLR 2025 AutoDAN-Turbo: A Lifelong Agent for Strategy Self-Exploration to Jailbreak LLMs

https://arxiv.org/pdf/2410.05295

https://github.com/SaFoLab-WISC/AutoDAN-Turbo

平台采用Autodl:https://www.autodl.com/home

PyTorch / 2.3.0 / 3.12(ubuntu22.04) / 12.1

b站视频:https://www.bilibili.com/video/BV1q8j1z7EV5/

1 模型下载

使用SDK下载下载:

开始前安装

source /etc/network_turbo

pip install modelscope

脚本下载

# source /etc/network_turbo

from modelscope import snapshot_download

# 指定模型的下载路径

cache_dir = '/root/autodl-tmp'

# 调用 snapshot_download 函数下载模型

# Qwen系列

model_dir = snapshot_download('Qwen/Qwen3-0.6B', cache_dir=cache_dir)

# model_dir = snapshot_download('Qwen/Qwen3-1.7B', cache_dir=cache_dir)

# model_dir = snapshot_download('Qwen/Qwen3-4B', cache_dir=cache_dir)

# model_dir = snapshot_download('Qwen/Qwen3-8B', cache_dir=cache_dir)

# DeepSeek-R1-Distill系列

# model_dir = snapshot_download('deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B', cache_dir=cache_dir)

# model_dir = snapshot_download('deepseek-ai/DeepSeek-R1-Distill-Qwen-7B', cache_dir=cache_dir)

# model_dir = snapshot_download('deepseek-ai/DeepSeek-R1-Distill-Llama-8B', cache_dir=cache_dir)

# Phi-4

# model_dir = snapshot_download('LLM-Research/Phi-4-mini-reasoning', cache_dir=cache_dir)

# QWQ 太大了

# model_dir = snapshot_download('Qwen/QwQ-32B', cache_dir=cache_dir)

print(f"模型已下载到: {model_dir}")

2 AutoDAN-Turbo 安装

由于 AutoDAN-Turbo需要用到openai_api、openai embedding、huggingface api,

这些都是国内不方便直接使用的,我就没有openai的api,

所以,这些东西都需要替换为中国国内的产品。

另外AutoDAN-Turbo写的花里胡哨的,感觉实在卖弄代码技巧,很多地方换个环境跑就不兼容了,导致我需要把这些花里胡哨的东西拆掉,以修改代码达到兼容。

经过三四天的修改,https://github.com/Whiffe/AutoDAN-Turbo-C

这就是修正后的,可以使用国内产品的AutoDAN-Turbo

具体修改的地方,我放在最后一章。

source /etc/network_turbo

pip install transformers==4.51.3

测试:

python -c "import transformers; print(transformers.__version__)"

python -c "from transformers import AutoModelForCausalLM, AutoTokenizer; AutoModelForCausalLM.from_pretrained('/root/autodl-tmp/Qwen/Qwen3-0.6B/')"

pip install faiss-cpu

pip install openai

pip install llama-index-core

pip install llama-index-embeddings-dashscope

pip install llama-index-readers-file

pip install docx2txt

source /etc/network_turbo

git clone https://github.com/Whiffe/AutoDAN-Turbo-C.git

cd AutoDAN-Turbo-C

这里不要用下面的指令,问题挺大的,

pip install -r requirements.txt

我也把requirements.txt删掉了

下面是运行结果

3 AutoDAN-Turbo修改的地方

requirements.txt

删掉了

main_r.py

pipeline.py

llm/deepseek_models.py

llm/huggingface_models.py

llm/qwen_embedding_models.py

整个都是新增的

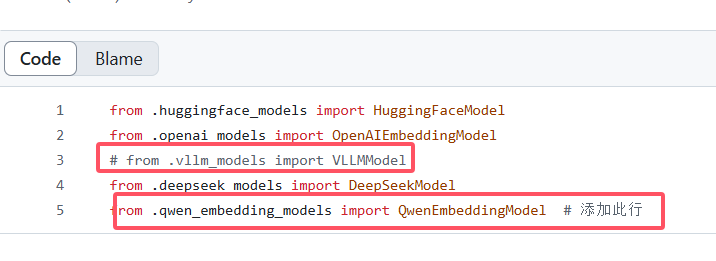

llm/init.py

684

684

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?