大家新年好!这几天都忙着串门,拜年,都没时间更新文章了。今天稍有闲暇,准备着写点什么。打开手机,刷刷某音,某号,某书等看看,不约而同的都是各种Deepseek的相关推荐,而更多的都是一些“教Deepseek本地部署”的各种视频,有些甚至高达一百多万播放量。看来春节期间科技圈Deepseek的热度飙升,引得许多人跟风尝试起来了。

然而,我却要来给大家刹刹车,降降温,其实本地部署 Deepseek 并非明智之举,下面我将从以下五个方面进行分析……

一、硬件门槛高

对于最低的Deepseek-1.5B 模型至少需要 8GB 显存,对于 90% 的普通笔记本来说难以满足。以配备 RTX 3060(12G 显存得1500元以上吧)的电脑为例,加载模型就会占用 10.3G 显存,使用过程中稍多开几个程序就可能导致显存爆满。对于一般的笔记本若想流畅运行,多数需升级到 16G 显存(而此类笔记本价格得超万元吧)。并且实际运行时,本地生成一段 100 字的文案可能需要 3 分钟,远不及云端的 3 秒响应速度。

对于7B模型,8B模型和其它更高级别的模型更不用说了,一句话说白了还是得“花钱”!(PS:对应的显卡价格自己通过Deepseek去查一下)

二、安全隐患突出

其实我想很多人是自以为本地部署使用Deepseek更私密更安全。可是我要说的是错误配置端口这一疏忽,很可能会给黑客可乘之机,他们利用端口漏洞,短短几秒钟内便能成功攻破系统。一旦系统被攻破,用户在使用过程中的聊天记录将毫无保留地暴露在黑客眼前,本地存储的各类文件,无论是工作文档、个人照片还是私密视频等,也都面临着被窃取、曝光的风险。不可否认,你们在平台上看到的哪些教程是不是足够专业,你自己又是否足够专业(我想大部分人应该都是一知半解的跟风吧),哪些链接是否植入有木马病毒犹未可知,本身AI就是一个全新的网络产物,建议在非专业的指导下还是不要轻易本地部署了。

从非官方渠道下载的模型,由于缺乏有效的安全监管与审核机制,极有可能被不法分子植入恶意代码。这些恶意代码一旦被激活,就可能导致系统瘫痪、数据丢失,甚至会让用户的电脑成为黑客进行网络攻击的 “肉鸡”。不仅如此,长期让硬件高负荷运行,会对硬件造成极大的不可逆转的损伤。以显卡为例,在持续高负荷的工作状态下,显卡的寿命会缩短 60%。而当显卡出现故障需要维修时,维修费用往往十分高昂,这无疑是一笔额外的、令人头疼的开支。

三、部署的并非完整的模型

就目前的情况而言,在各大网站上,那些关于通过 ollama 来完成本地部署的教学视频相当流行。进一步观察可以发现,在 ollama 网站上的 deepseek 模型,从本质上来说属于蒸馏模型。这个模型与官网的版本存在一定的差异。虽然它经过了独特的微调训练,但是其中却暗藏着诸多复杂性。对于刚接触的小白,本地部署从模型原理理解到实际操作,都充满挑战,极易陷入困境(PS:没有这个金刚钻就不要揽这个瓷器活)。而官网版本使用简便,且能满足大部分基础需求。权衡之下,本地部署deepseek在操作便捷性、使用适配性上难占上风。

四、部署过程困难重重

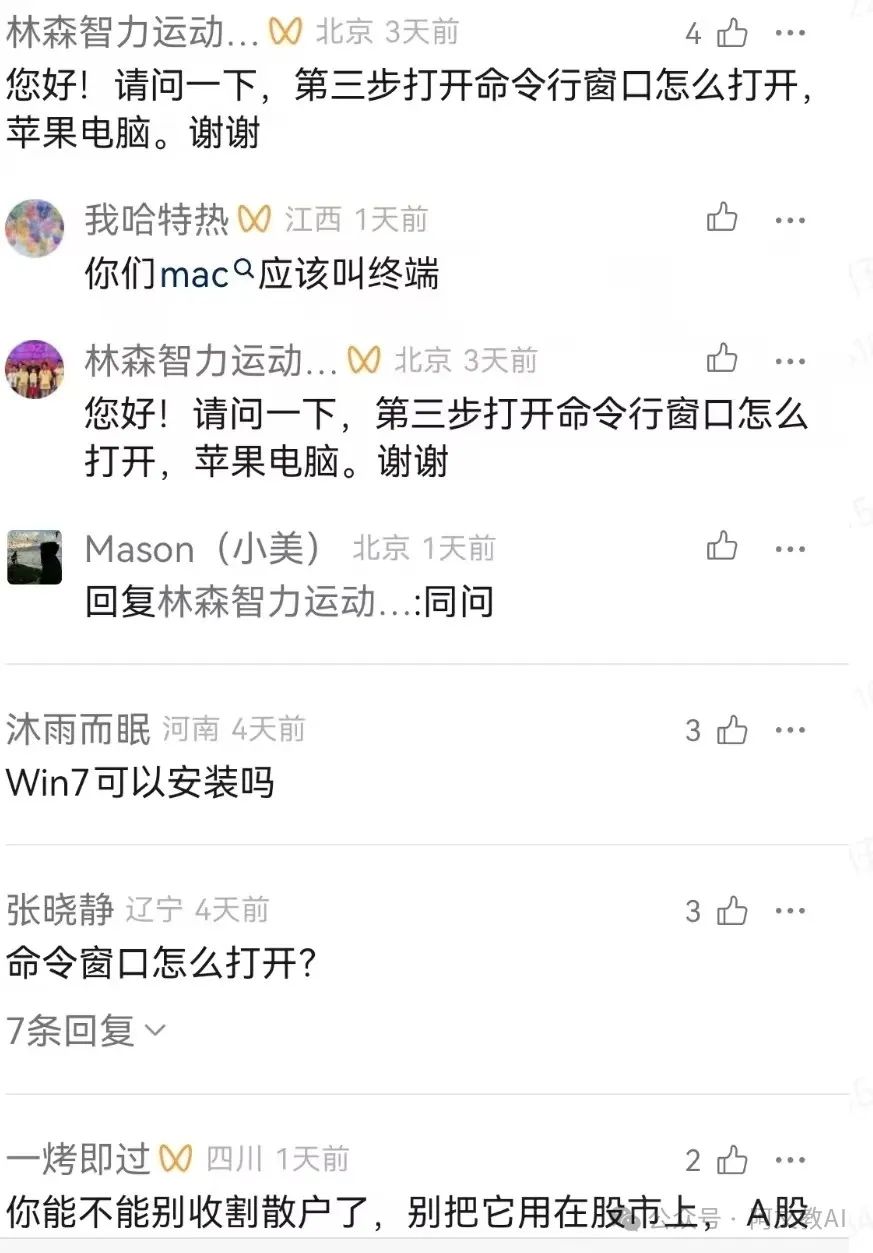

尽管各大平台上有很多“本地部署Deepseek”的保姆级教程,但是绝大多数应该都是“标题党”,普通人在部署时还是会遇到诸多问题。哪些所谓“一分钟教会……”和“几步教会:”的都是为了吸引眼球,我相信绝大多数人要完成本地部署Deepseek并不是那么容易(Ps:你们可以把各自完成部署的时间打在评论区都对比看看),整个过程不说全是英文了,就是按照保姆级教程来操作,你都未必容易吧。比如下面——GitHub无法访问,就卡在了第一步……

五、能耗大

本地部署 Deepseek 的功耗相对较高。在待机状态下,每小时的功耗约为 150W,若持续进行对话交互,每小时功耗则会提升至 300W。以每日使用 4 小时,每度电 0.6 元计算,一个月(30 天)的电费约为 22 元。与之对比,当前市场上某款热门的云端服务,其基础会员年费仅为 110 元。可见,本地部署5个月的电费支出便足以支付该云端服务一年的会员费用,成本差异显著。由此可见,相较于本地部署,云端服务在成本控制方面具备明显优势。

六、有更好的替代方案

Deepseek 官方 API能自动升级模型,且免费使用,阿里云 PAI 可一键调用 Deepseek,360的纳米AI搜索也能免费调用Deepseek的R1模型高速专线,秘塔AI搜索里面也内置了Deepseek的R1模型等。

综上所述,科技的发展旨在让生活更便捷,在决定是否本地部署 Deepseek 前,应冷静思考自身需求,避免盲目跟风,陷入烧钱又崩溃的困境。如果你也正想本地部署deepseek,那么还是请你三思而后行,如果你已经部署了,建议你先体验一下哈(不然白忙活了),好不好用回头欢迎在评论区分享成果。

那么如何使用Deepseek呢,我的建议是第一优先级是使用官方网站Deepseek(https://chat.deepseek.com/)……

重要的事情说三次:不要再本地部署了!不要再本地部署了!不要再本地部署了!

如何系统的去学习大模型LLM ?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

事实上,抢你饭碗的不是AI,而是会利用AI的人。

继科大讯飞、阿里、华为等巨头公司发布AI产品后,很多中小企业也陆续进场!超高年薪,挖掘AI大模型人才! 如今大厂老板们,也更倾向于会AI的人,普通程序员,还有应对的机会吗?

与其焦虑……

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高。

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、LLM大模型经典书籍

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套LLM大模型报告合集

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、LLM大模型系列视频教程

四、LLM大模型开源教程(LLaLA/Meta/chatglm/chatgpt)

LLM大模型学习路线 ↓

阶段1:AI大模型时代的基础理解

-

目标:了解AI大模型的基本概念、发展历程和核心原理。

-

内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

-

目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

-

内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.3 流水线工程

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

-

目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

-

内容:

- L3.1 Agent模型框架

- L3.2 MetaGPT

- L3.3 ChatGLM

- L3.4 LLAMA

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

-

目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

-

内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

这份 LLM大模型资料 包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

3515

3515

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?