点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:3D视觉工坊

添加小助理:dddvision,备注:方向+学校/公司+昵称,拉你入群。文末附行业细分群

扫描下方二维码,加入3D视觉知识星球,星球内凝聚了众多3D视觉实战问题,以及各个模块的学习资料:近20门视频课程(星球成员免费学习)、最新顶会论文、计算机视觉书籍、优质3D视觉算法源码等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

0. 这篇文章干了啥?

我们与自动驾驶公司May Mobility合作,提出了MARS数据集,该数据集整合了使多智能体、多遍历和多模态自动驾驶汽车研究得以实现的场景。

MARS数据集是通过一组在特定地理区域内行驶的自动驾驶汽车收集的。每辆车都有自己的行驶路线,不同的车辆可能会出现在附近的位置。每辆车都配备了激光雷达和环绕视图RGB摄像头。

我们在MARS数据集中整理了两个子集:一个子集促进了多辆车同时出现在同一地点的协同驾驶,另一个子集则通过多辆车对同一地点的异步遍历实现了记忆回溯。我们在地点识别和神经重建方面进行了实验。更重要的是,MARS为诸如多遍历3D重建、多智能体感知和无监督对象发现等新的研究机会和挑战提供了可能。

下面一起来阅读一下这项工作~

1. 论文信息

标题:Multiagent Multitraversal Multimodal Self-Driving: Open MARS Dataset

作者:Yiming Li, Zhiheng Li, Nuo Chen, Moonjun Gong, Zonglin Lyu, Zehong Wang, Peili Jiang, Chen Feng

机构:纽约大学、May Mobility

原文链接:https://arxiv.org/abs/2406.09383

官方主页:https://ai4ce.github.io/MARS/

官方主页:https://maymobility.com/

2. 摘要

大规模数据集推动了基于AI的自动驾驶汽车研究的最新进展。然而,这些数据集通常是从单一车辆单次通过某个地点时收集的,缺乏多智能体交互或对同一地点的重复遍历。这些信息可能使自动驾驶汽车的感知、预测和规划能力发生质的提升。为了弥补这一差距,我们与自动驾驶公司May Mobility合作,推出了MARS数据集,该数据集统一了使能多智能体、多遍历和多模态自动驾驶汽车研究的场景。更具体地说,MARS是通过在特定地理区域内行驶的一组自动驾驶车辆收集的。每辆车都有自己的路线,不同的车辆可能出现在附近的位置。每辆车都配备了激光雷达和环绕视图RGB相机。我们在MARS中整理了两个子集:一个子集促进了多辆车在同一地点同时存在的协作驾驶,另一个子集通过多辆车对同一地点的异步遍历实现了记忆回溯。我们在位置识别和神经重建方面进行了实验。更重要的是,MARS引入了新的研究机遇和挑战,如多遍历3D重建、多智能体感知和无监督对象发现。

3. 效果展示

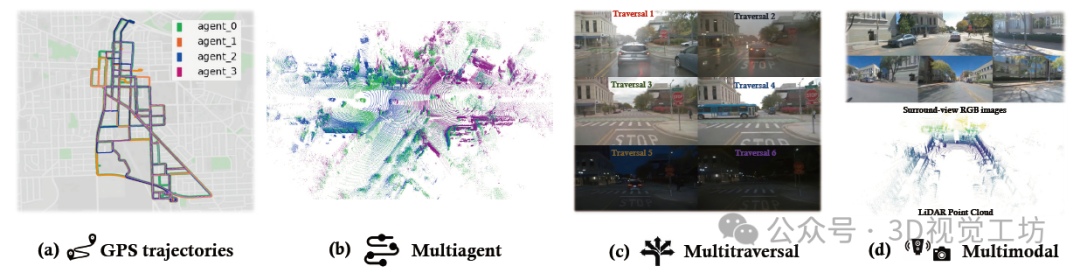

MARS概述。(a)在特定地理区域内,我们操作四辆自动驾驶车辆,使用不同的颜色展示它们在同一天内的GPS轨迹。(b)车辆偶尔会靠得很近(通过不同颜色的点云进行可视化),支持多智能体系统的研究。(c)我们在不同条件下对同一地点进行多次遍历,收集感知数据,用于具有回溯记忆的学习和感知研究。(d)数据集包括环视RGB图像和LiDAR点云,用于跨模态感知和学习。

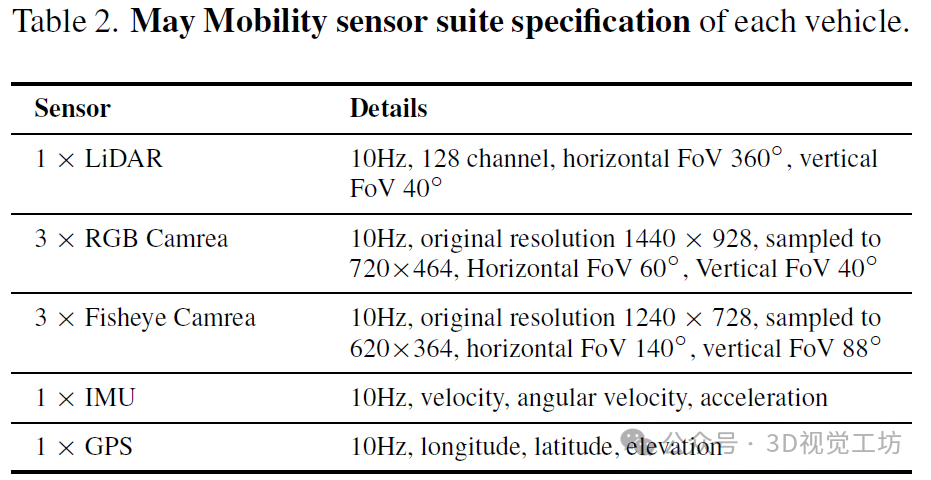

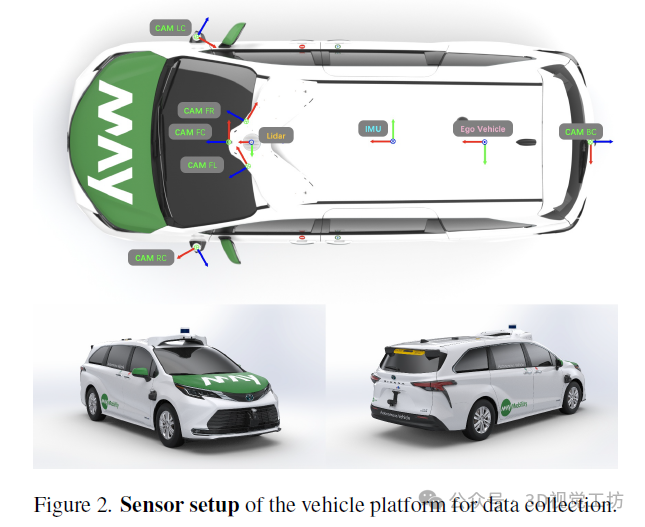

传感器设置。May Mobility的车队包括四辆丰田塞纳(Toyota Sienna),每辆车都配备了一个激光雷达、三个窄角RGB相机、三个广角RGB鱼眼相机、一个IMU和一个GPS。这些传感器具有不同的原始输出频率,但最终所有传感器数据都被采样至10Hz以实现同步。为了节省存储空间,相机图像被降采样。这些传感器的详细规格列在表2中。

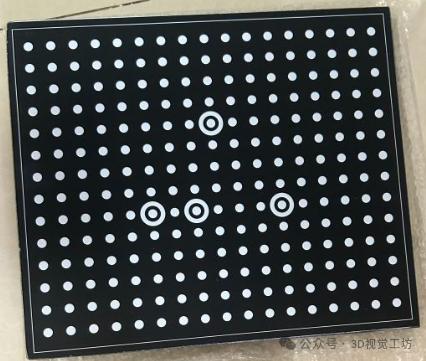

一般来说,激光雷达位于车辆的前部顶部。三个窄角相机分别位于车辆的前部、前部左侧和前部右侧。三个鱼眼相机分别位于车辆的后部中心、左侧和右侧;见图2。IMU和GPS位于车辆的中心顶部。这些传感器的明确外参表示为旋转和平移,用于将传感器数据从其自己的传感器坐标系转换到车辆的自身坐标系。对于每辆车上的每个相机,我们提供了相机内参和畸变系数。畸变参数是通过AprilCal校准方法推断出来的。

坐标系。共有四个坐标系:传感器坐标系、自身坐标系、局部坐标系和全局坐标系。传感器坐标系表示其原点定义在单个传感器中心的坐标系。自身坐标系表示其原点定义在自身车辆后轴中心的坐标系。局部坐标系表示其原点定义在自身车辆当天轨迹起点的坐标系。全局坐标系是世界坐标系。

4. 主要贡献

所有记录均来自在密歇根州安娜堡运营的May Mobility公司的自动驾驶汽车。

多智能体。我们部署了一组自动驾驶汽车,在指定的地理区域内进行导航。这些汽车可以同时出现在同一地点,通过车对车通信实现协作的3D感知。

多遍历。我们在不同的光照、天气和交通条件下,在同一空间区域内捕获了多次遍历。每次遍历可能遵循独特的路线,覆盖不同的驾驶方向或车道,从而产生多条轨迹,为3D场景提供多样化的视觉观测。

多模态。我们为自动驾驶汽车配备了RGB相机和LiDAR,两者都具有完整的360度视野。这套全面的传感器套件可以实现多模态和全景场景理解。

我们在地点识别和神经重建方面进行了定量和定性实验。更重要的是,MARS为视觉和机器人学社区引入了新颖的研究挑战和机遇,包括但不限于多智能体协作感知和学习、在重复遍历下的无监督感知、持续学习、神经重建以及利用多个智能体或多个遍历进行的新颖视图合成。

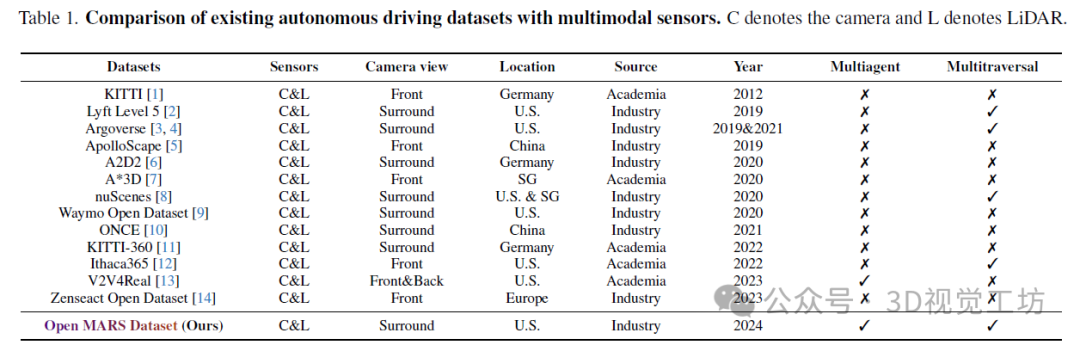

5. 数据集对比

我们的MARS数据集提供了具有全景摄像机视图的多智能体、多遍历和多模式驾驶记录

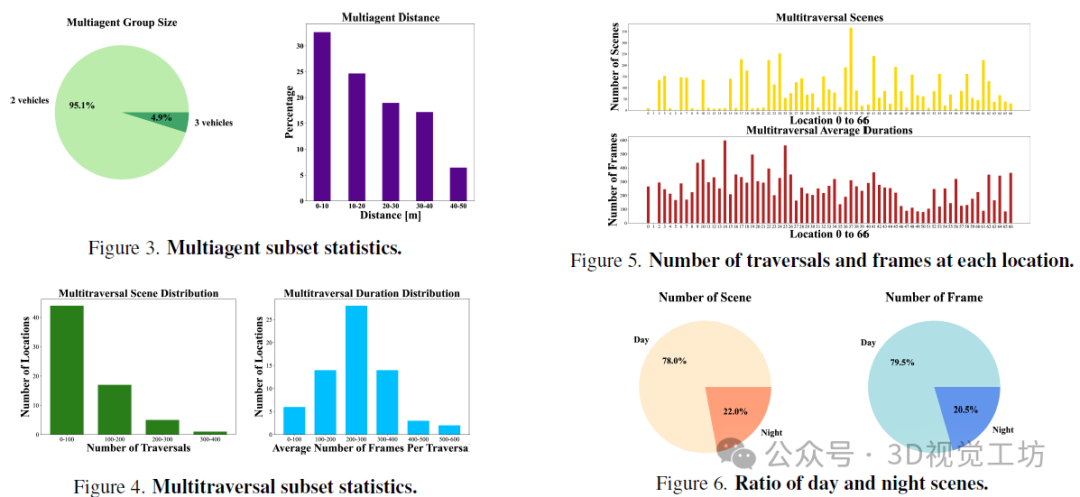

多遍历子集涵盖了从2023年10月4日到2024年3月8日之间26个不同日期的数据,其中有4天是雨天。我们共收集了5757次遍历,每个相机包含超过140万帧的图像和360度的激光雷达点云。在67个位置中,48个位置有超过20次遍历,23个位置有超过100次遍历,6个位置有超过200次遍历。每次遍历平均有250帧(25秒),其中大多数遍历包含100到400帧(10到40秒)。所有位置上的遍历和帧的具体分布。

如图4和图5所示。多智能体子集涵盖了从2023年10月23日到2024年3月8日之间20个不同日期的数据。我们收集了53个时长为30秒的场景,每个场景稳定地包含297到300帧,总共包含超过15000帧的图像和激光雷达点云。在53个场景中,有52个场景涉及两辆车,1个场景涉及三辆车。我们分析了每帧中每对自车之间的距离。分布表明,大多数情况下,两辆车在相距不到50米时相遇,如图3所示。

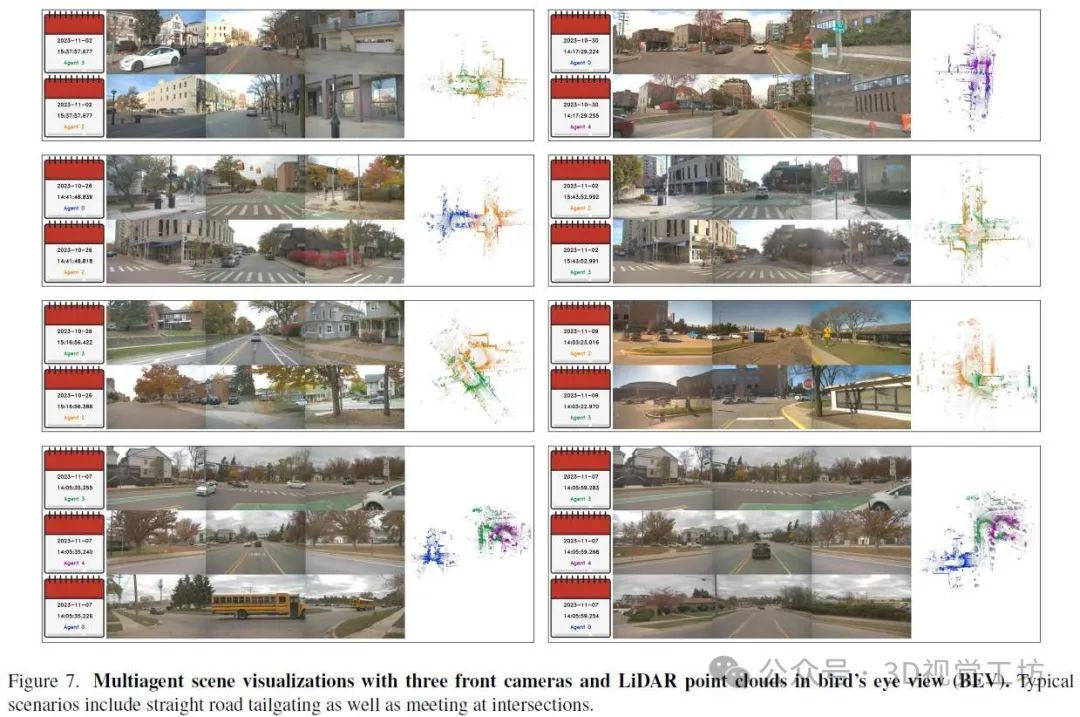

多智能体数据采集。我们数据集的亮点在于我们提供了现实世界同步的多智能体协作感知数据,这些数据提供了极其详细的空间覆盖范围。根据车辆的GPS坐标,我们提取了30秒长的场景,其中两个或多个主体车辆相互之间的距离小于50米的时间超过9秒,这些车辆共同提供了同一区域的同时但不同角度的重叠感知。对于相遇持续时间少于30秒的场景,相遇部分被放置在30秒时间段的中心,前后填充相等数量的非相遇时间(例如,20秒的相遇时间通过在其前后各添加5秒来扩展到30秒的场景)。这种相遇可以发生在地图上的任何地方,构成了如直路上尾随和交叉路口相遇等场景,如图7所示。我们的方法还确保场景中的至少一辆车在30秒内行驶超过10米。

6. 实验结果

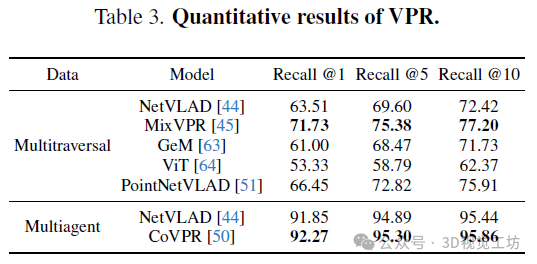

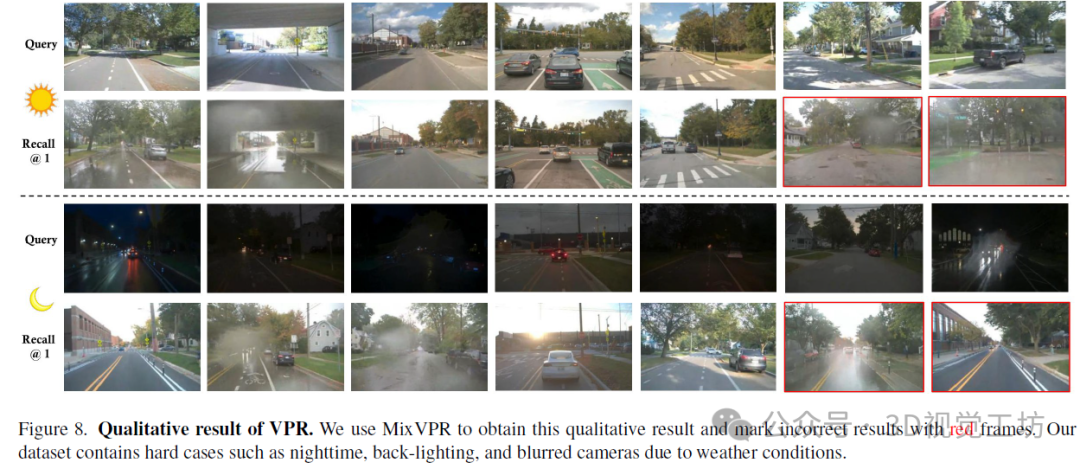

定量结果如表3所示。尽管GeM在其池化方法中实现了轻量级的特性,但与具有较小主干的NetVLAD相比,其性能较差。ViT在VPR中展示了较弱的性能,尽管其主干比ResNet更强,但没有针对任务的特定池化方法。MixVPR取得了最佳性能,因为其特征混合机制提供了更丰富的特征。利用点云的Point-NetVLAD在较小的输入尺寸下比NetVLAD获得了更好的性能。在多智能体数据的背景下,CoVPR始终优于其单智能体对应物。定性结果如图8所示。我们的数据集包含了白天和夜晚的场景,以及晴天、多云和雨天等各种天气条件。困难示例来自夜间场景和受雨或背光影响的摄像头。

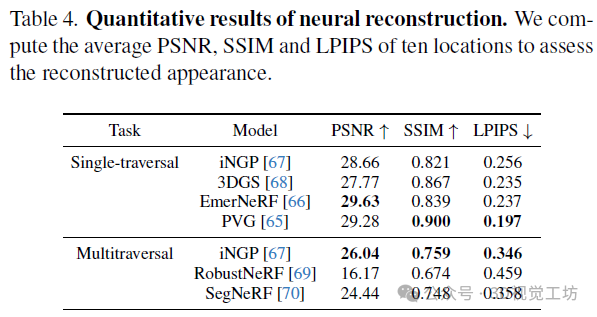

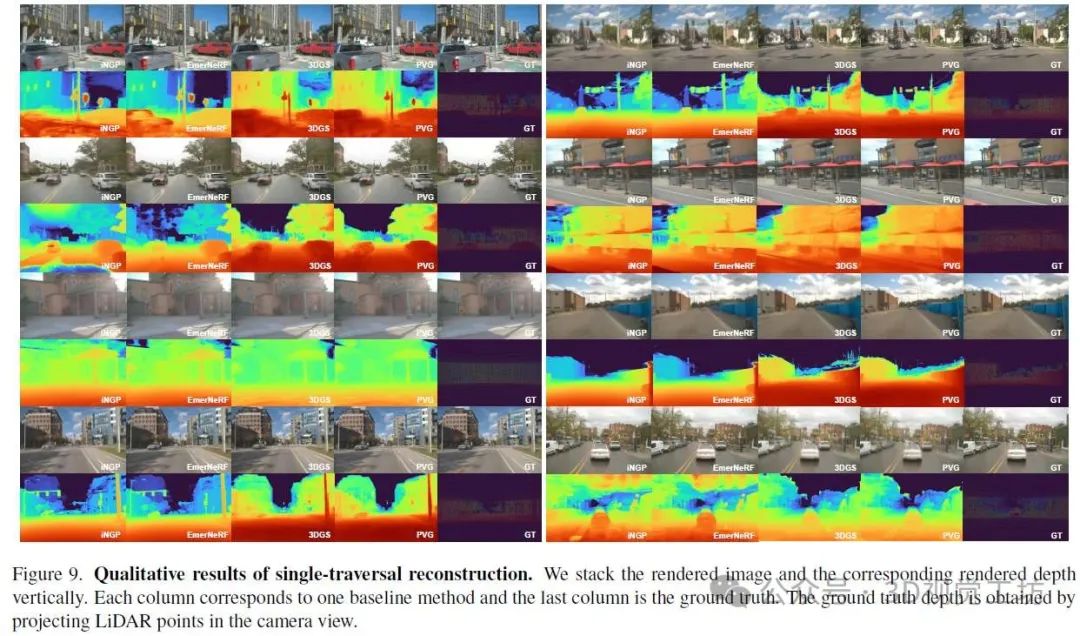

单次遍历实验:基于表4中的结果,PVG获得了更高的SSIM分数和更好的LPIPS分数,表明其结构细节得到了增强。PVG的卓越性能可能归因于其灵活的高斯点设置,该设置能够灵活地捕捉线性运动以及物体的出现和消失。另一方面,EmerNeRF在PSNR方面表现出色,这可能是由于其新颖的动态-静态分解方法。如图9所示,EmerNeRF和PVG都展示了完美渲染动态对象(如移动的汽车)的能力,而iNGP和3DGS在这方面的表现相对较差。

多次遍历实验:由于图像嵌入,iNGP能够渲染具有不同光照的场景。然而,它在准确渲染动态对象或去除动态对象方面存在困难。如表4所示,iNGP获得了最佳的相似性度量指标,因为它保留了关于动态对象的最多信息。RobustNeRF在消除动态对象方面表现最佳,但代价是静态对象的渲染细节较少。SegFormer利用语义信息,与其他两种方法相比,获得了更好的视觉结果。然而,汽车的阴影并没有完全去除,这可能是由于语义分割模型对阴影的识别不足。

7. 总结 & 未来工作

我们的MARS数据集代表了自动驾驶汽车研究领域的显著进步,通过整合多智能体、多遍历和多模态维度,超越了传统的数据收集方法。MARS为探索3D重建和神经模拟、协作感知和学习、基于场景先验的无监督感知等领域开辟了新途径。未来的工作包括为在线感知任务(如多智能体和多遍历场景中的语义占用预测)提供注释。我们坚信,MARS将在人工智能驱动的自动驾驶汽车研究中树立新的基准。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

本文仅做学术分享,如有侵权,请联系删文。

3D视觉工坊交流群

目前我们已经建立了3D视觉方向多个社群,包括2D计算机视觉、大模型、工业3D视觉、SLAM、自动驾驶、三维重建、无人机等方向,细分群包括:

2D计算机视觉:图像分类/分割、目标/检测、医学影像、GAN、OCR、2D缺陷检测、遥感测绘、超分辨率、人脸检测、行为识别、模型量化剪枝、迁移学习、人体姿态估计等

大模型:NLP、CV、ASR、生成对抗大模型、强化学习大模型、对话大模型等

工业3D视觉:相机标定、立体匹配、三维点云、结构光、机械臂抓取、缺陷检测、6D位姿估计、相位偏折术、Halcon、摄影测量、阵列相机、光度立体视觉等。

SLAM:视觉SLAM、激光SLAM、语义SLAM、滤波算法、多传感器融合、多传感器标定、动态SLAM、MOT SLAM、NeRF SLAM、机器人导航等。

自动驾驶:深度估计、Transformer、毫米波|激光雷达|视觉摄像头传感器、多传感器标定、多传感器融合、自动驾驶综合群等、3D目标检测、路径规划、轨迹预测、3D点云分割、模型部署、车道线检测、Occupancy、目标跟踪等。

三维重建:3DGS、NeRF、多视图几何、OpenMVS、MVSNet、colmap、纹理贴图等

无人机:四旋翼建模、无人机飞控等

除了这些,还有求职、硬件选型、视觉产品落地、最新论文、3D视觉最新产品、3D视觉行业新闻等交流群

添加小助理: dddvision,备注:研究方向+学校/公司+昵称(如3D点云+清华+小草莓), 拉你入群。

3D视觉工坊知识星球

3D视觉从入门到精通知识星球、国内成立最早、6000+成员交流学习。包括:星球视频课程近20门(价值超6000)、项目对接、3D视觉学习路线总结、最新顶会论文&代码、3D视觉行业最新模组、3D视觉优质源码汇总、书籍推荐、编程基础&学习工具、实战项目&作业、求职招聘&面经&面试题等等。欢迎加入3D视觉从入门到精通知识星球,一起学习进步。

3DGS、NeRF、结构光、相位偏折术、机械臂抓取、点云实战、Open3D、缺陷检测、BEV感知、Occupancy、Transformer、模型部署、3D目标检测、深度估计、多传感器标定、规划与控制、无人机仿真、三维视觉C++、三维视觉python、dToF、相机标定、ROS2、机器人控制规划、LeGo-LAOM、多模态融合SLAM、LOAM-SLAM、室内室外SLAM、VINS-Fusion、ORB-SLAM3、MVSNet三维重建、colmap、线面结构光、硬件结构光扫描仪,无人机等。

3D视觉相关硬件

| 图片 | 说明 | 名称 |

|---|---|---|

| 硬件+源码+视频教程 | 精迅V1(科研级))单目/双目3D结构光扫描仪 |

| 硬件+源码+视频教程 | 深迅V13D线结构光三维扫描仪 |

| 硬件+源码+视频教程 | 御风250无人机(基于PX4) |

| 硬件+源码 | 工坊智能ROS小车 |

| 配套标定源码 | 高精度标定板(玻璃or大理石) |

| 添加微信:cv3d007或者QYong2014 咨询更多 | ||

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

3D视觉科技前沿进展日日相见 ~

3766

3766

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?