点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信号:CVer111,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

转载自:Amaze

深度学习三巨头之一的Yoshua Bengio团队发布了一篇新论文!论文重新审视了十多年前的传统循环神经网络(RNNs),即长短期记忆网络(LSTMs)和门控循环单元(GRUs),通过去除隐藏状态依赖和一些约束条件,提出了最小化版本(minLSTMs 和 minGRUs),这些版本在训练时可并行计算,且参数显著减少,同时在多个任务上与近期的序列模型性能相当。

Were RNNs All We Needed?

论文:https://arxiv.org/pdf/2410.01201

论文要点:

|

研究背景

1.研究背景

Transformer 的局限:近年来 Transformer 在很多领域占主导地位,但它在序列长度上具有二次计算复杂度,对于长序列成本过高。因此,人们开始研究更高效的替代方案,如循环序列模型,其在训练时对序列长度具有线性内存需求,推理时逐个 token 循环展开,只需常数内存。

相关研究:包括状态空间模型(如 Mamba)和基于注意力的方法等,这些模型大多可使用并行前缀扫描算法进行高效训练。

2. 传统 RNN 回顾

LSTM:通过输入门、遗忘门和输出门来控制细胞状态和隐藏状态的更新,缓解了梯度消失问题,但计算复杂且只能顺序计算,训练时需要通过时间反向传播(BPTT),难以扩展到长序列。

GRU:简化了 LSTM,只有两个门和一个状态,训练和推理速度更快,但同样存在只能顺序计算和需要 BPTT 的问题。

方法与实验结果

1.方法

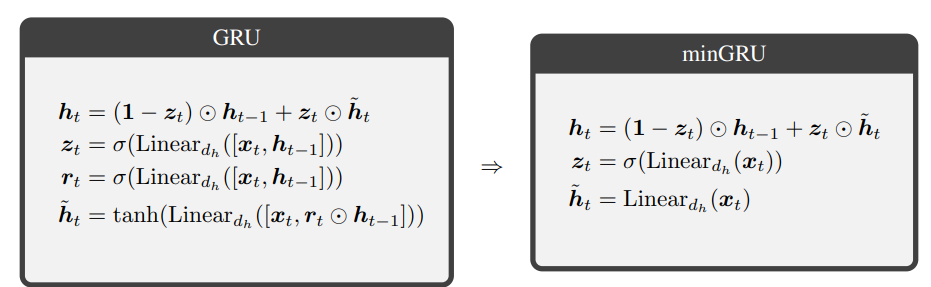

minGRU

步骤一:去除门的先前隐藏状态依赖:将 GRU 的更新门和候选隐藏状态的计算从依赖于先前隐藏状态和当前输入,改为仅依赖于当前输入。

步骤二:去除候选状态的范围限制:去掉了双曲正切函数(tanh)对候选隐藏状态的范围限制。

结果:得到的 minGRU 模型参数数量显著减少,仅需个参数,且可使用并行扫描算法进行训练。

minLSTM

步骤一:去除门的先前隐藏状态依赖:类似 minGRU,将 LSTM 的遗忘门、输入门和候选细胞状态的计算改为仅依赖于当前输入。

步骤二:去除候选状态的范围限制:去掉 tanh 对候选细胞状态和隐藏状态的范围限制。

步骤三:确保输出在尺度上与时间无关:通过归一化遗忘门和输入门,确保细胞状态的尺度与时间无关,并去掉输出门,进一步简化模型。

结果:minLSTM 模型仅需个参数,可并行训练。

2. 实验结果

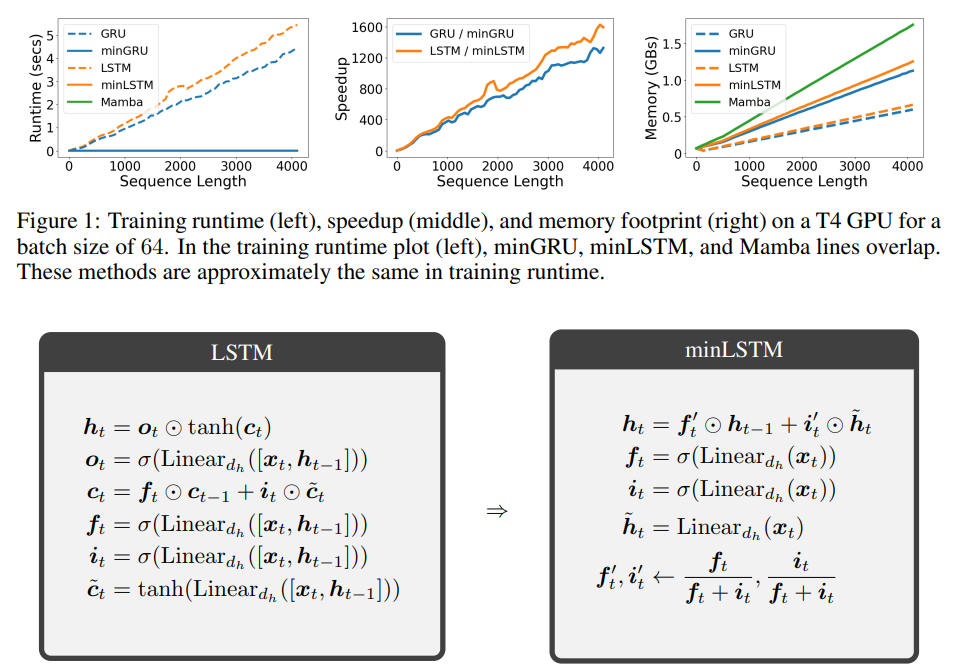

训练效率

运行时间:在不同序列长度下,minGRU 和 minLSTM 与 Mamba 的运行时间相近。对于长度为 512 的序列,minGRU 和 minLSTM 在 T4 GPU 上每个训练步骤分别比 GRU 和 LSTM 快和;对于长度为 4096 的序列,分别快和。

内存占用:minGRU、minLSTM 和 Mamba 由于使用并行扫描算法,相比传统 RNN 需要更多内存,minGRU 和 minLSTM 比传统版本多使用约的内存,Mamba 比 minGRU 多使用的内存。

层数影响:增加 minLSTM 和 minGRU 的层数可提高模型性能和稳定性,minGRU 在解决选择性复制任务时比 minLSTM 更稳定。

性能表现

选择性复制任务:minGRU 和 minLSTM 能够解决该任务,性能与 Mamba 的 S6 相当,优于其他一些基线模型。

强化学习任务:在 D4RL 数据集上,minLSTM 和 minGRU 优于 Decision S4,与 Decision Transformer、Aaren 和 Mamba 性能相当。

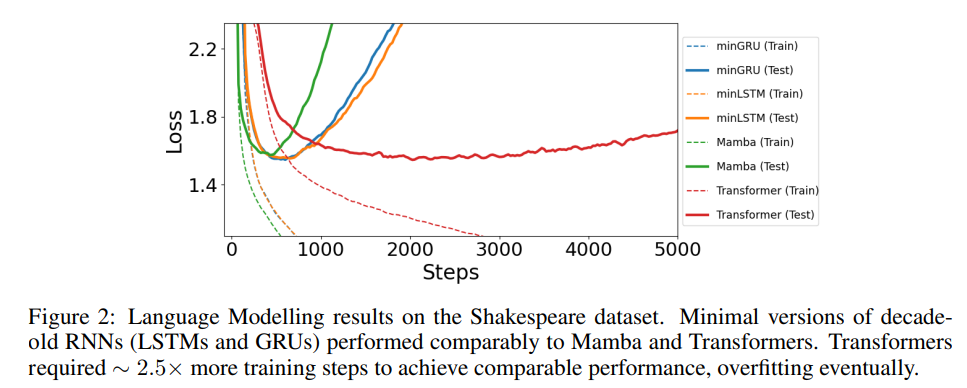

语言建模任务:在莎士比亚数据集上,minGRU、minLSTM 与 Mamba 和 Transformer 的测试损失相当,Transformer 训练速度明显较慢。

3. 相关工作比较

与状态空间模型(SSMs)、注意力的循环版本以及其他可并行训练的 RNNs 相比,minLSTM 和 minGRU 的核心循环组件相似,但在过渡计算方式上存在差异。这些模型都可看作是通过并行扫描训练的同一类函数的成员。

结论与优劣分析

1.结论

通过对传统 RNNs(LSTMs 和 GRUs)的深入研究和改进,成功提出了 minLSTMs 和 minGRUs 这两种最小化版本的模型。

实验结果表明,minLSTMs 和 minGRUs 在多个方面取得了显著成果。它们解决了传统 RNNs 在训练效率上的计算局限,能够高效地利用并行计算资源进行训练,在不同的任务场景下,包括选择性复制任务、强化学习任务以及语言建模任务等,都展现出了与现代先进的序列模型(如 Mamba、Transformer 等)相当的性能。

这一研究成果重新审视了传统 RNNs 的价值,表明经过合理的改进和优化,传统的 RNN 结构仍然具有强大的生命力和应用潜力,为序列数据处理领域提供了新的思路和方法。

2.优劣分析

(1)优势

训练效率提升

参数减少:minLSTMs 和 minGRUs 相较于传统的 LSTMs 和 GRUs,显著减少了参数数量。minGRU 仅需个参数,minLSTM 仅需个参数,这使得模型在训练和存储上更加高效。

并行训练:这两种模型可以使用并行扫描算法进行训练,摆脱了传统 RNNs 对时间反向传播(BPTT)的依赖,大大提高了训练速度。例如,在序列长度为 512 时,minGRU 和 minLSTM 在 T4 GPU 上每个训练步骤分别比 GRU 和 LSTM 快和。

性能表现良好

在多个任务中,minLSTMs 和 minGRUs 都展现出了与现代先进序列模型相当的性能。在选择性复制任务中,能够像 Mamba 的 S6 一样解决问题,优于其他一些基线模型;在强化学习任务中,在 D4RL 数据集上优于 Decision S4,与 Decision Transformer、Aaren 和 Mamba 性能相当;在语言建模任务中,在莎士比亚数据集上与 Mamba 和 Transformer 的测试损失相当。

模型稳定性

随着层数的增加,minLSTMs 和 minGRUs 的性能和稳定性都有所提高。例如在选择性复制任务中,层数增加到 3 层时,minLSTM 的准确率达到,minGRU 的准确率达到,同时方差减小,表明模型更加稳定。并且 minGRU 在解决选择性复制任务时比 minLSTM 更稳定,因为 minGRU 通过单一的更新门控制信息的丢弃和添加,更容易优化。

(2)劣势

内存占用增加

minLSTMs 和 minGRUs 由于采用并行扫描算法,相比传统 RNNs 需要更多的内存。它们比传统版本多使用约的内存,这在内存资源有限的环境下可能会成为应用的限制因素。

实验规模受限

研究中的实验是在 P100 和 T4 GPU 上进行的,规模相对较小。例如在选择性复制任务中,为了适应 GPU 内存,需要使用梯度累积来训练,这导致训练速度减慢。虽然作者认为结论可以推广到更大规模的设置,但目前缺乏大规模实验的直接验证。

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!

ECCV 2024 论文和代码下载

在CVer公众号后台回复:ECCV2024,即可下载ECCV 2024论文和代码开源的论文合集CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba、多模态和扩散模型交流群成立

扫描下方二维码,或者添加微信号:CVer111,即可添加CVer小助手微信,便可申请加入CVer-Mamba、多模态学习或者扩散模型微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者扩散模型+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer111,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集上万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

3255

3255

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?