本推文介绍了人工智能顶级会议CVPR 2025的一篇论文《EchoMimicV2: Towards Striking, Simplified, and Semi-Body Human Animation》。该论文提出了一种名为EchoMimicV2的半身人体动画方法,该方法利用了一种新颖的音频姿势动态协调策略(Audio-Pose Dynamic Harmonization, APDH),包括姿势采样(Pose Sampling)和音频扩散(Audio Diffusion),来增强半身细节、面部和手势表现力,同时减少条件冗余。此外,由于公共数据集通常评估音频驱动的说话头像或姿势驱动的人体动画,但没有一个专门针对音频驱动的半身动画。为了填补这一空白,该文引入了一个用于评估半身人体动画的EchoMimicV2测试数据集(EMTD)。经过广泛的实验和分析, EchoMimicV2框架的有效性得以验证,该框架在定性和定量指标上表现良好。

本推文由王一鸣撰写,审核为龚裕涛和黄忠祥

原文链接:https://arxiv.org/abs/2411.10061

代码链接:https://github.com/antgroup/echomimic_v2

一、会议介绍

IEEE/CVF Computer Vision and Pattern Recognition Conference(CVPR)是计算机视觉和模式识别领域的顶级学术会议之一,每年举办一次,与ICCV和ECCV并称为计算机视觉领域的三大顶级会议。该会议被评为CCF-A类会议,含金量极高。

期刊官网:https://cvpr.thecvf.com/Conferences/2025

二、研究背景与主要贡献

基于扩散模型的视频生成已经取得了重大进展,促进了对人类动画的广泛研究。人体动画作为视频生成领域的一个子集,旨在从参考角色图像中合成自然逼真的人类视频序列。目前关于人体动画的研究大量采用预训练扩散模型作为骨干,可以很好地生成逼真的动画。

遗憾的是,学术研究与产业需求之间仍存在差距,主要体现在以下两个方面:

1.头部区域限制。之前的人体动画作品主要侧重于生成头部区域视频,忽视了音频和身体下方肩膀的同步。

2.条件的复杂性。常用的控制条件(如文本、音频、姿势、光流、运动图)可以为逼真的动画提供坚实的基础。但复杂的条件会产生不协调从而导致训练不稳定以及推理延迟增加。

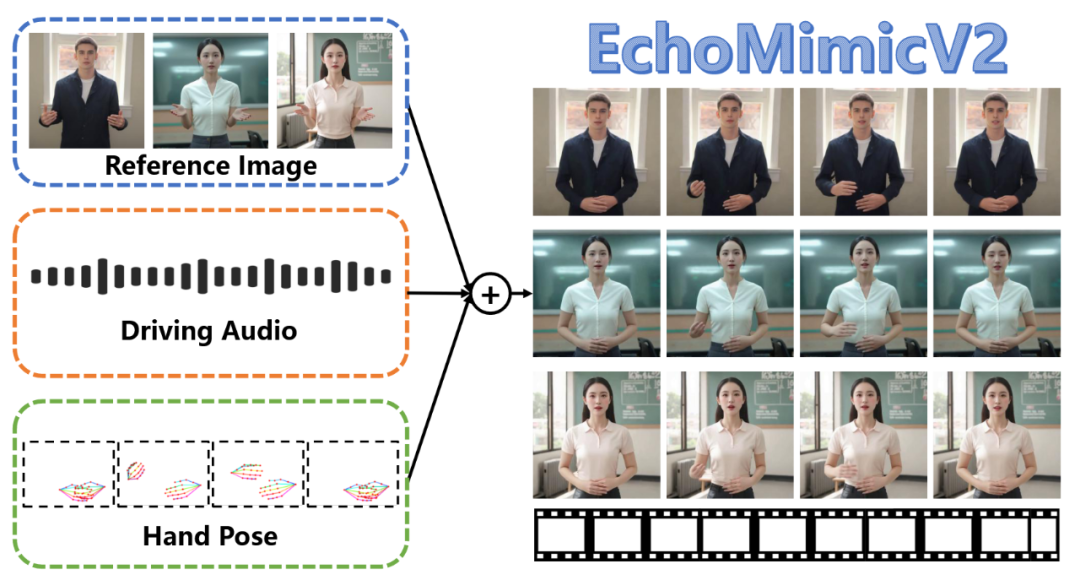

为了解决上述问题,EchoMimicV2致力于在简化条件下实现惊艳的的半身动画质量。如图1所示,EchoMimicV2仅使用图像、音频、手势作为驱动条件,即可创造出逼真且惊艳的虚拟数字人动画。为此,EchoMimicV2利用音频姿势动态协调(APDH)训练策略来调制音频和姿势条件,同时减少姿势条件的冗余。此外,它利用一个稳定的训练目标函数,称为相位特定损失(PhD Loss),来增强运动、细节和低级质量,取代冗余条件的指导。

总而言之,本文的贡献如下:

(1) 提出了EchoMimicV2,这是一个端到端的音频驱动框架,用于惊艳的的半身人体动画,但由简化的条件驱动;

(2) 提出了APDH策略,精心调制音频和姿势条件,减少姿势条件冗余;

(3) 为半身人体动画提供了一个新的评估基准。

(4) 进行了广泛的实验和分析,以验证EchoMimicV2的有效性,该框架超越了其他最先进的方法。

图1 EchoMimicV2利用参考图像、音频片段和一系列手部姿势来生成高质量的动画视频

三、研究方法

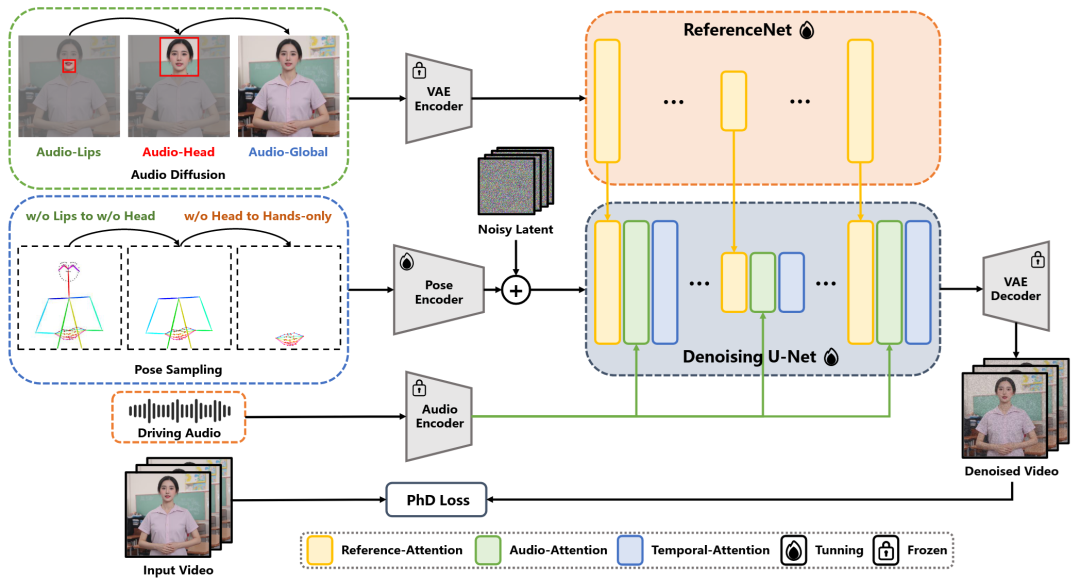

图2 EchoMimicV2的整体结构

如图2所示,该文中提出的EchoMimicV2包含多个模块。接下来将分模块逐步讲解。

3.1 准备工作

(1) 潜扩散模型( Latent Diffusion Model, LDM)

EchoMimicV2基于潜扩散模型,该模型采用变分自编码器(Variational Auto-Encoder, VAE)编码器将图像从像素空间映射到更紧凑的潜在空间。在训练过程中,将高斯噪声逐渐添加至潜像中。LDM的主要训练目标是估计在每个时间步长t引入的噪声,在推理阶段,使用预训练模型对从高斯分布采样的潜在向量进行迭代去噪。随后使用VAE解码器将去噪的潜像解码回图像。

(2) 基于ReferenceNet的骨干网络

在基于ReferenceNet的主干中,使用预训练的2D U-Net的副本作为ReferenceNet,从参考图像中提取参考特征。然后通过交叉注意机制将这些特征注入去噪U-Net,以保持生成的图像和参考图像之间的外观一致性。

使用预训练的Wav2Vec模型作为音频编码器来提取音频特征,然后通过去噪U-Net中的音频交叉注意块作为音频条件注入,以实现动作和音频之间的同步。

使用姿势编码器来提取关键点图。然后将这些关键点图与潜在噪声连接起来,并输入去噪U-Net,作为姿态条件。

使用时间注意力块注入去噪U-Net中,以捕捉帧间运动依赖关系,实现动画的运动平滑。

3.2 音频姿态动态协调

接下来将介绍EchoMimicV2的核心训练策略,即音频姿势动态协调(APDH)。APDH被用来逐步降低条件复杂性,并以华尔兹般的方式调制音频和姿势条件。该策略由两个主要部分组成:姿态采样和音频扩散。

(1) 姿态采样

初始姿态阶段:EchoMimicV2框架的训练从完整的姿态驱动阶段开始。在该阶段,关闭音频交叉注意力块,仅优化去噪 U-Net 中的其他模块,以实现对人体动作的全面识别。

迭代姿态采样阶段:在迭代层面,随着迭代次数增加,逐步对姿态条件进行丢弃。这种渐进式丢弃有助于减轻对姿态条件的过度依赖。

空间姿态采样阶段:在空间层面,作者按以下顺序移除关键点来采样姿态条件:首先是嘴唇部分,其次是头部,最后是身体部分。通过这种方式,姿态条件对唇部动作、面部表情和身体的控制被逐步减弱,从而为音频驱动过程创造空间,让音频条件发挥主导作用。

(2) 音频扩散

在初始姿态阶段和迭代层面姿态采样阶段,音频交叉注意力块完全冻结。在空间层面姿态采样阶段,音频条件开始逐步融入。

音频-唇部同步:移除嘴唇关键点后,将唇部的空间掩码应用于音频交叉注意力块,形成唇部部分注意力,迫使音频条件单独控制唇部动作。这样可以增强音频与唇部的同步性。

音频-面部同步:移除头部关键点后,将空间掩码扩展到头部区域,并应用于音频交叉注意力块,形成头部部分注意力。这使得音频条件能够主导整体面部表情,增强音频与面部表情的同步性。

音频-身体关联:对于仅含手部关键点的情况,部分掩码扩展到全局空间。这会产生完全由音频驱动的半身动画,同时姿态条件重点控制手部。需要注意的是,手部是音频条件和姿态条件的交叉点。因此,部分音频线索会转化为适当的手势,从而更好地捕捉音频与手势的关联。

四、实验结果

4.1 实验设置

训练数据集由三部分组成:完全姿势驱动数据集、半身数据集和头部特写数据集。首先使用HumanVid作为完全姿势驱动的数据集,其中包括大约20000个高质量的以人为中心的视频,带有2D姿势注释。半身训练数据集是从互联网视频中挑选出来的,主要关注半身说话的场景。该数据集涵盖160个小时,包括10000多个身份。头像数据集来自EchoMimic中使用的训练数据集,包括540小时的说话头像视频。

新型半身评估基准。公共数据集通常评估音频驱动的说话头或姿势驱动的人体动画,但没有一个专门针对音频驱动的半身动画。为了填补这一空白,该文引入了用于评估半身人体动画的EchoMimicV2测试数据集(EMTD)。EMTD包括来自YouTube的65个高清TED视频(1080P),其中包含110个带注释、清晰、面向前方的半身语音片段。

半身人体动画方法使用FID、FVD、PSNR、SSIM、E-FID等指标进行评估。FID、FVD、SSIM和PSNR是评估低级视觉质量的指标。E-FID使用Inception网络特征评估图像真实性,用面部重建方法提取表情参数,并计算其FID分数以衡量表情差异。为了评估身份一致性,这里也计算了参考图像的面部特征与生成的视频帧之间的相似度(CSIM)。此外,作者还使用SyncNet计算Sync-C和Sync-D,以确保音频唇形同步的准确性。此外,为了评估手部动画,采用HKC(手部关键点置信度)平均值来评估音频驱动场景中的手部质量,并计算HKV(手部核心点方差)来指示手部动作的丰富程度。

4.2 定性结果

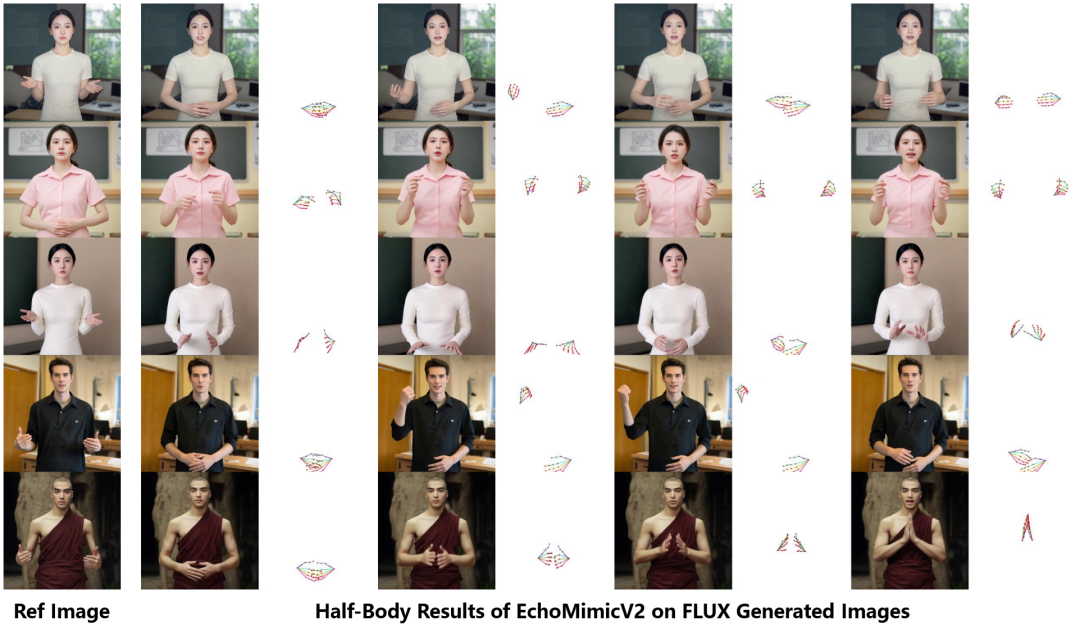

为了评估EchoMimicV2的定性结果,文中使用FLUX.1-dev生成参考图像,然后基于这些参考图像进行半身动画。EchoMimicV2使用音频信号、参考图像和手部姿势序列生成高分辨率的半身人体视频。如图3所示,这里展示了EchoMimicV2在合成视频时的结果。这些结果证实了其在音频驱动的半身人体视频生成中具有良好的性能,并说明EchoMimicV2可以很好地推广到不同的角色和复杂的手势。

图3 EchoMimicV2的生成结果,给出了不同的参考图像、手部姿势和音频。

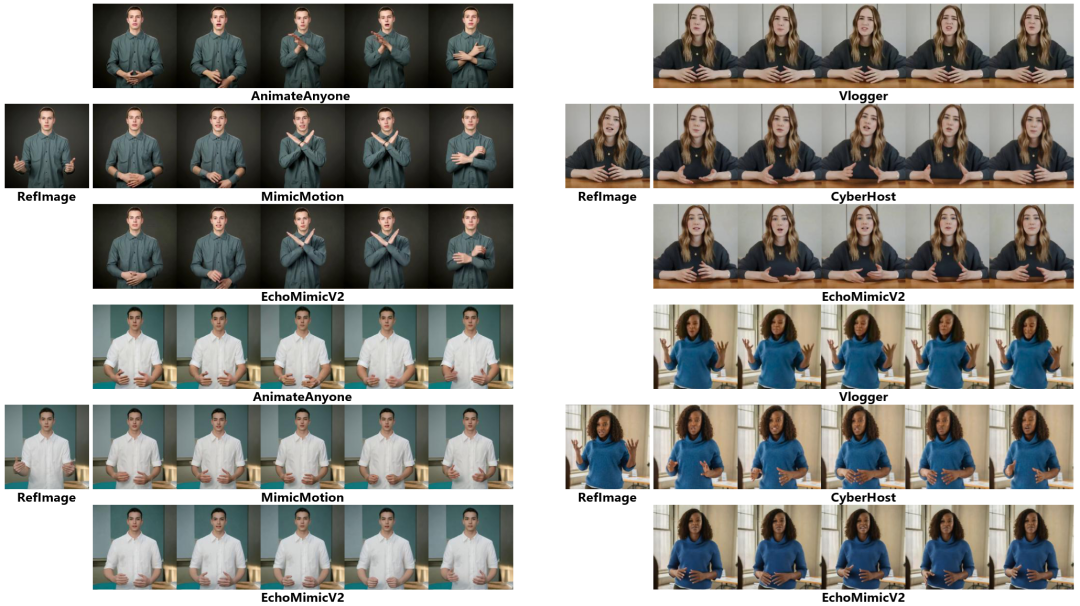

与姿势驱动和音频驱动方法的比较。该文将EchoMimicV2与最先进的姿势驱动方法进行了比较,包括AnimateAnyone和MimicMotion。同时还与音频驱动方法进行了比较,包括Vlogger和CyberHost。它们的结果如图4所示。可以看到, EchoMimicV2在结构完整性和身份一致性方面优于AnimateAnyone和MimicMotion,特别是在手和脸等局部区域。同时EchoMimicV2在生成的图像质量和运动的自然度方面都超过了Vlogger和CyberHost。

图4 EchoMimicV2的结果与姿势驱动的半身人体动画基线以及音频驱动的半身人体动画进行了比较。

4.3 定量结果与消融实验

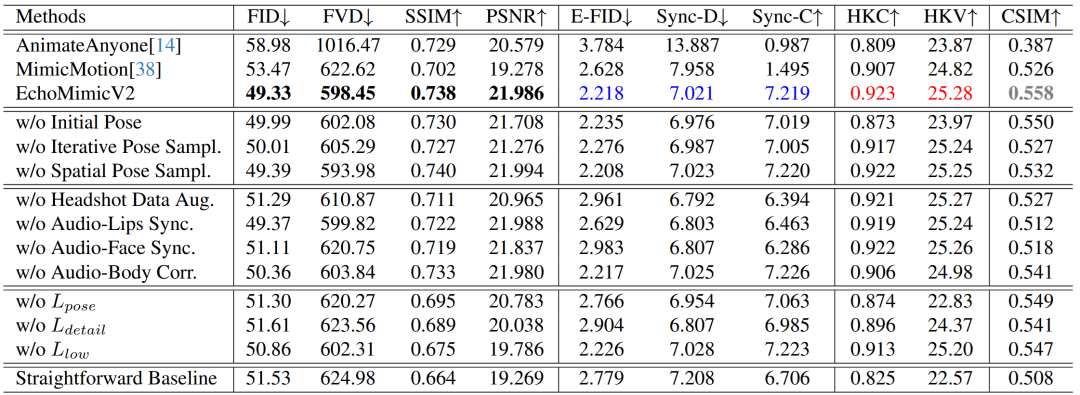

如表1所示,这里将EchoMimicV2与最先进的人体动画方法进行了定量比较,包括AnimateAnyone和MimicMotion。结果表明,EchoMimicV2显著提高了整体性能。具体来说,EchoMimicV2在质量指标(FID、FVD、SSIM和PSNR)方面表现出了显著的增强,在同步指标(Sync-C和Sync-D)方面也取得了竞争性的结果。此外,EchoMimicV2在一致性度量(CSIM)方面超越了其他SOTA方法,也在手持相关质量指标(HKV、HKC)中实现了新的SOTA。

此外,在表1中还展示了消融实验的结果,可以看出在绝大部分指标上,完整的EchoMimicV2都获得了最佳性能,证明了音频姿态动态协调(APDH)策略中姿势采样和音频扩散,以及PhD损失的有效性。

表1 EchoMimicV2和其他SOTA方法的定量比较和消融研究。

五、总结

本推文主要介绍了EchoMimicV2框架,它被用于生成由简化条件驱动的惊艳逼真的半身人体动画。该框架利用APDH训练策略和独特的PhD Loss实现了音频姿势条件协作和简化。综合实验表明,EchoMimicV2在定量和定性结果方面都超过了当前最先进的技术。此外,作者还介绍了一种用于评估半身人体动画的新基准,并将源代码和测试数据集提供给开源使用,以促进社区的进步。

737

737

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?