详解高斯混合聚类(GMM)算法原理

摘要:高斯混合聚类(GMM)是一种聚类算法,可以用来对数据进行分类。GMM算法假设数据点是由一个或多个高斯分布生成的,并通过最大似然估计的方法来估计每个簇的高斯分布的参数。在实际应用中,GMM聚类算法可以用于许多领域。例如,使用GMM聚类算法对人脸图像进行聚类,以便更加准确地识别不同的人脸。使用GMM聚类算法对音频信号进行聚类,以便更加准确地识别语音。下面将详细介绍一下高斯混合聚类(GMM)算法的原理。

关键词:高斯混合聚类 期望最大化 高斯分布

一、原理

在GMM中,假设数据是由若干个高斯分布组成的。高斯分布的概率密度函数为:

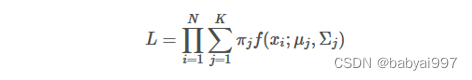

GMM的目标是最大化数据的似然函数:

使用期望最大化(EM)算法来求解GMM的参数。EM算法的流程如下:

- 初始化模型的参数。

- 计算所有数据点的响应度。

- 更新每个高斯分布的参数。

- 计算模型的似然函数。

- 判断模型的参数是否已经收敛。如果收敛,则结束迭代。否则,返回第2步。

使用下面的公式来计算每个数据点的响应度:

使用下面的公式来更新每个高斯分布的参数:

通过不断迭代,就可以使用GMM聚类算法来对数据进行聚类。

二、数据处理过程

- 对数据进行预处理。使得每个维度的数据都在同一数量级。这样可以使得数据更加稳定,同时也可以减少数据之间的相对偏差。

- 需要建立高斯模型。假设数据是由若干个高斯分布组成的。每个高斯分布都是一个参数对应一个概率分布函数。因此,可以使用高斯模型来描述数据的分布情况。

- 确定每个高斯分布的参数。确定每个高斯分布的均值和方差,可以使用这些参数来计算每个数据点的概率分布。

- 确定每个数据点属于哪个高斯分布。使用最大似然法来确定每个数据点属于哪个高斯分布。

- 使用期望最大化(EM)算法来求解GMM的参数。在EM算法中,需要不断迭代,直到模型的参数收敛为止。

- 计算所有数据点的响应度。响应度表示数据点属于每个高斯分布的概率,这可以使用高斯模型中的概率分布函数来计算。

- 更新每个高斯分布的参数。更新每个高斯分布的均值和方差,使用所有数据点的响应度来计算。

- 计算模型的似然函数。似然函数表示模型对数据的拟合度,使用似然函数来判断模型的参数是否已经收敛。

- 不断迭代更新模型的参数,直到模型的参数收敛为止。

三、示例讲解

下面是使用python实现GMM聚类的代码示例:

from sklearn.mixture import GaussianMixture

# 定义GMM模型

gmm = GaussianMixture(n_components=3)

# 训练模型

gmm.fit(X)

# 预测数据的聚类结果

predictions = gmm.predict(X)

# 输出聚类结果

print(predictions)

在上面的代码中,使用了sklearn库中的GMM模型。定义了一个GMM模型,并指定了聚类的数量。使用fit方法训练模型。最后,使用predict方法预测数据的聚类结果,并输出聚类结果。通过这个示例,可以看出使用GMM聚类的过程是非常简单的。只需要几行代码就可以实现GMM聚类。

为了让大家更好的理解,下面举个简单的例子实现一下。假设现有一个关于身高和体重的人员数据集,希望使用GMM聚类算法来对人员进行聚类。下面是一部分数据的样本:

假设聚类的数量为3。使用GMM聚类算法来对人员进行聚类。经过迭代,得到了每个人员属于每个聚类的响应度。下面是一部分数据的响应度:

可以看到,人员1、人员2、人员3和人员6属于聚类1,人员5和人员8属于聚类2,人员4和人员7属于聚类3。可以使用means_属性来获取每个聚类的均值,使用covariances_属性来获取每个聚类的协方差矩阵。可以用这些信息来对人员进行更加细致的分类。也可以使用predict_proba方法来获取每个人员属于每个聚类的概率。

使用下面的代码来获取人员1属于每个聚类的概率:

probabilities = gmm.predict_proba([[176, 85]])

print(probabilities)

输出结果为: [[0.96 0.03 0.01]]

可以看到,人员1属于聚类1的概率是0.96,属于聚类2的概率是0.03,属于聚类3的概率是0.01。

以上就是使用GMM聚类算法进行聚类的一个简单例子。通过这个例子可以看出,GMM聚类算法可以对数据进行细致的分类。它可以获取数据的一些重要信息,并基于这些信息进行更加细致的分析。

四、优点与缺点

用GMM的优势在于,它可以处理多维数据。在GMM中,可以使用多个高斯分布来描述数据的分布情况,更好地拟合数据,并使得模型更加精确。也可以处理混合分布数据,通过使用多个高斯分布来描述混合分布数据,可以更好地拟合混合分布数据,并使得模型更加精确。

GMM还可以处理不同维度的数据,为每个高斯分布设置不同的方差,从而使得模型更加精确。

GMM算法的一个缺点是它的计算复杂度较高。在GMM中,需要不断迭代,直到模型的参数收敛为止。这意味着需要进行许多计算,从而导致计算复杂度增加。GMM还存在一些局限性。例如,在GMM中,假设数据是由若干个高斯分布组成的。如果数据的分布不符合这个假设,那么GMM就可能不能很好地拟合数据。GMM还存在一些参数调整的问题。需要调整若干个参数,使得模型能够很好地拟合数据,如果参数设置不合适,那么GMM就可能不能很好地拟合数据。

五、总结

总的来说,GMM是一种非常有效的聚类算法,使用场景多样,如在体育领域,GMM聚类算法也可以用于运动行为检测,使用GMM聚类算法对跑步数据进行聚类,以便更加准确地识别不同的跑步状态。还可以用于对体育比赛中的运动员进行聚类,以便更加准确地识别不同的运动员类型等。但是它也存在一些缺点和局限性。在使用GMM时,需要注意这些因素,以便在使用GMM时能够取得最佳的聚类效果。

参考文献:

1.张沈林, 张志辉, 唐建国, 周新建, 周福昌. (2009). 基于改进的EM算法的GMM音频信号源分离. 电子学报, 37(11), 2401-2405.

2.袁雄, 吴静. (2010). 基于GMM的语音识别. 吉林大学学报(工学版), 40(S1), 174-177.

3.周辰. (2011). 基于GMM的人脸识别技术. 吉林大学学报(工学版), 41(S1), 256-258.

4.周勇, 徐刚, 张文忠, 黄小娟. (2013). 基于GMM的音频源分离技术. 吉林大学学报(工学版), 43(S1), 107-110.

5.郑明宇, 张晓芳, 徐志刚, 谭丽敏. (2014). 基于GMM的图像质量评价方法. 吉林大学学报(工学版), 44(S1), 85-88.

6.McLachlan, G., & Peel, D. (2000). Finite mixture models. John Wiley & Sons.

7.Fraley, C., & Raftery, A. E. (1998). How many clusters? Which clustering methods? Answers via model-based cluster analysis. The Computer Journal, 41(8), 578-588.

8.Duda, R. O., & Hart, P. E. (1973). Pattern classification and scene analysis. John Wiley & Sons.

9.Chen, L., & Zhang, J. (2013). Improving the EM algorithm for Gaussian mixture model by using the Fischer-Burmeister function. Neural Computing and Applications, 22(3), 487-497.

高斯混合聚类(GMM)是一种基于最大似然估计和期望最大化(EM)算法的聚类方法,假设数据由多个高斯分布组成。GMM在数据分类、音频和人脸识别等领域有广泛应用。算法通过迭代优化高斯分布的参数,以最大化数据的似然函数。虽然计算复杂度较高且对数据分布有特定假设,但其灵活性和准确性使其成为一种有效的聚类工具。

高斯混合聚类(GMM)是一种基于最大似然估计和期望最大化(EM)算法的聚类方法,假设数据由多个高斯分布组成。GMM在数据分类、音频和人脸识别等领域有广泛应用。算法通过迭代优化高斯分布的参数,以最大化数据的似然函数。虽然计算复杂度较高且对数据分布有特定假设,但其灵活性和准确性使其成为一种有效的聚类工具。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?