©PaperWeekly 原创 · 作者 | Jason

研究方向 | 计算机视觉

现有的深度卷积神经网络(CNN)结构通常依赖于 batch normalization(BatchNorm)来有效地训练模型。BatchNorm 显著提高了模型性能,但在小 batch 情况下性能较差。为了克服这一局限性,作者提出了核归一化(kernel normalization)和核归一化卷积层,并将它们作为主要的构建块集成到核归一化卷积网络(KNConvNets)中。

作者实现了与最先进的 CNN(如 ResNet 和DenseNet)相对应的 KNConvNets,同时放弃了 BatchNorm 层。通过大量实验,作者表明,KNConvNet 在准确性和收敛速度方面始终优于 BatchNorm,GroupNorm 和 LayerNorm,同时保持了有竞争力的计算效率。

论文和代码地址

论文标题:

Kernel Normalized Convolutional Networks

论文地址:

https://arxiv.org/abs/2205.10089

Motivation

卷积神经网络(CNN)是计算机视觉任务中的标准架构。深层 CNN,包括 ResNet、DenseNet 和 Efficentnet,在对具有挑战性的数据集(如 ImageNet)进行分类方面取得了优异的性能。这些 CNN 的主要构建块之一是 batch normalization(BatchNorm)。BatchNorm 层通过平滑优化空间和解决梯度消失的问题,大大增强了深层 CNN 的性能。

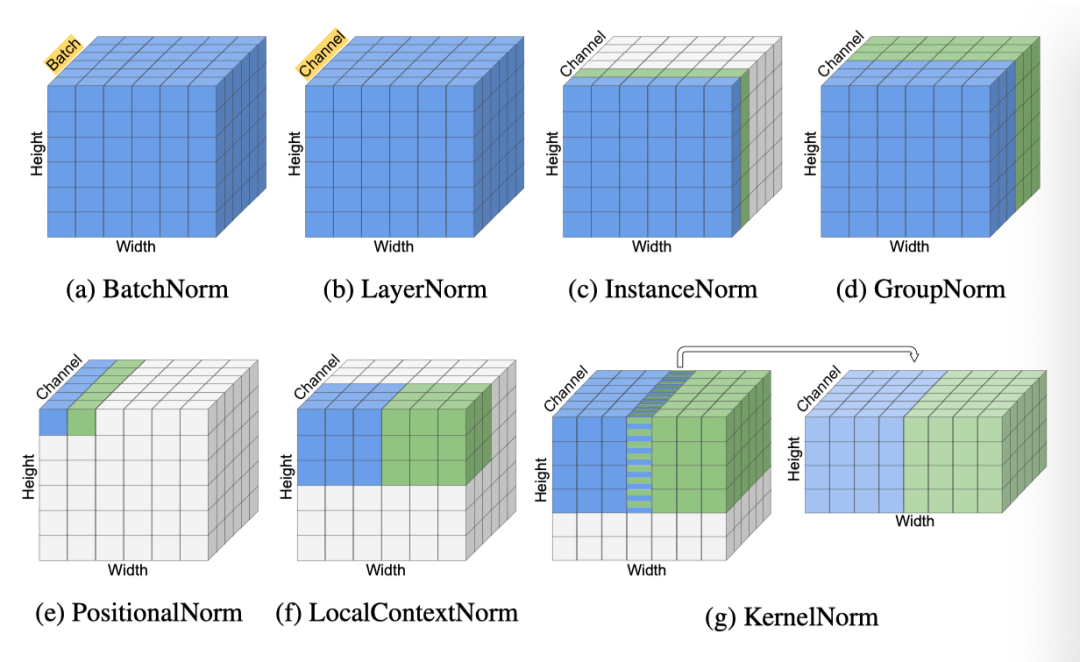

然而,BatchNorm 的缺点是打破了 batch 中样本之间的独立性。这是因为 BatchNorm 沿着 batch 维度执行归一化(上图 a),因此,与给定样本相关的归一化值取决于 batch 中其他样本的统计信息。因此,BatchNorm 的有效性在很大程度上取决于 batch 大小。使用大 batch,BatchNorm 可以更准确地估计 batch 统计信息,从而有效地训练模型,但会产生较高的内存开销。另一方面,对于小 batch,BatchNorm 会导致模型精度的大幅降低。

为了克服 BatchNorm 的局限性,引入了与 Batch

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9795

9795

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?