Domain Adaptation(DA: 域自适应),Domain Generalization(DG: 域泛化)一直以来都是各大顶会的热门研究方向。DA 假设我们有有一个带标签的训练集(源域),这时候我们想让模型在另一个数据集上同样表现很好(目标域),利用目标域的无标签数据,提升模型在域间的适应能力是 DA 所强调的。

以此为基础,DG 进一步弱化了假设,我们只有多个源域的数据,根本不知道目标域是什么,这个时候如何提升模型泛化性呢?传统 DG 方法就是在源域 finetune 预训练模型,然后部署时不经过任何调整,核心在于如何利用多个源域带来的丰富信息。本文大致总结了发表于 ICML 2023 中与分布变化,DA,DG,OOD detection 以及与域偏移相关的一系列文章。

01

/ ICML 2023 Poster /

论文标题:

On Balancing Bias and Variance in Unsupervised Multi-Source-Free Domain Adaptation

论文链接:

https://openreview.net/forum?id=jWFRFz7yIc

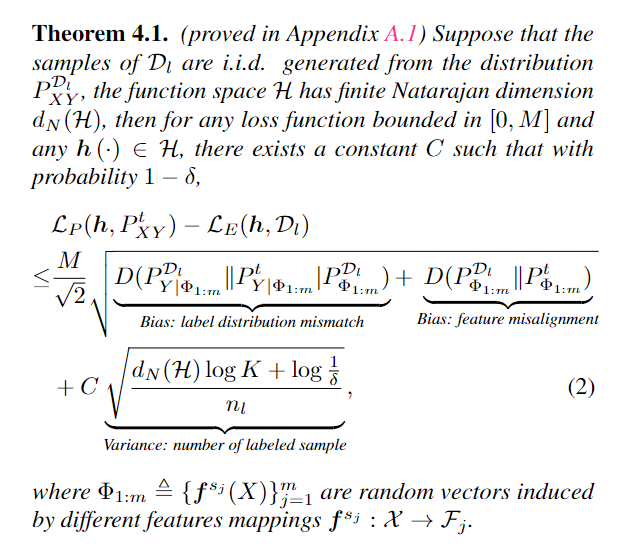

现有的多源自适应方法通常使用源模型生成的伪标签数据训练目标模型,这些方法主要关注改进伪标签技术或提出新的训练目标。而该研究旨在分析多源自适应的基本限制,并提供平衡这种权衡的洞察力。文章从三个角度(域聚合、选择性伪标签和联合特征对齐)讨论了如何平衡偏差和方差的问题,并提出了新的算法。通过在多个数据集上的实验证实了理论分析,并展示了所提出算法在一些具有挑战性的数据集上的卓越性能。

文章的核心方法是通过理论分析提出了多源自适应问题的信息论上界,揭示了固有的偏差-方差权衡。作者提出了从三个角度平衡偏差和方差的洞察力,并设计了新的算法。其中,域聚合可以减少标签不匹配的偏差,选择性伪标签可以进一步平衡标签不匹配的偏差和方差,而联合特征对齐策略可以显式地解决源域和目标域之间的域漂移问题,从而减少特征不匹配的偏差。

1. learning domain aggregation weights without target domain labs: 初始化一个权重参数 ,然后通过以下 loss 进行优化:即最小化单个预测的熵同时使得整体预测标签的边际分布接近于一个均匀分布。

2. surrogate section rule for the sective Oracle:不给所有数据打伪标签而是选择其中一部分,这个选择了机遇 prototype 的伪标签去噪技术,使得伪标签的质量尽可能的高。

3. a joint adversarial feature alignment approach:使用 adversarial training,对每个模型生成的特征进行对齐。

02

/ ICML 2023 Poster /

论文标题:

Sequential Counterfactual Risk Minimization

论文链接:

https://openreview.net/forum?id=E3Ny4RnbiT

这篇文章介绍了一个称为“连续反事实风险最小化(SCRM)”的框架,用于改善离线数据分析中“反事实风险最小化(CRM)”的性能。CRM 的目标是使用记录的 bandit feedback 数据来增强日志策略。SCRM 将 CRM 扩展到顺序设置中,可以多次部署学习策略以收集新数据。

文章的主要目标是在 SCRM 框架中开发一种学习策略,以最小化超额风险和预期遗憾(excess risk and expected regret)。作者提出了一种新颖的反事实估计器,并通过类似于加速优化方法中的重启策略的分析确定了可以改善 CRM 性能的条件。他们还通过在离散和连续行动设置中进行实证评估探讨了 CRM 多次部署的益处。

03

/ ICML 2023 Poster /

论文标题:

Provably Invariant Learning without Domain Information

论文链接:

https://openreview.net/forum?id=0jSSVPrfcX

背景:典型的机器学习应用通常假设数据遵循独立同分布(IID)的假设。然而,在现实世界中,这种假设经常被违反,导致了分布外(OOD)泛化问题和模型鲁棒性的严重下降。为了缓解这个问题,利用不变性学习技术来区分所有输入特征中的虚假特征和不变特征,并仅基于不变特征对模型进行训练。许多不变性学习策略要求训练数据应包含领域信息,如环境索引或先前知识获取的辅助信息。然而,在实践中通常无法获取这些信息。

本研究提出了一种无环境特定信息训练的环境无关不变性学习方法 TIVA。在因果图中,给定适当的条件,本文发现并证明可以基于与目标无关的属性来训练一个环境划分策略,然后进行不变风险最小化。该论文提出了一种名为 TIVA 的方法,用于在不知道领域信息的情况下进行不变性学习。通过在因果图中发现与目标无关的属性,可以训练一个环境划分策略,并进行不变风险最小化。该方法在多个基准测试中展示了优越的性能和出色的 OOD 鲁棒性。

04

/ ICML 2023 Poster /

论文标题:

Hybrid Energy Based Model in the Feature Space for Out-of-Distribution Detection

论文链接:

https://openreview.net/forum?id=tpCynHFviX

深度学习模型在关键应用领域(如医疗保健、自动驾驶或国防)中的部署需求,其中重要的安全要求之一是能够区分正常分布和异常分布的样本。当前大多数方法采用后处理的策略,利用预训练模型的特征空间来估计正常样本的密度以进行异常检测。现有的密度估计方法包括高斯混合模型(GMM)、最近邻分布和基于能量的方法(如能量对数 EL)等。然而,这些方法往往针对不同类型的异常数据表现出不同的检测能力,具体而言 EL 一般对 near-OOD data 效果更好,而 GMM 相反。作者引入了一种名为 HEAT 的方法,该方法使用基于能量的混合模型在预训练骨干网络的特征空间中估计内部分布样本的密度。HEAT 通过对先前的内部分布密度估计器(如高斯混合模型)进行能量修正,提供准确而稳健的密度估计。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1441

1441

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?