©PaperWeekly 原创 · 作者 | Jianwu Zheng

单位 | 上海交通大学

研究方向 | 数据管理与人工智能

近年来,神经网络(深度学习)主导了人工智能领域,并推动了大模型技术的蓬勃发展。然而,该论文引发了两个看似不相关却极具启发性的问题,可能会改变我们对现有技术的看法。

论文标题:

From Cluster Assumption to Graph Convolution: Graph-based Semi-Supervised Learning Revisited

论文链接:

https://arxiv.org/pdf/2309.13599

代码链接:

https://github.com/zhengwang100/ogc_ggcm

研究问题

第一个问题聚焦在图深度学习领域:为什么图神经网络(GCNs)会遭遇过渡平滑(oversmoothing)的问题,而传统的浅层方法却没有这种困扰,尽管它们都采用了相似的邻居信息聚合策略?

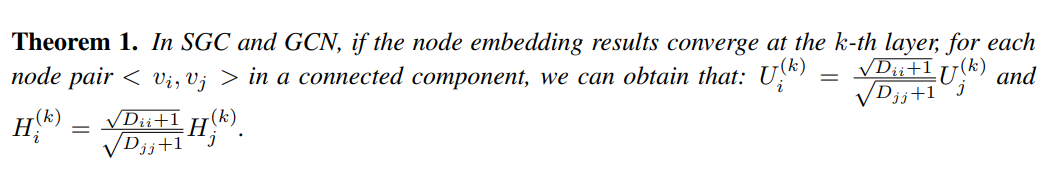

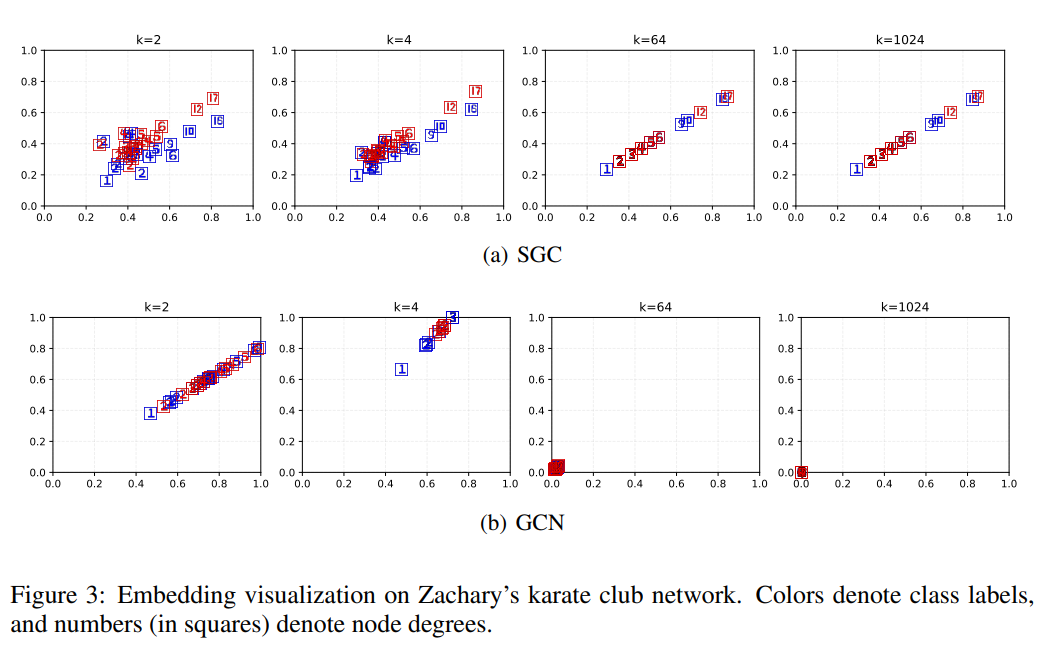

针对此问题,此论文给出了答案:相对于传统的浅层方法,典型的 GCNs 是一类“次优”方法。即 GCNs 在每一层无法同时对基于图结构的损失和基于标签的损失进行优化,从而导致了过渡平滑问题。此外,论文进一步首次从理论上给出了 GCNs 过渡平滑的理论收敛值,并通过可视化进行了展示。

第二个问题聚焦于深度学习中的数据利用效率:传统上,标注数据被分为训练集和验证集,前者用于训练模型权重,后者用于选择超参数。然而,(宝贵的、有标注的)验证集无法指导模型训练是否可惜?

针对此问题,此论文引入了一个新的深度学习模型训练 trick,叫做 LIM(Less is More)trick。其核心思想是使用所有监督数据(训练集+验证集)指导模型权重训练,但是只使用训练集(而不使用验证集)来做基于梯度下降的模型权重更新。通过这种方式,验证集的数据得到了更有效的利用,从而提升了模型的性能。

解决方案与实验结果

基于上述问题的研究,论文给出了一个非常简单的、只有一层神经网络的、半监督图嵌入算法 OGC。当从每一层的邻居中聚集信息时,OGC 基于“最优化理论”思想同时考虑图结构和标签信息。在模型参数训练更新时候,OGC 引入 LIM trick 来充分发挥验证集的效能。

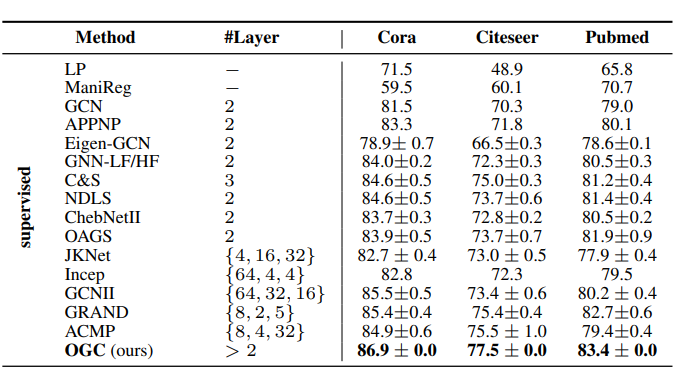

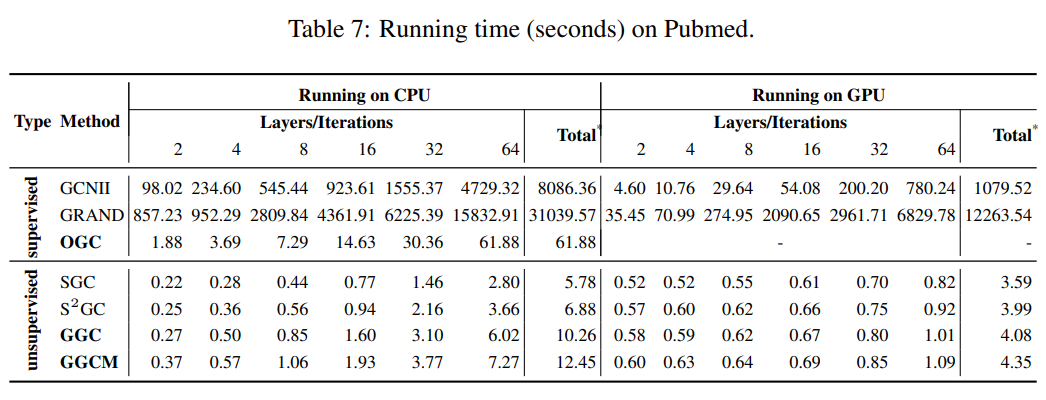

实验表明,在标准数据集 Cora、Citeseer 和 Pubmed 上,OGC 仅用一层参数就超越了所有对比方法,并在知名算法开源网站 PapersWithCode 上相关任务中排名第一。OGC 的运行速度也比其他精度较高但层数多的深度学习方法快 130 到 500 倍。

未来展望

这一研究揭示了未来两个非常有潜力的研究方向:

1. 小模型的潜力提升:虽然当下各类“定制”小模型在特定应用场景往往能够展示出不错的经济性,但是精度上仍然会输给大模型,而该论文则揭示了小模型的拥有击败大模型的潜力,值得工业界和学术界继续探索。

2. 大模型数据利用效率:大模型(比如各类 LLMs)对训练数据,尤其是珍贵的标注数据需求巨大,但是标注数据利用率仍然不佳,而 LIM trick 可以充分提升验证集利用效能,可能会是各类大模型训练数据不足的“解药”?

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

·

1589

1589

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?