直接用书上的代码(即直接手写去畸变)会出现边缘像素丢失的问题

书上代码如下:

#include <opencv2/opencv.hpp>

#include <string>

using namespace std;

string image_file = "../distorted.png"; // 请确保路径正确

int main(int argc, char **argv) {

// 本程序实现去畸变部分的代码。尽管我们可以调用OpenCV的去畸变,但自己实现一遍有助于理解。

// 畸变参数

double k1 = -0.28340811, k2 = 0.07395907, p1 = 0.00019359, p2 = 1.76187114e-05;

// 内参

double fx = 458.654, fy = 457.296, cx = 367.215, cy = 248.375;

cv::Mat image = cv::imread(image_file, 0); // 图像是灰度图,CV_8UC1

if (image.data == nullptr)

{

cerr << image_file << "not exist" << endl;

return 0;

}

int rows = image.rows, cols = image.cols;

cv::Mat image_undistort = cv::Mat(rows, cols, CV_8UC1); // 去畸变以后的图

// 计算去畸变后图像的内容

for (int v = 0; v < rows; v++) {

for (int u = 0; u < cols; u++) {

// 按照公式,计算点(u,v)对应到畸变图像中的坐标(u_distorted, v_distorted)

double x = (u - cx) / fx, y = (v - cy) / fy;

double r = sqrt(x * x + y * y);

double x_distorted = x * (1 + k1 * r * r + k2 * r * r * r * r) + 2 * p1 * x * y + p2 * (r * r + 2 * x * x);

double y_distorted = y * (1 + k1 * r * r + k2 * r * r * r * r) + p1 * (r * r + 2 * y * y) + 2 * p2 * x * y;

double u_distorted = fx * x_distorted + cx;

double v_distorted = fy * y_distorted + cy;

// 赋值 (最近邻插值)

if (u_distorted >= 0 && v_distorted >= 0 && u_distorted < cols && v_distorted < rows) {

image_undistort.at<uchar>(v, u) = image.at<uchar>((int) v_distorted, (int) u_distorted);

} else {

image_undistort.at<uchar>(v, u) = 0;

}

}

}

// 画图去畸变后图像

cv::imshow("distorted", image);

cv::imshow("undistorted", image_undistort);

cv::waitKey();

return 0;

}

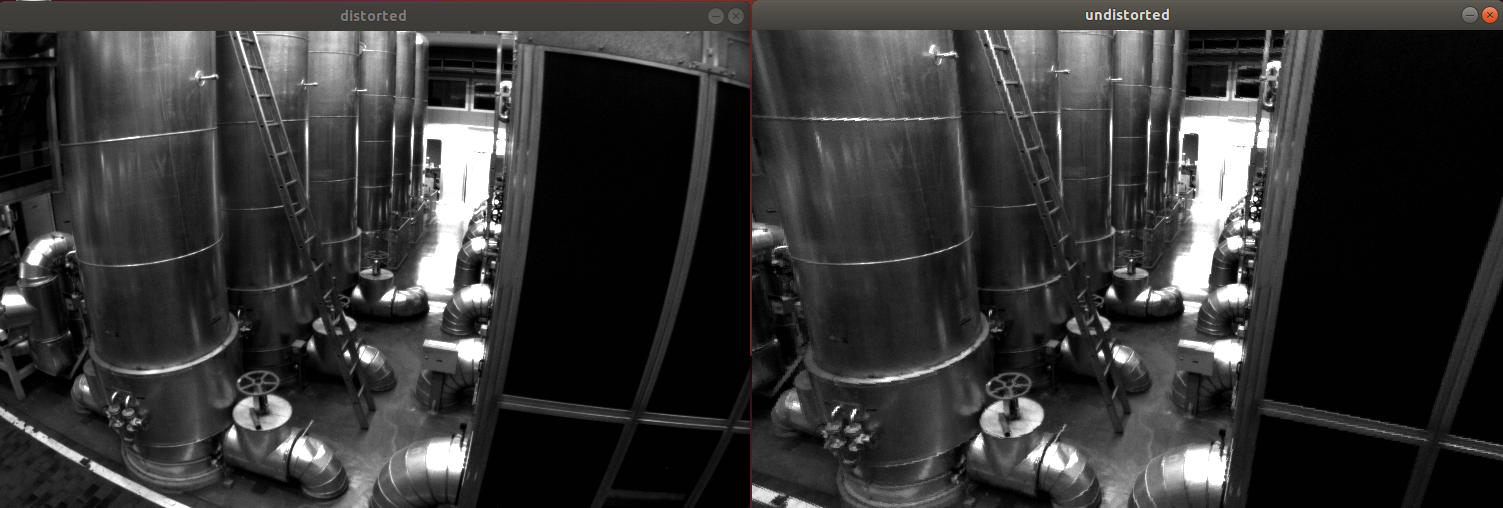

边缘像素丢失问题如下图

可以看到对比原图 图像确实“正” 了许多 但是边缘的一些信息丢失了

因此得找个方法保留边缘像素

这里参考了https://blog.csdn.net/djfjkj52/article/details/115348843

使用 getOptimalNewCameraMatrix + initUndistortRectifyMap + remap 矫正图像

并对blog中的程序做了一些修改使其能够在当前相机下使用

#include <iostream>

#include <opencv2/opencv.hpp>

using namespace std;

int main()

{

const cv::Mat K = ( cv::Mat_<double> ( 3,3 ) << 458.654, 0.0, 367.215, 0.0, 457.296, 248.375, 0.0, 0.0, 1.0 ); // 相机内参矩阵

//k1 = -0.28340811, k2 = 0.07395907, p1 = 0.00019359, p2 = 1.76187114e-05;

const cv::Mat D = (cv::Mat_<double> ( 5,1 ) << -0.28340811, 0.07395907, 0.0, 0.00019359, 1.76187114e-05);

const string str = "../distorted.png";

cv::Mat RawImage = cv::imread(str, 0);

if (RawImage.data == nullptr)

{

cerr << str << "not exist" << endl;

return 0;

}

int rows = RawImage.rows, cols = RawImage.cols;;

const int ImgWidth = cols;

const int ImgHeight = rows;

cv::Mat map1, map2;

cv::Size imageSize(ImgWidth, ImgHeight);

const double alpha = 1;

cv::Mat NewCameraMatrix = getOptimalNewCameraMatrix(K, D, imageSize, alpha, imageSize, 0);

initUndistortRectifyMap(K, D, cv::Mat(), NewCameraMatrix, imageSize, CV_16SC2, map1, map2);;

cv::imshow("RawImage", RawImage);

cv::Mat UndistortImage;

remap(RawImage, UndistortImage, map1, map2, cv::INTER_LINEAR);

cv::imshow("UndistortImage", UndistortImage);

cv::waitKey(0);

return 0;

}

转换代码时需要注意的是 畸变矩阵D的格式为k1,k2,k3,p1,p2

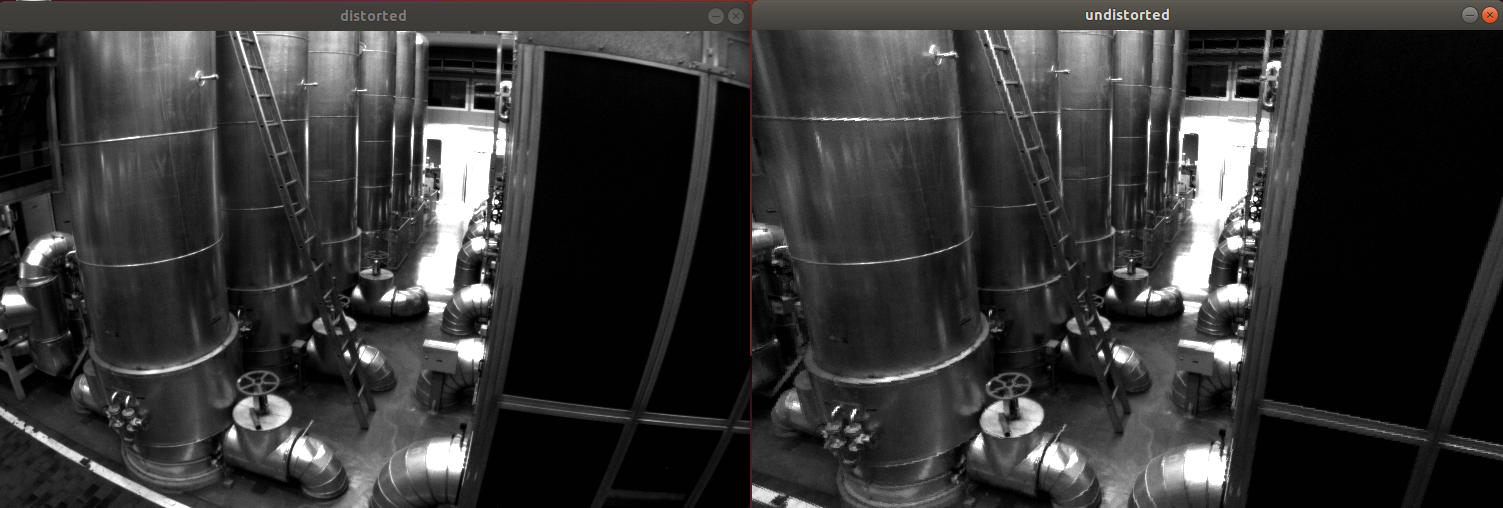

处理效果如下图

图像“正”了 但是也因为去畸变的原因 原来一些不存在的像素 没法给他生成出来(所以会有“黑框”)

注意到getOptimalNewCameraMatrix有一个参数alpha

当alpha=1时,所有像素均保留,但存在黑色边框。

当alpha=0时,损失最多的像素,没有黑色边框。

上图为alpha=0时生成的 下图为手撕畸变生成的

可以看到,alpha=0时getOptimalNewCameraMatrix + initUndistortRectifyMap + remap 的方法 比作者的手撕算法能保留更多信息 (并不是说作者的方法不好 只是单纯阐述事实 作者写这段代码的目的是让读者理解去畸变的原理,而不是实际应用)

还有一个作者提到的cv::undistort() 没有去尝试

欢迎大家补充

1597

1597

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?