深度学习模型应用场景全解析

本篇文章将深入解析CNN、Transformer、BERT、RNN 和 GAN 这五种深度学习模型的核心原理及其在实际应用中的案例。

1. 卷积神经网络(CNN)

1.1 原理

卷积神经网络(Convolutional Neural Networks, CNN)是一种专门用于处理图像数据的深度学习模型。它的核心组件包括:

- 卷积层(Convolutional Layer):提取图像的局部特征。

- 池化层(Pooling Layer):减少计算量,提高鲁棒性。

- 全连接层(Fully Connected Layer):最终进行分类或回归任务。

计算过程示例:

假设输入图像大小为 32x32x3(RGB 图像),经过多个卷积层、池化层和全连接层后,输出 10 维的向量(用于分类 10 个类别)。

1.2 典型应用

1️⃣ 计算机视觉

- 图像分类(Image Classification):常用 CNN 处理 猫狗分类、手写数字识别 (MNIST)、人脸识别 等任务。

- 目标检测(Object Detection):如 YOLO、Faster R-CNN 进行目标识别和定位。

- 图像分割(Semantic Segmentation):如 U-Net、Mask R-CNN 在医学影像和自动驾驶中应用。

2️⃣ 医疗诊断

- 癌症检测:CNN 可用于 X 光、CT、MRI 图像的自动分析,提高医生诊断效率。

- 皮肤病分类:使用 CNN 识别皮肤癌、湿疹等疾病。

3️⃣ 自动驾驶

- 道路场景分析:CNN 结合 激光雷达数据,用于检测行人、车辆、交通标志。

2. Transformer

2.1 原理

Transformer 是**自然语言处理(NLP)**领域的核心模型,解决了 RNN 不能并行计算的缺点。核心组件包括:

- 自注意力机制(Self-Attention):计算输入序列中每个单词与其他单词的重要性。

- 多头注意力(Multi-Head Attention):多个注意力机制并行,提高建模能力。

- 位置编码(Positional Encoding):弥补 Transformer 无法识别序列顺序的问题。

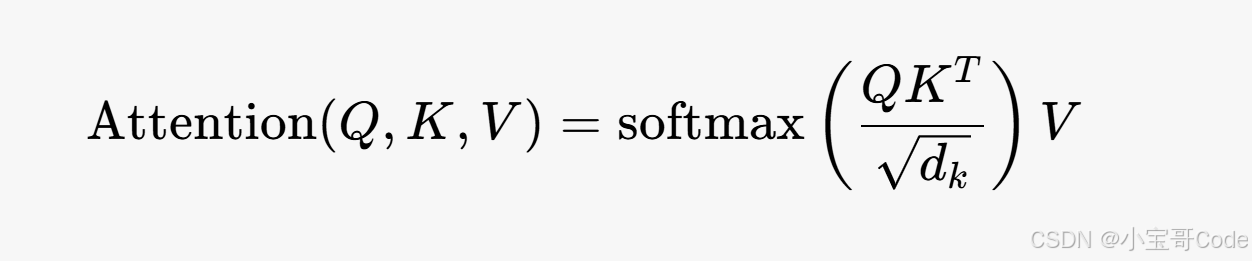

公式示例:

2.2 典型应用

1️⃣ 机器翻译

- Google Translate 采用 Transformer 进行多语言翻译,大幅提升翻译质量。

2️⃣ 语音识别

- Whisper(OpenAI):基于 Transformer 进行 语音转文字(ASR) 任务。

3️⃣ 代码自动补全

- GitHub Copilot 使用 Transformer 预测代码片段,提高开发效率。

3. BERT(Bidirectional Encoder Representations from Transformers)

3.1 原理

BERT 基于 Transformer,采用双向编码,能够理解上下文含义。核心技术包括:

- Masked Language Model(MLM):随机遮盖部分单词,让模型预测缺失部分。

- Next Sentence Prediction(NSP):判断两句话是否有逻辑关系。

训练过程:

- 预训练:在大规模语料库(如 Wikipedia)上训练通用语言模型。

- 迁移学习:微调 BERT 进行特定 NLP 任务(如情感分析、问答系统)。

3.2 典型应用

1️⃣ 搜索引擎

- Google Search 采用 BERT 解析用户查询,提高搜索结果的相关性。

2️⃣ 智能客服

- 银行、企业客服机器人 采用 BERT 解析用户问题,提供准确答案。

3️⃣ 文本摘要

- 新闻自动摘要:BERT 生成文章摘要,提高信息获取效率。

4. 循环神经网络(RNN)

4.1 原理

RNN 适用于处理时序数据,能够建模序列依赖关系。核心组件:

- 隐藏状态(Hidden State):存储过去的信息。

- LSTM(长短时记忆网络) 和 GRU(门控循环单元) 解决 RNN 长期依赖问题。

计算公式示例:

4.2 典型应用

1️⃣ 语音识别

- Siri、Google Assistant 采用 RNN 进行语音转文字。

2️⃣ 股票预测

- 金融数据分析,RNN 预测股票价格趋势。

3️⃣ 机器翻译

- RNN 被用于 早期的 Google Translate,但已被 Transformer 取代。

5. 生成对抗网络(GAN)

5.1 原理

GAN 由 生成器(Generator) 和 判别器(Discriminator) 组成:

- 生成器:学习生成逼真的数据(如假人脸)。

- 判别器:区分真假数据,指导生成器改进。

损失函数(对抗损失):

5.2 典型应用

1️⃣ 图像生成

- DeepFake:GAN 生成虚拟人脸,应用于换脸技术。

- StyleGAN:生成动漫、艺术风格的图像。

2️⃣ 数据增强

- 医学图像增强:GAN 生成更多训练样本,提高模型鲁棒性。

3️⃣ 超分辨率

- SRGAN:提高低分辨率图像的清晰度。

6. 深度学习模型应用场景总结

| 模型 | 核心机制 | 主要应用 |

|---|---|---|

| CNN | 卷积运算 | 图像分类、目标检测、医学影像分析 |

| Transformer | 自注意力机制 | 机器翻译、语音识别、代码补全 |

| BERT | 预训练 + 微调 | 搜索引擎、智能客服、文本摘要 |

| RNN | 时序建模 | 语音识别、股票预测、机器翻译 |

| GAN | 生成对抗训练 | 图像生成、数据增强、超分辨率 |

7. 未来发展趋势

- 跨模态 AI:结合 CNN + Transformer 进行多模态数据处理(如 OpenAI CLIP)。

- 自监督学习:减少对标注数据的依赖,提高模型泛化能力。

- 边缘 AI:优化神经网络,使其能在移动设备上高效运行。

深度学习模型正在推动智能制造、智慧医疗、自动驾驶、金融风控等行业变革,未来将更加智能化和高效。

深度学习模型应用场景全解析(进阶篇)

在前面的内容中,我们详细解析了 CNN、Transformer、BERT、RNN 和 GAN 的核心原理及应用场景。接下来,我们将深入探讨深度学习的最新进展,并介绍下一代 AI 模型及其应用,包括:

- Diffusion Models(扩散模型)

- NeRF(神经辐射场)

- Graph Neural Networks(GNN,图神经网络)

- Large Language Models(LLMs,大语言模型)

- Multimodal AI(多模态 AI)

这些新模型在 文本生成、图像合成、3D 建模、推荐系统、自动驾驶 等领域发挥着重要作用。

1. 扩散模型(Diffusion Models)

1.1 原理

扩散模型(Diffusion Models)是一种用于图像生成和合成的深度学习模型,核心思想借鉴了热扩散过程:

- 前向扩散(Forward Process):逐步向图像添加噪声,使其变成随机噪声。

- 反向扩散(Reverse Process):训练神经网络从噪声中逐步恢复原始图像。

数学公式表示:

其中,β_t 是噪声的变化率。

1.2 典型应用

1️⃣ 文本生成图像

- Stable Diffusion、DALL·E 2、Midjourney:根据文本描述生成高质量图像,如:

复制

"A futuristic city at sunset with flying cars."

2️⃣ 图像修复

- Inpainting:修复缺失或损坏的图像区域,应用于老照片修复、电影特效。

3️⃣ 超分辨率

- 生成高分辨率图像,用于医学影像增强、卫星图像处理。

2. 神经辐射场(NeRF,Neural Radiance Fields)

2.1 原理

NeRF 使用神经网络学习 3D 场景的光照和颜色信息,并可以从不同视角渲染高质量图像。

核心步骤:

- 输入 3D 坐标 (x, y, z) 和视角 (θ, φ)。

- MLP 预测该点的 RGB 颜色和密度。

- 体渲染算法(Volume Rendering) 计算最终的 2D 视图。

公式:

其中:

- σ 代表体积密度(决定光线是否透过)。

- c 代表颜色(RGB 值)。

2.2 典型应用

1️⃣ 3D 重建

- Google 用 NeRF 生成真实感极强的 3D 场景,应用于虚拟现实(VR)、增强现实(AR)。

2️⃣ 影视特效

- 电影制作中,NeRF 可用于生成高质量 3D 环境,替代传统 CGI。

3️⃣ 自动驾驶

- 通过 NeRF 生成高清道路环境,用于模拟训练自动驾驶系统。

3. 图神经网络(GNN,Graph Neural Networks)

3.1 原理

GNN 适用于非欧几里得数据,如社交网络、分子结构、知识图谱。它利用节点(Node)和边(Edge) 结构建模数据。

核心机制:

- 消息传递(Message Passing):节点与邻居交换信息,更新自身状态。

- 图卷积(Graph Convolution):类似 CNN,但用于图结构数据。

公式:

其中:

- h_v:节点 v 的特征。

- N(v):节点 v 的邻居。

3.2 典型应用

1️⃣ 推荐系统

- Pinterest、TikTok、阿里巴巴 使用 GNN 进行个性化推荐,提高商品匹配度。

2️⃣ 药物发现

- 预测分子结构的活性,加速新药研发。

3️⃣ 社交网络分析

- Facebook、Twitter 采用 GNN 进行社交关系预测,识别虚假账号。

4. 大语言模型(LLMs,Large Language Models)

4.1 原理

大语言模型(LLMs)基于 Transformer,通过 大规模语料训练,具备自然语言理解、文本生成能力。

核心技术:

- 自回归模型(如 GPT-4):逐步生成文本。

- 自编码模型(如 BERT):理解上下文,提高搜索理解能力。

- 指令微调(Instruction Tuning):优化模型,使其更符合人类需求。

4.2 典型应用

1️⃣ 智能对话

- ChatGPT 可进行人机对话、写作辅助、代码生成。

2️⃣ 机器翻译

- DeepL、Google Translate 基于 Transformer 进行高质量翻译。

3️⃣ 代码自动补全

- GitHub Copilot 预测代码,提高开发效率。

5. 多模态 AI(Multimodal AI)

5.1 原理

多模态 AI 结合文本、图像、语音等多种数据形式进行学习。

关键技术:

- CLIP(Contrastive Language-Image Pretraining):关联文本和图像,提高理解能力。

- Flamingo(DeepMind):同时处理文本和图像,支持复杂任务。

5.2 典型应用

1️⃣ 视觉问答(VQA)

- ChatGPT-4V 结合文本与图像,支持看图回答问题。

2️⃣ 医疗诊断

- 多模态 AI 可同时分析病历+医学影像,提高诊断准确度。

3️⃣ 自动驾驶

- 特斯拉 FSD 结合摄像头、激光雷达、雷达数据,提升感知能力。

6. 未来发展趋势

| 技术 | 核心原理 | 主要应用 |

|---|---|---|

| 扩散模型 | 逐步去噪生成图像 | AI 艺术、医疗影像修复 |

| NeRF | 3D 场景渲染 | VR、自动驾驶 |

| GNN | 处理图结构数据 | 推荐系统、社交分析 |

| LLMs | 预训练 + 微调 | 智能对话、机器翻译 |

| 多模态 AI | 处理多种数据 | 视觉问答、自动驾驶 |

7. 结论

深度学习正在推动 AI 进入 多模态、可解释、通用智能(AGI) 时代。未来,随着 计算能力提升、数据驱动优化、新算法创新,AI 将广泛应用于医疗、金融、自动驾驶、智能制造等领域,加速产业智能化进程。

未来 AI 发展趋势与应用解析

在前面的内容中,我们深入探讨了 CNN、Transformer、BERT、RNN、GAN、Diffusion Models、NeRF、GNN、LLMs、Multimodal AI 等核心深度学习技术。接下来,我们将进一步分析 未来 AI 发展的关键趋势,包括:

- AIGC(AI 生成内容,Artificial Intelligence Generated Content)

- 自动化机器学习(AutoML)

- 强化学习(Reinforcement Learning, RL)

- 边缘 AI(Edge AI)

- 通用人工智能(AGI, Artificial General Intelligence)

- 量子计算 + AI

- 生物计算与 AI 结合

这些技术正在推动 AI 从任务特定系统向更智能、更高效、更通用的方向发展。

1. AIGC(AI 生成内容)

1.1 原理

AIGC(Artificial Intelligence Generated Content)指 AI 生成 文本、图像、音频、视频等内容,核心技术包括:

- Transformer(GPT-4, LLaMA)

- 扩散模型(Diffusion Models)

- GAN(生成对抗网络)

AIGC 通过 大规模数据训练 + 预训练模型 + 微调,能够生成高质量内容。

1.2 典型应用

1️⃣ 文本生成

- ChatGPT:写作辅助、摘要生成、代码生成。

- Claude、Gemini、Mistral:多模态 AI,支持文本+图像输入。

2️⃣ 图像生成

- Stable Diffusion、DALL·E 3、Midjourney:根据文本描述生成高清图像。

- AI 设计师:Adobe Firefly 结合 AI 进行艺术创作。

3️⃣ 音乐与视频生成

- Suno AI、Udio:AI 生成音乐。

- Runway AI:AI 生成短视频,用于广告、电影特效。

2. 自动化机器学习(AutoML)

2.1 原理

AutoML(Automated Machine Learning)通过 AI 进行 自动化特征工程、模型选择、超参数优化,降低 AI 研发门槛。

核心技术:

- 神经架构搜索(Neural Architecture Search, NAS):自动寻找最佳神经网络结构。

- 超参数优化(Bayesian Optimization, Hyperparameter Tuning)。

2.2 典型应用

1️⃣ 企业 AI

- Google AutoML 帮助企业快速构建 AI 模型。

- DataRobot 提供自动化机器学习平台。

2️⃣ 医疗 AI

- AI 发现新药:AutoML 结合生物计算优化药物设计。

3️⃣ 机器人学习

- AutoML 结合 强化学习(RL),加速机器人路径规划。

3. 强化学习(Reinforcement Learning, RL)

3.1 原理

强化学习是 AI 在 探索环境、学习策略、最大化奖励 的过程中进行优化的技术。

核心算法:

- Q-Learning(离线 RL)

- 深度强化学习(Deep Q-Network, DQN)

- 策略优化(PPO, A3C)

3.2 典型应用

1️⃣ 游戏 AI

- AlphaGo(DeepMind):击败围棋世界冠军。

- OpenAI Five:在 Dota 2 电子竞技中击败人类玩家。

2️⃣ 自动驾驶

- 特斯拉 FSD 使用 RL 进行自动驾驶策略优化。

3️⃣ 机器人学习

- 波士顿动力(Boston Dynamics) 训练 AI 机器人自主行走、跳跃、搬运物体。

4. 边缘 AI(Edge AI)

4.1 原理

边缘 AI 指 AI 在本地设备(如智能手机、无人机、自动驾驶汽车)上运行,而无需云计算。

核心技术:

- 模型压缩(Model Compression)

- 量化(Quantization)

- TinyML(超小型 AI 模型)

4.2 典型应用

1️⃣ 智能手机

- 苹果 iPhone 采用 Neural Engine 运行 AI 任务(如人脸识别、语音助手)。

- 安卓端 AI 加速(Google Tensor, Qualcomm AI Engine)。

2️⃣ 物联网(IoT)

- 智能家居(Amazon Alexa, Google Nest) 运行本地 AI 语音识别。

3️⃣ 无人机

- DJI 大疆 采用 边缘 AI 进行目标识别,提高飞行安全性。

5. 通用人工智能(AGI)

5.1 原理

AGI(Artificial General Intelligence)指 AI 能够像人类一样进行自主思考、学习和适应新任务,而不是仅限于特定任务。

核心技术:

- 自我监督学习(Self-Supervised Learning)

- 元学习(Meta-Learning)

- 多模态 AI(Multimodal AI)

5.2 典型应用

1️⃣ 自主 AI 助手

- GPT-5 及未来 AI 版本 可能具备更强的推理能力,自主解决复杂问题。

2️⃣ 机器人

- 特斯拉 Optimus 机器人 目标是通用 AI 助手。

3️⃣ 人工智能科学家

- DeepMind AlphaFold 预测蛋白质结构,推动生物研究。

6. 量子计算 + AI

6.1 原理

量子计算(Quantum Computing)结合 AI,利用 量子并行计算 加速 AI 训练和优化。

核心概念:

- 量子神经网络(Quantum Neural Networks, QNN)

- 量子强化学习(Quantum RL)

6.2 典型应用

1️⃣ 金融 AI

- 量子 AI 预测股票市场趋势,提高交易策略优化。

2️⃣ 药物研发

- 量子计算加速 DNA 分析、蛋白质折叠模拟。

7. 生物计算与 AI 结合

7.1 原理

生物计算(Biocomputing)结合 AI,利用 DNA 计算、神经形态计算 提高计算效率。

7.2 典型应用

1️⃣ DNA 计算

- 微软 DNA 存储项目 研究 AI 如何利用 DNA 存储大规模数据。

2️⃣ 脑-机接口

- Neuralink(马斯克公司) 研究用 AI 读取人脑信号,实现大脑与计算机交互。

8. 未来 AI 发展趋势总结

| 技术方向 | 核心原理 | 应用案例 |

|---|---|---|

| AIGC | AI 生成文本、图像、音乐 | ChatGPT, Midjourney, Stable Diffusion |

| AutoML | 自动化机器学习 | Google AutoML, DataRobot |

| 强化学习 | 训练 AI 进行决策 | AlphaGo, OpenAI Five, 自动驾驶 |

| 边缘 AI | 本地 AI 计算 | iPhone Neural Engine, DJI 无人机 |

| AGI | 通用人工智能 | GPT-5, 未来 AI 机器人 |

| 量子 AI | 量子计算加速 AI | 量子金融, 药物研发 |

| 生物计算 | DNA 存储, 脑机接口 | Neuralink, DNA 计算 |

9. 结论

AI 正在向 更智能、更快速、更高效 方向发展,未来可能实现 真正的通用人工智能(AGI),并与 量子计算、生物计算、脑机接口 等技术深度融合,彻底改变人类社会。

1898

1898

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?