我们平时使用的ChatGPT、kimi、豆包等Ai对话工具,其服务器都是部署在各家公司的机房里,如果我们有一些隐私数据发到对话中,很难保证信息是否安全等问题,如何在保证数据安全的情况下,又可以使用大预言模型,Ollma(哦拉玛)可以告诉你答案!

这是一个保姆级的教程,从下载到成功运行Qwen2.5大模型,更适合没有玩过Ollma的小白宝宝哦~

文章目录

- 1. Ollma 是什么?

- 2. 安装教程

- 2.1 首先去官网下载

- 2.2 下载好之后安装

- 2.3 测试一下

- 3. 导入开源Qwen 2.5 - 0.5B 大模型

- 3.1 去模型仓库搜索模型

- 3.2 加载模型

- 3.3 使用模型

- 4. 部署webUI可视化对话

1. Ollma 是什么?

一句话介绍:一个可以让你在本地启动并运行大型语言模型的工具!

Ollma是一个开源的大模型服务工具,他可以让你在一行代码不写的情况下,在本地通过一条命令即可运行大模型。

Ollma会根据电脑配置,自动选择用CPU还是GPU运行,如果你的电脑没有GPU,会直接使用CPU进行运行(可能有点慢)

2. 安装教程

Ollma官网:[https://ollama.com/]

模型仓库:[https://ollama.com/library]

2.1 首先去官网下载

从主页点击下载,直接跳转到了当前系统所兼容的下载界面,点击download,一键下载

2.2 下载好之后安装

博主的电脑是Mac,下载好之后,直接把压缩包解压,然后移动到应用程序中即可,其他操作系统,参考这个文档:

下载好之后,打开,当这个帅气的小羊驼显示在你的任务栏中的时候,说明已经启动成功了!

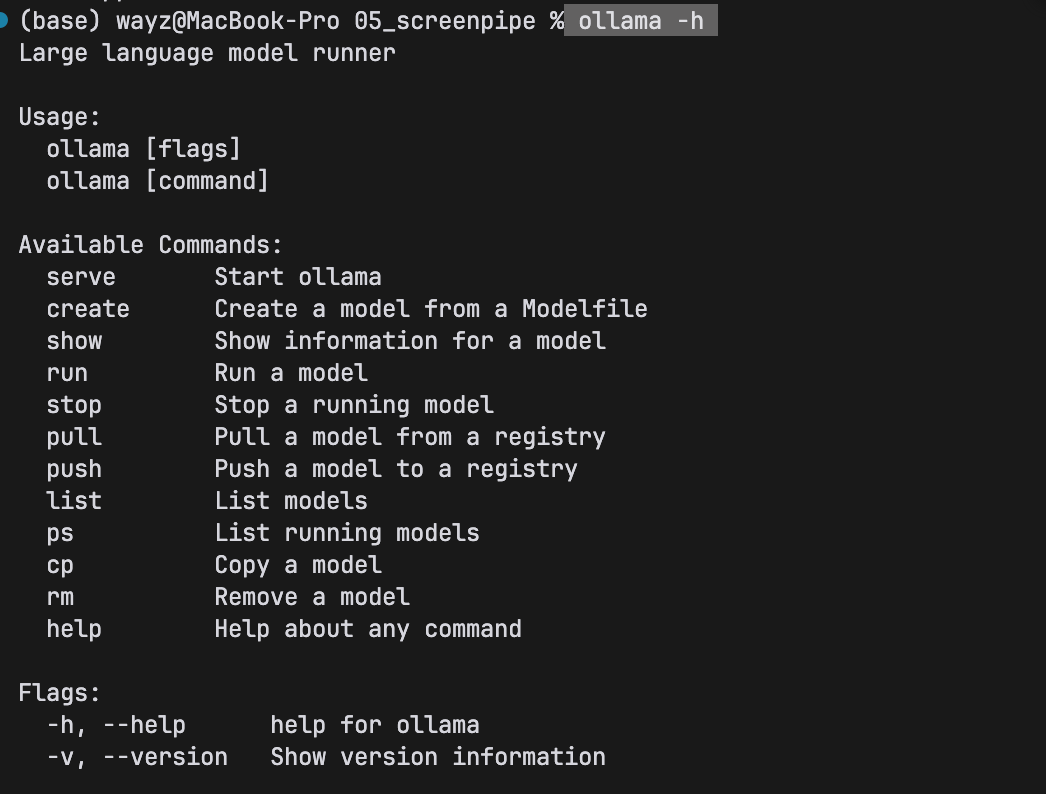

2.3 测试一下

打开命令行,输入ollama -h看到以下界面,就可以进行下一步,操作了~

3. 导入开源Qwen 2.5 - 0.5B 大模型

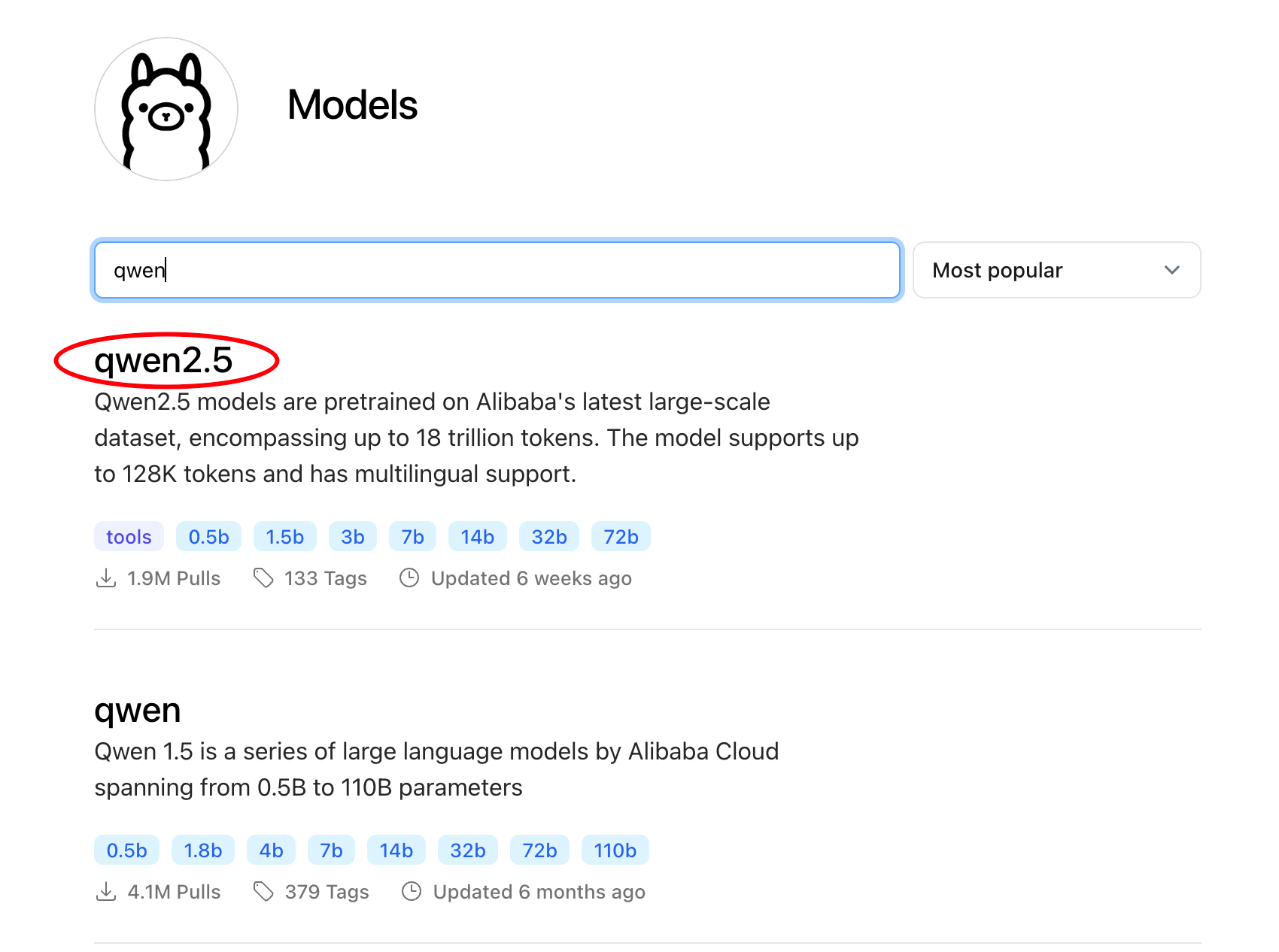

3.1 去模型仓库搜索模型

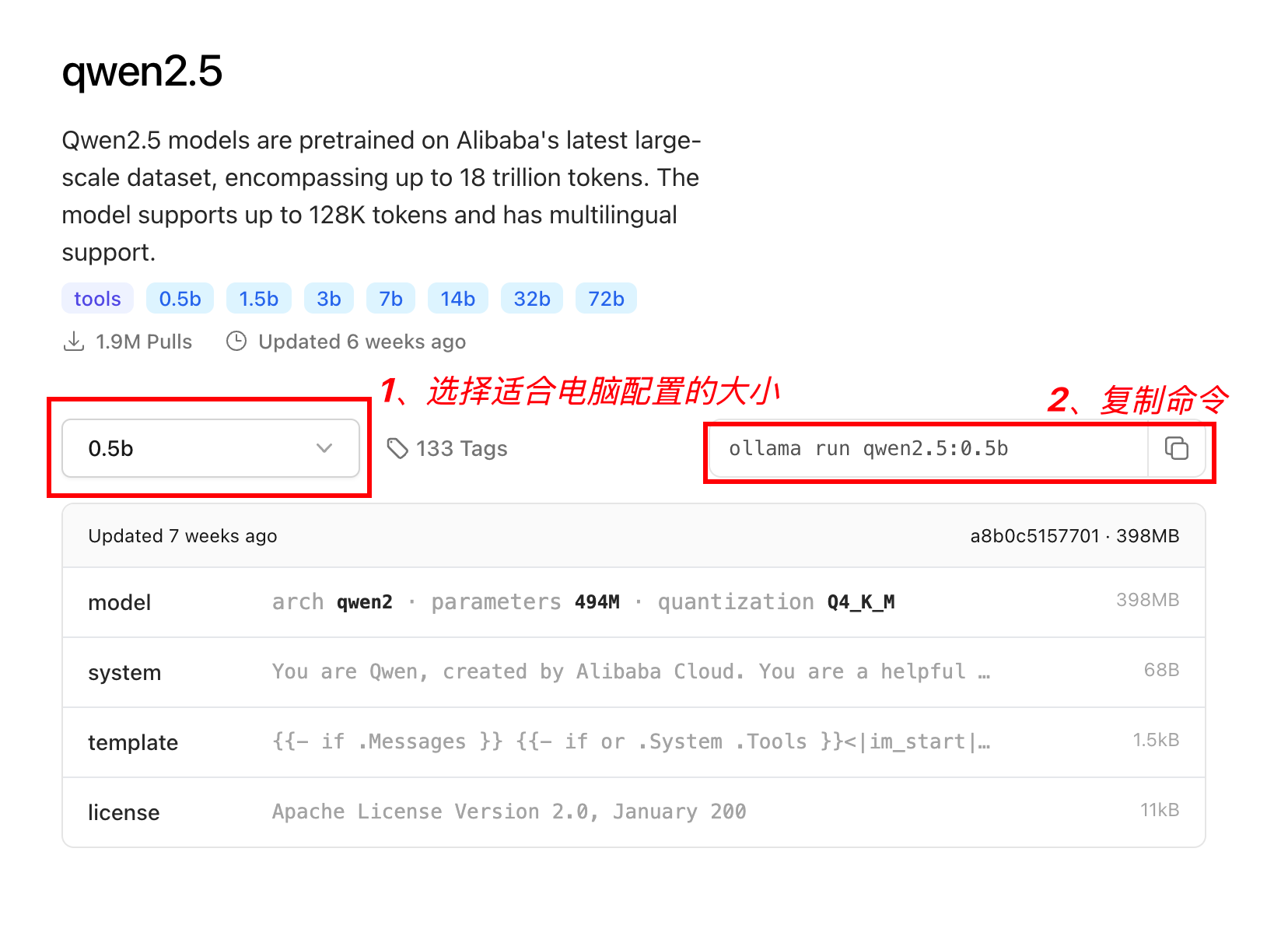

我们在上面提到的Ollma模型仓库中找到最新的千问大模型

点进去,界面如下:

3.2 加载模型

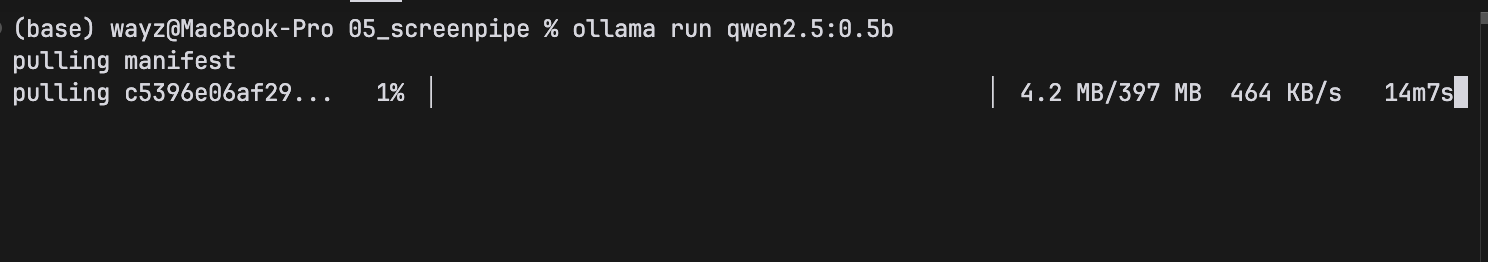

将上面的命令复制到命令行,回车执行!等待下载

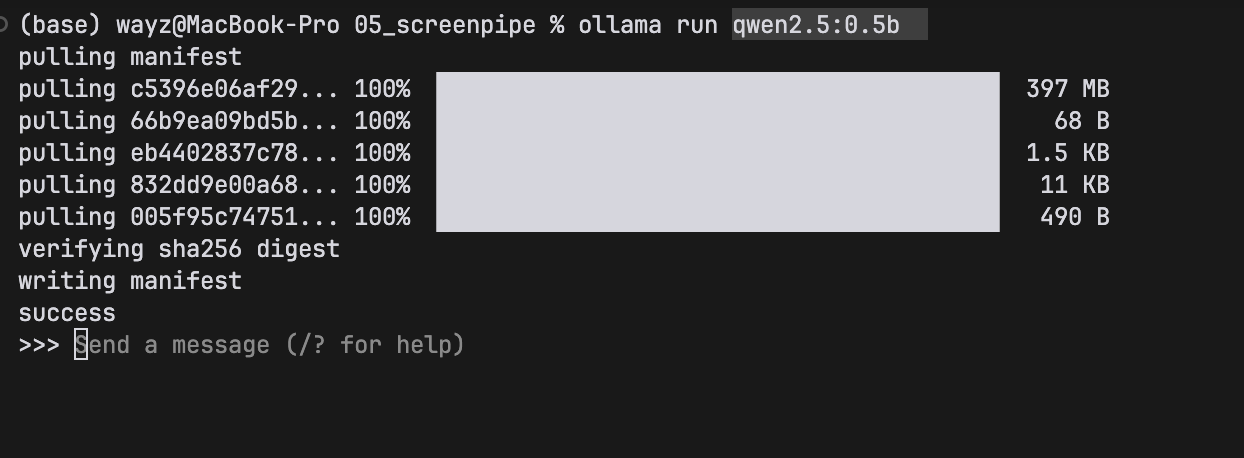

等进度100%了,即可使用模型

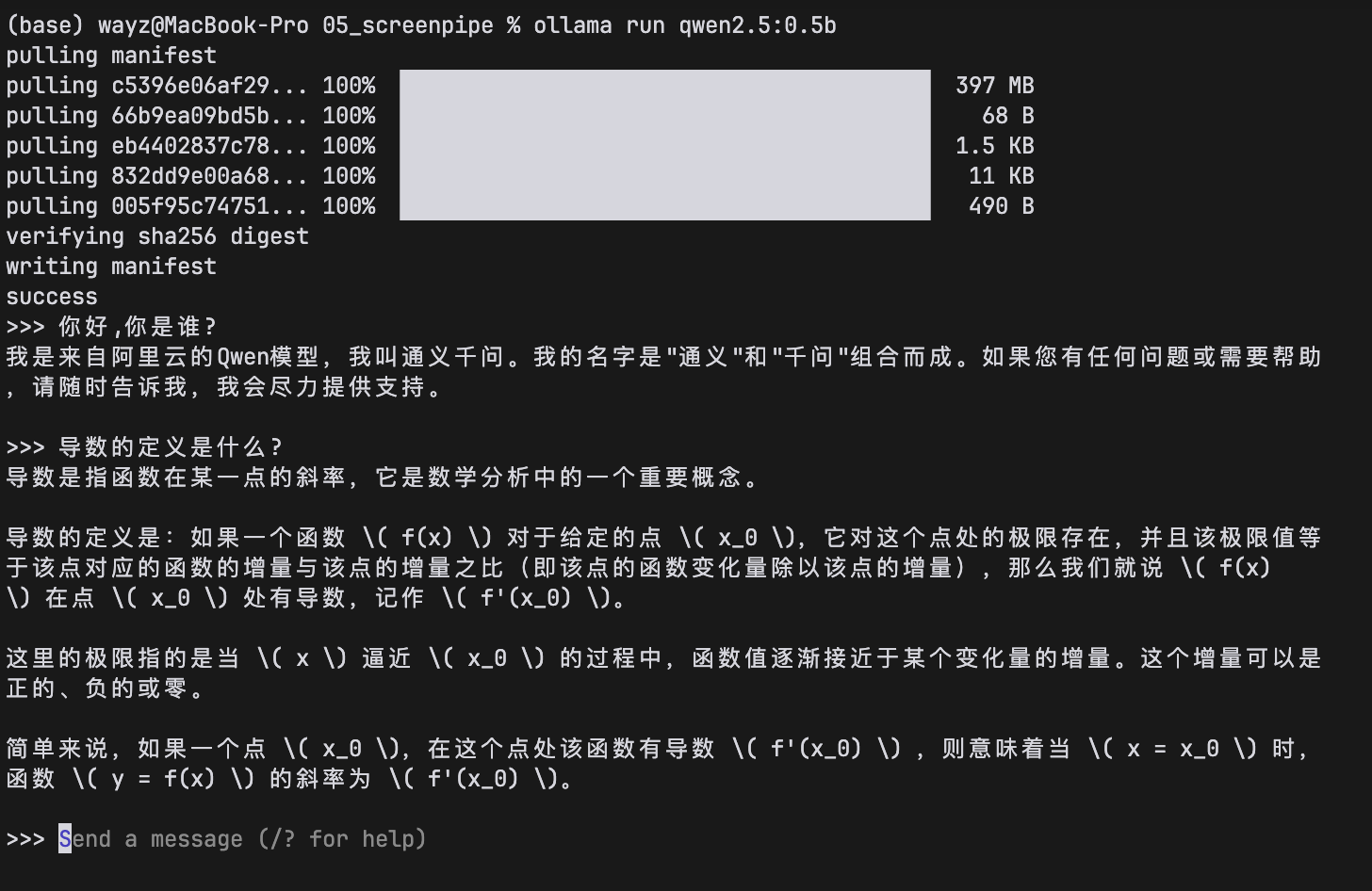

3.3 使用模型

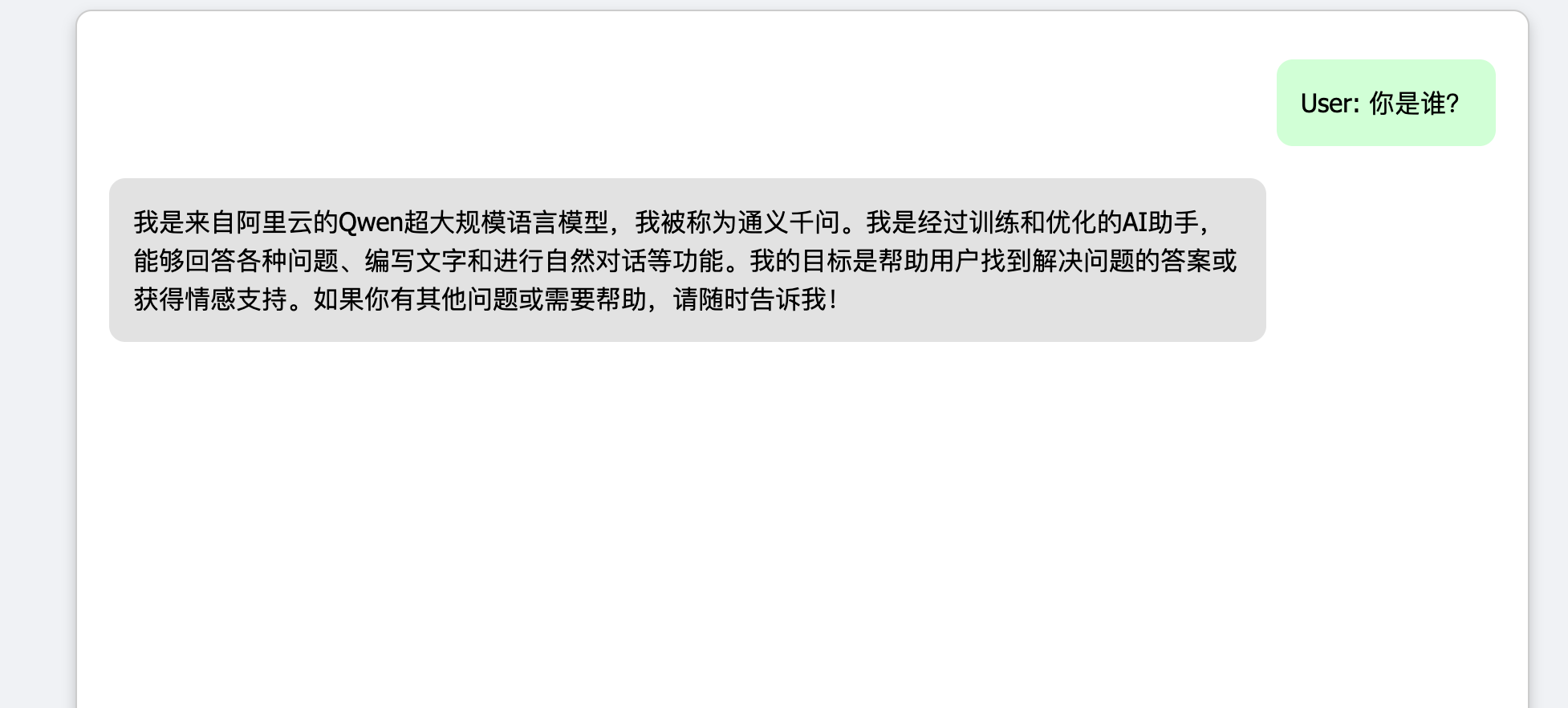

在命令行中,即可开启与千问大模型的对话,看到这里,是不是感觉很简单,快去点个赞!

输入/bye方可结束对话。

都看到这里了,点个赞再走吧!码字实属不易呀。

4. 部署webUI可视化对话

本文使用FastAPI 部署Ollma可视化页面,简单4步即可

1、克隆仓库

克隆完成进入目标目录:

2、安装依赖

3、修改app.py 代码

输入vim websocket_handler.py命令(确保你在fastapi_chat_app目录下先)更改model代码

4、运行模型

输入命令:

浏览器打开:[http://127.0.0.1:8000]

即可开始对话:

点个赞再走吧!

3842

3842

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?