Datawhale论文

联合组织:OpenMMLab、极市平台

热门方向新工作层出不穷,Arxiv每日新论文浩如烟海。只读paper还是太单调了,不如来听大佬们面对面详解顶会工作!

网络一线牵!OpenMMLab 与极市平台一起,发起了本次「CVPR2024论文分享会」,我们邀请了 7 位在 CVPR 2024 中稿的技术大咖们,来分享他们的优秀工作。诚邀各位小伙伴们一同参与,直接与领域的优秀学者们交流学习、相互探讨,进行思想碰撞!

直播详情

时间:2024年6月15日(本周六)15:00

直播预约:

欢迎加入社群交流:

观看直播即可参与抽奖:

01

InternVL: Scaling up Vision Foundation Models and Aligning for Generic Visual-Linguistic Tasks

论文地址:https://arxiv.org/abs/2312.14238

代码地址:

https://github.com/OpenGVLab/InternVL

分享背景:随着人工智能生成内容(AIGC)的快速发展,多模态大型语言模型(MLLM)在理解和生成结合视觉与语言的信息方面展现出巨大潜力。然而,现有的开源MLLM与商业模型之间存在性能差距。为了应对这一挑战,书生图像大模型InternVL 1.0模型作为早期的开源尝试,通过将视觉基础模型扩展到6亿参数,并与大型语言模型进行对齐,为缩小这一差距奠定了基础。

在1.0模型的基础上,InternVL 1.5引入了三项创新设计,进一步提升了模型的性能:(1)强大的视觉编码器:通过连续学习策略,InternViT-6B模型的视觉理解能力得到了显著提升,使其能够在不同的大型语言模型中进行迁移和重用。(2)动态高分辨率:InternVL 1.5能够根据输入图像的宽高比和分辨率,将图像动态划分为不同数量的448×448图像块,最高支持4K分辨率的输入,这为处理高分辨率图像提供了更高的灵活性和效率。(3)高质量双语数据集:研究团队精心构建了一个覆盖常见场景和文档图像的高质量双语数据集,并用英语和中文进行了问答对标注,显著增强了模型在OCR和中文相关任务中的性能。这些创新使得InternVL 1.5在多模态任务中的性能得到了显著提升,有效地缩小了开源模型与商业模型之间的性能差距。

在本次分享中,将全面介绍最新的书生图像大模型InternVL系列模型,包括InternVL 1.0和1.5。讨论1.0版本在视觉基础模型以及多模态大型语言模型(MLLM)领域的初步探索和所取得的进展。重点介绍1.5版本的核心改进,如视觉编码器的连续学习策略、动态高分辨率处理以及高质量双语数据集的构建。此外,将展示这些改进如何推动模型在多模态任务上的性能提升,并探讨InternVL系列模型在AIGC领域的应用潜力和未来发展。

02

MVBench: A Comprehensive Multi-modal Video Understanding Benchmark

论文地址:https://arxiv.org/abs/2311.17005

代码地址:

https://github.com/OpenGVLab/Ask-Anything/tree/main/video_chat2

分享背景:近年来,多模态大型语言模型(MLLMs)取得了快速发展,涌现出许多诊断基准来评估这些模型的理解能力。然而,大多数基准主要评估静态图像任务中的空间理解,而忽略了动态视频任务中的时间理解。为了解决这个问题,我们引入了MVBench,一个全面的多模态视频理解基准。MVBench 包含 20 个具有挑战性的视频任务,这些任务无法通过单帧有效解决。MVBench 的创新之处在于:静态到动态的转换方法:我们引入了一种新颖的静态到动态方法来定义这些与时间相关的任务。通过将各种静态任务转换为动态任务,我们能够系统地生成需要广泛时间技能的视频任务,涵盖从感知到认知的各个方面。自动生成多选题:基于任务定义,我们自动将公开的视频注释转换为多选题,以评估每个任务。这种独特的范式一方面可以高效地构建 MVBench,无需太多人工干预;另一方面,它可以保证评估的公平性,避免LLM的偏向评分。同时,我们开发了一个强大的视频 MLLM 基线,即 VideoChat2,通过使用各种指令微调数据进行渐进式多模态训练。

MVBench 的实验结果表明:现有的 MLLMs 在时间理解方面远远不够理想,而我们的 VideoChat2 在 MVBench 上比这些领先模型的性能高出 15% 以上。

这个分享旨在:

1.介绍 MVBench 的重要性和创新性。

2.展示 MVBench 如何帮助评估 MLLMs 的时间理解能力。

3.强调 VideoChat2 作为强大的视频 MLLM 基线。

4.鼓励研究人员使用 MVBench 进一步推动多模态视频理解领域的发展。

03

EgoExoLearn: A Dataset for Bridging Asynchronous Ego- and Exo-centric View of Procedural Activities in Real World

论文地址:https://arxiv.org/abs/2403.16182

代码地址:

https://github.com/OpenGVLab/EgoExoLearn

分享背景:在探索人工智能的边界时,我们时常惊叹于人类孩童的学习能力——他们是如何轻易地将他人的动作映射到自己的视角,进而模仿并创新的。为了赋予机器这种与生俱来的天赋,我们公布了跨视角技能学习数据集EgoExoLearn,旨在为机器人赋予通过观察他人学习新动作的能力。

EgoExoLearn数据集独辟蹊径,采集了第一视角与第三视角的视频素材。第一视角视频捕捉了人们学习第三视角演示动作的全过程,这种视角的转换与融合,为机器模拟人类学习模式提供了宝贵的数据资源。

数据集的构建不仅涵盖了日常生活的琐碎场景,更延伸到了专业实验室的复杂操作。EgoExoLearn精心收录了总计120小时的视角与示范视频,旨在让机器在多种环境下都能有效学习。

除视频外,我们还记录了高质量的注视数据,并辅以详尽的多模态标注。这些数据与标注的结合,构建了一个全面模拟人类学习过程的平台,有助于解决机器在不同视角下对异步动作过程的建模难题。

为了全面评估EgoExoLearn数据集的价值,我们提出了一系列基准测试,如跨视角关联、跨视角行动规划及跨视角参考技能评估等,并进行了深入的分析。我们坚信,EgoExoLearn将成为跨视角行动桥接的重要基石,为机器人无缝学习真实世界中的人类行为提供坚实支撑。

展望未来,我们期待EgoExoLearn数据集能助力AI技术的进一步突破,推动机器人从单纯的模仿走向真正的智能,实现与人类社会的和谐共存与共同发展。

04

Scale Decoupled Distillation

论文地址:https://arxiv.org/abs/2403.13512

代码地址:

https://github.com/shicaiwei123/SDD-CVPR2024

分享背景:知识蒸馏是知识迁移和模型压缩的常见手段。其中基于响应的蒸馏因其在高效和普适的特点在近些年的研究中受到越来越多的关注。然而,与特征知识蒸馏相比,它的性能往往较差。在本次分享中,将主要介绍我们在这个方面上的探索工作,Scale Decoupled Distillation (CVPR2024). 其中我们揭示了经典基于响应蒸馏中多类别知识的耦合问题,该问题阻碍了学生从模糊样本中继承准确的语义信息。为此,我们提出了一种简单但有效的方法,即尺度解耦蒸馏,用于辅助基于响应知识蒸馏。该方法将全局响应输出解耦为多个局部响应输出并为它们建立蒸馏通道,帮助助学生网络挖掘和继承细粒度和无歧义的响应知识。此外,解耦后的知识可以进一步分为传输语义信息的一致项和和样本歧义的互补项。通过增加互补部分的权重,引导学生更多地关注模糊样本,提高学习效果。

05

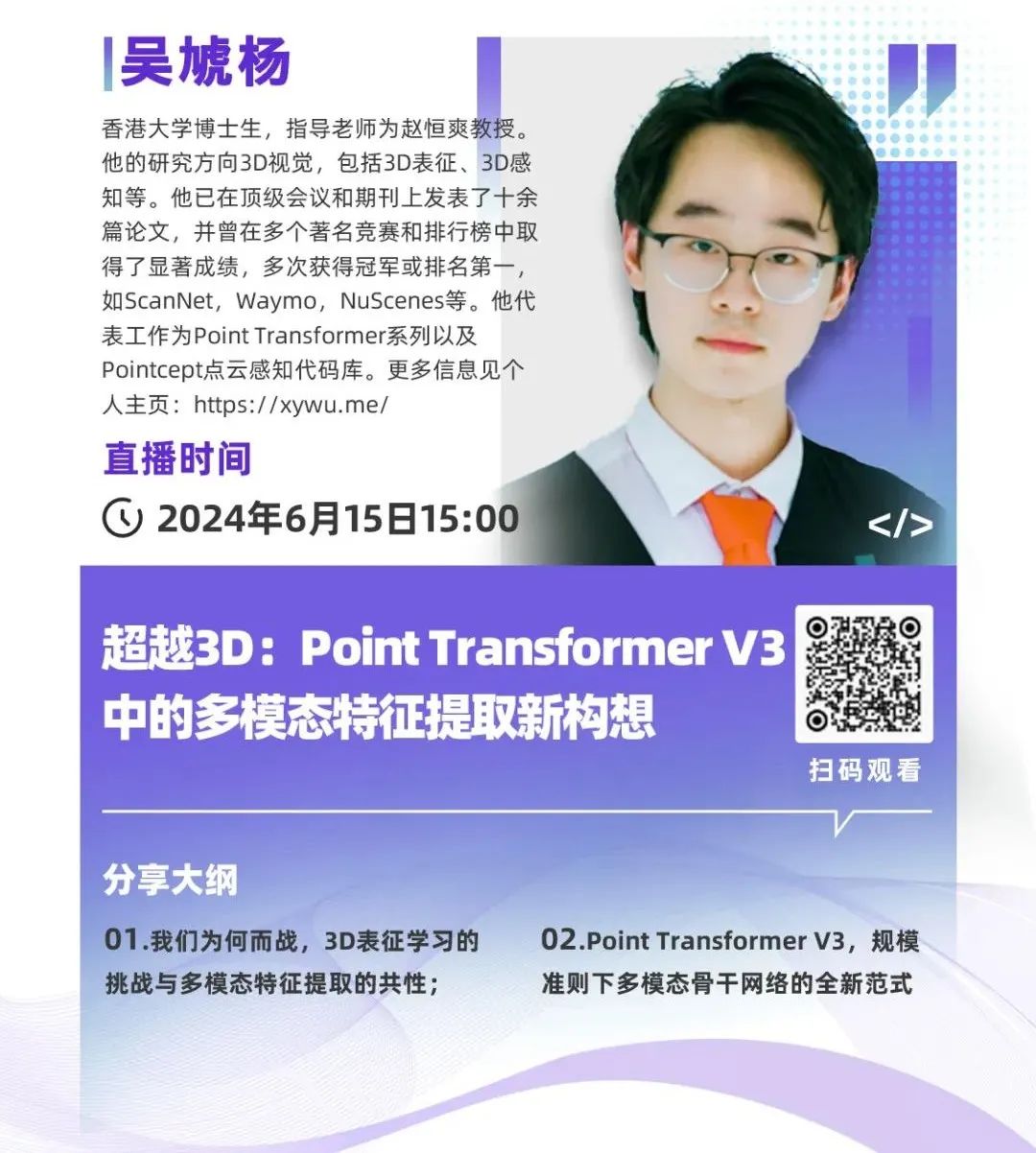

Point Transformer V3: Simpler, Faster, Stronger

论文地址:https://arxiv.org/abs/2312.10035

代码地址:https://github.com/Pointcept/Pointcept

分享背景:在本次的分享中,我们将从不局限于3D视觉的固有视角与论文的本身内容,去介绍我们这次被接收为CVPR 2024 Oral的工作,Point Transformer V3: Simpler, Faster, Stronge。点云作为高维稀疏无结构性数据的代表性数据集,处理其的骨干网络也具有扩展为其他模态的通用网络,例如将图像像素点视为点,点云网络同样可以处理图像数据,那么阻碍点云网络成为其他模态通用的特征提取器的限制与挑战是什么?本次的分享将带着这样的问题去分享PTv3的设计思想与实现形式,探究蕴含其中的多模态特征的可能性。

06

Language-driven All-in-one Adverse Weather Removal

论文地址:https://arxiv.org/abs/2312.01381

代码地址:https://github.com/noxsine/LDR

分享背景:图像恢复技术是计算机视觉领域的一项关键技术,其目的是从损坏或退化的图像中恢复出清晰图像,广泛应用于自动驾驶、户外监控和计算摄影等领域。为了应对不同的天气条件,多合一框架将自适应地学习针对不同退化的特定天气知识,并共享针对共同模式的知识。然而,现有的方法要么依赖于额外的难以获取的天气类型输入,要么采用固定的网络结构,这限制了特定天气知识的多样性。因此,我们提出了一个语言驱动的恢复框架来缓解上述问题。首先,我们利用预先训练的视觉语言(PVL)模型的能力,通过对退化的发生、类型和严重程度进行推理来丰富特定于天气的知识的多样性,生成基于描述的退化先验。然后,在退化先验的指导下,基于混合专家(MOE)结构动态地从候选名单中稀疏地选择恢复专家。这使我们能够自适应地学习特定天气和共享的知识,以应对各种天气情况(例如,未知或混合天气)。在广泛的恢复场景上的实验表明,我们的方法具有优越的图像恢复性能和泛化能力。

07

LDP: Language-driven Dual-Pixel Image Defocus Deblurring Network

论文地址:https://arxiv.org/abs/2307.09815

代码地址:

https://github.com/noxsine/LDP

分享背景:全像素双核传感器将传统的图像传感器的每个像素一分为二,因而一次拍摄能够捕获两幅带有微小基线的图像对。当使用大光圈的时候,较浅的景深会使拍摄的图像会出现散焦模糊。从具有视差相关模糊的全像素双核图像对中恢复清晰图像是一项具有挑战性的任务。最近的一些方法使用模糊图来促进散焦模糊的去除,并取得了不错的结果。然而由于缺乏模糊图的真值,使用网络估计准确的模糊图是困难的。因此,我们提出引入具有丰富语义知识的对比语言图像预训练框架(CLIP)来无监督地准确估计DP对的模糊图。具体来说,我们设计了一种新的将两张图像输入到CLIP中的模式,并用其估计全像素双核图像的模糊图。基于估计的模糊图,我们引入模糊先验注意块、模糊加权损失和模糊感知损失来恢复清晰图像。我们的方法在广泛的实验中获得了最先进的性能和良好的泛化性。

5066

5066

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?