阅读由来SCRDet++参考文献[22]【论文阅读】SCRDet++_dujuancao11的博客-CSDN博客

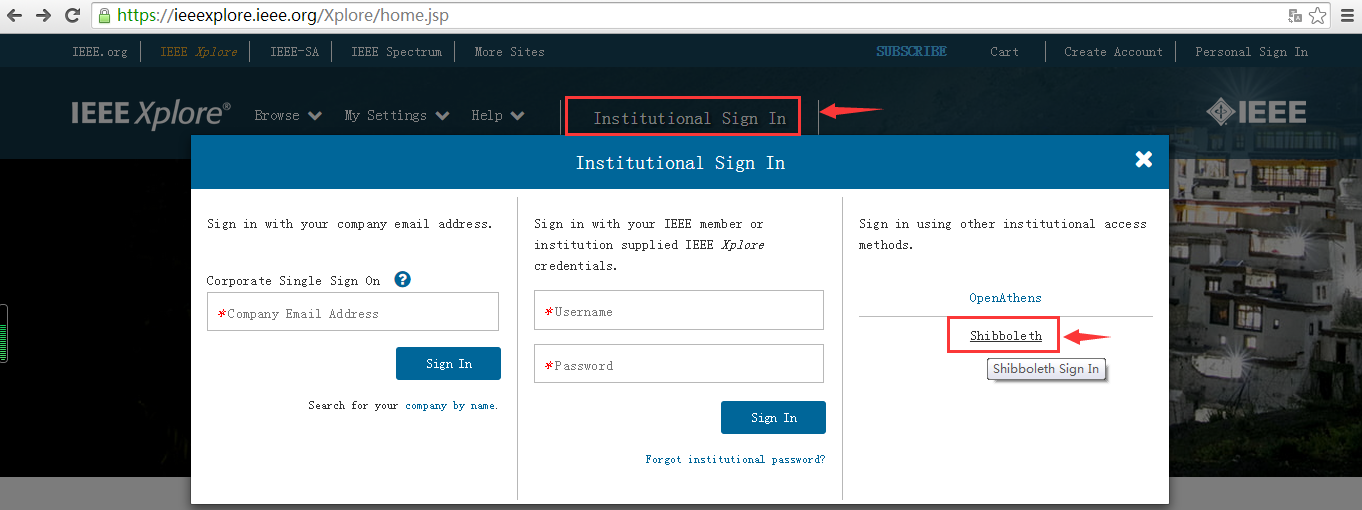

校外访问IEEE

目录

翻译部分

摘要

介绍

深度神经网络在图像分类、目标检测和语义分割等视觉相关任务中表现出卓越的性能。凭借这样的表现,深度学习技术已经开始应用于自动驾驶汽车、医疗保健人工智能等各个实践领域。然而,根据最近的一项研究,深度学习模型容易受到精心设计的输入扰动的影响。这些扰动很难通过人眼检测到,因此人类仍然可以正确理解物体。但是深度神经网络可以产生与我们预期完全不同的结果。对手甚至可以按照他们想要的方式进行扰动。例如,他们可以更改图像,以便深度神经网络将其错误分类为他们设置的错误目标。[8]、[10]、[23]。

这种受干扰的图像称为对抗性示例或对抗性攻击。它是通过使用受害者模型的参数和损失函数生成的。由于它需要模型的信息,因此称为白盒攻击。但是在无法访问模型的情况下,由于称为可转移性的属性,仍然可以创建对抗性示例。它允许对这种情况进行攻击,称为黑盒攻击。即,从特定模型生成的对抗性示例也适用于其他模型。

图1:语义分割中的对抗性攻击

众所周知,对抗性攻击在类似任务中效果更好。例如,对特定神经网络的对抗性攻击可以欺骗具有不同架构的其他神经网络[18]。有了这个可转移的特征,对手可以更容易地欺骗不同的模型。

许多研究试图生成更强的对抗样本来攻击最先进的模型[2]、[17]、[20]。针对这一点,已经出现了一些研究方法来制作针对对抗性攻击的稳健模型[15],[21]。在图像分类领域也有涉及对抗性攻击和防御的竞赛[14]。提出了几种攻击和防御方法。但是,对抗性示例中涉及的许多攻击和防御都仅限于图像分类问题。虽然有处理语义分割和对象检测的相关工作[16],[26], [29],只解决了攻击场景,对语义分割等复杂任务的防御场景的研究不足。此外,对于分类任务的防御模型,他们通常使用分辨率较小的简单数据集,如 MNIST、CIFAR 10。因此,由于在现实世界中使用更复杂的图像,因此需要对具有大分辨率的图像进行试验。另外,我们需要研究语义分割的防御场景,因为它更实用。例如,在自动驾驶汽车或医疗智能中,大部分场景理解是通过语义分割而不是分类来完成的。

在本文中,我们旨在提供强大的机制来保护语义分割模型免受对抗性攻击为此,我们提出了 DAPAS,一种去噪自动编码器,以防止语义分割中的对抗性攻击,可有效消除对抗性扰动。由于语义分割涉及像素的分类,因此在像素级别还原原始图像很重要,以便还原的图像给出正确的语义分割结果。我们使用遵循特定分布的随机噪声。我们使用高斯分布、均匀分布和双峰分布。对抗性攻击会轻微改变输入×的像素值,随机噪声可以覆盖多种攻击方法。对于数据集,我们使用 PASCAL VOC 2012 [7]并在 DeepLab V3 Plus 上对其进行测试[4]它拥有语义分割任务领域最先进的模型之一。我们首先生成 DeepLab V3 Plus 的对抗性示例,并验证我们的方法对对抗语义分割的对抗性攻击有效。因此,与原始模型 DeepLab V3 Plus 相比,我们提出的模型在干净图像上的性能约为 97%。在对抗性攻击的情况下,DeepLab V3 Plus 的性能下降到原始性能的 13% 左右,但是当它通过我们的降噪自动编码器时,它与原始性能相比覆盖了 68%。因此,我们提出的方法证实了攻击得到了有效防御,同时最大限度地减少了性能下降。此外,我们不必重新训练分割模型。我们保留我们想要捍卫的模型。其余部分内容如下。我们在第 2 节中展示了对相关工作的全面回顾。我们在第 3 节中解释了我们的方法并展示了我们的架构。在第 4 节中,我们使用对抗性示例评估我们的防御方法。第5节提供了结论和讨论。

相关工作

塞格迪等人。发现扰动的存在破坏了分类器[25]。本文提出了一种简单有效的攻击,称为快速梯度符号方法(FGSM)[11]。它表明小的扰动足以欺骗分类器。[17]衡量攻击所需的最小规模。他们通过计算足够的扰动幅度,对对抗样本的存在给出了更好的直觉。[24]设置了更多极其有限的场景。他们表明,仅修改图像的一个像素就会降低性能。[19]研究对手不知道深度学习模型的场景,称为黑盒场景。这项研究表明,即使对手没有关于深度学习模型的详细信息,他们也可以进行攻击。除了分类问题,[16]、[29]展示了对分割模型和对象检测任务的对抗性攻击。并且[1]实验并分析了对抗性攻击对 DeepLab V2 [3]和 PSPNet [30]等各种语义分割模型的影响。除了理论方面,一些论文[9] , [23] 表明在现实世界中存在对抗样本。

为了对抗对抗性攻击,一些作品用一个干净的例子和对抗性例子训练模型,这被称为对抗性训练[11],[13],[25],[27]。在训练过程中,他们会为训练产生对抗性。虽然它有效,但它取决于训练过程中使用的特定对抗性数据。例如,[13]表明他们的方法在简单攻击中是稳健的,但在更复杂的攻击中则不然。此外,它具有工程惩罚,因为它需要重新训练模型。如果创建对抗性示例需要更长的时间,则重新训练模型将需要更多时间。因此,使用更复杂的算法来生成对抗样本是一种负担。除了使用数据增强之外,还提出了改变模型本身的方法[5]、[6]。他们改变问题的目标函数以获得鲁棒性。但是,这种方法还需要重新训练模型,因此需要花费时间。[15] , [22]在将图像放入模型之前对图像进行预处理。这些方法与我们的工作类似,但他们对像 MNIST 和 CIFAR 系列这样的小分辨率图像进行了实验。此外,这些工作只关注分类问题 。

目前还没有通用的对抗性攻击防御方法。此外,据我们所知,在对抗性攻击的上下文中没有语义分割的防御场景。我们验证了我们的方法对语义分割中的对抗性攻击是有效的。

对抗性攻击

基本上,所有攻击都使用与受害者模型的损失函数相关的数据梯度。在本节中,我们简要回顾了对抗性攻击的基本方法。

A. 快速梯度符号法 (FGSM)

FGSM 是由[11]提出的。是一种简单有效的攻击方法。(详细介绍略)

B. 迭代 FGSM (I-FGSM)

迭代 FGSM 是 FGSM 的重复版本。与 FGSM 相比,它是一种更强大的攻击方法。(详细介绍略)

我们在本文中表示该算法 I-FGSM。虽然这些攻击方法是在图像分类的上下文中引入的,但相同的方法可以应用于语义分割任务的上下文中。我们将第一种方法称为非定向 I-FGSM,将第二种方法称为定向 I-FGSM。我们在本文中使用非定向 FGSM 和非定向 I-FGSM。即,图像中的像素将被对抗性攻击随机错误分类。

方法

我们的机制不会修改语义分割模型。我们使用去噪自编码器作为预处理器,把它放在语义分割模型的前面。无论输入是否是对抗性示例,它都会在传递原始模型之前通过降噪自动编码器。因此,去噪自编码器除了去除扰动外,还应该很好地恢复干净的图像。在本节中,我们展示了降噪自动编码器的架构、训练设置的详细信息,并演示了如何在构建稳健的语义分割模型中部署降噪自动编码器。

A. 去噪自编码器的架构

模型整体结构如图2所示. 去噪自编码器分为两部分,橙色编码器部分和蓝色解码器部分。当编码器提取输入图像的特征时,解码器从提取的特征中恢复输入图像。编码器由五个卷积层组成,每个特征图的分辨率逐渐降低一半。我们没有使用最大池化或平均池化来降低特征图的分辨率。我们调整内核的步幅以降低分辨率。在解码器中,它也由五个反卷积层组成,每个特征图的分辨率扩大了两倍。并且我们使用跳过连接来恢复特征图的空间信息的细节。换句话说,编码器中使用的特征与解码器的特征对称链接。我们添加了具有相同分辨率的功能。这里我们没有通过跳过连接来连接第一个特征,即输入图像。由于输入图像具有噪声信息。对于激活函数,我们对每一层使用 ELU 而不是 RELU。我们使用 sigmoid 作为最后一个激活函数。

图2:去噪自编码器的架构

去噪自编码器分为两部分:橙色编码器部分和蓝色解码器部分。

- 编码器提取输入图像的特征。编码器由五个卷积层组成,每个特征图的分辨率逐渐降低一半。没有使用最大池化或平均池化来降低特征图的分辨率。我们调整内核的步幅以降低分辨率。

- 解码器从提取的特征中恢复输入图像。它也由五个反卷积层组成,每个特征图的分辨率扩大了两倍。并且我们使用跳跃连接来恢复特征图的空间信息的细节(编码器中使用的特征与解码器的特征对称链接)。

- 添加了具有相同分辨率的功能。这里我们没有通过跳跃连接来连接第一个特征,即输入图像。由于输入图像具有噪声信息。

- 对于激活函数,我们对每一层使用 ELU 而不是 RELU。我们使用 sigmoid 作为最后一个激活函数。

B. 训练

我们使用广泛用于语义分割任务的 PASCAL VOC 2012 数据进行训练。总共有1464张训练图像和1449张验证数据。将值从0到255的像素值重新缩放为从0变为1。图像的分辨率固定为553×553。我们使用Adam优化器进行梯度下降算法,并使用5×10 -4对于学习率。我们向训练集添加随机噪声。我们使用干净或嘈杂的输入。它与 denoise autoencoder [28]的原始框架略有不同. 由于我们的目的是在没有对抗性攻击的情况下也保持原始性能,因此我们也输入了干净的输入。对于随机噪声,我们使用高斯分布、均匀分布和双峰分布。对于高斯分布,我们将均值设为 0,标准差设为 0.004。对于均匀分布,我们将范围设置为 -0.035 到 0.035。对于双峰分布,我们使用两种高斯分布的混合。对于每个高斯分布,我们设置了 -0.024 和 0.024 的平均值。我们使用 0.004 的标准偏差。

C. 结合语义分割模型

创建的去噪自动编码器连接到执行语义分割的通用模型,如图 3。去噪自编码器的作用是在图像进入分割模型之前进行预处理。由于去噪自编码器独立于分割模型,它可以位于任何模型之前。因此,它用作一般防御机制。因此,我们不必重新训练我们想要保护的模型。此外,用于训练去噪自编码器的随机噪声独立于任何对抗性攻击,可以防御多种攻击。

图 3:DAPAS整体流程

实验

在本节中,我们将研究去噪自编码器的恢复能力,然后测量恢复的图像在分割模型 DeepLab V3 Plus 中的表现。

我们使用来自 Pascal VOC 的测试数据和来自 SBD [12] 的附加注释来测试 DeepLab V3 Plus 中的分割结果。在对抗性攻击中,我们假设噪声不大。因为对抗性攻击的目的不是欺骗人,而是欺骗模型。所以我们将噪声的幅度限制为像素级的 0.032。即,它改变了原始像素值的 3.2%。我们适当调整了高斯分布和双峰分布的标准偏差和均匀分布的范围。分布的详细信息、评估指标和实验结果总结如下。

A. 数据集

我们使用 PASCAL VOC 验证集,该集在训练降噪自动编码器的过程中未使用。我们将图像大小调整为 513 x 513。由于我们使用预训练模型,该模型使用归一化数据,因此我们进行了相同的测试。换句话说,减去平均值并除以标准偏差。

B. 去噪自动编码器作为恢复

在测量对抗对抗性攻击的鲁棒性之前,我们将去噪自动编码器的输出可视化。尽管我们对噪声使用了三种不同的分布,但为了简单起见,我们只展示了高斯噪声的情况。由于噪声级差别不大,所以其他分布的结果是相似的。我们确保在去噪自动编码器之后以及在噪声图像的情况下,干净的图像得到很好的恢复,因为干净图像的性能不应该受到影响。图 4-(a)显示了原始图像,图 4-(b)显示了带噪图像,图 4-(c)显示了经过去噪自动编码器后的原始图像,图 11 显示了经过去噪自动编码器后的带噪图像。不难看出,图 4-(c)比图4-(d)更清晰。因此我们可以直观地预计,减速比不会那么大。

图 4:去噪自编码器的效果

C. 评估指标

联合平均交集(mIoU)被广泛用于评估语义分割的性能[7]。我们采用相对度量IoU 比率来衡量稳健性[1]。攻击的 IoU 比率定义如下。

-

mIoU CO:原始模型上干净图像的 mIoU

-

mIoU AO:原始模型上的对抗图像的 mIoU

-

mIoU CP:建议模型上干净图像的 mIoU

-

mIoU AP:在所提出的模型上的对抗图像的 mIoU

(其他内容略)

D. 结果分析

表 I显示,对于所有三个分布,由于降噪自动编码器导致的性能下降低至 3% 左右。并且我们验证了去噪自编码器对于消除对抗性攻击是有效的。图 6显示了结果。我们可以看到,当应用 FGSM 和 I-FGSM 时,分割输出很奇怪。此外,我们可以检查 I-FGSM 的噪声比 FGSM 小,但分割结果表明攻击在 I-FGSM 中更有效。然而,在通过去噪自动编码器后,两种情况下的图像都被成功地净化了。表 II显示了攻击的 IoU 比率。当ϵ为 0.008、0.0016 和 0.0032 时,攻击的 IoU 比率在 FGSM 上是相似的。但在 I-FGSM 的情况下,攻击的 IoU比率显着下降到 24.2%、21.9% 和 12.0%。表 III和表 IV显示了 FGSM 和 I-FGSM上稳健的 IoU 比率。这两个表进行比较,健壮IOU比上I-FGSM大于鲁棒IOU比上FGSM虽然攻击更有效的I-FGSM。图 7和图 8总结了表格的内容。

高斯分布我们使用高斯分布的小标准偏差,因为我们要检查性能取决于噪声分布,所以我们使用平均值 0 和标准偏差 0.004。虽然它也很有效,但性能在三个去噪自编码器中处于中等水平。

均匀分布我们给出了从 -0.035 到 0.035 的均匀分布范围,因为对抗性扰动的最大幅度是 0.032。在三种分布中,使用均匀分布的去噪自编码器在减少方面的性能最好。它显示了 97.4% 的 IoU 减少率。因此,与原始性能相比,它仅下降了 3.1%。在攻击场景的情况下,与其他分布相比,它显示出最差的性能。

双峰分布在大多数情况下,使用双峰分布噪声训练的去噪自编码器在三种分布中表现出最佳性能。由于对抗性攻击会增加或减少固定大小的噪声,我们使用遵循双峰分布的噪声,使用两个高斯分布,如图 5。每个高斯分布的均值为 -0.24 和 0.24,标准差为 0.004。IoU 降低为 97.2%,是三种分布中最差的,但差异很小。万一发生攻击,性能是最好的。

图 5:使用两个高斯分布的双峰分布

图 6:来自使用 FGSM 和 I-FGSM 的对抗性攻击的图像、DAPAS 之后的图像以及每个图像的输出。

图 7:FGSM 攻击的 IoU 比率 图 8:I-FGSM 攻击的 IoU 比率

结论

我们验证了降噪自动编码器在语义分割任务的上下文中有效防御对抗性攻击。我们还确认,根据去噪自动编码器在输入中产生的噪声分布类型,性能略有不同。我们还相信,由于我们的降噪自动编码器在设计降噪自动编码器时独立于特定攻击,因此这种方法不仅适用于语义分割任务,还适用于分类和对象检测领域。设计更详细、更仔细的降噪自动编码器以对抗对抗性攻击仍有待研究。

小结部分

白盒攻击:它是通过使用受害者模型的参数和损失函数生成的。由于它需要模型的信息,因此称为白盒攻击。

黑盒攻击:在无法访问模型的情况下,由于称为可转移性的属性,仍然可以创建对抗性示例。它允许对这种情况进行攻击,称为黑盒攻击。即,从特定模型生成的对抗性示例也适用于其他模型。

我们的机制不会修改语义分割模型。我们使用去噪自编码器作为预处理器,把它放在语义分割模型的前面。无论输入是否是对抗性示例,它都会在传递原始模型之前通过降噪自动编码器

去噪自编码器的架构

图2:去噪自编码器的架构

去噪自编码器分为两部分:橙色编码器部分和蓝色解码器部分。

编码器提取输入图像的特征。编码器由五个卷积层组成,每个特征图的分辨率逐渐降低一半。没有使用最大池化或平均池化来降低特征图的分辨率。我们调整内核的步幅以降低分辨率。

解码器从提取的特征中恢复输入图像。它也由五个反卷积层组成,每个特征图的分辨率扩大了两倍。并且我们使用跳跃连接来恢复特征图的空间信息的细节(编码器中使用的特征与解码器的特征对称链接)。

添加了具有相同分辨率的功能。这里我们没有通过跳跃连接来连接第一个特征,即输入图像。由于输入图像具有噪声信息。

对于激活函数,我们对每一层使用 ELU 而不是 RELU。我们使用 sigmoid 作为最后一个激活函数。

结合语义分割模型

创建的去噪自动编码器连接到执行语义分割的通用模型,如图 3。去噪自编码器的作用是在图像进入分割模型之前进行预处理。由于去噪自编码器独立于分割模型,它可以位于任何模型之前。因此,它用作一般防御机制。因此,我们不必重新训练我们想要保护的模型。此外,用于训练去噪自编码器的随机噪声独立于任何对抗性攻击,可以防御多种攻击。

图 3:DAPAS整体流程

其余部分和自己研究关联不是很大,暂时不深入。

自己的碎碎念

最近读的两篇去噪相关的都是语义分割以及人工智能安全相关的(有点疑问)。

自己看到的一些关键词:去噪自编码器 对抗性示例 对抗性攻击

需要关注的参考文献:denoise autoencoder [28]

8415

8415

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?