Seq2seq Models With Attention

Seq2seq

在机器翻译、文本摘要和图像标注等任务中都取得了很多成功。Google翻译在2016年底开始使用这种模型。该模型主要在下列两篇论文中介绍:

- Sutskever et al., 2014,NIPS,Sequence to Sequence Learning with Neural Networks

- Cho et al., 2014,EMNLP,Learning Phrase Representations using RNN Encoder–Decoder for Statistical Machine Translation

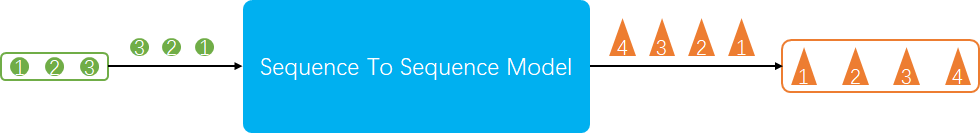

一个Sequence-toSequence模型就是输入一个序列,输出一个序列的模型,这个序列的元素可以是单词、字母、图像的特征等,如下图所示。

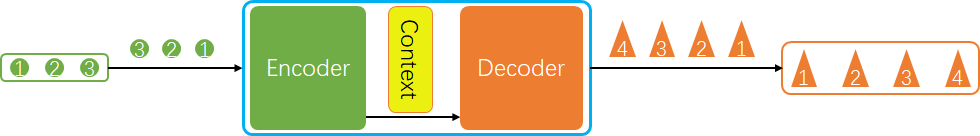

一般该模型会由编码器(Encoder)和解码器(Decoder)组成,编码器接受输入序列后生成一个语境(Context),将这个语境传给解码器后,解码器将生成输出序列,如下图所示。

在机器翻译中,语境(Context)一般是一个向量(一组浮点数)。编码器(Encoder)和解码器(Decoder)都会是一个RNN网络。下图展示了大小为4的语境向量,在实际中,大小一般比较大,如256,512或者1024。颜色的深浅表示数值的大小,大的颜色浅,小的颜色深。

同样,输入也应该转换成向量,一般一个序列中的元素对应一组向量,如下图所示。通常,将单词转换为向量的算法,称为“word embedding”算法,通过这个算法单词被转换到向量空间,可以代表更多的逻辑上的意义,例如:女王=王-男+女。

下图展示了第一幅图的具体流程。每接收一个输入向量,语境就进入下一个状态;当三个输入都接收完毕,Encoder得到了HS#3这一个语境。解码器拥有一个隐藏状态(hidden state),会(1) 将上一次的输出向量(最开始则是结束标志encoder出的向量)和当前的隐藏状态作为输入,得到(transform)到另外一个隐藏状态(感觉取名来自状态转移机); (2)新的隐藏状态结合encoder得到的语境,通过一些卷积层得到新的输出向量;(3)新的输出向量+新的隐藏状态重复(1)。

加入Attention

语境向量的表达能力有限,难以处理长的序列。下面两篇论文提出的attention解决了这一问题:

- Bahdanau et al., 2015,ICLR,Neural Machine Translation by Jointly Learning to Align and Translate

- Luong et al., 2015,EMNLP,Effective Approaches to Attention-based Neural Machine Translation

如下图所示,编码器会将每个输入得到的语境向量搜集起来;加入Attention模块的解码器:

- 查看收到的所有语境向量(每个语境向量会和输入序列中的一个元素相关)

- 利用当前隐藏状态给每个语境向量打分,选择分值最大的语境向量(或者其他方式得到一个语境向量:相乘求和)

上述的三个步骤会在每次输出都会重复。下图为展开的加入Attention的网络流程图:

解码器:

- 解码器接受前一个语境向量(初始)和由通过Embedding算法生成的向量,输出当前语境向量

- Attention模块根据当前语境向量给所有编码器生成的语境向量打分;并将打分和编码器的语境向量相乘后得到一个新的加入attention后的编码语境向量

- 该新生成的编码语境向量与解码器当前语境向量拼接后,可能经过一些卷积层,得到输出序列的元素向量

- 解码器接受上一个语境向量和上一步输出序列的元素向量,输出当前语境向量,重复步骤2,3,4直到。

参考资料:

https://jalammar.github.io/illustrated-transformer/

https://jalammar.github.io/visualizing-neural-machine-translation-mechanics-of-seq2seq-models-with-attention/

649

649

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?