码字不易,喜欢的请点赞收藏!!!!!

目录

1、下载代码

代码地址:https://github.com/chequanghuy/TwinLiteNet

2、解压缩

3、建立conda环境

我个人先建立起一个基础环境,然后复制为twinlitenet环境,大家可以直接建立环境

conda create -n baseenv python=3.8

conda activate baseenv

安装pytorch, torchvision, torchaudio等废了好大劲,传统搜索出的安装命令,不是太慢,就是安装错了,安装的cpu版本的torch,只有这一句,能够省时省力,正确安装。

pip3 install torch==1.10.0 torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113 -i https://pypi.tuna.tsinghua.edu.cn/simple some-package

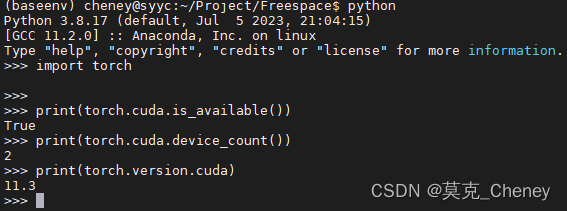

4、验证环境

环境安装好了,我们来验证下

import torch # 如果pytorch安装成功即可导入

print(torch.cuda.is_available()) # 查看CUDA是否可用

print(torch.cuda.device_count()) # 查看可用的CUDA数量

print(torch.version.cuda) # 查看CUDA的版本号

5、复制环境

conda create -n twinlitenet --clone baseenv

6、安装依赖

pip install -r requirements.txt -i https://pypi.douban.com/simple/

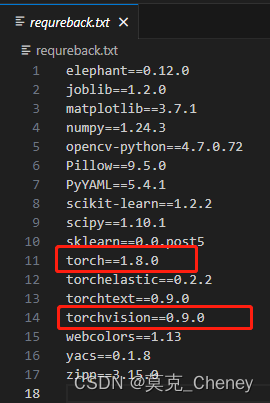

感觉对应的包没有必要和作者完全一致,能够安装上即可,自己和自己安装的版本不冲突即可

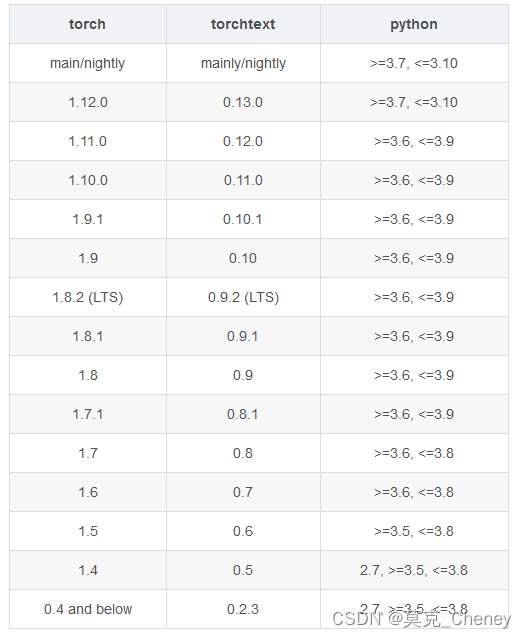

因为我们之前安装完成了torch,torchvision,所以要把它们两个删掉,另外torchtext对torch的版本有要求,要一并考虑。

7、测试

先建立结果文件夹

mkdir results

使用如下语句运行测试程序,调用的是'pretrained/best.pth'这个模型,运行的原图在images里,结果图存在results里

python test_image.py

结果示意图如下,蓝色的是可行驶区域,绿色的是车道线:

8、训练

下载数据集,后面两个标签需要科学上网:

- 下载images (https://bdd-data.berkeley.edu/)

- 下载可通行区域的标签[segments](https://drive.google.com/file/d/1xy_DhUZRHR8yrZG3OwTQAHhYTnXn7URv/view?usp=sharing)

- 下载车道线的标签 [lane](https://drive.google.com/file/d/1lDNTPIQj_YLNZVkksKM25CvCHuquJ8AP/view?usp=sharing).

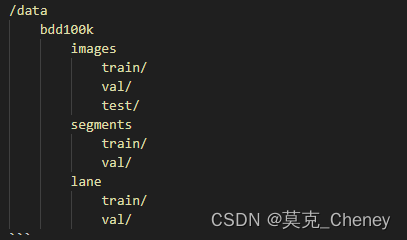

按照如下目录链接存放:

放好数据集后,更改DataSet.py里的数据集路径,改为你自己的路径:

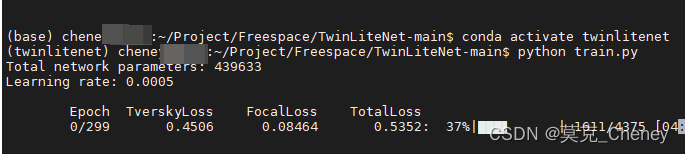

conda activate twinlitenet

python train.py即可开始训练:

8116

8116

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?