作者简介:洪亮劼,Etsy数据科学主管,前雅虎研究院高级经理。长期从事推荐系统、机器学习和人工智能的研究工作,在国际顶级会议上发表论文20余篇,长期担任多个国际著名会议及期刊的评审委员会成员和审稿人。

责编:何永灿(heyc@csdn.net)

本文为《程序员》原创文章,未经允许不得转载,更多精彩文章请订阅《程序员》

涉及自然语言处理、人工智能、机器学习等诸多理论以及技术的顶级会议——第55届计算语言学年会(The 55th Annual Meeting of the Association for Computational Linguistics,简称ACL会议)于今年7月31日-8月4日在加拿大温哥华举行。从近期谷歌学术(Google Scholar)公布的学术杂志和会议排名来看,ACL依然是最重要的自然语言处理相关的人工智能会议。因为这个会议的涵盖面非常广泛,且理论文章较多,一般的读者很难从浩如烟海的文献中即刻抓取到有用信息,这里笔者从众多文章中精选出5篇有代表性的文章,为读者提供思路。

Multimodal Word Distributions

摘要:本文的核心思想为如何用Gaussian Mixture Model来对Word Embedding进行建模,从而可以学习文字的多重表达。这篇文章值得对Text Mining有兴趣的读者泛读。

文章作者Ben Athiwaratkun是康奈尔大学统计科学系的博士生。Andrew Gordon Wilson是新加入康奈尔大学Operation Research以及Information Engineering的助理教授,之前在卡内基梅隆大学担任研究员,师从Eric Xing和Alex Smola教授,在之前,其在University of Cambridge的Zoubin Ghahramani手下攻读博士学位。

这篇文章主要研究Word Embedding,其核心思想是想用Gaussian Mixture Model表示每一个Word的Embedding。最早的自然语言处理(NLP)是采用了One-Hot-Encoding的Bag of Word的形式来处理每个字。这样的形式自然是无法抓住文字之间的语义和更多有价值的信息。那么,之前Word2Vec的想法则是学习一个每个Word的Embedding,也就是一个实数的向量,用于表示这个Word的语义。当然,如何构造这么一个向量又如何学习这个向量成为了诸多研究的核心课题。

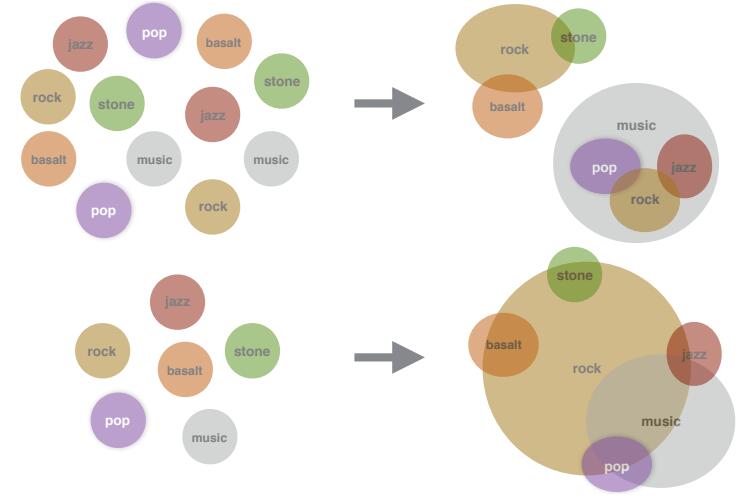

在ICLR 2015会议上,来自UMass的Luke Vilnis和Andrew McCallum在“Word Representations via Gaussian Embedding”文章中提出了用分布的思想来看待这个实数向量的思想。具体说来,就是认为这个向量是某个高斯分布的期望,然后通过学习高斯分布的参数(也就是期望和方差)来最终学习到Word的Embedding Distribution。这一步可以说是扩展了Word Embedding这一思想。然而,用一个分布来表达每一个字的最直接的缺陷则是无法表达很多字的多重意思,这也就带来了这篇文章的想法。文章希望通过Gaussian Mixture Model的形式来学习每个Word的Embedding。也就是说,每个字的Embedding不是一个高斯分布的期望了,而是多个高斯分布的综合。这样,就给了很多Word多重意义的自由度。在有了这么一个模型的基础上,文章采用了类似Skip-Gram的来学习模型的参数。具体说来,文章沿用了Luke和Andrew的那篇文章所定义的一个叫Max-margin Ranking Objective的目标函数,并且采用了Expected Likelihood Kernel来作为衡量两个分布之间相似度的工具。这里就不详细展开了,有兴趣的读者可以精读这部分细节。

文章通过UKWAC和Wackypedia数据集学习了所有的Word Embedding。所有试验中,文章采用了K=2的Gaussian Mixture Model(文章也有K=3的结果)。比较当然有之前Luke的工作以及其他各种Embedding的方法,比较的内容有

本文精选了ACL 2017会议上五篇具有代表性的论文,涉及Multimodal Word Distributions、Topically Driven Neural Language Model、端到端强化学习对话系统、Learning to Skim Text和从语言到程序的转化。这些论文展示了自然语言处理领域的最新进展,包括词向量建模、话题驱动的语言模型、对话系统优化、文本阅读策略以及程序生成。

本文精选了ACL 2017会议上五篇具有代表性的论文,涉及Multimodal Word Distributions、Topically Driven Neural Language Model、端到端强化学习对话系统、Learning to Skim Text和从语言到程序的转化。这些论文展示了自然语言处理领域的最新进展,包括词向量建模、话题驱动的语言模型、对话系统优化、文本阅读策略以及程序生成。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

259

259

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?