台湾国立大学机器学习技法.听课笔记(第五讲)

:Kernel Logistic Regression

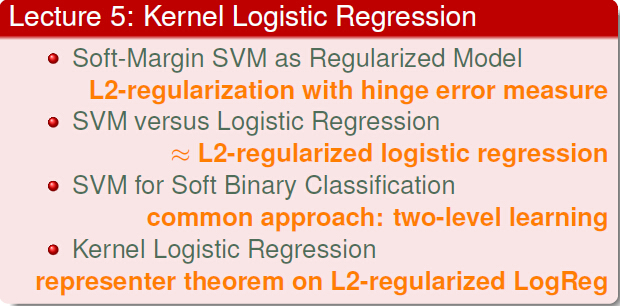

一,Soft-Margin SVM as Regularized Model

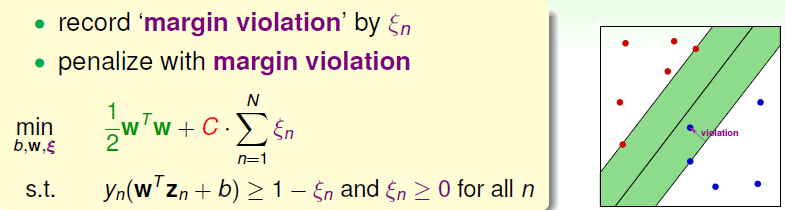

我们开始本lecture前,先对以前的知识进行回顾:

其中,ξ_n是松弛变量,它的特点是:

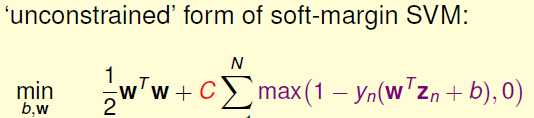

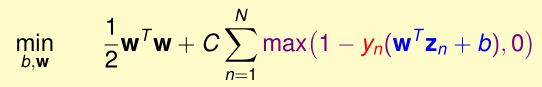

所以我们可以把Soft-Margin SVM写成:

这个形式是不是在那里看过呢?

它很像L2 regularization,但是我们为什么算Soft-margin SVM的时候没有用L2 Regularization的方法解呢??

因为:1,他不是二次规划问题;2,max(.,0)不可导,很难求解。

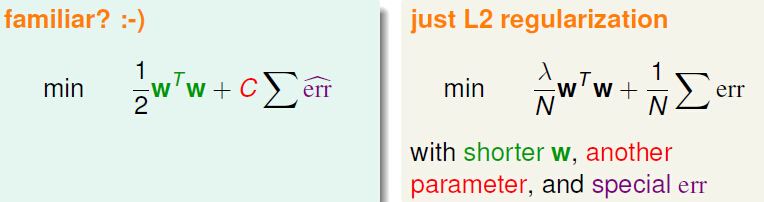

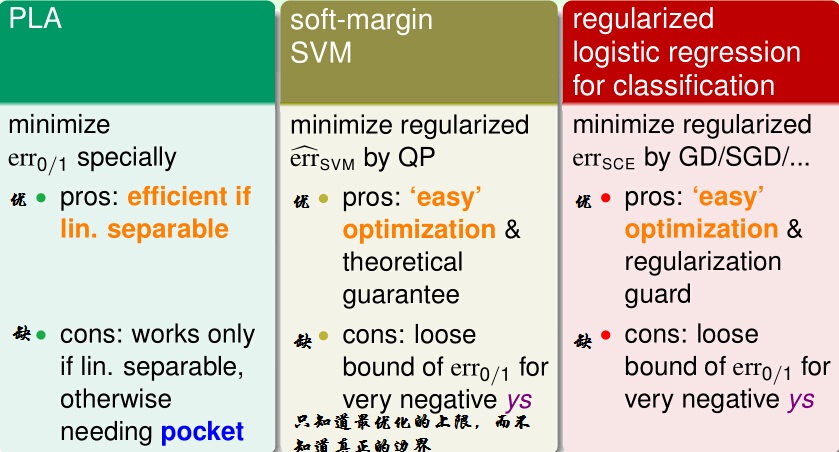

但是不管怎么样,我们可以看到SVM和Regularized 有一定的联系:

我们也可以根据这里,联想:可能SVM和其他算法也有联系。

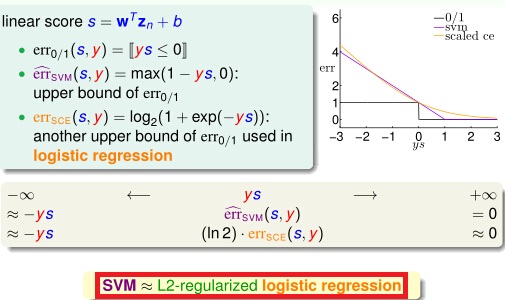

二,SVM versus Logistic Regression

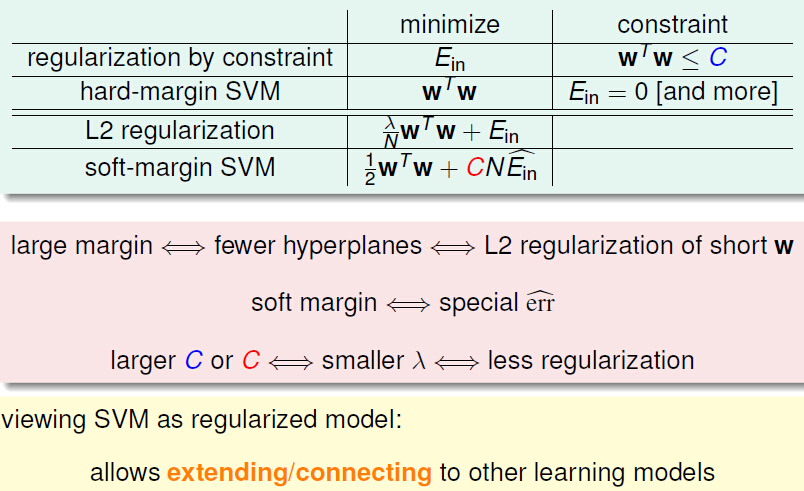

我们刚才已经知道了支持向量机的误差的式子:

我们既然想把SVM与线性回归进行比较,那我们是不是可以把线性回归的误差error拿出来进行比较:

首先是线性二元分类,然后用SVM的error进行比较:

然后,我们把error_(SVM)进行尺度变换,使SVM的error更像Logistic Regression。

这样就把SVM写的更像Logistic Regression,这样SVM依然可以解决线性而原问题,

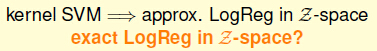

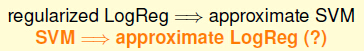

Regularized Logistic Regression就可以推导到approximateSVM。

所以我们解决线性而原问题是就有很多种方法了:

那SVM能不能推导的更像Logistic Regression呢??

三,SVM for Soft Binary Classification

我们能不能用SVM解决二元分类的问题,或者SVM和逻辑回归一起解决二元分类问题。

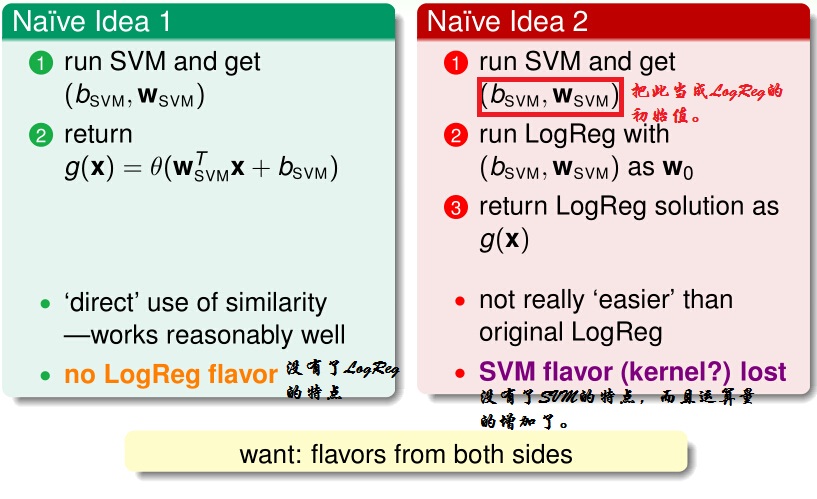

1,可行方案的提出

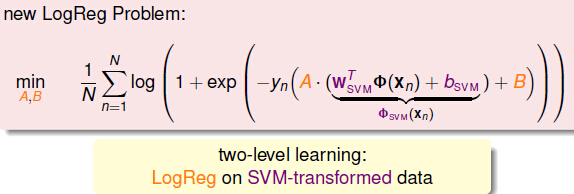

那我们想出一个可行的方案:Two-Level Learning

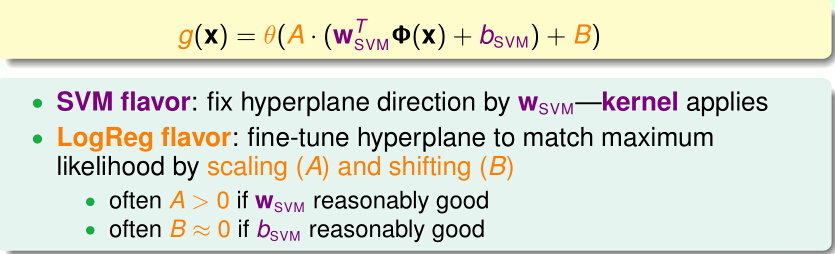

因此,一种新的LogReg 的形式就提出:

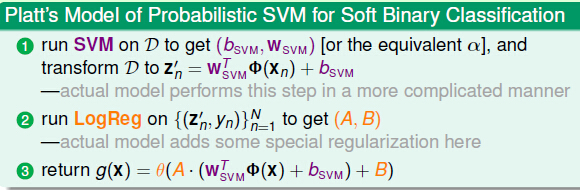

所以用SVM和Logistic Regression的方法解决二元分类问题算法的一般步骤是:

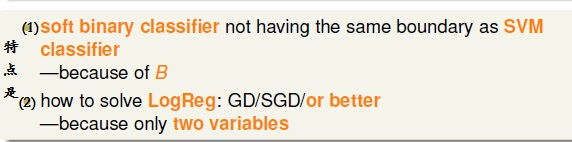

这种算法的特点是:

因此我们知道了:

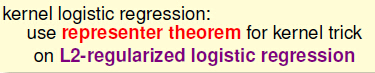

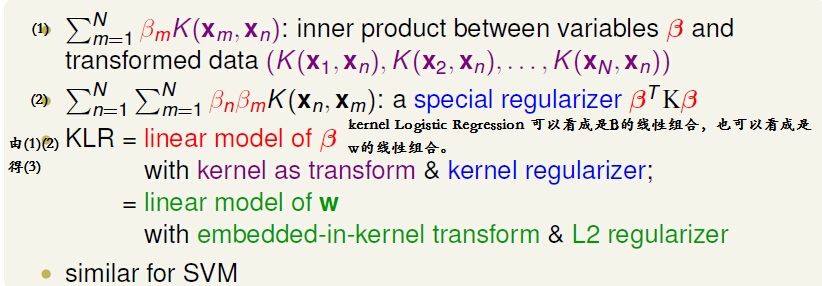

四,Kernel Logistic Regression

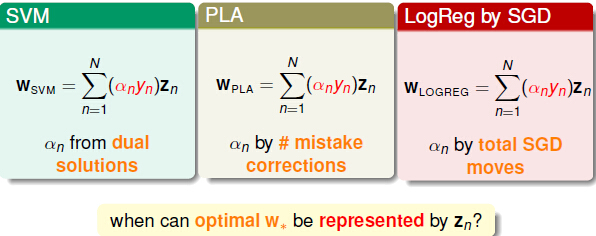

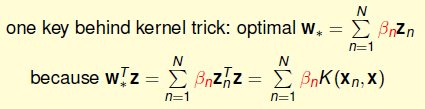

在SVM中为什么可以用kernel,是因为w是z的线性累加的形式组成的,即:

那么PLA和Logistic Regression by SGD中的w都能用z线性累加表示,那他们能不能用到kernel的形式呢?

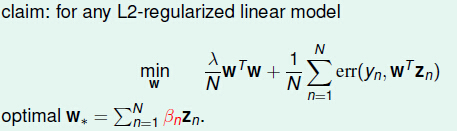

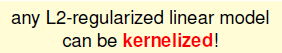

1,L2-regularizedlinear Model

我们先对L2-regularized linear Model给出结论:

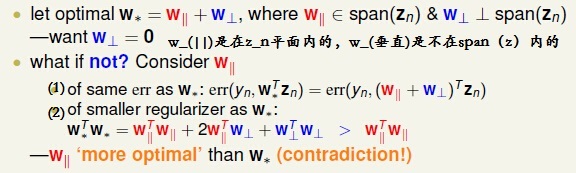

证明:

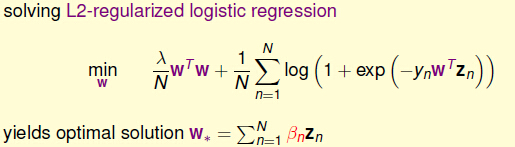

2,解决L2-regularizedLogistic Regression问题

L2-regularized Logistic Regression的问题是:

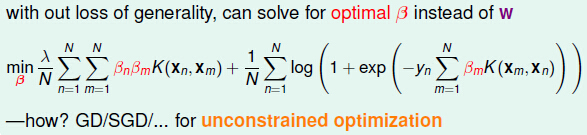

那我们根据刚才说的L2-Regularized最优问题,可以将其改写成:

所以我们把这个问题转换成了求解β的无约束问题。

这个问题还可以用另外一种解释方法进行解释:

但是KLR一般也有不足之处:

总结:

377

377

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?