实战需求

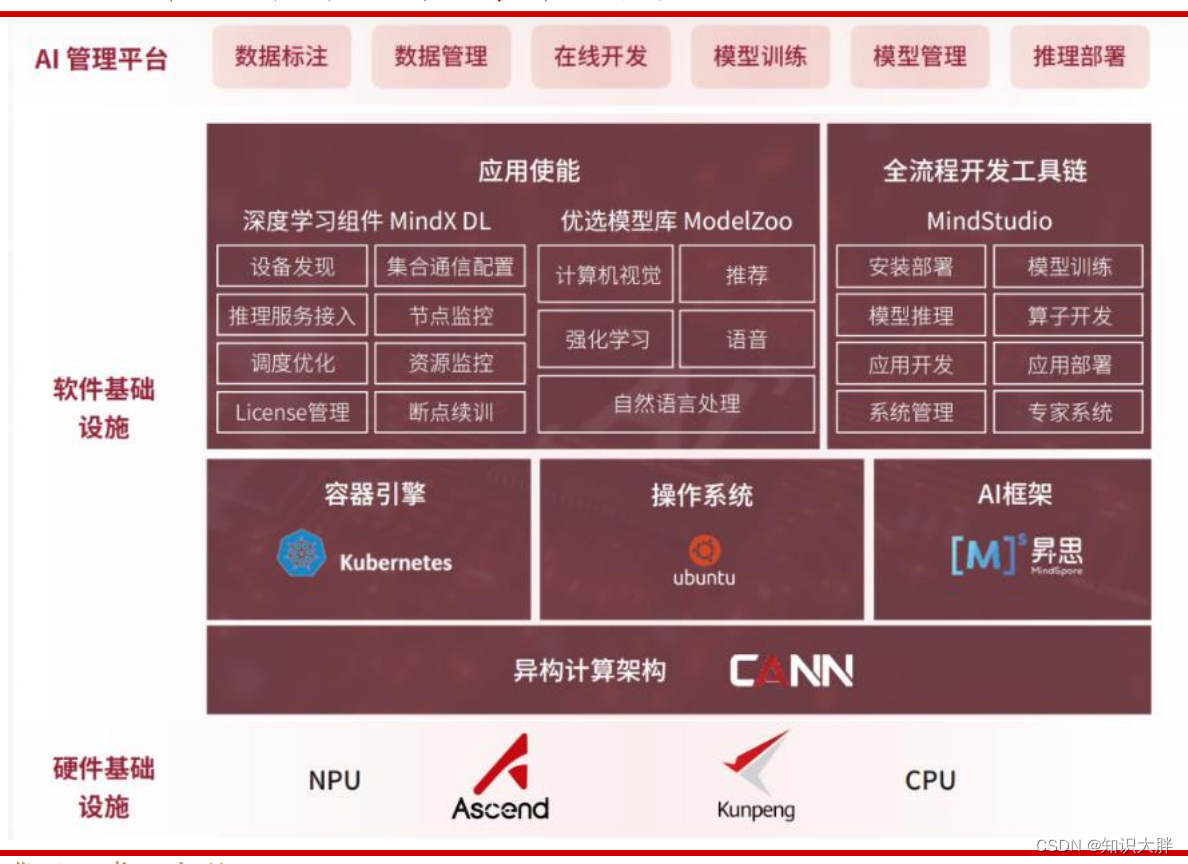

本文主要向用户介绍基于Ascend 910 推理卡,快速完成昇腾NPU(Neural-Network Processing Unit,神经网络处理器单元)驱动固件、CANN(Compute Architecture for Neural Networks,AI异构计算架构)软件的安装,实现推理业务的上线。

当前华为昇腾 910B 能力已经基本做到可对标英伟达 A100。华为轮值董事长胡厚崑在昇腾人工智能产业高峰论坛宣布,昇腾 AI 集群解决方案,已经在全国 25个城市的人工智能计算中心及重点实验室得到应用,其中有 7 个,包括武汉、西安等,成为科技部首批认可的“国家新一代人工智能公共算力开放创新平台”。

本文提供了一步一步的教程,讲解如何在华为昇腾910硬件环境下,安装docker并配置运行llama大模型进行推理。内容涵盖驱动固件和CANN软件安装,docker的配置与测试,以及模型的执行流程。

本文提供了一步一步的教程,讲解如何在华为昇腾910硬件环境下,安装docker并配置运行llama大模型进行推理。内容涵盖驱动固件和CANN软件安装,docker的配置与测试,以及模型的执行流程。

订阅专栏 解锁全文

订阅专栏 解锁全文

905

905

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?