一、GPT-4o简介

北京时间5月14日,OpenAI举行春季发布会。OpenAI在活动中发布了新旗舰模型“GPT-4o”!据OpenAI首席技术官穆里·穆拉蒂(Muri Murati)介绍,GPT-4o在继承GPT-4强大智能的同时,进一步提升了文本、图像及语音处理能力,为用户带来更加流畅、自然的交互体验,更多详情可查看官网:https://openai.com/index/hello-gpt-4o/。

GPT-4o的“o”代表“omni”,源自拉丁语“omnis”。在英语中“omni”常被用作词根,用来表示“全部”或“所有”的概念。GPT-4o是一个多模态大模型,支持文本、音频和图像的任意组合输入,并能生成文本、音频和图像的任意组合输出。与现有模型相比,它在视觉和音频理解方面尤其出色。

二、GPT-4o的性能

GPT-4o可以在音频、视觉和文本中进行实时推理,接受文本、音频和图像的任何组合作为输入,并生成文本、音频和图像的任何组合进行输出。它可以最短在232毫秒内响应音频输入,平均为320毫秒,这与人类在对话中的响应时间相似。

文本能力

GPT-4o 在 0 次 COT MMLU(常识问题)上创下了 88.7% 的新高分。所有这些评估都是用我们的新 简单评估(在新窗口中打开)。此外,在传统的 5 次无 CoT MMLU 上,GPT-4o 创下了 87.2% 的新高。(注:3400b(在新窗口中打开)还在训练)

音频能力

GPT-4o 在语音翻译方面创下了新的领先地位,并在 MLS 基准测试中优于 Whisper-v3。

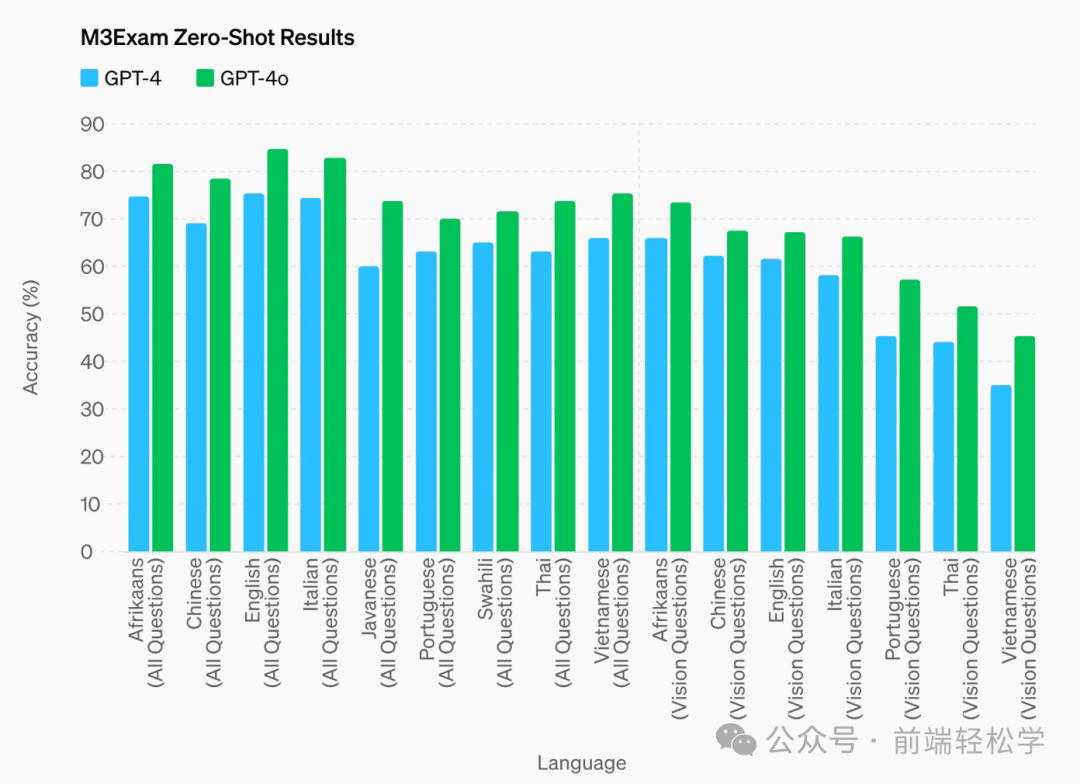

各种语言的考试能力

M3Exam 基准测试既是多语言评估,也是视觉评估,由来自其他国家标准化考试的多项选择题组成,有时包括数字和图表。GPT-4o 在所有语言的基准测试中都比 GPT-4 强。(我们省略了斯瓦希里语和爪哇语的视力结果,因为这些语言只有 5 个或更少的视力问题。)

视觉理解

GPT-4o 在视觉感知基准测试中实现了最先进的性能。全面碾压之前的模型。所有视觉评估均为 0 次,其中 MMMU、MathVista 和 ChartQA 为 0 次 CoT。

语音交互

GPT-4o 在语音交互方面取得了重大进展。它采用了先进技术,显著提高了响应速度,使得对话更加流畅自然。在最近的发布会上,OpenAI 展示了 GPT-4o 在语音对话中的表现,它能够几乎实时地回答问题,并通过文本转语音技术进行朗读,提供了一种沉浸式的交流体验。此外,GPT-4o 还可以调整说话的语气,从夸张戏剧到冰冷机械,以适应不同的交流场景。令人兴奋的是,GPT-4o 还具备唱歌的功能,增添了更多的趣味性和娱乐性。

三、GPT-4 Turbo 与 GPT-4o

不仅在传统的文本能力上GPT-4 Turbo的性能相当,还在 API 方面更快速,价格还更便宜 50%。总结来说,与 GPT-4 Turbo 相比,GPT-4o 速度提高了 2 倍,价格减半,限制速率提高了 5 倍。截至 2024 年 5 月 13 日,Plus 用户将能够在 GPT-4o 上每 3 小时发送多达 80 条消息,在 GPT-4 上每 3 小时发送多达 40 条消息。我们可能会在高峰时段减少限制,以保持 GPT-4 和 GPT-4o 可供尽可能多的人访问。

GPT-4o 具有相同的高智商,但比 GPT-4 Turbo 更快、更便宜,并且具有更高的速率限制。

具体说来:

-

定价:GPT-4o 比 GPT-4 Turbo 便宜 50%,输入 5 美元/月,输出代币 15 美元/M)。

-

速率限制:GPT-4o 的速率限制比 GPT-4 Turbo 高 5 倍——每分钟最多 1000 万个代币。

-

速度:GPT-4o 的速度是 GPT-2 Turbo 的 4 倍。

-

视觉:GPT-4o 的视觉能力在与视觉能力相关的评估中表现优于 GPT-4 Turbo。

-

多语言:GPT-4o 改进了对非英语语言的支持,而不是 GPT-4 Turbo。

GPT-4o 目前的上下文窗口为 128k,知识截止日期为 2023 年 10 月。

四、怎么使用GPT-4o

目前,GPT-4o的文本和图像功能已经开始在ChatGPT中逐步推出,用户可以在ChatGPT平台上免费体验到GPT-4o的相关功能,但免费版有使用次数限制,Plus用户可以享受到5倍的调用额度。

在接下来的几周内,OpenAI计划将在ChatGPT Plus中推出Voice Mode新版本,该版本带有GPT-4o。这将作为ChatGPT Plus的一个alpha版本提供给PIus用户。此外,GPT-4o也将通过API提供给开发者,作为文本和视觉模型。开发者可以利用AP来集成GPT-4o到他们自己的应用程序

中,而且GPT-4o在API中相比GPT-4Tubo更快、更便宜,并且有更高的速率限制。

至于GPT-4o的音频和视频功能,OpenAl将在未来的几周和几个月内继续开发技术基础设施、通过训练后提高可用性以及确保安全性,之后才会发布这些功能,并逐步向公众提供。

如有侵权,请联系删除。

写在最后

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?