一、什么是“Embedding”?

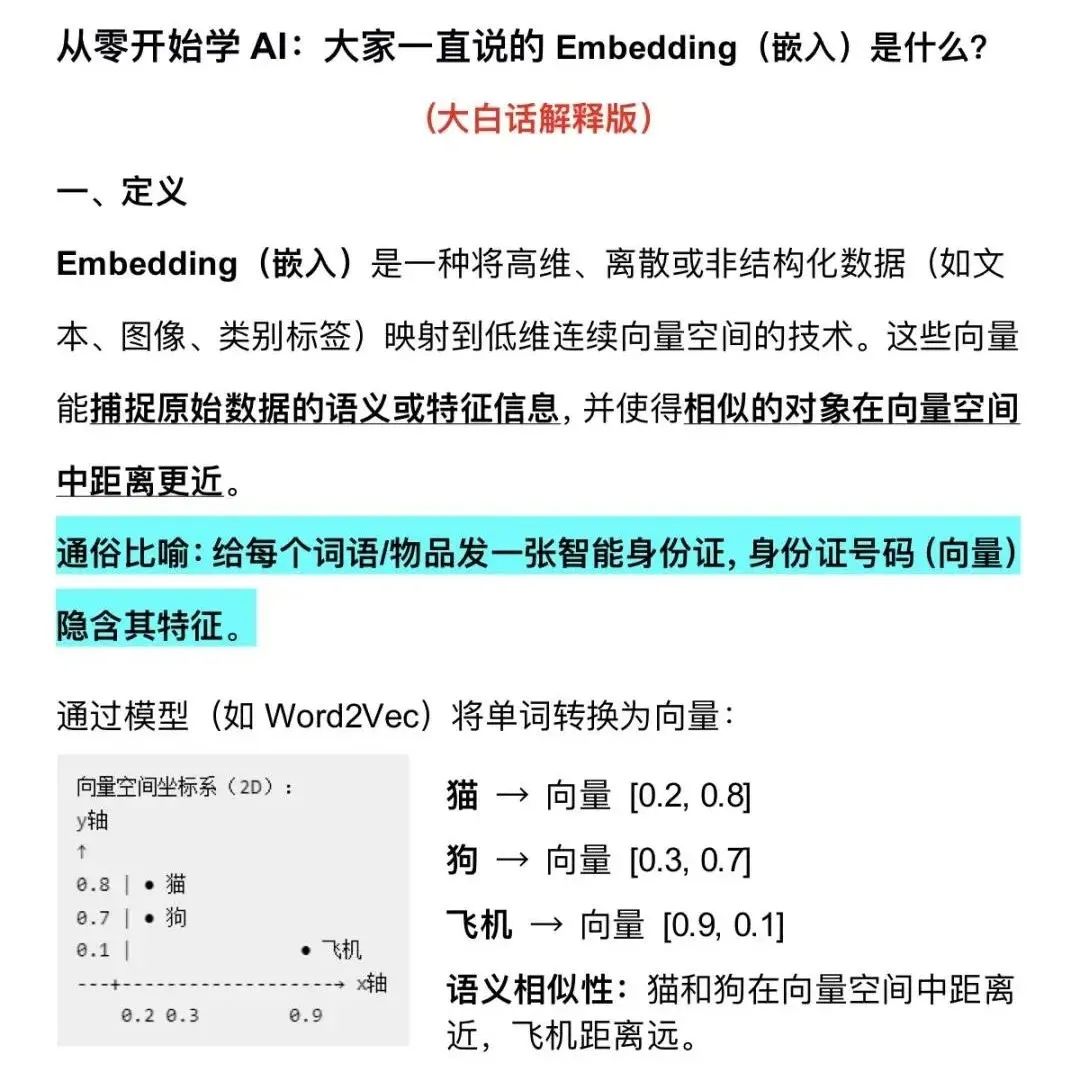

Embedding(嵌入)是指把文本(也可能包括图像、视频等其他模态数据)转成能表达语义信息的浮点数向量,向量之间的数学距离可以反映对应文本之间的语义相关性。

最近两年,大家都可以看到AI的发展有多快,我国超10亿参数的大模型,在短短一年之内,已经超过了100个,现在还在不断的发掘中,时代在瞬息万变,我们又为何不给自己多一个选择,多一个出路,多一个可能呢?

与其在传统行业里停滞不前,不如尝试一下新兴行业,而AI大模型恰恰是这两年的大风口,整体AI领域2025年预计缺口1000万人,其中算法、工程应用类人才需求最为紧迫!

学习AI大模型是一项系统工程,需要时间和持续的努力。但随着技术的发展和在线资源的丰富,零基础的小白也有很好的机会逐步学习和掌握。【点击蓝字获取】

【2025最新】AI大模型全套学习籽料(可白嫖):LLM面试题+AI大模型学习路线+大模型PDF书籍+640套AI大模型报告等等,从入门到进阶再到精通,超全面存下吧!

二、从文本到“Embedding”的流程

Embedding的生成方式,主要分两种情况:

1)大模型推理中的Embedding(Token级)

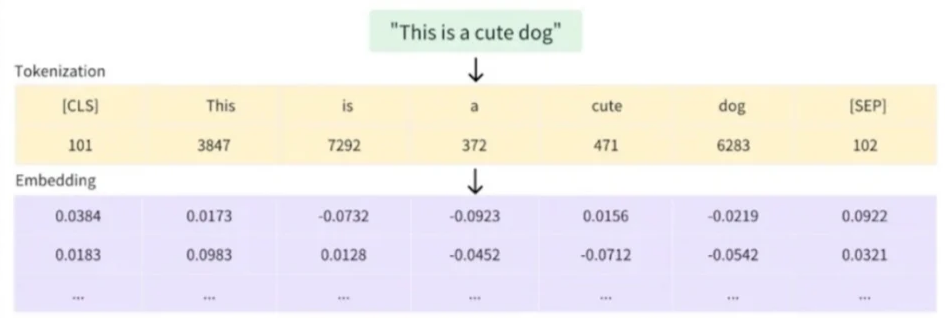

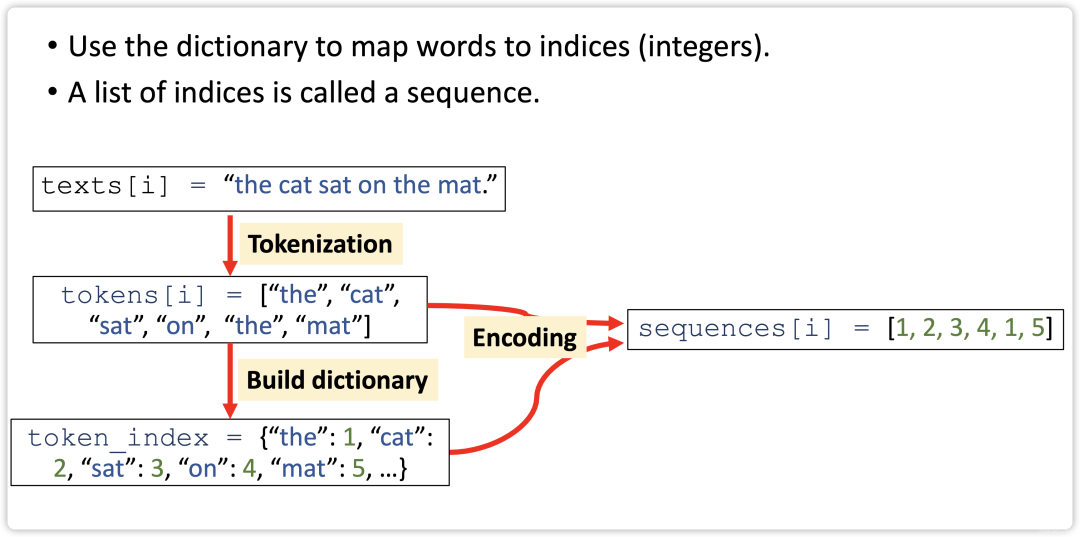

文本先通过分词器拆分成最小语言单位token,例如 :“unbelievable” → [“un”, “believ”, “able”]。

接着查询词表,每个token被映射成一个数字编号,比如:"un"→1087。

根据编号查询Embedding矩阵,快速取出对应的浮点数向量,例如:"un"→[0.24,-0.31,0.88,…, 0.05]。

生成Token级的Embedding,是大模型理解输入文本的第一步。

2)独立使用的Embedding(句子/文档级)

如果需要表示一整句或一段文本(比如在RAG中检索),就不能只查表了。

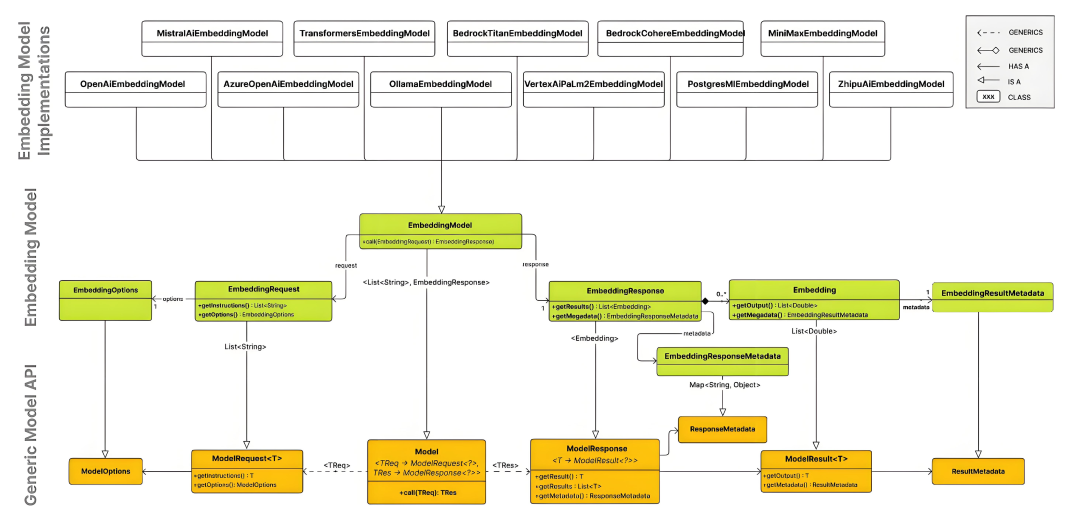

常见做法是: 将文本输入到一个专门训练好的Embedding模型(如Sentence-BERT、M3E),通过推理生成一个完整的句子或文档级向量。

这种Embedding包含了更丰富的上下文信息,适合检索、相似性判断等场景。

三、“Embedding”的本质: 语义可“被数字表示”

在模型训练中,发现文本的语义可以被““压缩”成一组数字向量,且向量之间的距离和方向,能自然反映文本间的语义关系。

比如:

“猫”和“狗”对应向量的数学距离很近,代表它们语义接近(都是动物)

“房子”和“你好”对应向量的数学距离很远,表示它们语义无关

模型甚至可以学到: king-man+woman≈queen 这样的语义数学关系

这些规律并非人为设定,而是模型通过海量数据自动学习到的。

四、“Embedding”的应用场景

Embedding不仅用于大模型推理时将输入文本编码为语义向量,也广泛应用于实际场景,例如:

检索增强生成(RAG): 将文档或知识内容转化为向量存储,推理时通过向量检索相关片段,扩展模型上下文,提升回答准确性。

相似性判断: 比较文本向量的距离或角度,判断语义一致性或检测重复内容。

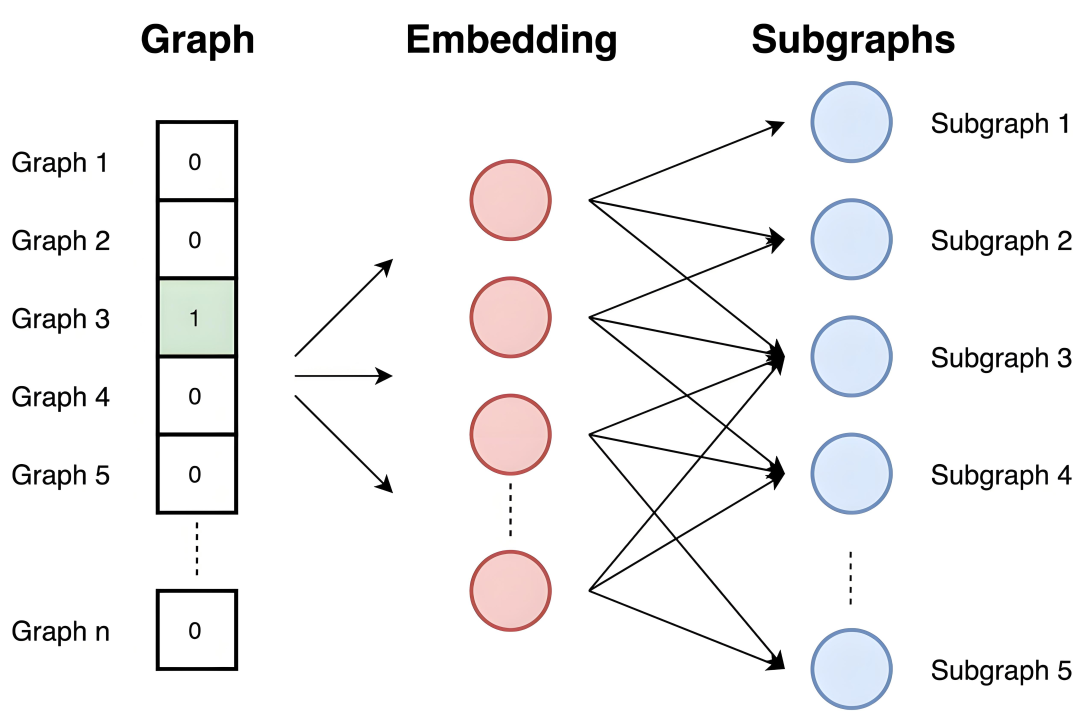

文本聚类与分析: 将文本编码为向量后进行聚类,挖掘内容结构和主题分布,如K-means聚类。

五、常见问题答疑

Q:Token 和 Embedding 是一回事吗?

A:不是。Token 是编号(离散的ID),Embedding 是承载语义的连续向量,二者功能完全不同。

Q:Embedding 是模型训练出来的吗?

A:是的。Embedding 向量是模型通过海量语料学习到的语义表示,而不是手动设定或硬编码的。

Q:Embedding 向量长度固定吗?为什么?

A:在同一个模型中,所有Embedding向量的长度是固定的(例如:512维、768维),这样可以统一模型内部的计算结构,方便批量处理和矩阵运算。不同模型之间的向量长度则可能不同。

六、大模型&小模型embedding对比

\1. BERT的Embedding生成原理:

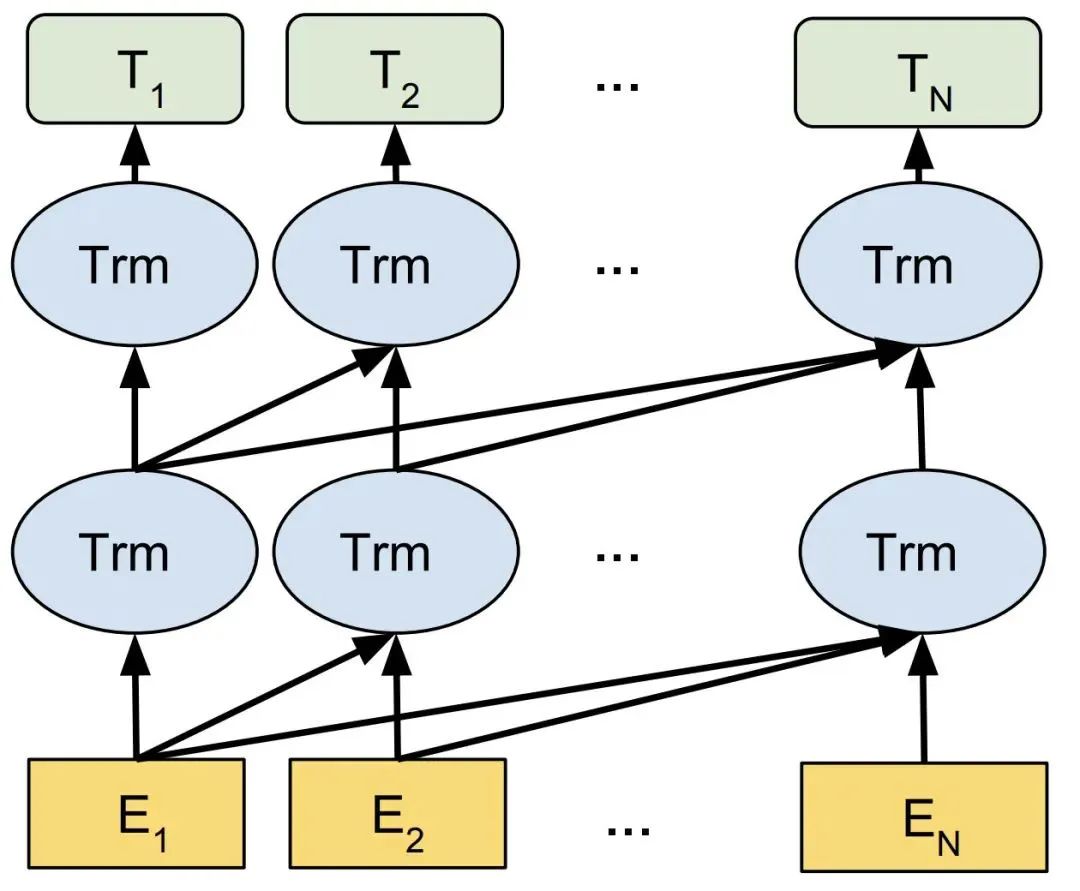

1)模型结构:基于Transformer编码器,使用双向自注意力机制。

2)预训练任务:Masked Language Model (MLM) 和 Next Sentence Prediction (NSP)。

3)Embedding来源:

Token-level:每个token的隐藏状态(最后一层或多层平均)

Sentence-level:通常取[CLS] token的隐藏状态作为句子表示,或通过池化(平均/最大池化)所有token的隐藏状态。

\2. LLM(如Qwen)的Embedding生成原理:

1)模型结构:基于Transformer解码器,使用单向自注意力(仅关注左侧上下文)

2)预训练任务:自回归语言建模(预测下一个token)

3)Embedding来源:通常取最后一层所有token的隐藏状态,或最后一个token的隐藏状态作为序列表示(需根据任务调整)

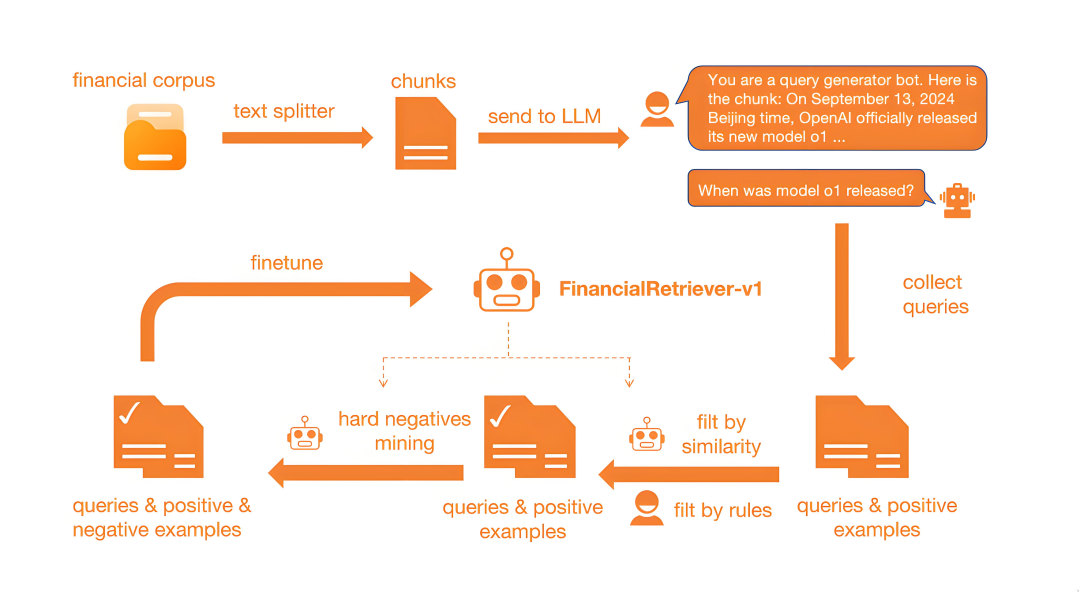

七、大模型embedding训练方案

1.基座模型:Qwen2.5-7B(平衡效果与推理成本)

2.改造方案:在Transformer顶层增加Mean Pooling层添加可学习的[CLS] token,输出层接768维投影层(L2正则化)

3.对比学习框架(Triplet Loss + InfoNCE)

4.Batch构造策略:在线困难样本挖掘(Online Hard Mining),跨语言负样本生成(同品类不同语言商品)

5.多语言对齐:通过共享subword词汇表实现跨语言映射。

最近两年,大家都可以看到AI的发展有多快,我国超10亿参数的大模型,在短短一年之内,已经超过了100个,现在还在不断的发掘中,时代在瞬息万变,我们又为何不给自己多一个选择,多一个出路,多一个可能呢?

与其在传统行业里停滞不前,不如尝试一下新兴行业,而AI大模型恰恰是这两年的大风口,整体AI领域2025年预计缺口1000万人,其中算法、工程应用类人才需求最为紧迫!

学习AI大模型是一项系统工程,需要时间和持续的努力。但随着技术的发展和在线资源的丰富,零基础的小白也有很好的机会逐步学习和掌握。【点击蓝字获取】

【2025最新】AI大模型全套学习籽料(可白嫖):LLM面试题+AI大模型学习路线+大模型PDF书籍+640套AI大模型报告等等,从入门到进阶再到精通,超全面存下吧!

4514

4514

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?