@inproceedings{zhang2020rethinking,

title={Rethinking the image fusion: A fast unified image fusion network based on proportional maintenance of gradient and intensity},

author={Zhang, Hao and Xu, Han and Xiao, Yang and Guo, Xiaojie and Ma, Jiayi},

booktitle={Proceedings of the AAAI conference on artificial intelligence},

volume={34},

number={07},

pages={12797–12804},

year={2020}

}

论文级别:CCF-A

影响因子:-

文章目录

📖论文解读

本论文发表于2020年,是SDNet的前身,想看后续的同学可以移步:

[SDNet: A Versatile Squeeze-and-Decomposition Network for Real-Time Image Fusion]

🔑关键词

图像融合

💭核心思想

(和SDNet思想非常非常相似,毕竟两篇论文是前世今生)

作者提出了一种基于【梯度和强度的比例维持】(proportional maintenance of gradient and intensity,PMGI)的【端到端】的【多任务图像融合】网络。

图像融合问题可以统一视为源图像【梯度】【强度】的比例维护问题。

网络分为两条路:梯度路径负责提取高频纹理信息,强度路径负责源图像像素强度信息的提取。

加入了特征重用(即DenseNet的密集连接)和信息交换操作。

损失函数由梯度损失项和强度损失项构成。

🪢网络结构

PMGI网络结构如下图所示。看起来很复杂,其实梳理一下很简单。

从图中我们可以看出,上面是梯度路径,下面是强度路径。输入图像并不是简单的拼接,而是让拼接比

β

=

1

:

2

\beta=1:2

β=1:2,

(我的理解是,以往的图像融合有两个源图像作为输入,分别是A和B,即为A+B,

而本文创新为AAB+BBA,使“你中有我,我中有你,但是我还是我【因为AAB里A占大头,即A“还是”A】,你还是你”)

最终的特征图也是由不同卷积时期的特征图拼接形成的,因为填充设置为SAME,所以特征图尺寸均一样,方便拼接。

📉损失函数

A和B分别代表两幅源图像,

L

(

⋅

)

i

n

t

\mathcal L_{(·)_{int}}

L(⋅)int代表A或者B的强度损失,

L

(

⋅

)

g

r

a

d

\mathcal L_{(·)_{grad}}

L(⋅)grad代表相应的梯度约束。

λ

(

⋅

)

\lambda_{(·)}

λ(⋅)代表各项权重系数。

看起来很复杂是不是,换种写法,上式可以表示为:

总损失函数=A的强度损失+A的梯度损失+B的强度损失+B的梯度损失。每项前面有个系数。

这两组公式也很好理解,就是融合结果和源图像的二范数平方,或者是梯度的二范数平方。HW是图像高和宽。

详细解释可以看本专栏其他论文解读,写的很清楚。

在公式1中,四个参数如何确定呢?

作者给出的解释就是,【不同的任务权重不同】。

-

可见光-红外

融合结果在强度方面应该主要看红外图像的,在梯度方向主要看可见光图像的。

因为强度反应的是热辐射目标,梯度反应的是纹理细节。

-

多曝光

同样重要,互为补充,所以相等

-

多聚焦

同理

-

医学图像PET-MRI

强度主要从PET中获得,纹理主要从MRI中获得。那下式第一项为什么是等于号不是大于号呢?

因为PET图像从RGB转换到IHS中,I分量比MRI大的多,如果再大于,则强度会掩盖纹理。为了平衡强度和纹理所以如此。

-

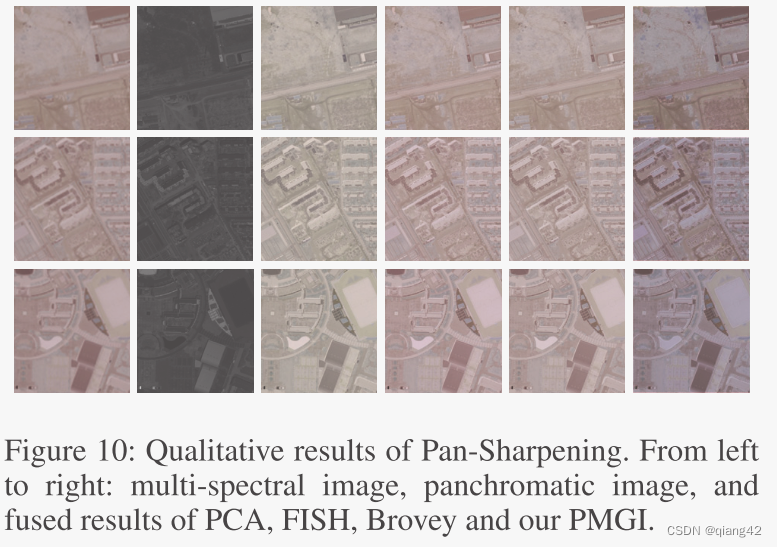

pan-sharpening(全色图像锐化)

全色图像具有较高的空间分辨率(丰富的纹理细节),多光谱图像包含丰富的颜色信息。

为了避免光谱失真,只对全色图像的纹理信息进行约束,而不约束强度。

🔢数据集

- TNO dataset for task1;

- MEF dataset and the dataset provided by (Cai, Gu, and Zhang 2018) for task2;

- MRI and PET images from Harvard medical school website for task3;

- the dataset provided by (Nejati, Samavi, and Shirani 2015) and sametaymaz4 for task4

- the panchromatic and multi-spectral images generated by the Quickbird satellite for task5.

图像融合数据集链接

[图像融合常用数据集整理]

🎢训练设置

- VIF:源图像都是灰度图像

- 多聚焦:同上

- 医学:PET是RGB,转换为IHS,使用I通道和MRI融合

- 多曝光:将RGB转换到YCbCr,融合Y通道,CbCr使用传统方法融合。

- 全锐化:多光谱4通道,全色图像单通道。分辨率为1:4。使用双三次插值将多光谱上采样至全色尺寸,然后将多光谱的每个通道都分别与全色图像融合,最后将4个中间结果拼接在一起形成最终结果。

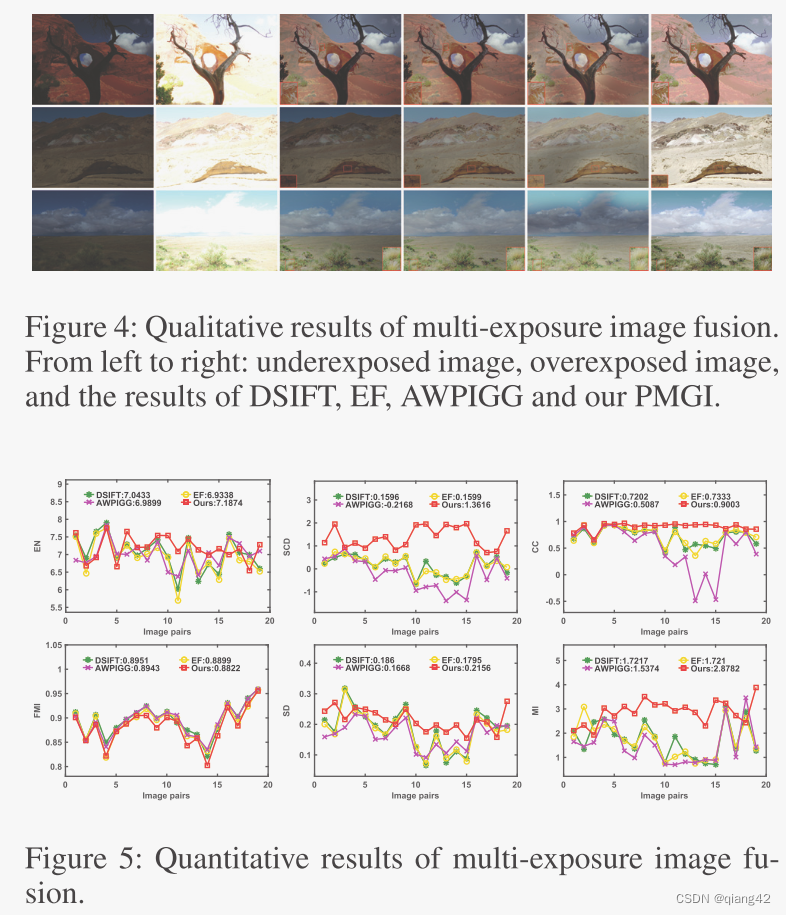

🔬实验

📏评价指标

参考资料

[图像融合定量指标分析]

🥅Baseline

- LPP (Toet 1989),

- GTF (Ma et al.2016)

- DDLatLRR (Li and Wu 2018a)

- LatLRR (Li and Wu2018b)

- FusionGAN

🔬实验结果

更多实验结果及分析可以查看原文:

📖[论文下载地址]

💽[代码下载地址]

🚀传送门

📑图像融合相关论文阅读笔记

📑[SDNet: A Versatile Squeeze-and-Decomposition Network for Real-Time Image Fusion]

📑[DDcGAN: A Dual-Discriminator Conditional Generative Adversarial Network for Multi-Resolution Image Fusion]

📑[FusionGAN: A generative adversarial network for infrared and visible image fusion]

📑[PIAFusion: A progressive infrared and visible image fusion network based on illumination aw]

📑[Visible and Infrared Image Fusion Using Deep Learning]

📑[CDDFuse: Correlation-Driven Dual-Branch Feature Decomposition for Multi-Modality Image Fusion]

📑[U2Fusion: A Unified Unsupervised Image Fusion Network]

📚图像融合论文baseline总结

📑其他论文

[3D目标检测综述:Multi-Modal 3D Object Detection in Autonomous Driving:A Survey]

🎈其他总结

🎈[CVPR2023、ICCV2023论文题目汇总及词频统计]

✨精品文章总结

✨[图像融合论文及代码整理最全大合集]

✨[图像融合常用数据集整理]

如有疑问可联系:420269520@qq.com;

码字不易,【关注,收藏,点赞】一键三连是我持续更新的动力,祝各位早发paper,顺利毕业~

862

862

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?