基本简介

论文下载地址:https://arxiv.org/pdf/1904.09664v2.pdf

代码开源地址:https://github.com/facebookresearch/votenet

作者以及论文信息如下:

Abstract

目前,3D目标检测算法严重受2D检测类算法的影响。为了利用2D检测器的网络结构,常把3D点云转化为规律的网格(比如,体素网格,或者鸟瞰图像),或者基于2D图像的检测结果来得到3D预测边框。很少有工作直接在点云中检测目标。在本文工作中,我们回归第一性准则,直接建立基于点云的3D目标检测流程,并尽可能通用。由于来自于三维空间的2D流体样本具有稀疏性,所以直接从场景点云中预测边框参数将面临巨大的挑战:3D目标的中心通常远离目标表面,导致很难一步回归出精确的参数。为了应对这个挑战,我们提出——VoteNet,一个基于深度点集神经网络和霍夫投票相互配合的端到端3D目标检测网络。我们的算法在实际扫描场景(ScanNet,SUN RGB-D)上取得不错的结果,并且网络设计紧凑、高效。仅仅使用几何信息(未使用彩色图像信息),我们的算法明显优于之前的算法。

摘要的主要内容:

- 场景点云的稀疏性;

- 3D目标的中心通常远离目标的表面,导致直接回归出精确的边框信息很有挑战。

- 提出了【直接】在3D点云中进行目标检测的通用流程框架,VoteNet.

- 深度点集神经网络和霍夫投票策略的相互配合使用,进而构成了【VoteNet】的核心模块,保证了网络直接在点云中进行有效的目标检测。

1. Introduction

3D目标检测的任务是在3D场景中进行定位和识别。更为具体的说,在本文中,我们要从点云中估计出有方向的3D边框和语义类别。

与图像相比,3D点云提供精确的几何信息和对于光照变化的鲁棒性。另一方面,点云是不规律的。因此,典型的CNN网络无法直接处理点云。

为了避免处理不规律的点云,现在的算法严重依赖2D检测类算法。比如,【42,12】将Faster/Mask R-CNN 扩展为处理3D目标检测。通过将不规律的点云处理为规律的3D体素网格,然后应用3D CNN检测器,这不仅没有利用点云稀疏性,反而增加了计算代价(3D 卷积算子)。除此,【4,55】将点云投影为规律的2D鸟瞰视角,然后利用2D检测器定位目标。这样牺牲了对于杂乱的室内场景(室内的目标通常相互粘连,空间距离较近,点云数据比较杂乱)检测至为重要的几何细节。最近,【20,34】提出级联的两阶段流程:首先,在图像进行2D目标检测,然后根据2D边框,在点云中截出3D目标区域,该算法非常依赖2D检测结果。如果2D算法无法检测到目标,那么3D检测必然失败。

本文工作中,我们提出基于点云的3D检测框架——直接处理原始点云,在网络结构和目标预测上,不依赖于任何2D检测器。我们的检测网络,VoteNet,基于最近提出的应用在点云上的3D深度学习模型,以及霍夫投票在目标检测上的应用【23】。

我们使用【PointNet++】,一个用于点云的分层次神经网络,避免了必须将点云转为规律的数据组织结构。通过直接处理点云,不仅可以避免数据转换过程中的信息损失,也可以充分利用点云稀疏性的优势。

虽然【PointNet++】在分类和分割任务中取得巨大的成功,很少有学者研究如何将该网络应用在点云中进行3D目标检测。一个常规操作是遵循2D检测器的做法,并进行密集预测,比如根据学习的密集特征,直接回归出3D边框。但是,点云本身的稀疏性使得该方法不可行。在图像中,总会存在像素位于目标中心附近,但是点云中却并非如此。由于深度传感器获取的是物体的表面点,3D目标中心通常在一个空的空间,远离任何目标表面点。因此,基于点的神经网络很难在目标中心点附近聚合场景信息。由于增大网络的感受野会包含周围的目标和杂乱点,因此简单的增加感受野并不能解决问题。

最终,我们提出将深度神经网络与投票机制结合。通过投票,我们可以在目标中心附近生成新的点,进而聚合生成候选边框。与传统的具有多个相互独立模块(难以联合优化)的霍夫投票算法相比,VoteNet 可以进行端到端联合优化。具体地来说,首先将点云输入到骨干网络,得到一些种子点,并根据种子点特征得到投票点。投票点通常应该分布在目标的中心区域附件。结果,投票聚类出现在目标中心附近,反过来可以通过一个学习模块聚合特征,进而得到边框的预测。这样就得到纯粹基于几何特征的3D目标检测器,并且可以直接应用在3D点云上。

我们在两个很有挑战的数据集上测试:SUN RGB-D 和 ScanNet. 在这两个数据集上,与其它同时使用RGB图像信息和几何特征,甚至使用多视角图像相比,在仅仅使用几何特征的情况下,VoteNet 仍明显超过其它算法。我们的研究表明,投票策略机制能够非常高效的进行上下文聚合,并且进行特别实验验证表明,当目标中心距离目标表面越远(比如,桌子和浴缸),VoteNet 可以得到越大的精度提升。

总的来说,本文工作贡献如下:

- 在深度学习的背景下,通过端到端可微的神经网络架构,我们重新定义霍夫投票。

- 在 SUN RGB-D 和 ScanNet 上,VoteNet 表现优秀。

- 深入分析了投票算法在点云上的3D目标检测的重要性。

2. Related Work

3D Object Detection. 之前很多工作都在研究3D目标检测,包括:【27】利用成对语义上下文,可以潜在的引导预测有无目标的得分;基于模板的方法【26,32,28】;基于滑动形状以及它的基于深度学习的方法的延伸版本【42】;点云的有向梯度(GOG)【38】;最近的3D-SIS【12】.

由于直接处理3D场景的复杂性,特别是大规模场景,很多学者都在研究各种投影的算法。比如在 MV3D【4】和 VoxelNet【55】,3D数据首先被转为鸟瞰视图,然后进行后续的算法处理。也有一些算法首先处理2D输入,比如 Frustum PointNets【34】和【20】。类似地,在【16】中,通过使用3D地图,一个分割假设被验证。最近,基于深度学习的工作 GSPN【54】和 PointRCNN【20】用于探索数据的稀疏性。

Hough Voting for Object Detection. 最初提出的时间是1950年末,在点采样中,霍夫变换【13】将检测简单模式的问题转化为检测参数空间的峰值点。广义的霍夫变换【2】进一步将该技术扩展到图像块,作为复杂目标存在与否的指示器。霍夫投票的开创性工作【24】,首先介绍具体的形状模型,比如3D点云中进行平面提取【3】,6D姿态估计【44】等等。

霍夫投票也曾与先进的的学习技术相结合。在【30】中,投票点被赋予权重,以此表示其重要性,然后使用最大间(max-margin)隔框架学习。【8,7】引入霍夫森林用于目标检测。最近,【15】通过使用深度学习特征建立密码本,进而提高了6D 姿态的估计效果。类似地,【31】使用深度学习特征建立密码本进而进行MRI和超声图像分割。在【14】中,经典的霍夫算法被用于在车标中提取圆形目标,然后将其输入到深度分类网络。【33】利用半卷积算子进行2D图像的实例分割,该工作与霍夫投票相关。

其它在3D目标检测中应用霍夫投票的工作【50,18,47,19】,流程与2D检测器的应用流程类似。

Deep Learning on Point Clouds. 最近,有很多将深度学习技术应用于点云的工作【35, 36, 43, 1, 25, 9, 48, 45, 46, 22, 17,

53, 52, 49, 51】,并且在3D目标分类,目标分块分割,以及场景分割中取得不错的效果。在3D目标检测中,VoxelNet【55】从体素点云中学习体素特征,然而在【34】中,PointNets 根据2D边框得到目标的定位。但是,很少有算法研究如何直接在原始点云中处理检测3D目标。

3. Deep Hough Voting

传统的霍夫投票2D检测器【24】包含离线和在线两个步骤。首先,给定一组标注过目标边框的图像集合,一个存储了图像块(或者图像块特征)与目标中心偏离程度的映射的密码本。预测的时候,在图像上提取兴趣点,并在兴趣点周围提取图像块。这些图像块与密码本中的图像块比对,进而得到偏移量和投票点。由于目标图像块倾向于投票一致性,所以聚类将会靠近目标中心。最后,通过将聚类的投票点反向投影到相关的图像块,进而得到目标的边界。

我们从两方面确认霍夫投票技术非常适合我们关心的问题。首先,相比于区域推荐算法(RPN),基于投票的检测算法更加适合稀疏的点集。对于RPN类算法,它必须是在目标中心附近生成一系列候选框,而稀疏的点集中心不存在任何点,也就增加了额外的计算代价。其次,投票类算法是基于自下而上的准则,因此小的局部信息可以被聚合,进而生成置信度高的候选边框框。尽管神经网络可以根据更大的感受野聚合上下文信息,但仍然可能对投票空间的信息聚合是有益处的。

但是,由于传统的霍夫投票包含多个独立的模块,将其整合为处理点云的神经网络是一个开放的研究问题。最后,我们提出如下一些策略,用于将不同的独立模块整合。

- Interest Points 兴趣点由神经网络选择,而不依赖于手动设计的特征进行提取。

- Vote 投票点的生成也是由神经网络完成,而不是依赖于提前建立的密码本。借助较大的感受野,降低了投票点生成的随意性,同时更加高效。此外,一个投票点可以用一个固定长度的特征向量表达,更加有利于特征的聚合。

- Vote Aggregation 投票点的聚合是通过点云处理层(包含可训练参数)实现。利用投票点特征,网络可以最大可能的滤除低质量的投票点,生成高质量的候选框。

- Object Proposal 根据聚合的投票特征,可以直接生成候选框的位置,维度,方向和语义类别信息,避免了需要回溯投票点的起源。

在下文中,我们将描述如何将前面将的各个策略整合成一个端到端可训练的神经网络,称为 VoteNet .

4. VoteNet Architecture

如【Fig.2】所示, VoteNet 的整体处理流程。整个网络可以分为两大部分:(1)处理原始点云,得到投票点;(2)处理投票点,预测候选框。

4.1. Learning to Vote in Point Clouds

对于输入点云大小为 N × 3 N\times3 N×3,每个点由 3D(XYZ)坐标描述,我们的目的是生成【M】个投票点,每一个投票点由3D坐标和高维特征向量组成。生成投票点需要【2】个步骤:骨干网络提取输入点云特征,得到种子点;基于种子点以及特征,学习霍夫投票,生成投票点。

Point Cloud Feature Learning. 生成一个高精度的投票点需要几何推理和上下文的环境。我们利用最近提出专门用于处理点云的深度神经网络【36,9,43,25】提取特征,而不是手动设计的特征。我们的方法并不依赖于某一种网络,本文实验中,我们选择 PointNet++【36】作为主干网络。该网络方便易用,并且在不同的任务领域(法线估计,语义分割,3D目标定位)都取得巨大的成功。

该主干网络有多个点集提取层(set-abstraction layers,SA)和特征上采样层(包含跳跃连接),并输出输入点集的子集,每个点包含 【XYZ】坐标和 长度为【C】的特征向量。最终生成【M】个种子点,维度为【3+C】。每一个种子点生成一个投票点。

Hough Voting with Deep Networks. 传统的霍夫投票中的投票点(offsets from local key-points)是由预先定义的密码本决定的。本文中,我们建立一个投票模块,根据特征自动生成投票点,不仅更加有效(没有KNN查询),而且更加准确(与后面的流程联合训练得到)。

给定种子点集合

{

s

i

}

i

=

1

M

\lbrace s_i\rbrace ^M_{i=1}

{si}i=1M,

s

i

=

[

x

i

;

f

i

]

,

x

i

∈

R

3

,

f

i

∈

R

C

s_i=[x_i;f_i],x_i\in R^3,f_i\in R^C

si=[xi;fi],xi∈R3,fi∈RC,借助共享投票模块,每一个种子点独立的生成一个投票点。特别地,投票模块是由多层感知机网络(MLP)构成,包含全连接层,ReLU 和 BN层。MLP 输入种子点的特征向量

f

i

f_i

fi,输出欧式空间的偏移量

Δ

x

i

∈

R

3

\Delta x_i\in R^3

Δxi∈R3 和一个特征向量偏移量

Δ

f

i

∈

R

C

\Delta f_i\in R^C

Δfi∈RC,因此由种子点生成投票点

v

i

=

[

y

i

;

g

i

]

v_i=[y_i;g_i]

vi=[yi;gi] 满足如下等式关系

y

i

=

x

i

+

Δ

x

i

y_i=x_i+\Delta x_i

yi=xi+Δxi 和

g

i

=

f

i

+

Δ

f

i

g_i=f_i+\Delta f_i

gi=fi+Δfi.

预测的3D偏移量

Δ

x

i

\Delta x_i

Δxi 明确的由回归损失监督训练,定义如下:

L

v

o

t

e

r

e

g

=

1

M

o

p

s

∑

i

∣

∣

Δ

x

i

−

Δ

x

i

∗

∣

∣

1

[

s

i

o

n

o

b

j

e

c

t

]

(1)

L_{vote_reg}=\frac{1}{M_{ops}}\sum_i||\Delta x_i-\Delta x_i^*||\Bbb 1[s_i ~on~object]\tag{1}

Lvotereg=Mops1i∑∣∣Δxi−Δxi∗∣∣1[si on object](1)

这里 1 [ s i o n o b j e c t ] \Bbb 1[s_i ~on~object] 1[si on object] 表示种子点 s i s_i si 是否在目标的表面, M o p s M_{ops} Mops 表示目标表面的种子点数量。 Δ x i ∗ \Delta x_i^* Δxi∗ 表示种子点的位置 x i x_i xi 距离该种子点所属边框目标中心点的真实距离。

从张量的表达上看,种子点和投票点没有什么差别,但是空间位置上,投票点已经不在目标表面。更为本质的区别是它们的位置,生成的投票点更加彼此靠近,使得其更容易聚合目标不同部分的信息。下一步,我们将充分语义感知局部性【semantic-aware locaity】来聚合投票特征,进而得到候选框的信息。

4.2. Object Proposal and Classification from Votes

投票点为来自目标不同部分的上下文聚合信息创建了可信的汇合点。当对投票点进行聚类之后,我们对其特征进行聚合,进而得到目标的候选框,并对其进行分类。

Vote clustering through sampling and grouping. 虽然有很多方式可以对投票点进行聚类,我们选择了较为简单的均匀采样策略,并根据空间距离进行分组。具体地,对于投票点集合 { v i = [ y i ; g i ] ∈ R 3 + C } i = 1 M \lbrace v_i=[y_i;g_i]\in R^{3+C}\rbrace^M_{i=1} {vi=[yi;gi]∈R3+C}i=1M,基于投票点的空间坐标 { y i } \lbrace y_i\rbrace {yi}, 采用最远点采样算法,从投票点集中采样出【K】个投票点,得到 { v i k } , k = 1 , . . . , K . \lbrace v_{i_k}\rbrace,k=1,...,K. {vik},k=1,...,K.. 然后,我们通过邻近投票点 v i k v_{i_k} vik 相互之间的3D位置来进行聚类, C k = { v i ( k ) ∣ ∣ ∣ v i − v i k ∣ ∣ < r , k = 1 , . . . , K C_k=\lbrace v_i^{(k)}|||v_i-v_{i_k}||<r,k=1,...,K Ck={vi(k)∣∣∣vi−vik∣∣<r,k=1,...,K. 尽管很简单,这种聚类技术可以很容易的整合到端到端的流程,实际效果也很好。

Proposal and classification from vote clusters. 一个投票点的聚类本质上是高维的点集合。我们可以使用通用点集学习网络聚合投票点,进而生成目标候选。与传统霍夫投票需要通过回溯算法(back-tracing)获得目标的边界,我们的流程可以生成完整的边界(即使只有目标局部的观察视角),也能预测出其它的参数,比如方向,类别等。

在我们的应用中,我们使用共享的 PointNet【35】对每一个投票点聚类进行信息聚合和候选框生成。给定一个投票聚类

C

=

{

w

i

}

,

i

=

1

,

.

.

.

,

n

C=\lbrace w_i\rbrace ,i=1,...,n

C={wi},i=1,...,n,以及聚类中心

w

j

w_j

wj,

w

i

=

[

z

i

;

h

i

]

,

z

i

∈

R

3

w_i=[z_i;h_i],z_i\in R^3

wi=[zi;hi],zi∈R3 是投票点的位置,

h

i

∈

R

C

h_i\in R^C

hi∈RC 作为投票特征。为了能够使用投票点局部几何信息,我们将投票点位置转换到局部归一化坐标系统,公式为

z

i

′

=

(

z

i

−

z

j

)

/

r

z'_i=(z_i-z_j)/r

zi′=(zi−zj)/r. 那么,将每一个聚类点集输入到 PointNet-like的模块,就可以得到目标候选,具体如下:

p

(

C

)

=

M

L

P

2

{

m

a

x

i

=

1

,

.

.

.

,

n

{

M

L

P

1

(

[

z

i

′

;

h

i

]

)

}

}

(2)

p(C)=MLP_2\Bigg\lbrace max_{i=1,...,n}\{MLP_1([z'_i;h_i])\}\Bigg \rbrace \tag{2}

p(C)=MLP2{maxi=1,...,n{MLP1([zi′;hi])}}(2)

这里,在被 max-pooled(channel-wise)处理单个特征向量之前,每一个聚类中的每一个投票点单独被

M

L

P

1

MLP_1

MLP1 处理,然后将不同点的信息在

M

L

P

2

MLP_2

MLP2 中聚合。最终,候选向量

p

p

p 是一个多维向量,包含是否存在目标的分数,边框参数(中心,朝向和维度信息)以及语义分类分数。

Loss Function. 在生成候选和分类阶段的损失函数包括有无目标(objectness),边框估计(bounding box estimation),语义类别损失(semantic classification losses).

对于投票点的【objectness scores】监督,要么是靠近目标中心(0.3米范围内),要么远离目标中心(超过0.6米)。我们称这些投票点分别为正,负候选。【objectness predictions】对于其它的预测(other proposals,0.3~0.6米之间)并不作惩罚。【objectness】的损失函数为交叉熵损失函数,并根据一个批次内有效预测的候选框数量进行归一化。对于正预测候选(positive proposals),根据最近的真实边框,我们进一步监督边框的估计和类别的预测。具体地,我们遵循【34】的方法:将边框损失与中心回归,方向估计和边框尺寸估计解耦。对于语义分类,我们使用标准的交叉熵损失。所有的回归损失,我们使用Huber(smooth-L1【37】)损失,详细的解释可以参考附件的补充材料。

4.3. Implementation Details

Input and data augmentation. 输入到网络之前,要么从深度图中采样N个点(N=20K)或者从3D扫描中采样N个点(N=40K)。此外,每个点除了包含XYZ坐标,同时还包含高度特征(指示每个点距离地面的高度)。该高度特征取的是所有点前1%分位的高度。为了对输入数据进行增强,训练过程中,我们随机采样输入点集。我们同样也对点云进行随机翻转,围绕 Z轴随机旋转【-5,5】度,随机缩放点为【0.9,1.1】.

Network Architecture Details. 主干网络是基于PointNet++【36】,该网络包含4个点集提取层(SA)和2个上采样层(FP),4个SA层的感受野半径逐渐增大,分别为【0.2,0.4,0.8,1.2】米,对输入点集采样数量分别为【2048,1024,512,256】. FP 层将SA的输出上采样到1024个点,每一个点特征向量为256维,以及3D坐标(详细参考附件)。

投票层是由多层感知机实现,FC的是输出为【256,256,259】,最后一个FC输出XYZ的偏移量和特征的残差。

候选生成模块包含一个SA层,max-pooling,以及 M L P 2 MLP_2 MLP2. SA 的半径为0.3, M L P 1 MLP_1 MLP1 的输出为 128,128,128. 最大池化特征进一步被 M L P 2 MLP_2 MLP2 处理,输出为128,128,5(2个objectness scores+3个中心坐标值)+2NH(边框朝向回归数量)+4NS(边框尺寸回归数量)+NC(语义分类数量)。

Training the Network. 端到端训练,优化器(Adam),batch=8,初始学习率(0.001)。学习率在epoch=80,除以10,并在epoch=120时,除以10. 在 Volta Quadro GP100 GPU花费10个小时训练SUN RGB-D,ScanNetV2少于4个小时。

Inference. 输入整个场景,一次运行,可得到结果。后处理为3D NMS模块,IOU=0.25。评估方法与【42】一样,使用平均准确度(mAP)。

5. Experiments

在这一章节,我们将基于投票的目标检测方法与之前优秀的算法对比,数据集为室内公开数据集(见 5.1)。然后,我们提供分析实验,证明投票的重要性,以及不同投票聚合算法的影响,以及我们的算法在紧凑性和效率方面的优势(见 5.2)。最后,我们展示检测器定性分析结果(见 5.3)。更多的分析和可视化,参考附录。

5.1. Comparing with State-of-the-art Methods

Dataset. SUN RGB-D【40】数据集是用于3D场景理解的单视角数据。该数据集包含了约5000张训练图像,每一张图都标注了带有方向的3D边框,总共标注37类。为了将数据输入到网络,借助相机参数,首先将深度图像转换为点云,我们在较为常见的10类目标上进行训练和评估。

ScanNetV2【5】是一个标注丰富的室内3D网络数据。该数据集包含大概1200多个样本,收集与几百个不同的房间,并且同时标注了语义和实例分割,总共类别18类。与部分扫描的SUN-RGBD数据相比,ScanNetV2的场景更加完整,覆盖更大的区域,每一个区域具有更多的目标。我们从重建的网格中采样固定的点数输入到我们的网络。由于ScanNetV2没有提供目标的方向信息,我们只预测轴对齐的边框,正如【12】的作法一样。

Methods in Comparison. 我们与之前顶级的方法进行广泛的对比。基于 Faster R-CNN【37】的流程,Deep Sliding Shapes(DSS),3D-SIS【12】都是基于3D CNN的检测器,并且结合了RGB和几何信息,进而进行目标边框预测和类别预测。相比于 DSS,3D-SIS 引入了更加复杂的传感器融合策略(反投影RGB特征到3D体素)和使用多视角RGB图像来改善预测效果。2D-Driven【20】和 F-PointNet【34】基于2D的3D传感器,依赖2D的检测结果,进而降低3D检测的搜索空间。点云梯度【38】是一个滑动窗口的检测器,设计了一个新的3D 类HOG的特征。MRCNN 2D-3D 是一个基准算法,直接将 Mask-RCNN的实例分割结果投影到3D空间中,然后估计目标边框。GSPN【54】是个新提出的实例分割方法,使用的是生成式模型提出预测出目标实例,骨干网络用的也是 PointNet++.

Results. 在公开数据集上(SUN RGB-D,ScanNet),VoteNet 比之前的算法分别提高了至少3.7和18.4 mAP,而且我们的输入仅仅是几何信息,而其它算法输入的是几何和RGB信息。【Table 1】表明,在数量最多的类别(椅子),我们的算法提升了11 AP. 【Table 2】表明,当输入仅为几何信息时,我们的方法比基于3D CNN方法的 3D-SIS至少提高了 33AP. ScnaNet每一类的评估结果在附录。重要的是,两个数据集使用的是同一套参数。

5.2. Analysis Experiments

To Vote or Not To Vote?VoteNet一个最为直接的基准算法是直接从场景采样点预测出目标边框。我们称这个基准算法为BoxNet,可以直接证明投票策略在本算法中的重要作用。BoxNet 与 VoteNet具有相同的主干网络,但是没有投票模块,直接从种子点预测出目标边框信息(详细参考附录)。【Table 3】表明,投票策略在 SUN RGB-D提升了大概 5 mAP,在ScanNet,提升了大概 13mAP.

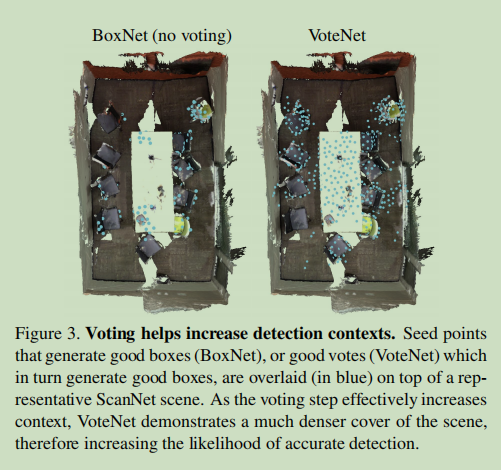

那么,投票在什么方面会有帮助呢?我们认为在稀疏的3D点云中,目标点云通常远离目标中心,直接预测边框可能会造成置信度度很低和不精确的边框预测。相反,投票策略可以将低置信度的点聚集到一起,并通过聚合信息进而提升预测结果。我们在ScanNetV2的一个典型场景证明了这个现象,见【Fig 3】。我们将种子点覆盖在场景的表面,并能得到精准的预测。如图所示,VoteNet 种子点覆盖面更全,表明了投票策略对于鲁棒性的重要性。

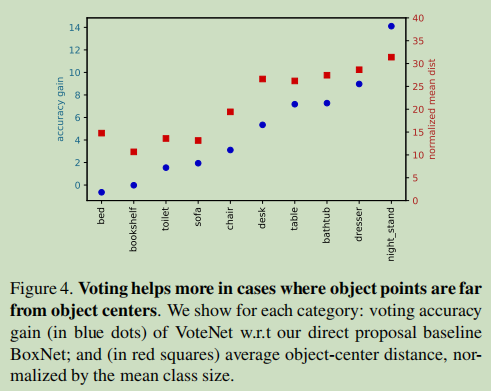

在【Fig 4】中,我们作了进一步的分析,将结果画在一起(以不同的尺度),对于每一个 SUN RGB-D类别:(蓝色点)表示VoteNet和BoxNet在mAP上的增加,(红色方块)表示目标表面点距离目标中心点最近的距离,对每一类求平均值,并且用每一类的平均尺寸进行归一化(较大的距离意味着目标中心距离目标表面较远)。根据mAP的增加量进行排序,我可以看到一种强相关关系。也就是说,当目标中心远离目标中心时,投票策略的影响更大。

Effect of Vote Aggregation 投票点的聚合是VoteNet中非常重要的模块,它使得投票点之间可以信息传递。因此,研究不同聚合策略对精度的影响是很有必要的。

在【Fig 5(右图)】中,可以看到通过可学习的PointNet和最大池化构建的投票聚合(vote aggregation)模块远远优于在局部区域进行手动聚合的方式,经常受到杂乱投票点干扰(投票点来自于非目标种子点)。我们测试了3种聚合方式:最大值,平均值,RBF权重(基于投票点距离聚类中心的距离)。与用PointNet(Eq.2)相比,对投票特征直接进行池化,比如: p = M L P 2 { A V G { h i } } p=MLP_2\lbrace AVG\lbrace h_i\rbrace\rbrace p=MLP2{AVG{hi}}.

在【Fig 5(左图)】中,我们显示了投票聚合半径对检测的影响(使用的模块:PointNet+max pooling)。当聚合半径增加时,VoteNet精度增加,直到达到峰值(半径为0.2)。尝试增加聚合区域时,会增加更多的杂乱的投票点,进而影响了好的投票点,导致了精度的降低。

Model Size and Speed 由于充分利用了点云的稀疏性,所以我们的模型效率很高,并且避免了在空的空间搜索。与之前最好的算法相比【Table 4】,我们的模型大小比 F-PointNet 小了四倍,模型的运行效率比 3D-SIS降低了20倍。值得注意的是,3D-SIS的统计时间是离线统计的平均时间,而我们的模型是在线运行。

5.3. Qualitative Results and Discussion

【Fig6,Fig7】展示了一些有代表性的可视化预测结果。可以看出,这些场景是相当多样化的,并包含很多挑战,包括杂乱,部分扫描目标,扫描伪影等。尽管存在这些挑战,我们的网络还是显示出了相当稳健的预测结果。如【Fig 6】所示,绝大多数椅子是如何在顶部场景中被正确检测到的。我们的方法能够很好地区分粘连的沙发和椅子,以及左下角场景中的沙发;并预测了右下角场景中那个非常支离破碎和杂乱的桌子的完整边框。

但是,我们的方法仍然存在一些限制。比较常见失败案例为:瘦的目标(比如门,窗户,画),见【Fig 6】顶部场景。由于我们没有使用RGB信息,检测这些类别是非常难的。【Fig. 7】也表明了我们的方法在部分扫描物体的检测能力。比如,【Fig 7】左上角的检测结果,我们检测的椅子多于真实标注的椅子。比如右上的沙发,只有非常局部的扫描点云,但是我们仍能够检测完整。像右下的桌子,扫描的视角非常有限,因此检测失败。

6. Conclusion

在本文工作中,我们介绍了 VoteNet:一个简单,强大的融入霍夫投票算法的3D目标检测模型。该网络学习直接从点云投票到目标中心,并学习通过其特征和局部几何结构来聚合投票,以生成高质量的候选边框。仅仅使用3D点云,本文算法优于之前用3D点云和彩色图像的算法。

在未来的工作中,我们打算探索如何将RGB图像合并到我们的检测框架中,并在下游应用程序中利用我们的检测器,如3D实例分割。我们相信霍夫投票和深度学习的协同配合可以推广到更多的实际应用中,比如6D姿态估计,基于模板的检测等。

3399

3399

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?