SmartFlowAI

点击上方蓝字关注我们

作者:樊奇,上海交通大学硕士研究生

全文约 2000 字,预计阅读时间 5 分钟

众所周知,LLM 的训练数据存在时效性和通用性问题。在面对时效性或是专业性较强的提问时,如果只依赖于内在知识,LLM 就无法很好地回答。为了解决这些问题,让 LLM 搜索信息后再生成的方法应运而生。而搜索信息的方法又可以简单地分为网络搜索与本地搜索两种。网络搜索可以在一定程度上缓解 LLM 的时效性问题,而依赖于本地知识库的 RAG 方法可以较好地解决 LLM 在某专业领域知识不足的情况。

如果要打一个比方来描述网络搜索信息、本地搜索信息与依赖内在知识的区别,那么就是

-

网络搜索信息就像是做项目,网络上的一切信息都可以利用

-

本地搜索信息就像是开卷考试,只能从有限的资料中搜索与考试科目有关的内容

-

依赖内在知识就像是闭卷考试,成绩完全取决于自身能力

但是,我们应该如何平衡这三者的关系呢?让我们来看一个真实的使用场景。

社区同学猫猫头想要知道在最近的巴黎奥运会中,乒乓球单打项目的金牌情况,所以他使用了 MindSearch(一款 AI 搜索工具) 来让 LLM 在网络上搜索,并且得到了满意的回复。同时他也选择了直接询问 LLM,但是很明显,LLM 的训练数据截止在了巴黎奥运会举办前,所以 LLM 认为巴黎奥运会还没有举办。

左图:使用mindsearch搜索论文;右图:直接询问LLM

所以,本文将会在一定程度上从原理出发,为大家讲解网络搜索信息、本地搜索信息、依赖内在知识三种方法的利与弊,希望可以对大家在平衡这三者关系方面上有所帮助。

MindSearch 网络搜索

首先我们来简单介绍一下 MindSearch。MindSearch 是 InternLM 团队最近开源的 AI 搜索引擎工具,其可以在3分钟内主动从300+网页中搜集整理有效信息,并进行总结归纳。(进一步阅读见往期内容:《AI搜索能力媲美Perplexity Pro,教你如何部署MindSearch》)

上图即为 MindSearch 的整体工作流程。MindSearch 框架主要包含两个 Agent,分别为 Planner 和 Searcher,前者负责生成搜索图以及输出最终的回复,后者则负责网页信息的抽取与整合。不难看出,网络搜索对于 LLM 的长文本能力、信息抽取能力以及推理能力提出了要求,而对于 LLM 本身的知识多少却没有限制。另一方面,网络搜索到的信息一定是实时更新的,所以网络搜索很适合用来解决 LLM 的知识时效性问题。

但是,值得注意的一点是,网络搜索信息的全过程极大地依赖于搜索引擎。无论是 DuckDuckGo 还是 Bing,搜索引擎根据搜索关键词返回的结果将会直接影响 LLM 所看到的资料。此外,网络上大量的同质化内容也会对于网络搜索带来不小的挑战。因此,网络搜索信息方法的表现主要受到了搜索引擎和网络信息质量的影响。在某种意义上讲,网络搜索信息的方式更适合处理那些时效性极强,或是存在相关高质量信息来源网页的问题。

从下面的例子我们可以看出,当我们搜索“Real-time tracking 论文”时,由于 mindsearch 默认配置的搜索引擎并不适合检索学术论文(mindsearch 是开源的,可以更换搜索引擎的 API),且“Real-time tracking 论文”相关内容(低时效性)本身可能存在于 LLM 的内在知识中,因此此时直接询问 LLM 的效果可能反而比使用 mindsearch 搜索的更好。

左图:使用mindsearch搜索论文;右图:直接询问LLM

RAG 本地搜索

我们简单介绍一下 RAG(Retrieval Augmented Generation),进一步阅读可以看我们往期内容《5 分钟熟悉 RAG:助力大模型突破训练数据的桎梏》。RAG 的工作原理基本如下:

-

将问题向量化并在向量知识库内查询

-

将查询到的结果的原始信息作为上下文送入 LLM

-

LLM 依据上下文和问题生成结果并输出

不难看出,RAG 的全过程依赖的是向量知识库的构建以及查询过程,而对于 LLM 的知识能力几乎不做要求,主要依赖于 LLM 的长文本处理能力。

由于这样的向量知识库一般可以部署在本地,并且更新频率相对于网络搜索较低(但高于 LLM 内在知识的更新频率),所以适合承载一些专业性知识或是私有知识,用于解决 LLM 的知识通用性问题,不适合用来解决 LLM 的知识时效性问题。

依赖内在知识

依赖内在知识,顾名思义,LLM 在训练过程中学到了什么,它就只会什么。依赖内在知识虽然无法避免 LLM 的知识时效性与通用性问题,甚至在面对专业问题时会发生知识冲突的现象,但是其可以避免外界杂乱信息的干扰。当然,依赖内在知识对于 LLM 的各种能力都提出了较高的要求,包括但不限于知识能力、推理能力等等。

但是如果当我们在询问一些低时效性或几乎无时效性的问题(如生活常识、已被公众广泛接受认可的知识)时,依赖内在知识的方法就显得更加合适了。因为在这种情况下,混杂着大量干扰信息的网页内容也不会对 LLM 的回答产生影响,LLM 的回复稳定性也会更高。

写在最后

综上所述,我们可以简单地总结三者的优势与劣势:

-

网络搜索知识更适合于时效性极强,或是高质量信息来源网页的问题

-

RAG 更适合于专业性知识或私有知识

-

依赖内在知识适合几乎无时效性的问题

写到这里,希望 AI 时代的大家也可以像 MindSearch 一样快速搜集整合信息,像 RAG 一样丰富专业知识,最后将这些知识内化为自己的内在知识。

黑客&网络安全如何学习

今天只要你给我的文章点赞,我私藏的网安学习资料一样免费共享给你们,来看看有哪些东西。

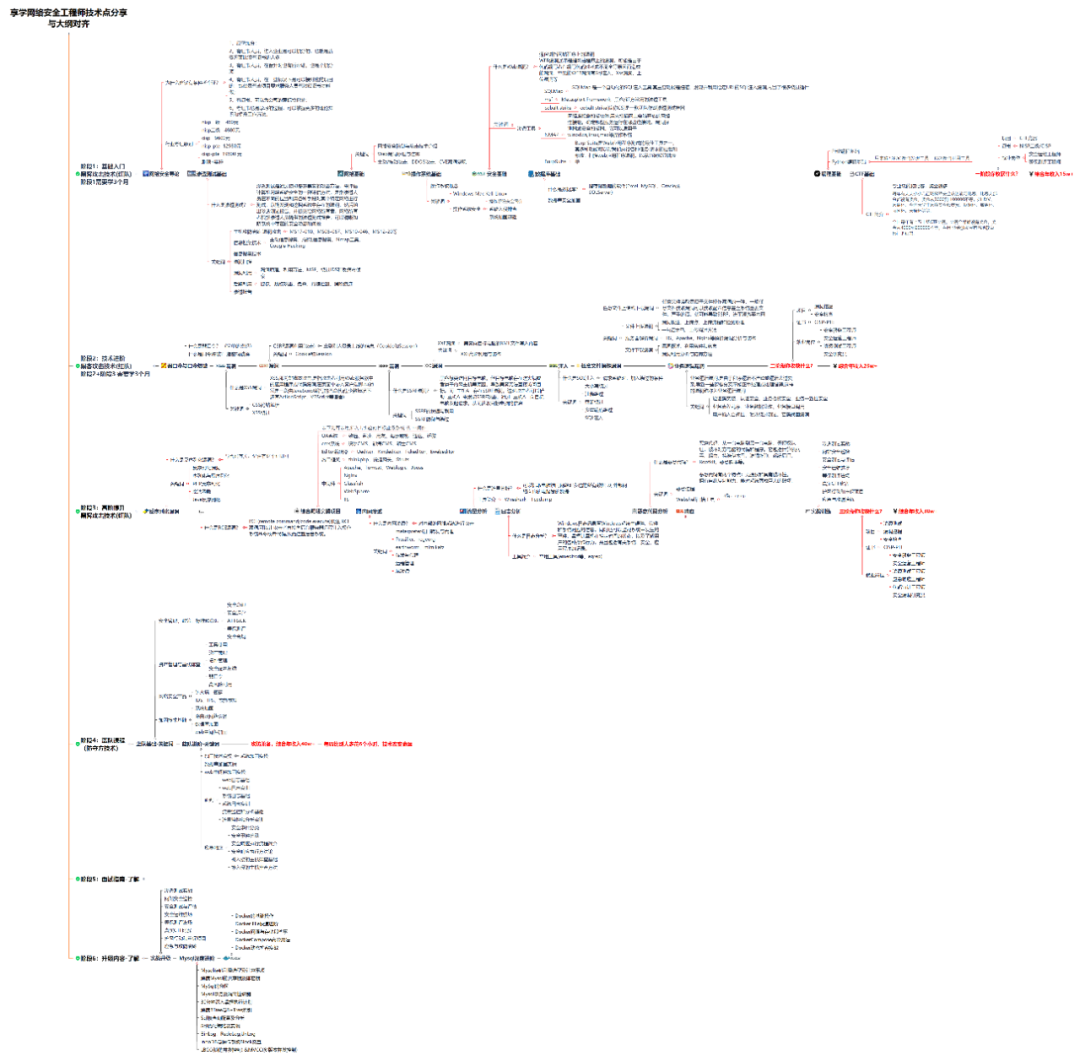

1.学习路线图

攻击和防守要学的东西也不少,具体要学的东西我都写在了上面的路线图,如果你能学完它们,你去就业和接私活完全没有问题。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己录的网安视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

内容涵盖了网络安全法学习、网络安全运营等保测评、渗透测试基础、漏洞详解、计算机基础知识等,都是网络安全入门必知必会的学习内容。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

CSDN大礼包:《黑客&网络安全入门&进阶学习资源包》免费分享

3.技术文档和电子书

技术文档也是我自己整理的,包括我参加大型网安行动、CTF和挖SRC漏洞的经验和技术要点,电子书也有200多本,由于内容的敏感性,我就不一一展示了。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

CSDN大礼包:《黑客&网络安全入门&进阶学习资源包》免费分享

4.工具包、面试题和源码

“工欲善其事必先利其器”我为大家总结出了最受欢迎的几十款款黑客工具。涉及范围主要集中在 信息收集、Android黑客工具、自动化工具、网络钓鱼等,感兴趣的同学不容错过。

还有我视频里讲的案例源码和对应的工具包,需要的话也可以拿走。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

CSDN大礼包:《黑客&网络安全入门&进阶学习资源包》免费分享

最后就是我这几年整理的网安方面的面试题,如果你是要找网安方面的工作,它们绝对能帮你大忙。

这些题目都是大家在面试深信服、奇安信、腾讯或者其它大厂面试时经常遇到的,如果大家有好的题目或者好的见解欢迎分享。

参考解析:深信服官网、奇安信官网、Freebuf、csdn等

内容特点:条理清晰,含图像化表示更加易懂。

内容概要:包括 内网、操作系统、协议、渗透测试、安服、漏洞、注入、XSS、CSRF、SSRF、文件上传、文件下载、文件包含、XXE、逻辑漏洞、工具、SQLmap、NMAP、BP、MSF…

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

1750

1750

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?