叉积的标准介绍

我们知道叉积的这个

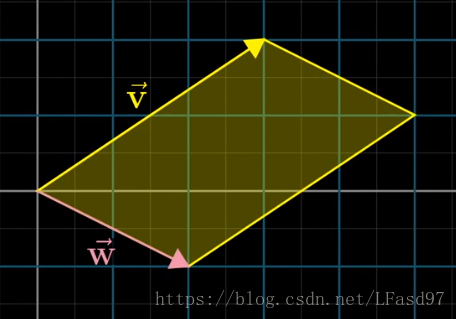

在学习线性代数的时候,我们知道,两个向量做叉积运算会得出一个新的向量,新向量垂直于原两个向量所在的平面,而且新向量的长度是原两个向量所围成的面积大小。

a ⃗ × b ⃗ = det ( [ i ^ j ^ k ^ a x a y a z b x b y b z ] ) = det ( [ i ^ a x b x j ^ a y b y k ^ a z b z ] ) \vec{a} \times \vec{b} = \det \left( \begin{bmatrix} \hat{i} & \hat{j} & \hat{k} \\ a_x & a_y & a_z \\ b_x & b_y & b_z \end{bmatrix} \right) = \det \left( \begin{bmatrix} \hat{i} & a_x & b_x \\ \hat{j} & a_y & b_y \\ \hat{k} & a_z & b_z \end{bmatrix} \right) a×b=det⎝⎛⎣⎡i^axbxj^aybyk^azbz⎦⎤⎠⎞=det⎝⎛⎣⎡i^j^k^axayazbxbybz⎦⎤⎠⎞

∣ a ⃗ × b ⃗ ∣ = ∣ a ⃗ ∣ × ∣ b ⃗ ∣ × sin ( θ ) \left| \vec{a} \times \vec{b} \right| = |\vec{a}| \times |\vec{b}| \times \sin(\theta) ∣∣∣a×b∣∣∣=∣a∣×∣b∣×sin(θ)

θ \theta θ 是两个向量 a ⃗ \vec{a} a 和向量 b ⃗ \vec{b} b 的夹角

由于这里涉及到了两个向量围成的面积,所以在前面讲到的行列式能在这里起到作用。

我们以上面这个图片为例,向量 v ⃗ \vec{v} v 和向量 w ⃗ \vec{w}

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

18万+

18万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?