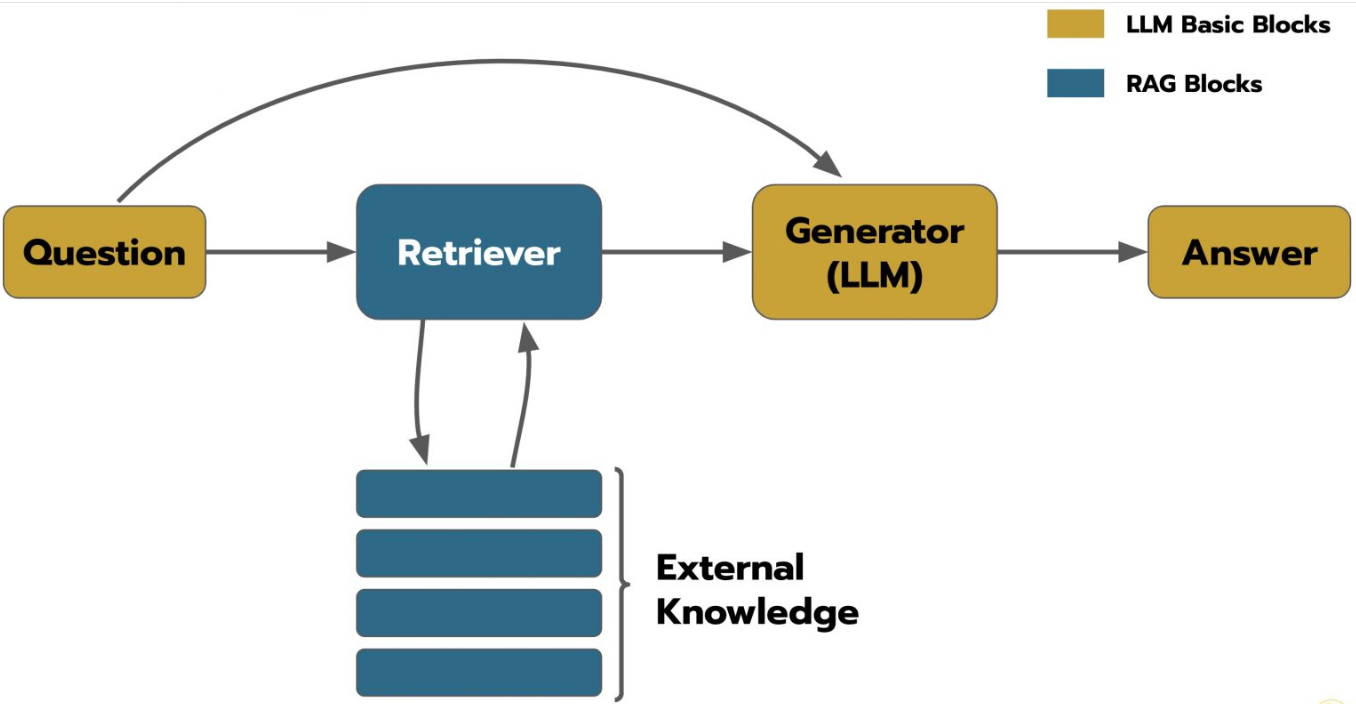

使用 DeepSeek + RAG (Retrieval-Augmented Generation) 技术搭建内部知识库,并专注于测试用例自动生成,是一个高效且实用的方案。它结合了大型语言模型(LLM)的生成能力和精准检索内部知识的能力。下面详细介绍详细的步骤、实施方案、所需资料和关键技术:

核心目标: 用户输入一个需求描述(如用户故事、功能点、接口定义),系统能自动生成高质量、符合内部规范的测试用例(包括测试步骤、预期结果、测试数据建议等)。

整体流程:

-

知识库构建: 收集、处理、存储内部知识。

-

查询处理: 理解用户需求。

-

知识检索: 从向量库中查找最相关的文档片段。

-

提示工程与生成: 将查询和检索到的知识组合成提示,让LLM生成测试用例。

-

后处理与输出: 格式化、验证(可选)并返回结果。

详细步骤与具体实施方案

阶段一:知识库构建 (知识投喂)

这是最基础也是最重要的环节。知识库的质量直接决定生成测试用例的准确性和相关性。

1.资料收集 (需要投喂的关键资料):

- 需求文档: 用户故事、产品需求文档、功能规格说明书。(核心)

- 设计文档: 系统架构图、接口设计文档、数据库设计文档。(理解系统交互)

- API文档: Swagger/OpenAPI 规范、Postman Collection 导出文档。(核心,用于API测试)

- 现有测试用例库: 历史积累的、高质量的、符合规范的测试用例(Excel, TestLink, Jira Xray/Zephyr, TestRail 等导出的结构化数据或文本)。(核心,学习测试模式、步骤描述风格、预期结果写法)

- 测试策略与规范: 公司或团队的测试策略文档、测试用例编写规范、测试数据管理规范、命名约定。(确保生成的用例符合内部标准)

- 领域知识文档: 特定业务领域的术语表、业务规则文档、流程图。(提升对业务逻辑的理解)

- 缺陷报告 (精选): 修复过的高频或严重缺陷的描述、复现步骤、根本原因分析。(帮助生成覆盖潜在缺陷场景的用例)

- UI 设计稿/原型图标注 (可选): 关键元素的说明、交互逻辑描述。(辅助UI测试用例生成)

- 日志规范/错误码文档 (可选): 了解系统预期的错误处理和日志输出。

2.资料预处理:

-

格式转换: 将各种格式(PDF, Word, Excel, Confluence, Jira Issue, Swagger JSON/YAML)转换为纯文本或结构化JSON。

-

分块:

-

目的: 文档通常太长,LLM一次处理不了,RAG需要检索最相关的“片段”。

-

策略 (关键):

-

按语义分块: 使用

LangChain的RecursiveCharacterTextSplitter或Semantic Chunker,结合句子边界和标点,确保块具有相对完整的语义(如一段需求描述、一个API端点定义、一个测试用例)。 -

按结构分块: 对于API文档(Swagger),按

path(端点)和operation(GET/POST等)分块;对于测试用例库,按单个测试用例分块。

-

-

块大小: 根据模型上下文窗口(DeepSeek-R1是128K,很宽松)和内容性质调整,通常 256-1024 个字符比较通用。API端点描述可以小些,复杂需求描述可以大些。

-

块重叠: 设置少量重叠(如50-100字符),避免关键信息被切断。

-

-

元数据附加:

-

为每个块添加元数据,便于后续检索和生成时参考。例如:

-

source_doc: 原始文档名称/URL -

doc_type:requirement,api_spec,test_case,design,bug_report,spec -

feature/module: 所属功能模块 -

api_path(如果是API文档块) -

test_case_id(如果是测试用例块) -

last_updated: 文档更新时间

-

-

3.文本嵌入 (Embedding):

-

目的: 将文本块转换为高维向量(语义表示),使得语义相似的文本向量距离相近。

-

技术: 使用预训练的文本嵌入模型。

-

模型选择:

text-embedding-ada-002(OpenAI, 效果好但需API调用),bge-large-zh-v1.5(中文效果好),multilingual-e5-large(多语言), DeepSeek 也可能提供嵌入模型(关注其开源动态)。推荐使用开源的嵌入模型(如bge)以降低成本并保证数据隐私。

-

-

工具:

SentenceTransformers库 (Hugging Face) 是本地运行嵌入模型的标准方式。

4.向量数据库存储:

-

目的: 高效存储嵌入向量和关联的原始文本块及其元数据,支持快速近似最近邻搜索。

-

技术选择:

-

ChromaDB: 轻量级,易于使用,Python原生,适合快速启动和中小规模知识库。(推荐用于初始POC和中小项目)

-

FAISS (Facebook AI Similarity Search): 高性能库,尤其擅长内存和速度优化,通常作为库集成到应用中。

-

Milvus / Weaviate / Qdrant: 可扩展的、生产级的专用向量数据库,支持分布式、持久化、高级过滤等特性。(推荐用于大型、生产级知识库)

-

-

操作: 使用所选向量数据库的SDK/API,将每个文本块的嵌入向量、块文本内容、元数据作为一个记录插入数据库。

阶段二:测试用例生成服务 (查询与生成)

5.用户输入接收:

-

提供接口(如 REST API、Web UI、IDE插件)接收用户输入的需求描述。例如:

-

“用户登录功能,需要手机号和验证码”

-

“查询订单列表接口

/api/v1/orders,支持按状态过滤” -

“在商品详情页,点击‘加入购物车’按钮”

-

甚至可以直接粘贴一段用户故事文本。

-

6.查询处理与嵌入:

-

使用与知识库构建阶段相同的嵌入模型,将用户输入的查询文本转换为一个查询向量。

7.向量检索:

-

目的: 在向量数据库中查找与查询向量最相似的文本块(Top-K,通常K=3-10)。

-

操作:

-

使用向量数据库的相似性搜索接口(如

query或search),传入查询向量。 -

设置返回结果数量

k。 -

可选: 应用元数据过滤,缩小搜索范围,提高相关性。例如:

-

只检索

doc_type为requirement或api_spec或test_case的块。 -

指定

feature/module为 “用户认证” 或 “订单管理”。

-

-

-

输出: 得到一组最相关的文本块(

retrieved_contexts)及其元数据和相似度分数。

8.提示工程与组装:

-

目的: 构建一个包含背景信息(检索到的知识)、任务指令和用户查询的清晰提示,指导DeepSeek生成符合要求的测试用例。

-

提示模板设计 (核心中的核心):

-

角色定义: “你是一个专业的测试工程师,擅长根据需求和规范编写高质量的测试用例。”

-

任务指令:

-

“请基于提供的相关需求和上下文信息,为以下功能点编写详细的测试用例。”

-

“测试用例应包括:清晰的测试用例标题(概括测试点)、详细的测试步骤(操作描述)、明确的预期结果、可选的测试数据建议。”

-

“严格遵守公司测试用例编写规范:[简要列出关键规范点,如‘步骤用动词开头’,‘预期结果可验证’,‘使用标准术语’等]。”

-

“优先考虑核心业务流程和正面场景,同时覆盖重要的边界值、异常场景和安全性考虑(如适用)。”

-

“生成的测试用例应独立可执行。”

-

-

背景信息注入:

-

“以下是检索到的相关需求、设计或现有测试用例片段:”

-

将

retrieved_contexts中的文本块按相关性顺序(或分门别类)清晰列出。(重要:让模型知道这些是依据)

-

-

用户查询呈现:

-

“需要编写测试用例的功能点描述是:

[用户输入的需求描述]”

-

-

输出格式要求:

### [测试用例标题] * **测试步骤:** 1. [步骤1描述] 2. [步骤2描述] ... * **预期结果:** * [预期结果1] * [预期结果2] ... * **测试数据 (可选):** [建议数据]-

“请以 Markdown 格式输出测试用例列表。每个测试用例格式如下:”

-

-

-

示例:

prompt_template = f""" 你是一个经验丰富的测试工程师,负责为新的功能需求编写全面且符合规范的测试用例。 **公司测试用例规范摘要:** - 测试步骤使用祈使句(动词开头),描述清晰明确。 - 预期结果必须具体、可观察、可验证。 - 使用标准术语(参考现有用例库)。 - 覆盖正常流程、关键边界值、主要异常场景。 **相关上下文信息 (来源于知识库):** {formatted_retrieved_contexts} # 将检索到的多个片段用分隔符(如---)或小标题组织好 **请为以下功能描述编写测试用例:** {user_query} **输出要求:** * 生成 [n] 个核心测试用例(根据功能复杂度确定,通常3-7个)。 * 使用上面指定的 Markdown 格式。 * 确保测试用例覆盖功能的核心逻辑和关键检查点。 """

9.调用 DeepSeek-R1 生成:

-

API 调用: 使用 DeepSeek-R1 的 API (OpenAI 兼容格式)。

-

参数设置:

-

model:deepseek-chat(根据实际API名称调整) -

messages:[{"role": "user", "content": assembled_prompt}] -

temperature: 设置为较低值(如 0.2-0.5),以降低随机性,提高生成结果的稳定性和一致性。 -

max_tokens: 设置足够大(如 1024 或 2048),确保能生成完整的用例集。DeepSeek-R1支持128K上下文,一般够用。 -

stop(可选): 可以设置一个停止序列,如["###", "***"],防止模型过度生成。

-

-

发送请求并获取响应: 解析响应中的

choices[0].message.content,得到生成的测试用例文本。

阶段三:后处理与集成 (可选但推荐)

10.结果后处理:

-

格式校验: 检查生成的Markdown是否符合预期格式(可通过简单规则或正则)。

-

内容校验 (基础): 检查是否有明显错误(如缺失预期结果、步骤描述极其模糊)。(复杂的内容校验需要额外模型或人工)

-

去重: 如果生成了高度相似的用例,进行合并或去重。

-

信息增强 (可选): 自动添加元信息(如关联的需求ID、生成时间、使用的知识块来源ID)。

11.结果返回与展示:

-

将格式化(或后处理过)的测试用例(Markdown 或转换后的 HTML/JSON)返回给用户界面。

-

在UI中展示时,强烈建议同时展示用于生成该用例的“来源知识片段”(即检索到的上下文)。这增加了透明度和可信度,方便用户验证和追溯。

12.人工审核与反馈闭环:

-

关键步骤: 生成的测试用例必须经过人工审核、补充和修正后才能正式纳入测试计划。AI是助手,不是完全替代。

-

反馈机制:

-

允许用户对生成的用例评分。

-

允许用户标记错误或遗漏。

-

收集用户修正后的用例(可作为高质量样本,后续可选择性加入知识库进行再训练或微调,持续提升生成质量)。

-

涉及的具体技术总结

-

大型语言模型:

DeepSeek-R1: 作为生成引擎的核心。通过其API调用。 -

嵌入模型:

Sentence Transformers 模型: 如bge-large-zh-v1.5,multilingual-e5-large,用于生成文本和查询的向量表示。(本地运行) -

向量数据库:

-

ChromaDB: (轻量级,易上手)

-

FAISS: (高性能库)

-

Milvus / Weaviate / Qdrant: (生产级,可扩展)

-

-

数据处理与流程编排框架 (推荐):

LangChain / LlamaIndex: 极大简化RAG流程的搭建。提供文档加载器、文本分割器、向量数据库集成、检索器、提示模板管理、LLM调用链等功能。(强烈推荐使用其中一个) -

编程语言:

-

Python: 生态最完善(LangChain, LlamaIndex, Hugging Face, 数据库驱动等)。

-

-

文档处理库:

-

PyPDF2/pdfminer/pdfplumber: 处理PDF。 -

python-docx: 处理Word。 -

openpyxl/pandas: 处理Excel。 -

beautifulsoup4: 处理HTML (如Confluence导出)。 -

json/yaml: 处理JSON/YAML (如Swagger)。

-

-

应用框架 (构建API/Web UI):

-

FastAPI / Flask: 构建REST API 服务。

-

Streamlit / Gradio: 快速构建原型Web UI。

-

Django / React (可选): 构建更复杂的生产级前端。

-

-

部署与运维:

-

Docker: 容器化应用。

-

云服务: AWS/Azure/GCP 的虚拟机、容器服务、Serverless (如 AWS Lambda)。

-

向量数据库部署: 根据选择的数据库(Chroma可嵌入,Milvus等需独立部署)。

-

关键成功因素与注意事项

-

知识库质量: 资料是否全面、准确、最新?预处理(分块、元数据)是否合理?这是效果的天花板。

-

提示工程: 提示是否清晰传达了任务、规范、格式要求?背景信息的组织是否利于模型理解?需要不断迭代优化。

-

检索优化: 分块大小/策略是否合适?嵌入模型是否匹配领域?检索时

k值和过滤条件是否合理?检索结果的相关性直接影响生成质量。 -

人工审核: 绝对不能跳过! AI生成结果需要人工把关、修正和补充。将AI视为强大的辅助工具。

-

领域微调 (可选进阶): 如果通用模型在特定领域术语或规则上表现不佳,可以考虑用收集到的高质量测试用例和需求对DeepSeek-R1进行轻量级微调(LoRA/P-Tuning),或微调嵌入模型。

-

评估指标: 定义如何评估生成用例的质量(如覆盖率、清晰度、符合规范程度、人工审核通过率)。持续监控和改进。

-

安全与隐私: 确保敏感信息(密码、密钥、个人数据)在知识库构建前已脱敏。考虑私有化部署模型和向量数据库。

通过遵循这些步骤,利用DeepSeek-R1的强大能力和RAG的精准知识检索特性,我们可以构建一个能够显著提升测试用例编写效率的内部智能知识库系统。记住,这是一个迭代过程,需要持续优化知识库、提示和检索策略。

5313

5313

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?