对图G=(V,A),V为顶点集,A为二元邻接矩阵,没有节点特征或其他额外信息.

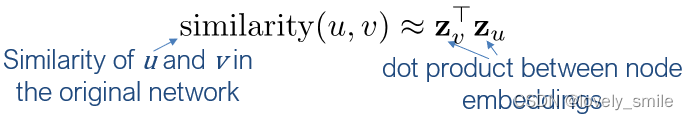

节点嵌入目的:找到节点嵌入方式,将其变为d维,使得在d维空间,图中的"相似"节点的嵌入更为接近.,即编码节点使得嵌入空间的相似性近似于原网络的相似性.

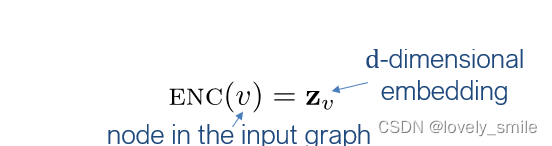

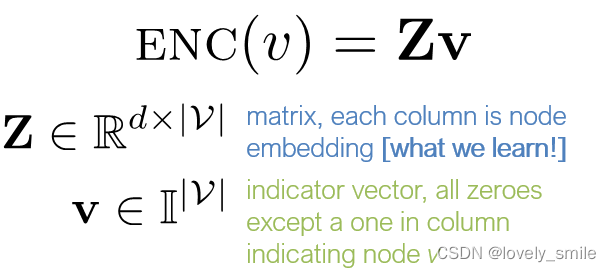

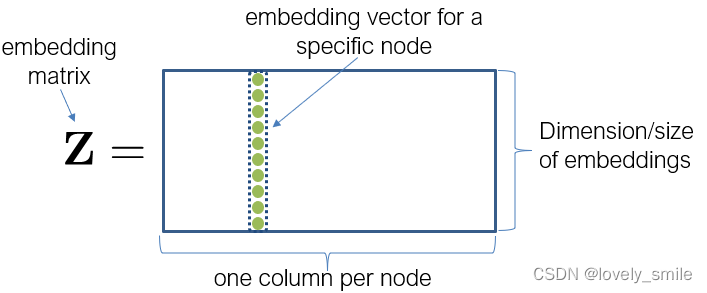

一.定义编码器(节点到嵌入的映射)

编码器将每个节点映射到一个低维向量,最简单的编码器为embedding-lookup,每个节点被分配一个唯一的嵌入向量。

例如,node2vec, DeepWalk, LINE.

二.定义节点相似性函数(原网络的相似性度量方式)

相似性函数指定向量空间的关系如何映射为原网络的关系,这里对3类相似性进行讨论

1.基于邻接关系的相似性

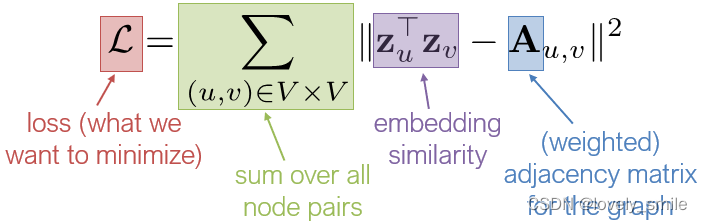

相似性为原网络u和v间的边的权重,简单的节点嵌入的点乘可用来近似边的存在,目标为找到最小化以下损失的嵌入矩阵Z.

两种优化方式:

A.采用SGD作为一般的优化方法(高度可扩展的通用方法);B.用SVD或QR求解矩阵分解求解器(只在有限情况下有效)

缺点:

1)O(|V|^2)运行时间(要考虑所有节点对)(当只考虑非零边并使用正则化时,O(|E|)运行时间);

2)O(|V|)参数(每个节点学习一个向量);

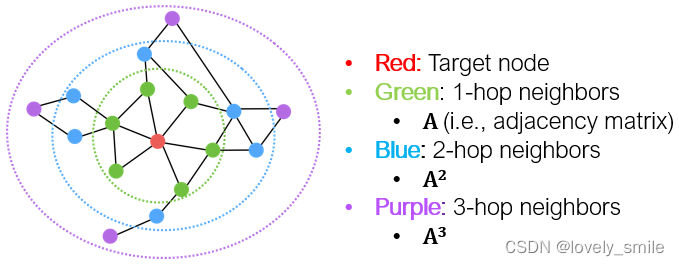

3)只考虑了直接的局部连接,如下图

2)基于多跳的相似性

2)基于多跳的相似性

2.考虑节点的k跳邻域,如下图

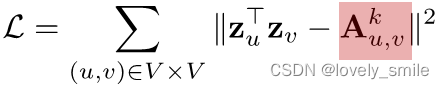

嵌入节点间的关系可用来预测k-跳邻域的关系,损失函数如下

嵌入节点间的关系可用来预测k-跳邻域的关系,损失函数如下

GraRep from Cao et al,2015中,对邻接矩阵使用了如下log变换

GraRep from Cao et al,2015中,对邻接矩阵使用了如下log变换

训练得到多个不同跳,即k时的嵌入向量,将不同跳时得到的嵌入向量拼接作为嵌入输出.

其他:

HOPE from Yan et al,2016通过衡量两个结点的邻域之间的重叠来计算相似性(如,Jaccard similarity函数,Adamic-Adar score函数),损失函数如下:

损失函数如下:

损失函数如下:

其中,Su,v为节点u和节点v的重叠度(如,Jaccard overlap或Adamic-Adar score)

若使用重叠度衡量相似性,1)的"只考虑了直接的局部连接"问题可解决.

3.随机游走方法

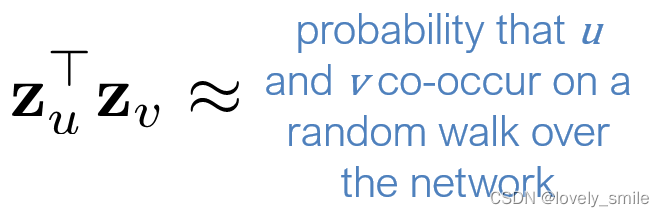

原网络中节点u和v之间的相似性度在原网络随机游走时节点u和v同时出现的概率

随机游走嵌入步骤:

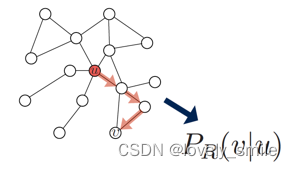

1)评估使用随机游走策略R从节点u开始到达v的概率

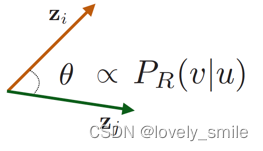

2)优化嵌入来编码这些随机游走统计量,使得u和v的嵌入的相似性(这里可用角度衡量)与u到达v的概率成正比.???

优点:1)表达能力强:节点相似性的灵活随机定义同时整合了局部和高阶邻域信息2)有效性:训练时不用考虑所以节点对,只需考虑随机游走时同时出现的节点对.

随机游走优化过程:

1).使用策略R在图上从每个节点进行短距离随机游走

最简单策略:从每个节点出发,进行固定长度、无偏向的随机游走(如DeepWalk from Perozzi et al.,2013)

更好的:采用灵活的、有偏向的随机游走来协调网络的局部和全局视角(Grover and Leskovec,2016)

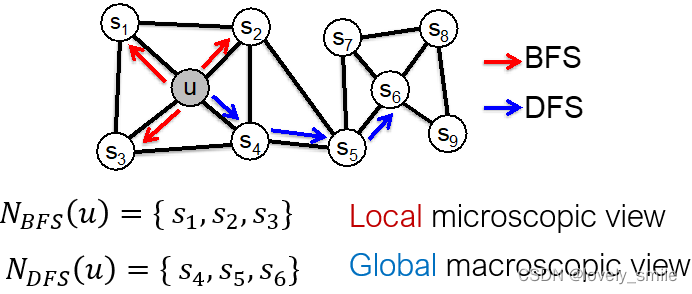

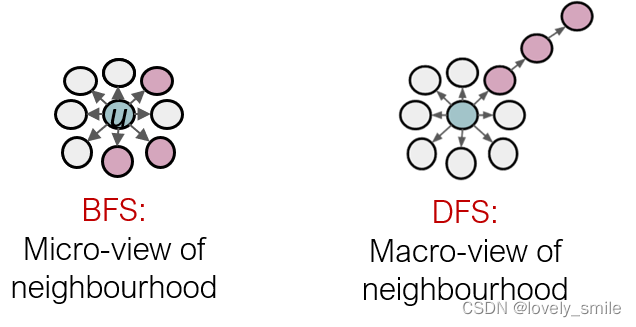

采用两种经典策略(BFS、DFS)来定义给定节点u的邻域

N

R

(

u

)

N_R(u)

NR(u),如下图所示

2).对每个节点u,收集从u开始,通过随机游走到达的节点的集合

N

R

(

u

)

N_R(u)

NR(u)(

N

R

(

u

)

N_R(u)

NR(u)中可以有重复元素,因为随机游走过程中节点可能被访问多次)

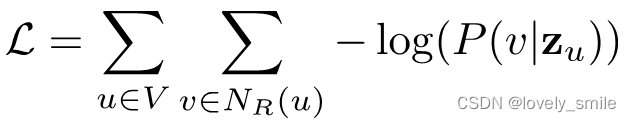

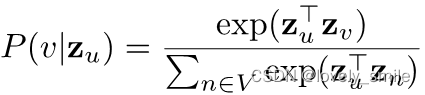

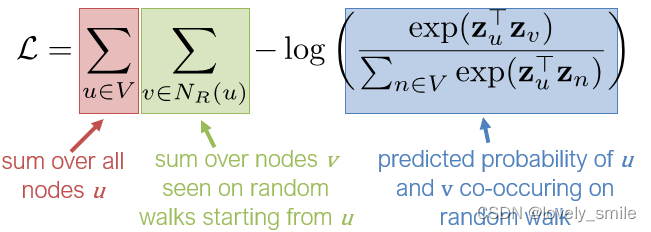

3).使用如下损失函数优化嵌入特征,使得P(v|zu)最大,最大化随机游走嵌入变为找到使损失最小的嵌入

使用softmax最大化

P

(

v

∣

z

u

)

P(v|z_u)

P(v∣zu)

损失函数近似为

缺点:复杂度高,

O

(

∣

V

∣

2

)

O(|V|^2)

O(∣V∣2)复杂度(softmax内一次求和,最外层一次求和)。如何对softmax内的求和近似来降低复杂度。

解决方案:不是对所有节点normalization,只对k个随机负样本normalization,k个负样本为从对所有节点的随机分布中随机采样得到。(采样的负样本节点数与度成比例)

采样数k的两个考虑的点:1)k越大,对原softmax的估计越鲁棒;2)k越高,对negative events的先验越高。

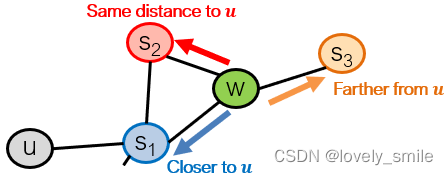

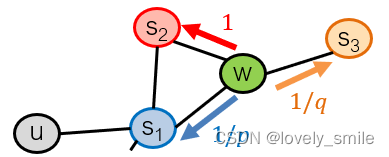

对有偏向的随机游走设置两个参数:1)返回参数p(返回之前访问的节点);2)In-out参数q(向外移动,即DFS,或向内移动,BFS)

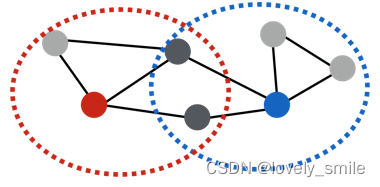

有偏向的二阶随机游走探索网络邻域示意图如下,随机游走从u开始,现在到达w,w的邻域为s1、s2、s3.其中s1为已经过的节点,s2与u与w与u的距离相同(均经过一个节点,距离为2)

使用参数p、q来建模随机游走的转移概率如下,其中1、1/p、1/q为标准化前的概率

当p值较低时,得到BFS-like walk,得到微观角度的节点邻域;当q值较低时,得到DFS-like walk,得到宏观角度的节点邻域。对比如下

其他的随机游走思想

1)不同的有偏向随机游走:基于节点属性、基于学到的权重

2)其他优化机制:直接基于1跳和二跳随机游走概率进行优化

3)网络预处理技术:在原网络的改进版本进行随机游走

方法的选择:

选择适用于应用的节点相似性定义。(node2vec在节点分类任务更好,多跳方法在链接预测任务更好,随机游走方法更高效)。

**

3.优化编码器参数

**

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?