作为一名多次参加机器学习竞赛的数据科学家,我一直在寻找“不太流行”的算法。我对它们的定义是这些算法本身可能不会成为竞争的赢家。但它们为预测带来了不同的方式。

为什么我对这些算法感兴趣?关键是可以在集成模型中使用,以获得比大多数流行的梯度增强算法(XGBoost、LightGBM等)更多的优势。

本文讨论了一种被称为正则化贪婪森林的算法。它的性能可以与针对大量数据集的Boosting算法媲美。该算法模型间产生的相关预测较少,并且与其他树提升模型很好地集成在一起。

一、RGF vs Gradient Boosting

在Boosting算法中,每个分类器/回归器都是基于数据进行训练的,同时考虑到之前分类器/回归器的结果。在每个训练步骤之后权重会被重新分配,错误分类的数据增加其权重。这样后续的学习者在训练过程中就会把注意力集中在错误分类的部分。

然而,该方法将决策树基础学习者简单地看作是一个黑盒子,并没有利用树结构本身的优势。从某种意义上说,每次迭代时,boost都会对模型执行部分纠正步骤。

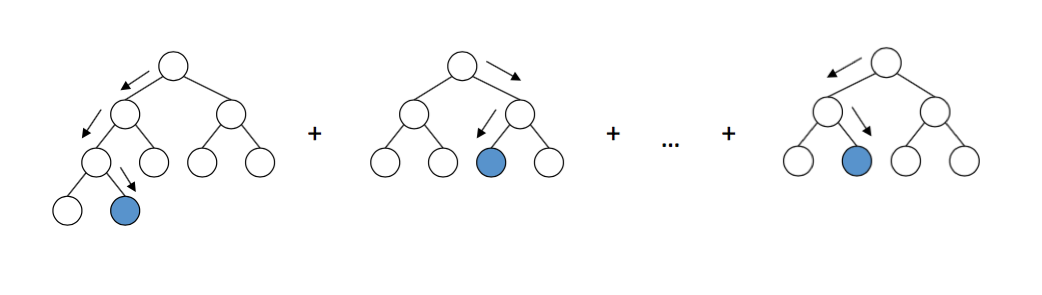

相比之下,RGF执行两个步骤:

-

对当前森林进行一步结构更改,以获得最小化损失函数的新森林(例如最小二乘法或logloss)

-

调整整个森林的叶重,使损失函数最小化

其中寻找最优结构变化:

1、为提高计算效率,搜索策略中只执行两种类型的操作:

-

分割现有的叶节点

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1868

1868

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?