摘要

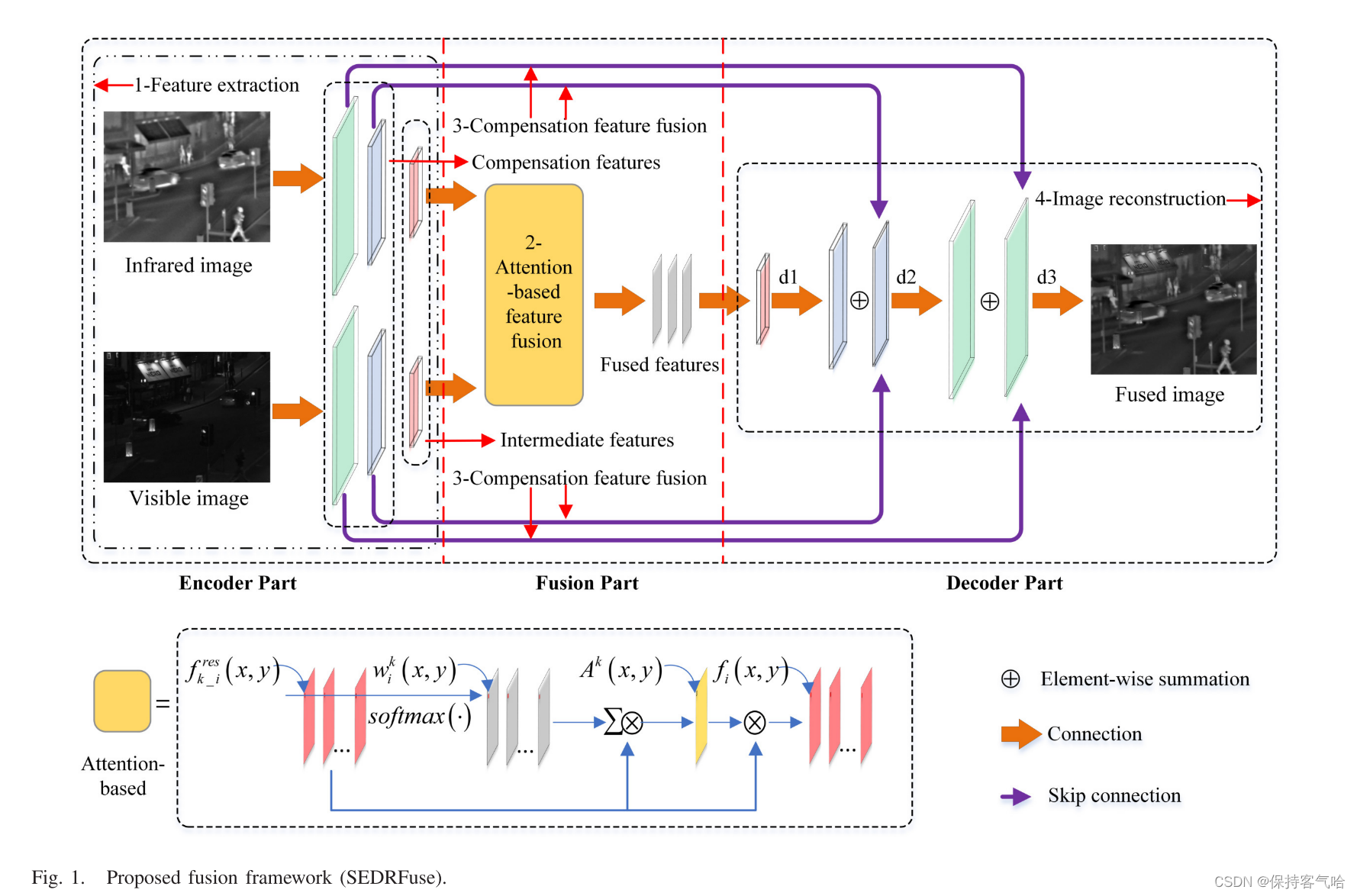

现有的图像融合方法主要在像素级实现,这可能引入伪像和/或不一致性,而且计算复杂度会很高。在这篇文章中,我们提出了一个对称的编码器-解码器与残差块(SEDRFuse)网络融合红外和可见光图像。在训练阶段,训练SEDRFuse网络以创建固定特征提取器。在融合阶段,训练的提取器被用于提取中间和补偿特征,其分别由输入源图像通过残差块和前两个卷积层生成。两个由中间特征得到的注意力图再乘以中间特征进行融合,通过逐元素选择获得的显著补偿特征被传递到对应的反卷积层以进行处理。最后,对融合后的中间特征和所选择的补偿特征进行解码以重构融合图像。

引言

融合算法可以在三个主要级别实现,即:像素级、特征级和决策级。

- 像素级图像融合与低级融合技术一样,直接处理从多个传感器获得的图像的像素。它的目的是保留更多的原始信息的源图像的视觉表现。然而,在真实的应用中,像素级融合通常遭受高计算强度和不可接受的伪影。

- 特征级图像融合随着深度学习(DL)技术的进步而显示出其优势。特征级融合通常通过使用特定滤波器或其他表示学习方法来提取源图像的代表性特征。

- 决策级融合主要基于关联数据。存在许多挑战,这是由于不同的模态之间的模态相关性。它为最终用户提供了一个分类描述符,而不是视觉感知。因此,它可能不适合当前大多数计算机视觉任务。

现有技术的像素级图像融合方法可以大致分为两大类,即:基于空间和变换的方法。

- 基于空间域的融合方法,采用简单的逻辑、算术、矩阵变换等运算,直接对源图像的像素点进行操作。基于空间的融合方法的示例包括加权平均、主成分分析(PCA)、强度-色调-饱和度、形态学操作和其他矩阵计算方法。通过这些方法获得的融合结果通常被不期望的效果污染,例如低对比度和光谱失真。

- 基于变换的图像融合方法通常使用适当的变换工具来呈现变换域中具有各种系数的源图像。随后,应用基于活动水平测量的融合策略来合并这些系数。最后,通过逆变换重构这些融合系数以生成融合图像。对于基于变换的融合方法,如金字塔,小波和边缘保留滤波器,是最常用的变换工具。

现有的像素级图像融合方法可以分为以下几类:

- 基于加权平均的融合方法 该方法通过对两张待融合图像的像素值进行加权平均,得到融合后的图像。其中权重的设定可以根据图像的亮度、色彩差异等因素来确定。这种方法简单易行,但需要对权重进行准确的控制。

- 基于小波变换的融合方法 该方法利用小波变换将两幅图像分解成不同频带的系数,然后对系数进行加权,最后再利用小波逆变换得到融合后的图像。该方法可以保留图像中的高频信息,改善图像的细节和清晰度,适用于需要更高图像质量的场合。

- 基于梯度调和的融合方法 该方法通过在两幅图像间计算梯度的调和平均数,获得一种半透明的效果,使得两幅图像之间的过渡更加自然。同时,该方法可以保留两幅图像的边缘和纹理细节,并且能够在运动目标和不同场景的图像融合中发挥重要作用。

- 基于能量优化的融合方法 该方法通过对两幅图像构造的能量函数进行优化,得到一种最优的融合方案。该方法可以充分考虑两幅图像的几何、色彩和纹理等特点,从而获得更自然、更逼真的融合结果。

- 基于局部统计信息的融合方法 该方法利用统计分析的方法将两幅图像分别分割成多个子区域,并在这些子区域上计算像素值的统计信息,以此确定两幅图像的融合权重。该方法可以保留两幅图像的空间和纹理细节,并且对于图像质量有较高的要求。

以上几类方法各具有不同的特点和适用范围,需要根据场景的具体要求和需要,选择合适的像素级图像融合方法

为了解决上述问题,本文提出了一种新的红外和可见光图像融合的DL方法。训练具有残差块的对称编码器-解码器(SEDRFuse)网络,包括IR和可见光图像。然后利用训练好的网络提取源图像的中间特征和补偿特征。随后,利用中间特征通过使用softmax函数来生成概率权重图。将特征与概率权重图相乘以获得两个注意力图,然后用于融合中间特征。另外,所获得的补偿特征需要首先被合并并且被传递到对应的反卷积层。最后,所有合并的特征通过反卷积操作反馈到解码器部分,以重建最终的融合图像。

本文的贡献如下:

- 提出了一种用于红外和可见光图像融合的SEDRFuse网络。由卷积层生成的所有特征,完全保留了每个级别的信息,都被融合到最终结果中。

- 利用softmax函数实现了一种基于注意图的特征融合策略。源图像的活动水平用注意力图来测量。采用该融合策略,融合后的图像既能很好地保留红外图像的热信息,又能获得有竞争力的亮度。

- 在融合框架中应用融合补偿特征后面的跳跃连接。由浅层生成的特征包含源图像的更多细节。通过应用跳跃连接,特征提取的丢失的细节在图像重建中被重新使用,并且融合结果的对比度可以进一步增强。

方法

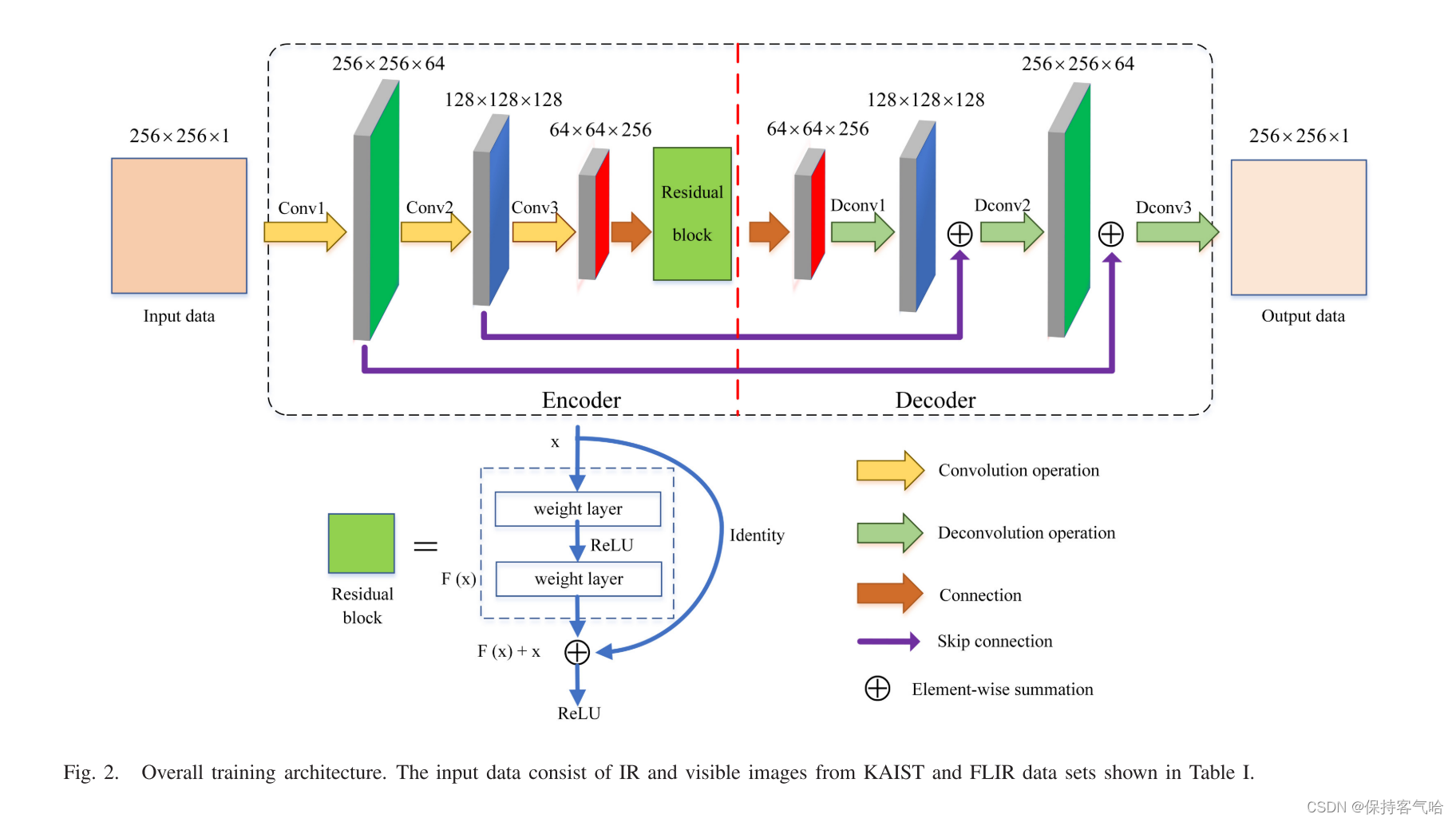

与现有架构不同,所提出的训练网络的修改在于:首先,我们在编码器部分添加残差块,以使训练过程更稳定,并重用先前第三卷积层生成的特征。其次,我们将卷积层生成的所有特征连接到相应的反卷积层,这可以有效地保留卷积过程中的详细信息。第三,我们在由红外和可见光图像组成的KAIST和FLIR数据集上训练所提出的网络,以获得更适合本文融合任务的特征提取器。

SYMMETRIC ENCODER–DECODER WITH RESIDUAL BLOCK FUSION METHOD

整体框架

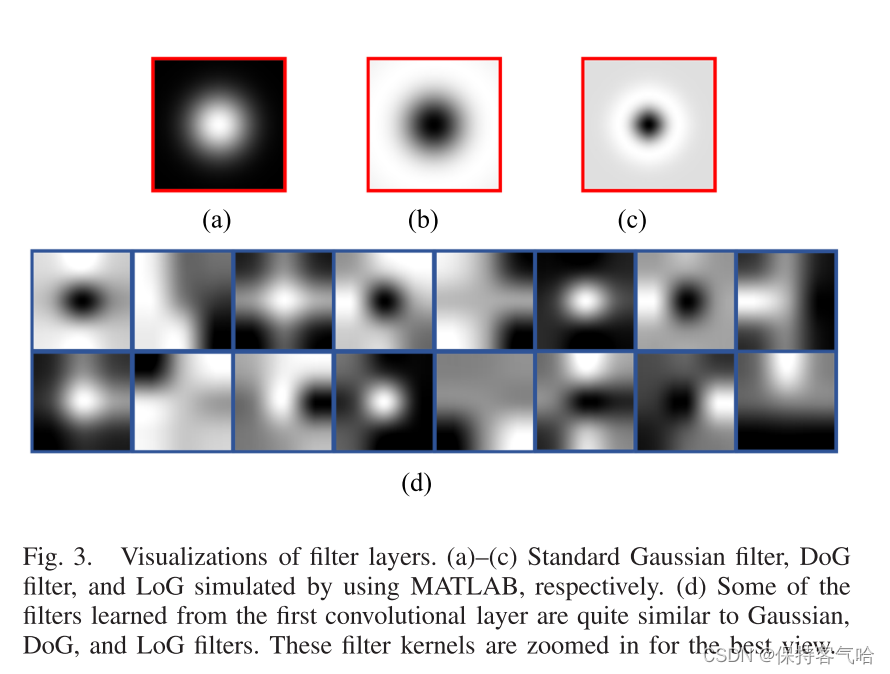

图1示出了所提出的融合框架,其由编码器、融合器和解码器部分组成。编码器部分的目标是特征提取。图3通过可视化给出了从第一个卷积层学习的一些滤波器。可以观察到,这些滤波器非常类似于高斯滤波器、高斯差分(DoG)滤波器、高斯拉普拉斯(LoG)滤波器等,可以有效地从源图像中提取各种代表性特征。此外,这些特征的融合是可行的,因为相同的卷积层共享相同的权重,这可以输出相同类型的特征。与现有的仅使用中间特征的框架不同,在所提出的融合框架中,卷积层生成的所有特征都被用于融合

定义由残差块产生的中间特征为

f

k

_

i

r

e

s

f_{k\_i}^{res}

fk_ires(i = 1,…,256),其中k表示第k张输入源图像,在该框架中,k = 1用于IR图像,并且k = 2用于可见光图像。i是输入图像的中间特征的总数。res表示残差层输出。此外,这个第一个卷积层和第二个卷积层的输出特征图被定义为

f

k

_

m

c

o

n

v

1

f_{k\_m}^{conv1}

fk_mconv1 (m = 1, … , 64) 和

f

k

_

n

c

o

n

v

2

f_{k\_n}^{conv2}

fk_nconv2 (n = 1, … , 128) m是conv1层中的特征的总数,而n是conv2层的特征的总数。我们称这些特征为补偿特征。

融合部分包括两种中间特征和补偿特征的融合策略,即基于注意力的特征融合和补偿特征融合。解码器部分旨在通过对上述两个融合部分进行解码来重构最终融合图像

Training Stage

在训练阶段没有融合部分,如图2所示。SEDRFuse网络使用可用的KAIST和FLIR数据集进行训练。训练阶段是在最小化重建损失的同时准确地重建原始数据集。也就是说,重构误差越小,提取的特征越有代表性。训练网络中的基本单元是卷积层,反卷积层,残差块,跳跃连接和整流线性单元(ReLU)函数。池化层被移除以防止从原始数据集中丢失有用的细节。

- Encoder Part

- encoder包含三个卷积层和一个残差块,输入图片是256*256*1,第一个卷积层没有改变输入大小,第二和第三卷积层(下采样)是输入大小的一半。为了补偿卷积过程中丢失的图像细节,我们模仿ResNet以进一步重用以前的特征。在这个网络中,我们在最后一个卷积层之后添加一个残差块。所有卷积运算都充当特征提取器,完全保留了源图像的纹理和结构信息。编码器的输出有256个中间特征,大小为64 × 64,保留了更多原始的结构细节。

- Decoder Part

- 为了获得与输入相同大小的输出图像,解码器部分采用对称反卷积来对应编码器部分中的卷积。反卷积通常用于通过上采样从提取的中间特征重建原始图像。反卷积层的核大小必须与卷积层相同,以精确匹配。在这个网络中,所有内核大小都设置为3 × 3。此外,解码器部分只有两种类型的单元,解卷积层和ReLU函数。

- Residual Block

- 如图2所示,我们在编码器部分中添加一个残差块以用于两次使用。第一个是确保深度网络的最佳训练收敛,用于提取更具代表性的中间特征。第二种是充分利用第三卷积层生成的先前特征。残差块的数目的选择将由实验性能确定。

- Skip Connections

- 卷积运算保留了主要图像内容,而图像的纹理细节可能会丢失。此外,反卷积只能从提取的特征中恢复图像内容的结构细节,这在编码器部分的下采样期间具有一定量的信息损失。通常,解码器的输出是输入图像的滤波版本,这导致图像融合的性能不令人满意。因此,在我们的工作中,我们使用跳跃连接将纹理特征信息从卷积层传输到其相应的反卷积层,通过元素,选择最大的方式。这些跳跃连接使所提出的框架更容易被训练,并加快收敛

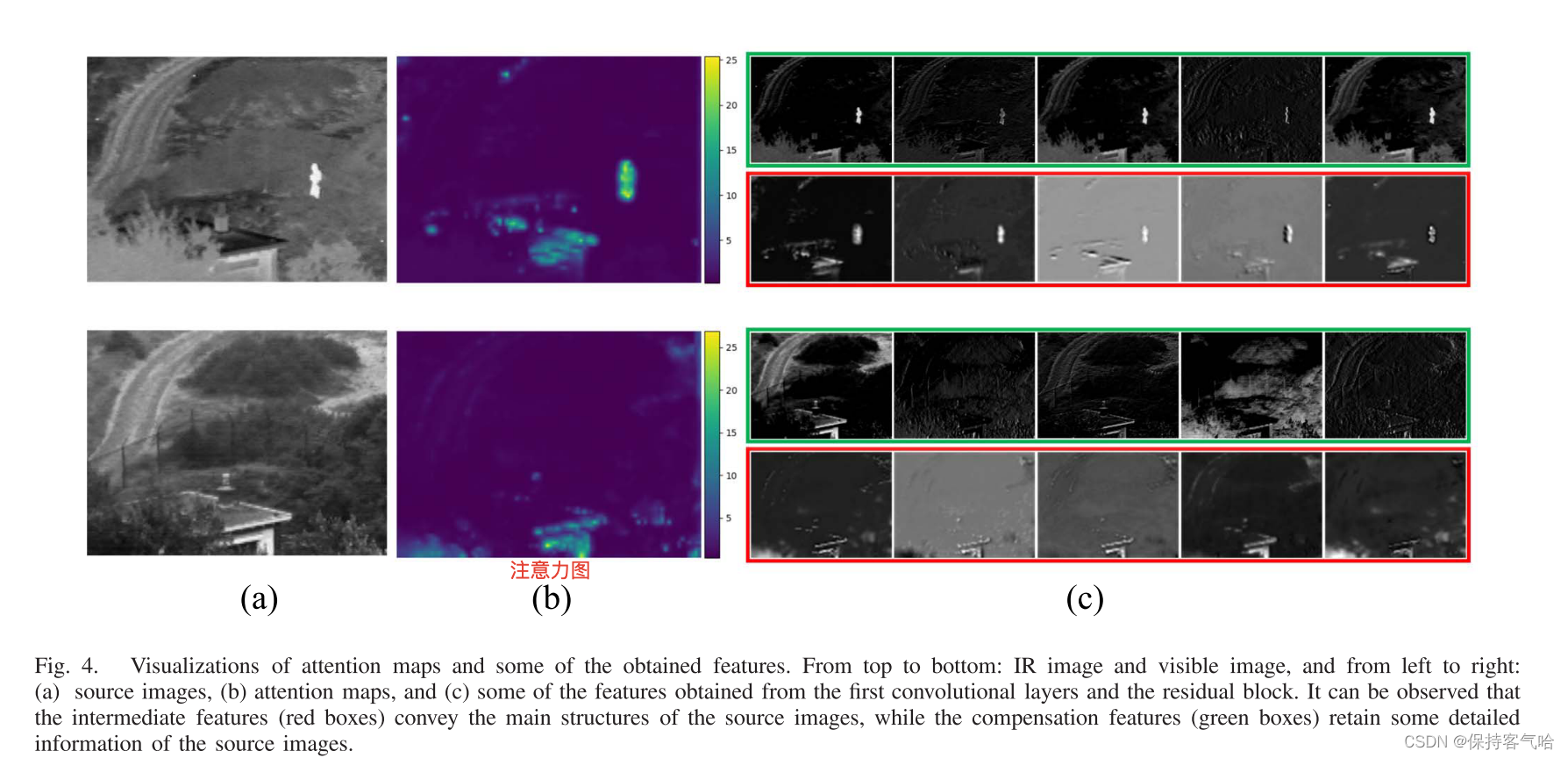

Fusion Stage

本文中描述了两种策略,用于在融合阶段合并中间特征和补偿特征。如图4(c)中可见,中间特征指示源图像的主要结构。因此,采用简单的加权平均或L1范数策略在融合过程中无法区分显著特征,导致融合结果对比度低、亮度低。为了保持源图像的亮度信息,我们设计了一个基于注意力的特征融合策略来融合中间特征,图4(b)表示出了源图像的注意力图。据观察,源图像中的显著对象被分配较高的注意力分数,这是适合于融合这些中间特征。然而,随着卷积层数量的增加,大量详细信息在中间特征中丢失。可以发现,由先前的浅层产生的特征,图4(c)中的绿色框包含源图像的更多细节。因此,为了在融合结果中保留这些视觉细节,我们通过使用跳跃连接策略来重用这些补偿特征。

Attention-Based Feature Fusion

受先前工作的启发,我们使用这些中间特征来获得注意力图。在框架中,残差的输出是一系列的中间特征,为了准确地反映源图像的显著特征,我们需要从这些特征图去创建注意力图。每个特征图都有自己的权重,由softmax运算给出,它计算通道方向上的概率。由于softmax函数可以计算每个中间特征对注意力图的贡献概率,因此它适合于计算源图像的活动水平度量。

w i k ( x , y ) = s o f t m a x ( f k _ i r e s ( x , y ) ) w^k_i(x,y)=softmax(f^{res}_{k\_i}(x,y)) wik(x,y)=softmax(fk_ires(x,y))

- 其中 w i w_i wi是每个特征的概率权重图, ( x , y ) (x,y) (x,y)表示所有中间特征通道的相同位置。 i i i是通道号,其中softmax函数能够被表示为 s o f t m a x ( x 1 , . . . , x i ) = e x s ∑ j = 1 i e x j softmax(x_1,...,x_i)=\frac{e^{x_s}}{\sum_{j=1}^ie^{x_j}} softmax(x1,...,xi)=∑j=1iexjexs,其中 x i x_i xi是向量序列的元素。

- 所有中间特征乘以相应的概率权重并求和以生成源图像的注意力图。数学表达式为 A k ( x , y ) = ∑ i = 1 256 w i k ( x , y ) f k _ i r e s ( x , y ) A^k(x,y)= \sum_{i=1}^{256}w^k_i(x,y)f_{k\_i}^{res}(x,y) Ak(x,y)=i=1∑256wik(x,y)fk_ires(x,y),其中 A k A_k Ak是反映源图像的活动水平测量的注意力图。

- 根据显著性机制,我们使用注意力地图优化这些中间特征之前的特征级融合。这个过程可以写成如下: f i ( x , y ) = ∑ j = 1 k w o p t j ( x , y ) ∗ f j _ i r e s ( x , y ) f_i(x,y)=\sum_{j=1}^kw^j_{opt}(x,y)*f^{res}_{j\_i}(x,y) fi(x,y)=j=1∑kwoptj(x,y)∗fj_ires(x,y) ,其中 w o p t j ( x , y ) = A j ( x , y ) ∑ j = 1 k A j ( x , y ) w^j_{opt}(x,y)=\frac{{A^j(x,y)}}{\sum_{j=1}^kA^j(x,y)} woptj(x,y)=∑j=1kAj(x,y)Aj(x,y),其中j表示第j个输入源图像, w o p t j ( x , y ) w^j_{opt}(x,y) woptj(x,y)表示是第j个源图像的特征的最佳权重图, f i ( x , y ) f_i(x,y) fi(x,y)是将被送入解码器部分的融合的中间特征

Compensation Feature Fusion

对于补偿特征,我们可以使用这些特征来重建编码器部分中卷积过程的缺失细节。由于压缩后的每个特征像素值表示原始图像的感受野,因此choose-max策略是以元素方式合并它们的更好选择,其可以写为如下:

f m c o n v 1 ( x , y ) = m a x { f 1 _ m c o n v 1 ( x , y ) , f 2 _ m c o n v 1 ( x , y ) } f_m^{conv1}(x,y)=max\lbrace f_{1\_m}^{conv1}(x,y),f_{2\_m}^{conv1}(x,y)\rbrace fmconv1(x,y)=max{f1_mconv1(x,y),f2_mconv1(x,y)}

f n c o n v 2 ( x , y ) = m a x { f 1 _ n c o n v 2 ( x , y ) , f 2 _ n c o n v 2 ( x , y ) } f_n^{conv2}(x,y)=max\lbrace f_{1\_n}^{conv2}(x,y),f_{2\_n}^{conv2}(x,y)\rbrace fnconv2(x,y)=max{f1_nconv2(x,y),f2_nconv2(x,y)},

其中 f 1 _ m c o n v 1 ( x , y ) , f 2 _ m c o n v 1 ( x , y ) , a n d f m c o n v 1 ( x , y ) f_{1\_m}^{conv1}(x,y),f_{2\_m}^{conv1}(x,y),and \quad f_m^{conv1}(x,y) f1_mconv1(x,y),f2_mconv1(x,y),andfmconv1(x,y)分别表示IR,VIS和第一个卷积的融合特征,m是第一个卷积中的特征总数

随后第一个和第二个卷积层的融合的补偿特征【 f m c o n v 1 ( x , y ) , f n c o n v 2 ( x , y ) f_m^{conv1}(x,y),f_n^{conv2}(x,y) fmconv1(x,y),fnconv2(x,y)】它们通过逐元素求和被传递到对应的反卷积层,其可以表示如下

f m 1 ( x , y ) = f m c o n v 1 ( x , y ) + f m d c o n v 1 ( x , y ) f_m^1(x,y)=f_m^{conv1}(x,y)+f_m^{dconv1}(x,y) fm1(x,y)=fmconv1(x,y)+fmdconv1(x,y)

f n 2 ( x , y ) = f n c o n v 2 ( x , y ) + f n d c o n v 2 ( x , y ) f_n^2(x,y)=f_n^{conv2}(x,y)+f_n^{dconv2}(x,y) fn2(x,y)=fnconv2(x,y)+fndconv2(x,y)

其中 f m d c o n v 1 ( x , y ) 和 f n d c o n v 2 ( x , y ) f_m^{dconv1}(x,y)和f_n^{dconv2}(x,y) fmdconv1(x,y)和fndconv2(x,y)这个分别表示第一层和第二层反卷积的输出, f m 1 ( x , y ) 和 f n 2 ( x , y ) f_m^1(x,y)和f_n^2(x,y) fm1(x,y)和fn2(x,y)是这个输入特征,其被转移到解码器部分的第二和第三反卷积层中

4985

4985

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?