一、ReLu、Leniar activation function、Sigmoid激活函数

Sigmoid(一般用于处理二分类问题的输出层):也就是说,当输出是一个概率,这个概率拿来判断的结果只有0和1的时候才使用它。

Linear activation function(一般用于隐藏层或输入层或输出层):当y可能有正有负的时候就要用它

ReLU:当y只有正的情况的时候用它。

大多数时候我们用这三个就够了,但是现在市面上还有一些其他的激活函数,可以了解一下,但那些只会在某些少数情况的时候比这三个好点。

我们之所以没有用sigmoid在隐藏层中,而使用ReLU的话,是因为sigmoid函数左边和右边都是平的,这样的话会导致在使用梯度下降的时候,我们的训练速度会变慢。

所以为什么我们不能在每个神经元用线性激活函数呢?

因为用了之后,整个模型最后的输出层就是个线性函数,它无法学习东西,也无法实现我们要的效果。

二、多分类问题(multi-class)

定义:指可以有不止两个输出标签的问题(也就是不只有0或1)

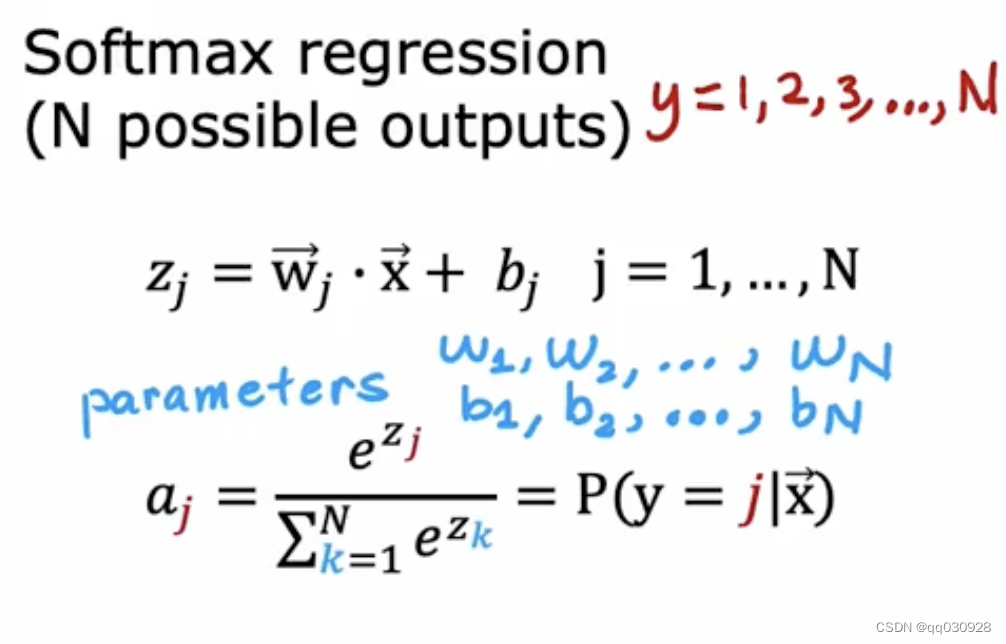

解决方式:softmax回归算法(逻辑回归的泛化)

下面是softmax回归算法的计算公式

注意,事实证明,当n=2时,也就是说只有两个输出标签时,softmax最终会变成逻辑回归(尽管参数有所不同,这也是为什么我们说它是逻辑回归的延伸)

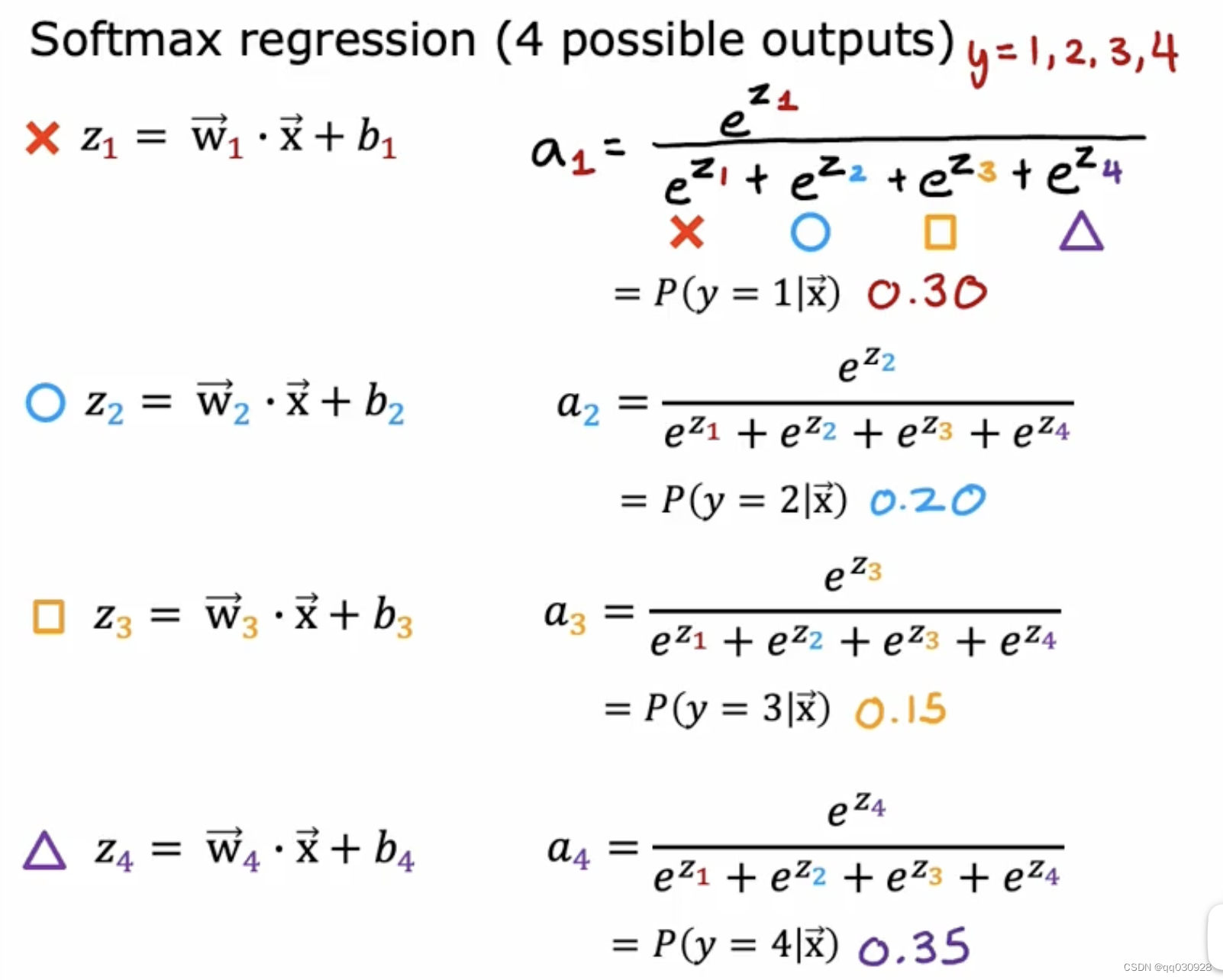

举个例子:

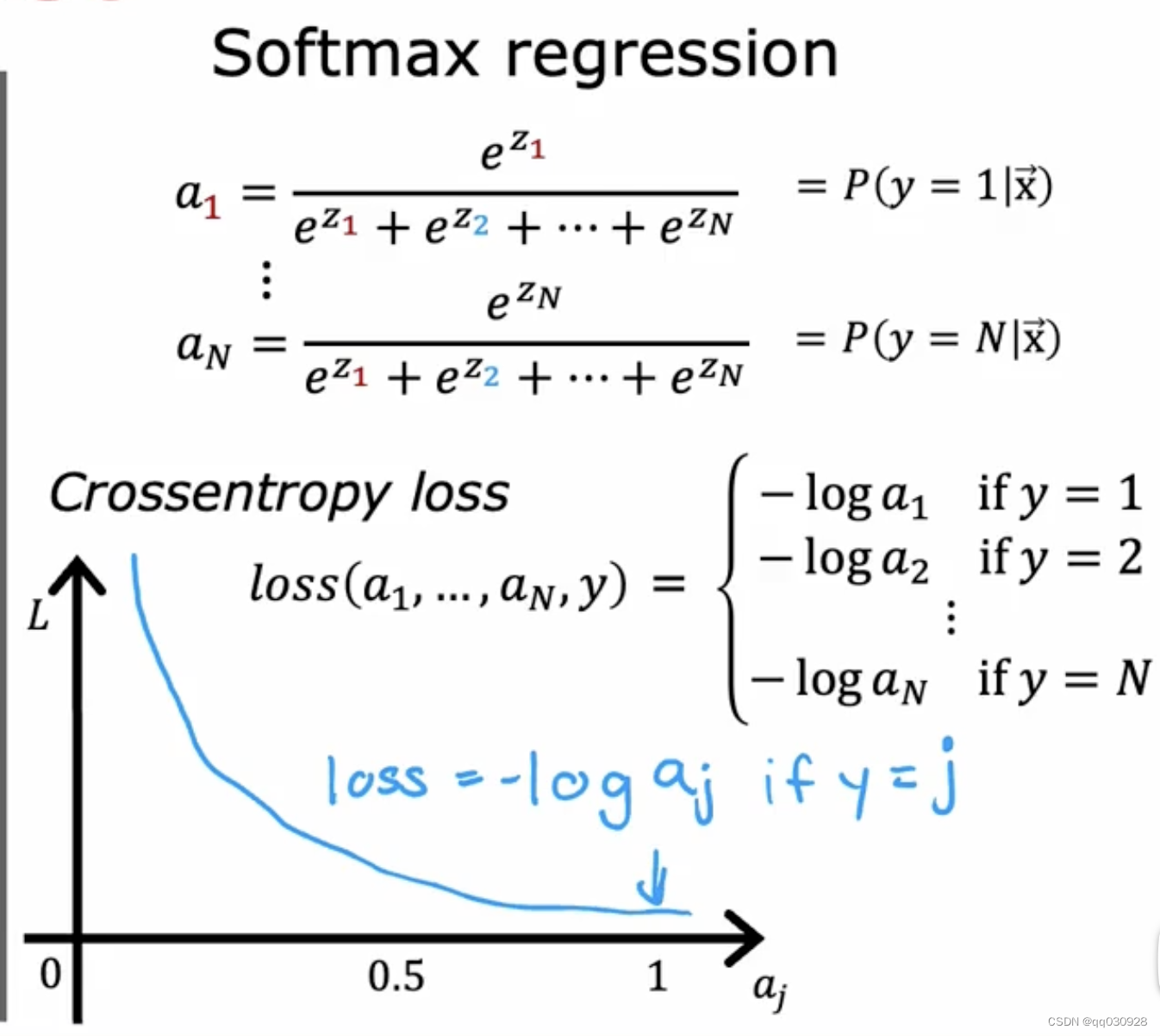

softmax的代价函数的式子和其图像:

三、多标签分类问题(multi-label classification)

举例说明:一张图可能同时出现几个我想要检测的物体 (比如车、人、自行车同时出现,我要同时输出他们三个)

解决方法:

1. 把他们独立看作三个问题去解决(不推荐)

2.训练一个单一的神经网络来同时检测

注意:

多分类最后用的是softmax激活函数,输出是一个值

而多标签分类最后用的是sigmoid激活函数,输出是一个向量(分别代表对应物体匹配的概率)

3033

3033

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?