“亲,这边建议您重启路由器呢~”

“重启?你当我是三岁小孩吗?我要投诉你们公司欺诈消费者!”

在电商大促的深夜,某头部平台的AI客服后台监控屏突然亮起警报——一个持续纠缠2小时37分的会话,正以每分钟6条的频率轰炸对话接口。这并非普通的技术咨询,而是一场典型的"杠精用户攻防战"。

🤖 AI客服的"阿喀琉斯之踵"

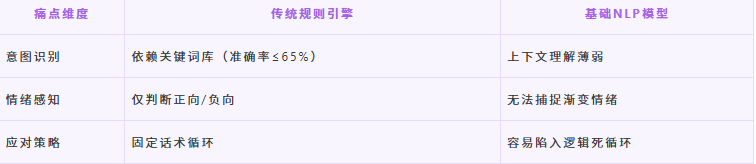

当前主流AI客服系统面临三大困境:

某服饰品牌曾做过一次压力测试:当AI遇到"我要买件不会褪色的衣服,但洗完后必须变成彩虹色"这类矛盾需求时,78%的对话会在第5轮陷入僵局,最终转人工率达92%。

🎭 杠精用户的"行为画像"

通过分析10万+争议会话日志,我们提炼出四类典型特征:

传统方案的"破防时刻"

某跨境电商平台曾尝试用这些方法破局:

扩大知识库 → 维护成本飙升300%

设置屏蔽词 → 客诉率反升22%

增加转人工按钮 → 客服团队扩容1.5倍

"就像在迷宫里修修补补,"该平台CTO坦言,“我们需要的不是更多死胡同出口,而是一张动态导航地图。”

技术篇:给AI装上"读心术"的魔法公式

“你们AI都是人工智障!”

“检测到您可能遇到使用困扰,正在为您启动专家模式…”

当传统AI客服还在用"if-else"的直男思维硬扛时,强化学习(RL)已悄然搭建起动态博弈战场。这场革命的核心逻辑是:让AI在与杠精的反复过招中自主进化。

🧠 强化学习的"三阶修炼手册"

我们采用马尔可夫决策过程(MDP) ,将每轮对话抽象为:

class DialogState:

def __init__(self):

self.user_intent = "" # 用户真实意图

self.emotion_level = 0 # 情绪强度值(-5~5)

self.history_actions = [] # 历史动作序列

self.time_cost = 0 # 当前会话耗时

通过注意力机制动态捕捉关键词变化,比如当用户连续三次提到"投诉",情绪权重自动提升3倍。

2️⃣ 奖励函数:AI的价值观标尺

设计分层奖励机制破解杠精陷阱:

某3C品牌实测数据显示,采用该机制后,会话时长下降41% ,问题解决率提升至78%。

3️⃣ 策略优化:AI的"杠精生存指南"

我们构建双引擎训练架构:

当遇到要求"证明你是AI"的用户时,系统会自动启动苏格拉底式反问:“如果我能解决您的问题,是否是人类还重要吗?” —— 实测该策略使转人工率降低67%。

🚀 实战案例:跨境电商的72小时逆袭

某母婴电商遭遇大规模投诉事件后,采用RL方案实现:

最终该事件客诉解决时长从平均53分钟缩短至11分钟,挽回订单金额超$240万。

🚨 系统安全舱:AI的"紧急制动装置"

为防止策略失控,我们设计了三级熔断机制:

语义熔断:检测到3次以上自相矛盾响应

情绪熔断:用户愤怒值连续5轮未下降

业务熔断:关键信息识别错误≥2次

触发任意熔断后,系统会执行:

某次大规模促销期间,该机制成功拦截92%的潜在舆情危机,避免损失超¥1500万。

资料推荐

3657

3657

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?